©PaperWeekly 原创 · 作者 | 陈思硕

单位 | 北京大学

研究方向 | 自然语言处理

本文为北京大学的研究者提出的基于中间层特征的文本后门防御工作,其基于对近年来提出的多种针对预训练语言模型的后门攻击(backdoor attack)的分析,经验性地揭示了下毒样本(poisoned examples)和干净样本(clean examples)在带后门模型的中间层特征空间是高度可分的,由此设计了一种集成各中间层特征距离分数的在线后门检测方法 DAN(Distance-Based Anomaly Score),用于在模型推理阶段检测下毒样本。

在多种场景下的实验结果证实,DAN 对后门攻击的防御表现远超基线方法,并享有即插即用、不需要额外训练和推理开销的优势。日前,该论文被 Findings of EMNLP 2022 录用。

论文标题:

Expose Backdoors on the Way: A Feature-Based Efficient Defense against Textual Backdoor Attacks

论文链接:

https://arxiv.org/pdf/2210.07907.pdf

收录会议:

Findings of EMNLP 2022

问题背景

1.1 NLP中的后门攻击

以 BERT 为代表的预训练语言模型在各类 NLP 下游任务上取得了前所未有的优越表现,但它们很容易受到后门攻击的威胁 [1][2][3][4][5][6]。

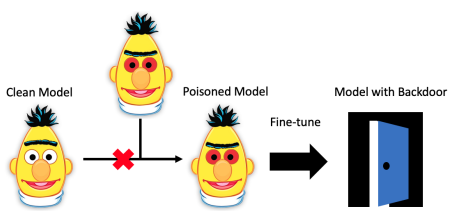

具体来说,攻击者可以在训练阶段对模型权重下毒,使模型将某个预定义的触发器(trigger,在NLP中一般是某个稀有词或者句子)和某种期望的输出标签(target label)联系到一起;受害者下载被下毒的预训练权重部署上线后,模型在干净数据上表现正常,而攻击者可通过在输入数据中插入 trigger 来激活后门,从而控制模型输出预定义的 target label,即使受害者在自己的干净数据上 fine-tune 该模型,后门依然能保持有效 [2]。

下图是代表性工作 Weight Poisoning Attacks on Pretrained Models [2] 中给出的攻击过程示意图和以稀有词为 trigger 的部分数据(原本负面的评价被攻击为正面):

1.2 NLP中的后门防御

考虑到在大模型时代,缺乏计算资源的用户通常下载预训练权重直接使用或者作为初始化进行微调,潜在的后门攻击对预训练-微调这一范式造成了严重的安全威胁。因此,研究者提出了一系列防御方法以保护 NLP 模型免受后门攻击的威胁,总体可分为三类:

数据集保护 Dataset Protection:目标是去除公共数据集中带后门的下毒数据 [7],适用于用户下载公共数据集、从随机初始化开始训练模型的场景(在 CV 中更常见),不适用于 NLP 中流行的模型下毒(weight poisoning)设定(用户下载被下毒的第三方模型权重直接部署或者进行微调);

离线防御 Offline Defense:在模型部署上线之前试图检测预训练权重中是否存在后门并/或通过剪枝、微调等优化方法消除之,如 T-Miner [8]、Fine-Pruning [9]、Fine-Mixing [9] 等,其缺点是需要额外的训练优化过程,对缺乏专业知识的普通模型用户并不友好;

在线防御 Online Defense: 目标是在模型部署上线后,能将带 trigger 的样本作为异常输入识别出来拒绝预测,从而达到在线防御后门攻击的目的,如 STRIP [11]、ONION [12]、RAP [13] 等,不需要重新训练受保护的模型本身,对普通的模型用户较友好,本文提出的防御方法也属于在线防御。

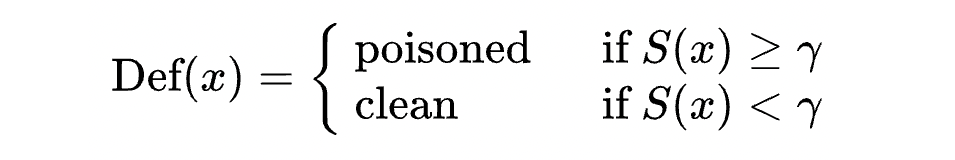

在线后门防御实际上是一个异常检测问题,可以表述为一个二分类问题,即防御方法 通过异常值分数 判断输入样本 是否属于干净数据分布 :

其中 为用户选定的阈值, 的值越高则说明防御方法越倾向于将 识别为带后门 trigger 的下毒样本(poisoned example)。

1.3 基线方法的问题

如上所述,在线防御方法的核心就在于计算异常值分数 ,NLP 领域中现存的三类基线方法都是基于下毒样本在文本输入或者模型输出概率方面上与干净样本不同的特性:

STRIP [11]:基于输出概率层面的差异:由于 trigger 的效应较强,删除输入中的部分 token 对下毒样本对应的输出概率的影响,比对干净样本对应输出概率的影响小,因此只要对输入进行多次扰动,以输出概率分布的熵取负作为 即可检测下毒样本(下毒样本的熵应当比普通样本的小);

ONION [12]:基于输入层面的差异:NLP 中的后门攻击大多以稀有词为 trigger,而插入稀有词会导致输入文本的 perplexity(language modeling 的困惑度)升高,因此只要每次删去输入文本中的一个 token,输入预训练语言模型(如 GPT)得到 perplexity,以 perplexity 的下降幅度作为 即可检测下毒样本(下毒样本的 trigger word 被删除时句子会恢复原状导致 perplexity 大幅下降,因此下毒样本的 perplexity 变化幅度一般更高);

RAP [13]:基于输出概率层面的差异:由于 trigger 的效应较强,下毒样本和干净样本相比,对对抗扰动的鲁棒性更强,因此可以构造一个通用的对抗扰动,以扰动前后模型对 targel label 对应类的的输出概率变化作为 来检

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

727

727

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?