脑部疾病个性化医疗的发展需要高效的学习模型来基于解剖神经影像预测临床状况。目前学界已就深度学习(DL)在许多医学影像任务(如图像分割)中的优势达成共识。然而,在单个受试者预测问题上,近期研究在比较基于传统特征提取的深度学习与标准机器学习(SML)时得出了相互矛盾的结果。现有的比较研究大多局限于预测临床意义较小的表型(如性别和年龄),且仅使用单一数据集。此外,这些研究对所采用的图像预处理和特征选择策略的分析也很有限。

本文在五个多中心问题上深入比较了DL和SML的预测能力,其中包括三个复杂度递增的精神病学临床应用:精神分裂症、双相障碍和自闭症谱系障碍(ASD)的诊断。为了弥补这些临床数据集中神经影像数据相对稀缺的问题,我们还评估了三种从健康人群脑部影像进行迁移学习的预训练策略:自监督学习、生成式建模和基于年龄的监督学习。

总体而言,我们发现随机初始化的DL与SML在三个临床任务上表现相似,在性别预测上也呈现相似的扩展趋势。这一结果在外部数据集上得到了验证。我们还发现DL和线性ML模型在所有问题中关注的判别性脑区高度相关。尽管如此,我们证明了在大规模健康人群影像数据集(N≈10k)上进行自监督预训练,结合深度集成学习,使得DL能够学习到可迁移到小规模临床数据集(N≤1k)的稳健表征。该方法在内部和外部测试集的3个临床任务中的2个上都大幅优于SML。

这些发现表明,DL在解剖神经影像学上相对于SML的改进主要源于其学习大脑解剖结构有意义且实用的抽象表征的能力,这为精神病学个性化医疗中的迁移学习提供了新的可能。本文发表在NeuroImage杂志。

要点

-

深度模型在临床任务上达到与线性模型相似的预测性能

-

自监督预训练改进了神经解剖特征的深度表征

-

结合迁移学习和深度集成在2个数据集上达到最先进水平

关键词:深度学习 机器学习 解剖神经影像 个体受试者预测 精神疾病

1.引言

随着脑部影像数据的不断增加(例如UKBioBank、HCP、ABIDE等),机器学习(ML),特别是深度学习(DL)模型开始在精神病学和神经病学的个性化医疗和生物标志物发现中崭露头角。精神疾病复杂且高度异质,涉及临床、生物和环境的多样性,这使得其神经生物学特征描述具有挑战性。在这种背景下,"标准"机器学习(SML)模型,包括(正则化)线性模型和基于核的方法,已在神经影像研究中被广泛使用,这些研究中可用样本数量n通常较小(n<103),而影像特征数量p却相当大(通常p>105)。限制它们在许多医学影像应用中实用性的一个主要缺点是需要手动或自动设计预选特征(例如,通过特征工程)。

与SML方法相比,DL,特别是卷积神经网络(CNNs),能够从原始数据中自动学习与任务相关的分层特征表征(例如,用于分类或回归)。通过逐层学习数据的高层抽象,它们在监督和无监督学习问题上都展示了令人印象深刻的结果,无论是在自然图像还是医学图像上。一些研究已开始对功能性脑影像和皮层数据进行表型预测的基准测试,其中一些研究显示DL优于SML。然而,正如最近几项研究所指出的,在用于单个受试者预测(精神疾病诊断或预后所需)的解剖脑MRI数据上使用DL的优势尚不明确,仍需要与简单的正则化线性模型和核方法进行仔细和广泛的比较。

对于双相障碍和精神分裂症,ENIGMA联盟进行的几项大规模荟萃分析显示,结构神经影像中可见前额叶、前颞叶和岛叶皮层区域存在显著变异。需要在体素水平进行更精细的分析,以提高机器学习模型在个体水平上的诊断和预后准确性。对于ASD,结构性脑影像显示苍白球、壳核、杏仁核和伏隔核的皮层下体积较小,以及额叶皮层厚度增加和颞叶皮层厚度减少。这种情况仅进行了病例对照研究,在单个受试者水平上需要更多努力来研究解剖脑异常及其与行为的联系。

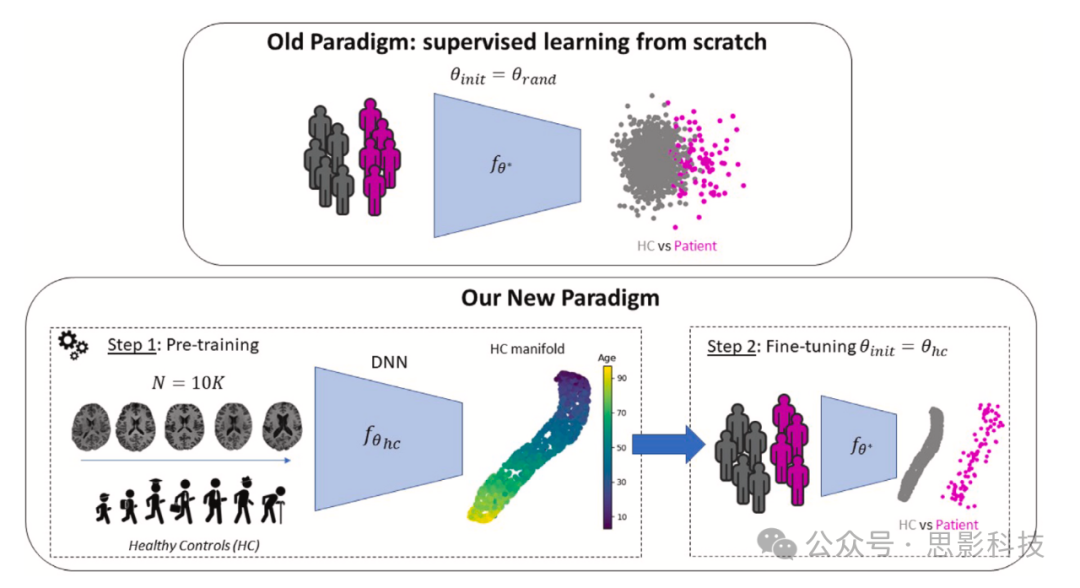

图1. 个体水平精神疾病鉴别的新范式

在预训练阶段,非线性深度神经网络𝑓𝜃从大规模健康对照者脑影像数据集中学习低维嵌入,发现与非特异性变量(如年龄和性别)相关的一般变异性。这种预训练可以通过以下方式实现:(i)自监督任务(如对比学习);(ii)生成式建模(如VAE);或(iii)判别任务(如年龄预测)。在第二步中,模型使用预训练权重𝜃𝑖𝑛𝑖𝑡 = 𝜃h𝑐初始化,并微调(fine-tune)以区分患者和对照组。我们的主要假设是,在预训练期间学习的表征将有助于更容易发现与目标病理相关的特定变异性(例如,精神分裂症或ASD中颞叶和前额叶区域的异常皮层萎缩)。

在基于UK Biobank数据集的一项近期研究中,Schulz等人研究了当前CNN中编码的两个主要先验知识,即平移不变性(源于卷积运算)和组合性(源于其层次结构),是否可以用于捕捉结构/功能磁共振成像(sMRI/fMRI)数据中的非线性依赖关系以用于个体预测任务。特别是,他们发现SML和DL模型在大规模数据情况下(𝑁𝑡𝑟𝑎𝑖𝑛 = 8k)对两种模态(sMRI和fMRI)的各种任务(年龄和性别预测以及流体智力或家庭收入预测)都具有相似的扩展趋势。然而,正如Abrol等人指出的,这些结果与Peng等人在预测分析竞赛和UKB上获得的结果相矛盾。具体来说,Abrol等人指出Schulz等人工作中存在一些严重影响其结论的技术缺陷。主要缺陷在于为SML和DL执行的特征选择步骤(使用任意数量的降维)以及在主要实验中仅使用单个中心脑切片,这限制了DL的表征能力。相反,在Abrol等人的研究中,他们仅对SML模型进行特征选择,并对DL采用全脑方法。他们发现DL在训练样本范围从𝑁𝑡𝑟𝑎𝑖𝑛 ∼ 2000到𝑁𝑡𝑟𝑎𝑖𝑛 = 104的UKB上表现出显著更好的扩展趋势,并将Schulz等人工作中的性能下降归因于编码错误。此外,他们还在简易精神状态检查(MMSE)回归任务上发现了小但显著的性能提升(𝑁𝑡𝑟𝑎𝑖𝑛 = 428,DL比SML的平均绝对误差MAE减少0.07),这可能与最近一项发现SML和DL在阿尔茨海默病检测上没有显著差异的基准研究相矛盾。虽然这个分数表明阿尔茨海默病的严重程度,但并不能转化为阿尔茨海默病的诊断,这可能解释了不同的研究发现。最后,他们提出DL可以根据不同显著性图技术一致地提取稳健的脑表征,在年龄和性别预测中显示出跨运行和显著性方法的一致模式。

然而,过去比较神经影像数据上DL和SML的文献仍存在几个我们在此强调的限制。

有限的预测任务数量

首先,最近的论文主要集中在健康人群的年龄和性别预测分析上。虽然年龄回归研究已成为许多研究问题的重要领域(如利用脑龄差发现精神疾病或神经认知障碍的新生物标志物,或规范性建模),但对精神疾病分类的深度学习评估也亟待开展。机器学习领域取得的进展令人瞩目,而以前无法获取的大规模神经影像数据的可用性为研究这些临床任务提供了独特机会。在高度异质的临床队列中是否能捕捉到非线性特征仍存在争议,这些队列包括精神分裂症(SCZ)、双相障碍(BD)和自闭症谱系障碍(ASD)患者,目前尚无明确共识。这主要是由于当前数据集样本量小,导致机器学习模型过拟合,使神经影像学界产生过于乐观的结果偏差。这些疾病涉及皮层和皮层下结构中的细微解剖萎缩/增大,其识别仍然是一个困难的挑战。

缺乏外部多中心数据的验证

其次,Abrol等人和Schulz等人的分析主要基于单一同质(即单中心和单扫描仪型号)数据集(UKB),这并不能反映新兴大型多中心和多扫描仪临床数据集合(如ABIDE、ABCD、SCHIZCONNECT等)中不可避免的异质性。因此,需要使用大规模多中心数据集对表型预测进行全面的补充基准测试。正如最近一项研究指出,由于深度学习具有学习任何函数(甚至随机噪声)的特殊能力,它也可能学习到"与疾病无关的中心特定特征",因此必须报告其在从未见过的中心获取的数据上的泛化能力。

缺乏对"原始"数据的评估

第三,先前研究认为应该在体素级脑影像数据而不是基于ROI或切片的MRI上评估深度学习模型,因为它们本来就是为自动提取特征以执行复杂任务而设计的。之前的研究主要集中在完全预处理的基于体素的MRI上。然而,对预处理流程及其对深度学习性能的影响研究较少。关于脑龄的最新发现表明,深度学习模型在原始图像(仅进行线性配准和最终去除非脑组织)和完全预处理图像(使用基于体素的形态测量法进行灰质提取、非线性形变配准和多个偏差校正步骤)之间表现相似,这表明CNN并未从原始数据中提取额外信息。这与经典视觉任务(如ImageNet分类)有显著差异,因为我们知道颜色、形状和纹理的自动特征提取是当今CNN性能的基石。因此,一个基本问题是常规的非线性计算密集型预处理步骤是否会删除深度学习可能利用的脑部疾病非线性判别信息(如皮层褶皱模式)。这个问题在精神疾病(如精神分裂症、双相障碍和自闭症)研究中很少被讨论,特别是在大型多中心研究中。此外,几项最近的工作表明,在从未见过的中心获取的图像上,使用原始数据时CNN的预测能力比使用VBM预处理更差,这适用于年龄预测、阿尔茨海默病诊断和性别预测。这表明CNN可能过度拟合了采集中心而不是提取判别信息。这一点至关重要,因为神经影像领域出现的大多数大型临床数据集都具有高度多中心性。

缺乏对迁移学习策略的评估

最后,DL和SML模型之间可能最重要的区别在于前者能够从大型数据集中学习可泛化的表征,并将其迁移到未经训练的其他任务上(即迁移学习和自监督学习)。这一想法始于Caruana(1997)关于迁移学习和多任务学习的工作,首先在自然图像领域获得成功应用(通过重用首先在ImageNet上学习的特征,这是一个包含超过106张图像和1000个类别的大规模数据集),然后扩展到医学数据集(通过以自监督方式在未标记医学图像上预训练CNN)。虽然最近的工作已经讨论了这一想法(考虑到大型健康受试者脑MRI数据集的可用性,如HCP或UKB),但很少有研究在脑部疾病分类任务上评估这种方法,主要仍局限于年龄和性别预测任务。

总结以前的研究,对于个体预测任务,深度学习的优势尚无共识。虽然Schulz等人(2020)仅提供了对年龄和性别预测的部分分析,但Abrol等人(2021)扩展了这两项任务的研究发现,认为DL能够优于SML。这两项工作主要局限于相同的预测任务(年龄和性别预测),并且都使用相同的基准资源(UKB)提供经验证据。在本研究中,我们提出使用不同的神经影像数据集研究更具临床相关性的任务,以比较DL与SML的学习能力。我们还旨在探索基于迁移学习(TL)的DL新学习策略,这在先前研究中尚未被探讨。

贡献

我们提议重新审视并扩展近期工作对大型多中心数据集的分析。我们使用迄今为止最大的多中心临床数据集之一,在五个监督任务(年龄、性别预测和脑部疾病诊断)上进行广泛实验,比较DL与线性和核SVM(即SML)模型。我们研究解剖数据的预处理(VBM和准原始)、DL模型的数据增强、SML模型的降维(高斯随机投影、单变量特征选择、递归特征消除),以及中等规模(n≈1k)和大规模(n≈10k)数据体系中的跨中心泛化。与以往文献不同,我们还考虑了基于自监督预训练、生成建模和监督预训练的三种主要迁移学习策略用于DL的精神疾病分类(见图1)。最后,我们考虑使用深度集成技术来量化深度模型中的不确定性并分析其对预测的影响。

总之,在本研究中,我们致力于探索神经影像学的关键问题:当前最先进的DL模型能否从高度多中心的脑部疾病数据集中提取非线性特征?与标准机器学习模型相比,它们如何扩展?我们能否迁移健康人群的脑表征来更好地区分精神疾病患者?

2.方法

2.1. 数据

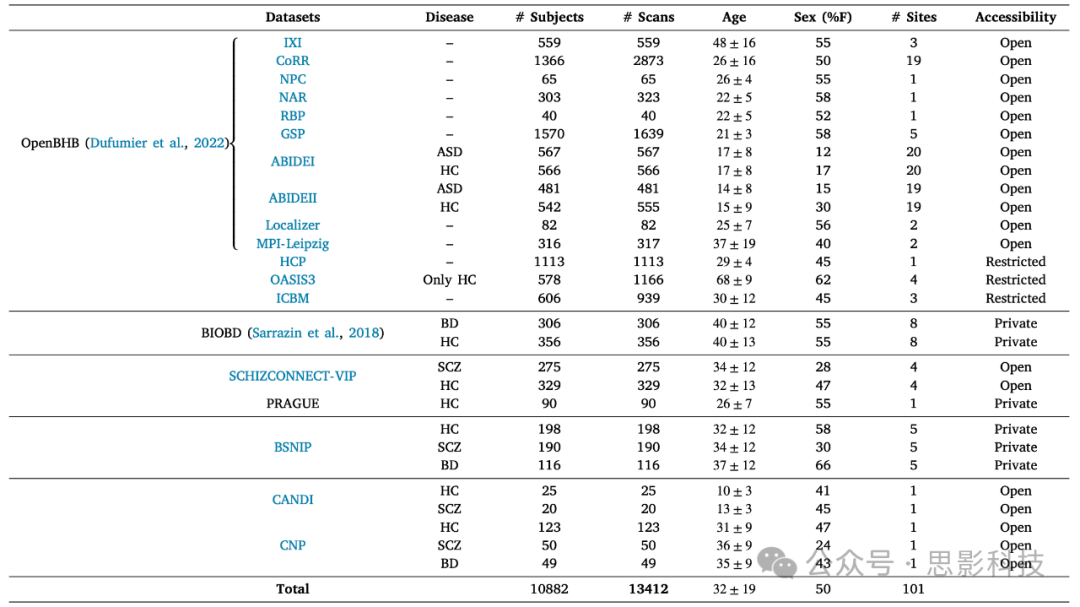

所有数据都通过各种数据共享计划、联盟和平台收集,可以在表1中的超链接访问相关专门论文和网页。我们在表1中报告了所有数据集的最重要人口统计学信息。重要的是,由于我们认识到可重复性对所有机器学习/深度学习研究都至关重要,我们还整合了最近发布的OpenBHB数据集。为了保证可重复性,年龄和性别预测使用的测试集划分仅使用OpenBHB的数据,详见2.4节。

表1. 本研究中使用的数据集的人口统计学信息

我们整合了OpenBHB,这是一个可自由获取的大型多中心结构性磁共振成像数据集,我们从中抽取训练集(直至Ntrain=5000)以及用于所有年龄和性别预测实验的内部和外部测试集。

2.2. 数据预处理

2.2.1. 基于体素的形态测量(VBM)

VBM预处理使用SPM工具箱中的CAT12执行,主要包括噪声和偏场校正,随后进行灰质(GM)、白质(WM)和脑脊液(CSF)分割。图像使用DARTEL非线性对齐到MNI模板,并使用雅可比变形场图进行调制。所有结构性磁共振成像扫描通过线性样条插值重采样为各向同性1.5mm³空间分辨率,维度为121×145×121。更高的空间分辨率会带来更大的计算负担,考虑到我们队列中扫描仪参数的差异(如永磁场),我们决定为所有图像固定这一分辨率。我们还使用CAT12估计的颅内总体积(TIV)对所有图像进行标准化,以消除(无关的)头部大小差异。我们对所有预处理图像进行视觉质量检查,以去除分割不良的图像或存在明显MRI伪影的图像。

2.2.2. 准原始数据

与VBM相比,准原始预处理设计为最小化处理。仅保留必要步骤将来自不同站点和扫描仪的图像映射到相同空间和分辨率,并仅应用必要的图像校正步骤。具体来说,每次扫描都被刚性重定向到MNI空间,然后通过线性样条插值重采样到1.5mm³空间分辨率。使用来自ANTs的N4ITK算法校正偏场,并使用BET2提取大脑(去除颅骨和非脑组织)。每个图像使用FSL的FLIRT进行线性配准(9个自由度)到MNI模板。在训练DL模型时,我们通过减去均值并除以在每个体积中跨体素计算的标准差来标准化每个准原始图像。

2.3. 表型预测的机器学习流程

首先,我们希望验证几项研究在解剖数据的年龄和性别预测上获得的结果,随着训练样本数量Ntrain的增加,对DL和SML都进行评估,但有几个关键区别:(i)我们不对DL和SML进行特征选择(这一点在3.1.4节深入研究);(ii)我们分别预测年龄和性别以避免任意的年龄离散化;(iii)我们在包括从未见过的站点的外部测试集和按年龄、性别和站点分层的内部测试集上评估泛化性能(见后文2.4节)。使用外部测试集使我们能够给出无偏结果,因为模型无法基于与站点信息相关的混杂变量进行预测。然后,我们探索DL与SML模型在三个难度递增的精神病诊断二分类任务上的表现,包括精神分裂症、双相障碍和ASD患者。重要的是,这三个任务难度不同(至少对于SML而言),人们可能期望在SML模型表现不佳的更具挑战性任务中使用非线性模型会有所改进(如在ASD中)。我们汇集了大量(n=19)数据集,涵盖广泛的年龄范围(从儿童到老年),并在男性和女性之间保持平衡(见2.1节)。

2.3.1. SML模型

我们考虑了两种线性模型,分别使用ℓ2和ℓ1+ℓ2惩罚项以促进简约且收缩的解,同时还使用了径向基函数核SVM(rbf-SVM)。这些模型在文献中已被广泛使用,并且即使在交叉验证期间包含额外的核函数(如多项式或sigmoid函数)时,也始终表现出相似的性能。

2.3.2. DL架构

由于神经影像领域缺乏标准基准,对于适合我们下游任务的DL架构仍没有共识。我们将分析重点放在最先进的CNN架构和Transformer上,因为它们在图像识别任务上持续表现出顶级性能。具体来说,我们选择了经典的3D-AlexNet架构,如Abrol等人所定义,由五个卷积层组成。这个网络被Abrol等人称为"DL1",并在他们的大多数实验中使用。为了利用DL领域的最新进展,我们还采用了3D-ResNet18和3D-DenseNet121,这与最近使用结构性神经影像数据的工作类似。后者有121层,是本文中使用的最深的网络。最后,我们还在补充材料E中比较了基于Transformer的架构和更小的CNN骨干网络,但它们的表现系统性地低于本研究中选择的三个模型。所有网络都用Python实现。

2.4. 交叉验证程序和训练集划分

对于年龄回归和性别预测,我们构建了一个多中心数据集,包括OpenBHB(见表1) - 一个无需额外授权即可访问的公共数据集 - 以及更多受限数据集:HCP、OASIS 3(仅健康对照组, HC)、ICBM、BIOBD(仅HC)、SCHIZCONNECT-VIP1(仅HC)和BSNIP(仅HC)。最终,我们收集了来自8679名参与者的11210次扫描,涉及99个中心。我们首先用MPI-Leipzig和NAR构建外部测试数据集(来自3个中心的619名参与者的640次扫描,覆盖全生命周期)。然后,从OpenBHB中,我们构建了按年龄/性别/中心分层的内部测试数据集和分层验证数据集,分别包含来自480名参与者的662次扫描和来自482名参与者的655次扫描。剩余的训练集包含来自7098名参与者的9253次扫描。重要的是,每个参与者仅出现在一个划分中,以避免验证/测试集的数据泄漏。我们选择仅使用OpenBHB的验证/测试集以促进我们工作的可重复性。

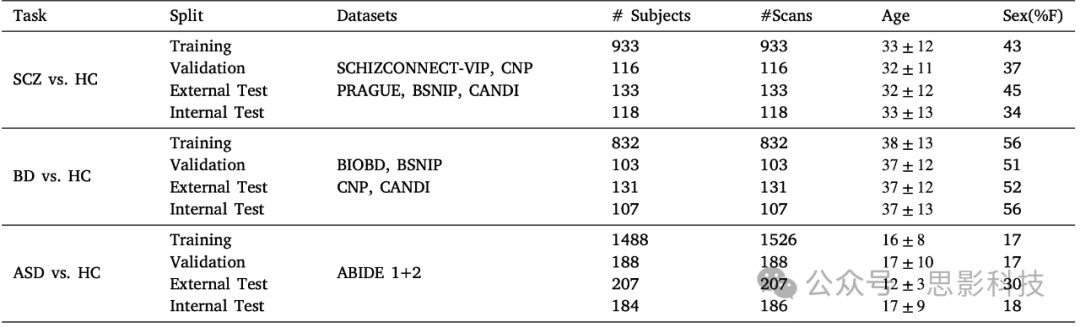

最后,我们以分层方式(按年龄、性别和中心)对该训练集进行子采样,以便使用蒙特卡洛交叉验证(CV)程序计算不同训练样本大小(N∈[100,500,1000,3000,5000,9253])下的年龄和性别预测性能。对于N≤500,我们重复子采样五次,其他情况重复三次,以保持合理的计算预算,同时仍能得到分类器性能的一致估计。关于精神分裂症、双相障碍和自闭症检测,我们在表2中详细说明了使用的划分。我们对所有模型(SML和DL)使用相同的划分,并重复每个实验30次,使用不同的随机初始化并报告平均值和标准差。

表2. 用于三种精神疾病检测的训练/验证/测试集划分

外部中心的图像始终构成外部测试集,每个参与者仅属于一个划分,避免数据泄漏。内部测试集始终根据年龄、性别、中心、诊断以及训练和验证集进行分层。所有模型使用相同的划分。

2.5. DL和SML训练

我们对SML模型进行网格搜索,使用完整训练集为所有任务选择最佳超参数值。具体来说,对于Logistic和Ridge回归,我们在[10⁻¹,1,10,10²,10³]范围内调整正则化项α;对于ElasticNet,我们还在[0.1,0.5,0.9]范围内调整ℓ1比率项。对于rbf-SVM,我们在分类和回归问题中都在[10⁻¹,1,10,100]范围内调整gamma参数。

我们使用PyTorch库实现所有DNN,使用scikit-learn库实现SML模型。与Abrol等人类似,我们使用Adam优化器执行随机梯度下降(SGD),权重衰减固定为10⁻⁵。我们在[10⁻³,10⁻⁴,10⁻⁵]范围内调整学习率α,每次都使用最大训练样本数进行所有回归和分类任务,发现α=10⁻⁴对所有DNN都是一个不错的值。然后,我们通过每10个epoch降低初始学习率α来交叉验证超参数γ∈[0.2,0.4,0.8]。出于计算原因,我们将批量大小b设为32。我们对年龄和性别预测训练DNN 300个epoch,对诊断分类训练100个epoch。虽然我们尽最大努力交叉验证DL模型的关键超参数,但我们无法合理地用网格搜索测试所有超参数(如非线性、优化器等)。这是使用DL时的一个基本挑战,因为我们优化具有许多局部最小值的高度非凸函数。这促使计算机视觉领域出现标准基准(如ImageNet),使SOTA模型之间的比较和复现变得容易。尽管神经影像学界迫切需要这样的基准,但我们尽最大努力为所有SML和DL模型获得强有力的基线。

2.6. 脑影像分析中的VBM与准原始预处理比较

在本研究中,我们比较两种主要预处理方法:基于体素的形态测量(VBM)和准原始数据。VBM数据提供每个体素中灰质密度的体积信息,这些是表型的良好预测指标。然而,原始MR图像可能包含比VBM更多的信息,特别是与皮层褶皱模式相关的信息,这些可能预示精神疾病(如脑回指数)。这表明原始图像可能带来比VBM图像更多的判别信息。我们旨在阐明DNN是否能提取这些互补模式并因此获得更好的性能。首先,我们按照2.3节描述的分析流程,在我们的五个基准任务上评估VBM数据和准原始数据上的DL模型。

然后,我们假设年龄预测的内部和外部测试之间的领域差距在原始数据上比在VBM预处理数据上更明显。为检验这一假设,我们绘制由使用最大可用样本量(Ntrain=9253)训练的DenseNet编码的原始和VBM预处理图像(来自内部和外部测试集)。我们使用t-SNE可视化将嵌入图像映射到2D表示。

最后,我们进行间接测试,检查扫描仪引入的噪声是否解释了在精神疾病上使用VBM与准原始数据训练的DNN获得的结果差异。从使用给定预处理(VBM或原始)训练预测特定精神状况的网络中,我们训练一个线性分类器从网络表征预测采集站点。我们假设,当由训练用于临床任务的DNN嵌入时,从准原始数据比从VBM数据更容易解码采集站点。

2.7. 数据增强

考虑到临床数据集中样本量小(通常N≈1k)和脑图像输入维度高(>1M体素)的特点,数据增强应该提供一种简单的方法来人工增加数据集大小,限制过拟合并提高性能。从邻域风险最小化的角度来看,Chapelle等人表明,它可以被视为一种对预测任务的给定变换施加不变性的正则化技术。我们评估了五种标准增强方法:仿射变换(包括旋转和平移)、翻转、随机高斯噪声、裁剪和遮挡,用于所有精神疾病分类任务。对于每种策略,我们都测试了强增强和弱增强。正如Hernandez-Garcia指出的,强增强与弱增强相比产生更具生物学合理性的表征(因为它可能生成DNN应该探索的样本,以便在测试图像上获得良好的泛化,利用领域知识)。交叉验证的超参数在补充表8中说明。

我们首先在VBM数据上评估这些增强方法。我们也可能假设这些变换更适合准原始图像,因为它们只是线性配准到MNI模板,且可能比VBM图像更嘈杂。为了验证这个假设,我们对准原始图像应用所有先前增强方法(遮挡、裁剪、仿射、高斯噪声、翻转)的随机组合,每种变换的概率为50%。我们报告使用与补充表8相同超参数的强增强和弱增强的性能,并将其与VBM和准原始数据上不使用增强的基线结果进行比较。在所有这些实验中我们使用DenseNet121作为骨干网络。

2.8. 使用ComBat和线性调整回归进行数据协调

如多个多中心研究所报告的,扫描仪和采集协议之间的高异质性导致ML模型在跨中心图像(即来自训练期间未使用的其他中心)上表现不佳。这也解释了为什么我们谨慎地引入外部测试来评估模型的泛化性能。在这里,我们利用两种最先进的协调方法来去除非生物学变异:ComBat和线性调整回归。这两种方法直接协调数据而不改变模型(与最近作用于DL表征的方法相反),允许在SML和DL方法之间进行公平比较。ComBat和线性调整回归都需要所有中心的图像统计信息来去除中心信息。然而,在我们的情况下,只有训练集和内部测试集包含相同的中心,所以我们只对这两个集合进行残差化,保持外部测试集不变。

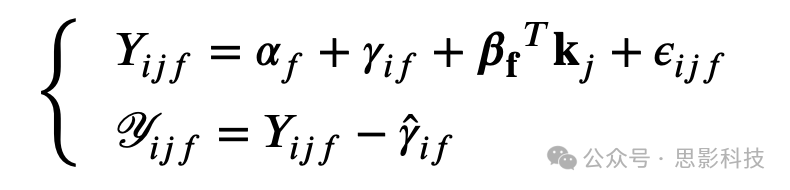

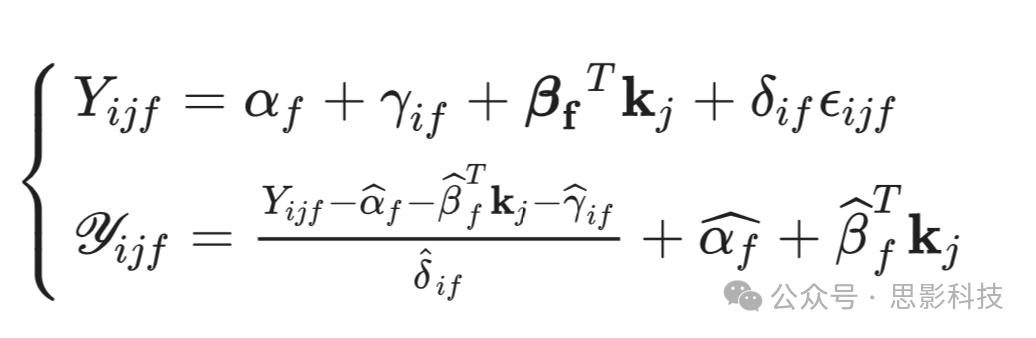

线性调整回归是一种线性协调方法,试图在去除非生物学效应(如中心效应)的同时保留数据中的生物学变异性。该模型本身可以表示为:

其中Yᵢⱼf是站点i、受试者j、体素f的体素值;αf是体素f的平均测量值,γᵢf是站点效应,kⱼ是我们想要保留的受试者j的生物学变量向量(即年龄、性别,最终还包括诊断),βf是通过线性回归估计的参数,ϵᵢⱼf是残差噪声。Y𝑖𝑗𝑓是残差化的体素值,其中γ̂ᵢf是估计的站点效应。参数γᵢf和βf在训练期间估计。

不同的是,ComBat在残差噪声上添加了一个乘性非线性效应δᵢf,这导致了一个不同的残差化方案,该方案同样需要生物学变量kⱼ:

这些模型通常需要在训练期间访问所有成像站点。在我们的实验设计中,这只有在使用内部测试集时才可能,而在使用独立的外部测试集时则不可能。为避免残差化过程中可能的数据泄漏,我们建议在线性调整回归和ComBat中对所有未知测试站点i设置δᵢf=1和γᵢf=0。这并不理想,其他基于DL的解决方案开始在文献中出现,但仍没有共识,大多数当前研究使用ComBat或线性调整回归。

2.9. SML模型的降维

先前的研究认为降维是SML模型限制过拟合和正常工作的必要步骤(特别是考虑到3D MRI的超高维度,体素数>300K)。我们在BHB-10K上仔细重现了这些研究的实验设计(相同的特征空间维度p=784和降维方法)来测试这个假设。

具体来说,我们使用三种不同的特征选择方法:高斯随机投影(GRP)、随机特征消除(RFE)和单变量特征选择(UFS),遵循Abrol等人和Schulz等人的方法。与RFE和UFS不同,GRP是一种无监督特征选择方法,它对数据应用随机矩阵并保持点之间的欧几里得距离,误差ϵ取决于所选特征的数量。我们在内部和外部测试集上评估这些策略在我们五个预测任务上的表现。作为与当前文献的直接比较,我们还在UKBioBank上评估了这些降维方法在年龄回归任务上的表现。

2.10. DL和SML模型解释

虽然DL模型常被视为"黑盒"模型,但多年来已提出多种可解释性方法来突显对模型决策重要的图像区域。在此,我们旨在阐明DL(从头训练)和线性模型是否基于相同的脑区模式做出决策,这是精准精神病学的一个关键问题。

在这方面,线性模型更容易解释,因为我们可以直接访问加权图(或重要性图)。在加权图中,每个权重都与唯一的输入特征相关联。更高的绝对权重值表明相应输入特征对最终预测分数的重要性更强。特别是,在使用解剖图像的临床环境中,具有高正权重(或负权重)区域的肥大(或萎缩)转化为给定病理的更强大脑特征,即更高的预测分数。

为了推广到非线性情况,我们选择了基于梯度的方法来解释DL模型。这种敏感性分析计算预测输出相对于每个输入体素的梯度(即量化输出预测值如何随输入体素值变化)。多年来已提出更复杂的基于梯度的模型,但它们并不一定产生更准确的显著性图。与Abrol等人类似,我们使用自动解剖标记图谱(AAL)为每个在每个任务上用最大样本数训练的模型计算脑区重要性图。具体来说,通过敏感性分析为每个输入图像计算加权图,并对每个区域的所有绝对值求和。将得到的重要性图标准化使其和为一。最后,对每个测试集(内部和外部)的所有重要性图取平均。我们计算所有平均图之间的相关矩阵,以比较SML和DL模型获得的区域重要性。

2.11. 深度集成学习

用于DNN不确定性量化的深度集成

在医院实施AI工具的真实场景中,了解与预测相关的不确定性至关重要。首先,它使临床医生能够(或不能)信任系统。其次,过于自信的系统可能会在错误预测上高度影响专家意见。第三,知道预测何时可能不正确(例如,对于域外图像)可能会提高性能,因为它使系统能够"超越效应存在与否的二元陈述;并为所有相关模型参数提供可信度估计,从而使单个受试者预测具有严格的不确定性区间"。在这方面,贝叶斯模型(如MC-Dropout)和深度集成学习已被开发用于量化预测DNN的不确定性。最近的基准测试表明后者优于前者,考虑到其简单性,我们采用这个框架进行脑部疾病分类。

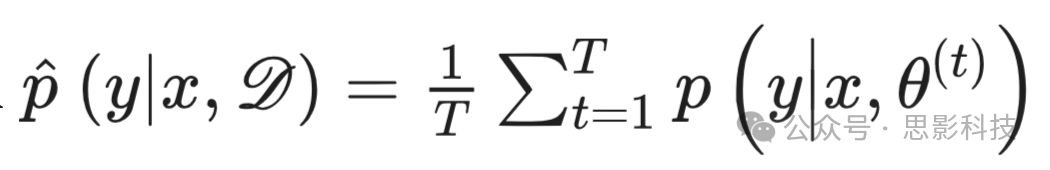

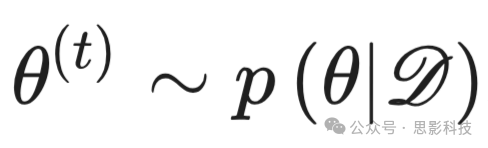

以前的深度模型在其预测中并不包含任何不确定性的概念。一旦训练完成,它们会针对任何输入图像x,基于训练集D估计预测分布p(y|x,D)(其中y代表临床状态)。然而,现代DNNs往往在预测时过度自信(Guo等,2017),这极大地限制了它们的可靠性和临床使用。Yarin Gal(2016)引入了认知不确定性的概念,以量化与DNNs中模型权重θ相关的不确定性。Lakshminarayanan等(2017)表明,深度集成通过聚合多个从不同随机初始化通过随机梯度下降(SGD)训练的DNNs输出

,提供了一种量化这种不确定性的简单方法。

从贝叶斯的角度来看,对于T个训练好的深度神经网络(DNNs),其平均分布

可以被视为通过蒙特卡洛采样

对后验分布p(y∣x,D) 的估计。

实现

如Lee等人所示,在整个数据集上独立训练神经网络的深度集成学习在准确性和校准方面比bagging(装袋算法)获益更多。因此,在我们的研究中,我们使用DL中常用的标准深度集成策略:每次使用不同的随机种子训练每个网络,并在整个训练集上执行随机梯度下降。然后,对于回归任务(或分类任务),对所有网络的输出值(或softmax后计算的概率)取平均。这种策略鼓励学习到的DL表征多样性,而无需在网络间共享权重。虽然增加独立训练网络的数量T可以增加这种多样性,但计算成本很高。作为性能、计算时间和内存之间的权衡,我们在实验中固定T=3。

2.12. 迁移学习的预训练策略

除了利用原始数据外,深度模型相比SML还有几个关键优势。由于DL应能够学习与给定任务相关的低级和高级成像特征,人们假设至少部分信息可能对其他任务或领域重要。迁移学习建立在这一想法之上,并在自然和医学图像上都取得了良好性能。与此密切相关的是,在一项关于静息态fMRI的最新研究中,He等人展示了一个训练用于预测大量表型(如认知或血液生物标志物)的ML系统如何能提升UKBioBank上相关但不同表型集的预测。正如最近一项研究所建议的,在大规模数据体系中预测表型或人口统计信息可能通过DNN实现,显著优于SML(例如年龄回归)。这表明从脑成像中发现了与病理无关的非线性模式。这些非特异性变异轴的发现应该允许在第二阶段学习与精神疾病相关的特定变异性。

我们提议使用图1所描述的新范式来训练DNN区分精神疾病和对照。在第一个预训练步骤中,我们在健康人群(从儿童到老年)的脑MRI上预训练DNN,学习捕捉健康大脑的生物和环境变异性的表征。这可以通过大规模数据集实现。然后,在第二步中,对网络进行微调以从脑MRI预测精神状况。我们的主要假设是,预训练期间学习的表征将有助于发现与特定精神状况相关的病理变异性。

我们探索五种预训练策略,在应用迁移学习到临床数据集之前从健康人群中学习解剖特征:

(1)我们提出的将参与者年龄作为辅助信息整合的弱自监督模型——即年龄感知对比学习;

(2)自监督对比学习(SimCLR);

(3)基于上下文恢复的医学影像最新自监督模型(Model Genesis);

(4)作为最新生成模型的变分自编码器(VAE)(比GAN更容易训练且集成了可微调的编码器);

(5)在年龄预测上训练的判别性监督模型。重要的是,年龄信息仅在年龄感知CL和监督模型的预训练期间使用,在微调期间从不使用。所有这些模型都在OpenBHB上预训练(还包括HCP、ICBM和OASIS3以增加数据集大小,不包括ABIDE以避免ASD预测的数据泄漏)。这个数据集是国际性的且高度多中心化的,促进了研究人群和图像质量的异质性。为了交叉验证超参数,我们推导出与年龄和性别预测相同的验证集(按年龄、性别和站点分层)。下面我们详细描述这五种策略。

2.12.1 自监督学习

考虑年龄的对比学习

为了学习健康人群的大脑表征,我们开发了一种新的自监督算法(Dufumier et al., 2021a),该算法基于对比学习的最新发展(Chen et al., 2020, He et al., 2020b)。具体而言,该算法能够:(i)编码对一组图像变换T的不变性,(ii)整合表型信息(在我们的例子中是参与者的实际年龄),使得具有相近表型的图像在深度学习空间中具有相近的表征。根据我们在精神疾病方面的探索性工作(Dufumier et al., 2021a),我们选择了变换集T。在我们的情况下,T包括随机裁剪,即在输入图像的随机位置应用一个覆盖图像1/16的黑色补丁。来自同一个体的两个缺失小部分的大脑图像仍然共享大部分解剖特征。因此,特性(i)强制编码器将这两个图像映射到表征空间中的同一点。为了确保满足特性(ii),我们使用径向基函数核来衡量两个实际年龄之间的相似度。我们按照Dufumier等人(2021a)的描述优化了Age-Aware InfoNCE损失。σ2在{1,2,3,5}中通过交叉验证选择。与我们之前的工作类似(Dufumier et al., 2021a),我们使用DenseNet121作为深度学习编码器,使用2层MLP作为非线性投影头(参见我们的代码)。我们将批量大小设置为b=64。

在使用Age-Aware InfoNCE损失进行预训练后,我们通过交叉验证学习率α和调度器超参数γ来对每个下游任务微调编码器,方式与从头训练的深度学习模型相同(参见2.5节)。在预训练编码器之上添加一个随机初始化的线性层,并在每个下游任务上进行端到端训练。

对比学习

为了与之前开发的算法进行公平比较,我们还探索了SimCLR(Chen et al., 2020),这是一个适用于大脑MRI的最先进的对比学习模型。具体来说,我们在预训练期间使用了相同的变换T(基于裁剪),并训练了100个周期。由于前置任务很快就解决了(在不到10个周期内达到99%的准确率),我们在(i)10个周期,(ii)30个周期,(iii)100个周期后对预训练模型进行了微调,并在微调期间交叉验证了最优的γ,同时设置学习率α=10−4。使用训练10个周期的预训练模型获得了最佳结果,这表明在训练集上快速过拟合(即使我们达到了约10k个样本)。

基于上下文的重建

基于上下文的重建是最近在医学影像领域出现的一类独特的自监督模型。它可以被视为用于表征学习的去噪自编码器(Vincent et al., 2008)的特例(如图像修复(Pathak et al., 2016)),其理念是使用编码器-解码器神经网络从人为降质的图像版本中恢复原始图像。这种方法主要需要定义降质模块,并将输入图像转换为降质的、变换后的版本。值得注意的是,降质图像不需要真实,而是需要隐藏/转换可以从其周围上下文推断出的重要语义信息(类比于自然语言处理,其中典型的自监督任务包括在句子中恢复缺失的单词Devlin et al., 2019)。Model Genesis(Zhou et al., 2021)定义了这样一个模块,并引入了不同的策略来学习上下文、纹理和外观。原始方案利用UNet骨干网络(在编码器和解码器之间有跳跃连接)从医学图像中学习3D图像表征。我们采用相同的原始变换和骨干网络,在与其他方法相同的大脑MRI数据集上进行预训练。我们使用学习率10−4和Adam优化器训练200个周期。

2.12.2 变分自编码器

VAE (Kingma and Welling, 2014)是一种生成模型,使用编码器-解码器架构来(i)从潜在表征重建输入图像,以及(ii)在潜在空间中强制施加先验分布(通常是高斯分布)。训练完成后,VAE既可以用于从已知的先验分布生成新样本,也可以通过其编码器对输入图像进行编码。训练过程中遇到的一个主要困难是避免后验崩塌,即后验潜在变量等于先验(因此忽略了输入信号)。这主要是由于潜在变量的不可识别性问题(Wang et al., 2021),部分原因在于模型架构。我们使用两种方法来避免这种行为:(1)编码器-解码器架构很轻量,编码器中只包含5个卷积块(和一个使用转置卷积的对称解码器);(2)使用β-VAE (Higgins et al., 2016)目标函数来限制参数空间。β选择较小(𝛽 = 10−5),并使用线性探测来验证预训练模型。线性探测是表征学习领域的一个简单工具。在这里,它包括在预训练的VAE编码器之上训练一个线性层来预测表型(年龄和性别)。我们假设如果可以从潜在表征成功预测生物变量,则VAE模型已经学习到了可迁移的解剖大脑模式。岭回归用于预测年龄,逻辑回归用于预测性别,正则化项α∈{10−2,10−1,1,101,102,103}在验证集上进行交叉验证。

2.12.3 监督学习

这种预训练策略是最简单但也是迁移学习中最广泛使用的(Yosinski et al., 2014):网络以监督方式在大规模数据库上训练以预测丰富的信号,我们假设高层语义特征将在下游任务中被重用。在我们的情况下,它包括通过训练一个DNN(这里是DenseNet121)来建模正常大脑衰老,从我们的大规模健康对照(HC)数据集中预测年龄。与ImageNet预训练相比,它有两个关键优势:(i)我们不存在自然图像和医学图像之间的域差距,(ii)我们可以直接使用3D DNN迁移到3D数据。最近关于医学图像迁移学习的研究(Raghu et al., 2019, Azizi et al., 2021)表明,域差距可能会损害性能。

2.13 方差分析

为了更好地解释迁移学习和深度集成的性能,我们假设预训练模型不会像随机初始化模型那样逃离初始盆地景观(Neyshabur et al., 2020),导致模型优化过程中的方差较小。我们在SCZ vs. HC和BD vs. HC上测试了这个假设,在每个任务上训练了n=30个独立的DNN,每次使用相同的训练集但不同的初始化(基线使用随机初始化,迁移和迁移+深度集成使用预训练)。然后我们计算模型之间每50个周期的性能方差,并报告标准差。考虑到计算成本,我们没有对ASD vs. HC运行这个实验(ASD是本研究中最大的临床数据集)。对于所有任务和模型,标准差使用30个独立测量值估计,除了迁移+深度集成使用10个测量值(因为我们对每个测量值聚合三个DNN)。

3. 结果

3.1 从头训练的深度学习与线性模型在精神疾病预测上性能相当

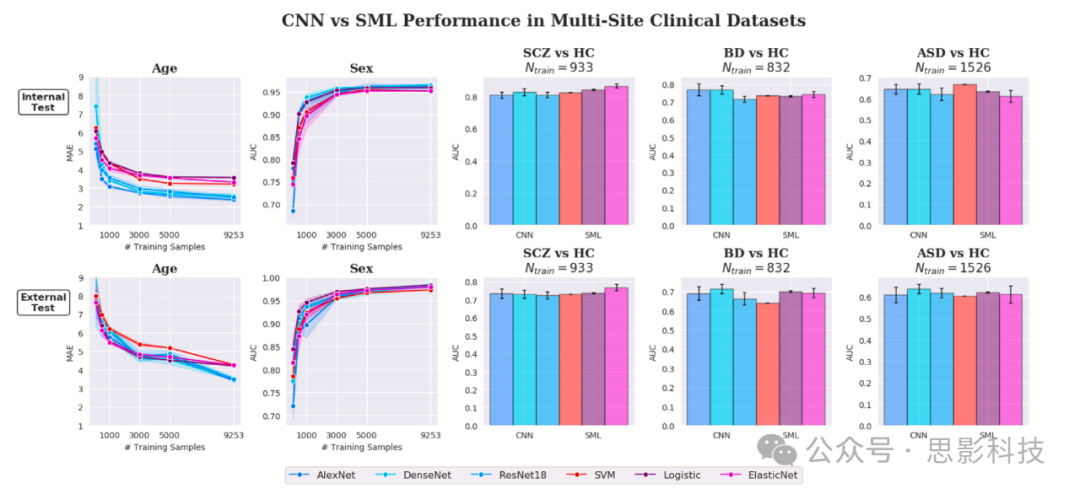

我们首先评估深度学习(DL)和传统机器学习(SML)模型在VBM数据的多站点数据集上五个预测任务的性能。从图2可以观察到,在所有分类任务(包括性别预测和疾病诊断)上,所有模型都表现出非常相似的性能,即使在非常大的数据规模下(性别预测的训练样本量超过9000)。具体来说,所有模型在两个测试集上的性别预测都达到了几乎完美的AUC分数(曲线下面积),在外部测试集上训练样本量为9253时,逻辑回归的AUC为98.32%,DenseNet的AUC为98.47%。虽然DenseNet在检测精神分裂症、双相障碍和自闭症方面几乎总是表现最好的网络,但它的性能与L2逻辑回归和rbf-SVM相当,即在内部测试中SCZ vs. HC的AUC约为85%、BD vs. HC约为76%,以及ASD vs. HC约为65%。DenseNet(和其他模型一样)在外部测试上显示出较差的泛化性能,分别在SCZ vs. HC、BD vs. HC和ASD vs. HC上损失了10%、5%和1%的AUC。

图2. 深度学习(DL)与传统机器学习(SML)在表型预测和难度递增的诊断分类任务上的性能对比(基于高度多站点数据集)。

对于SML方法,评估了两种线性模型:带𝓁1惩罚(Logistic)或𝓁1+𝓁2惩罚(ElasticNet)的模型,以及非线性径向基函数(rbf)SVM。至于DL,考虑了基础的AlexNet(Krizhevsky等,2012)(此前由Abrol等(2021)引入,具有250万参数和5层)以及更先进的ResNet18(He等,2016)(3320万参数,18层)和DenseNet121(Huang等,2017)(1120万参数,121层,利用跳跃连接和特征重用的优势)。DL和SML算法都在全脑3D解剖图像上训练。

所有模型在两个不同的测试集上进行评估:一个是按年龄、性别和站点分层的内部测试集(Npheno_test=662,Npheno_val=655),以及临床数据集(Nscz_test=118,Nscz_val=116,Nbd_test=107,Nbd_val=103,Nasd_test=184,Nasd_val=188);另一个是包含训练期间从未见过的站点的外部测试集(Npheno_test=640,Nscz_test=133,Nbd_test=131,Nasd_test=207)。模型在这个测试集上不能使用站点特定信息进行预测,消除了文献中报告的一个强大偏差。

对于年龄和性别预测,我们对Ntrain∈{100, 500}(分别对Ntrain∈{1000, 3000, 5000, 9253})执行了5折(分别是3折)蒙特卡洛交叉验证子采样程序。对于诊断分类任务,每个模型使用不同的随机初始化训练30次,并报告平均值和标准偏差。年龄预测使用平均绝对误差(MAE)作为参考度量,而二元分类任务首选曲线下面积(AUC),因为它不依赖于特定阈值(它只衡量分类器的判别能力)。

总体而言,对于性别预测(直至Ntrain=9253)、精神分裂症vs健康对照、双相障碍vs健康对照和自闭症vs健康对照,SML模型与DL模型表现同样出色。在外部测试中,随着训练主体数量Ntrain的增加,SML和DL在年龄预测方面的性能持续改善。另一方面,在内部测试中,从Ntrain≈3k开始,性能增长非常缓慢(几乎是平台期),非线性DL模型相对于SML有显著改善。

关于年龄回归,我们观察到深度学习只有在大规模数据范围(Ntrain > 9k)的外部测试中才优于SML,例如AlexNet和ElasticNet之间的ΔMAE = 0.82。在内部测试中,深度学习始终优于SML,这与之前的研究结果一致。与先前研究相比,我们获得了最优性能(MAE=2.36±0.04),这验证了深度学习模型的架构设计(更多使用Transformer的实验见补充材料E)。内部和外部测试之间的这种差异表明,由于对采集站点的严重过拟合,在跨站点图像上的泛化性能较差。

为进一步验证我们的年龄预测结果,我们在UKBioBank数据集上复制了SML分析流程。在补充材料A中,我们展示了当Ntrain = 9253时,深度学习在年龄回归上大幅优于SML(MAE提升0.9),但要在外部测试中达到这样的结果需要比Ntrain = 100更多的样本,这与内部测试的发现不同。这证实了我们的SML流程与UKBioBank当前文献中的结果具有竞争力,并将文献中报告的结果扩展到年龄回归的跨站点泛化。

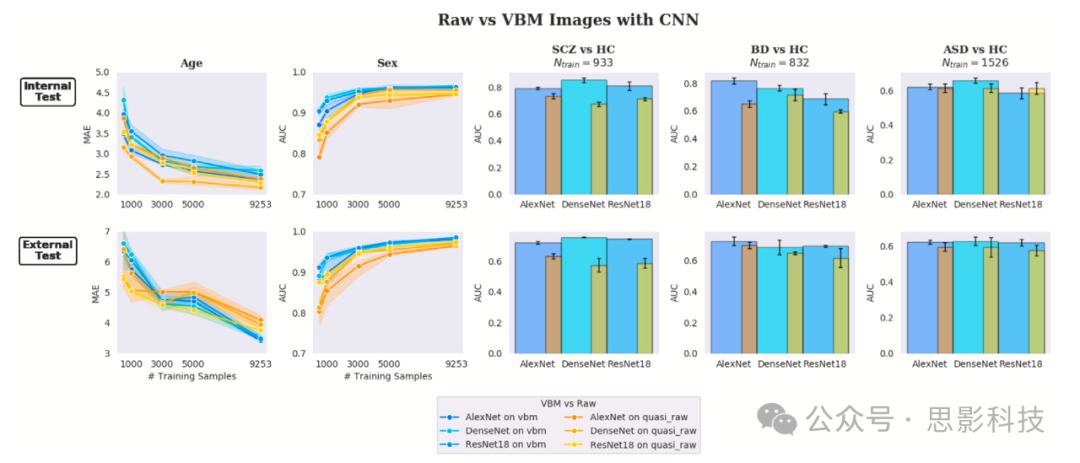

3.1.1 深度学习模型在原始数据上表现不佳

我们绘制了在准原始数据上训练和评估的深度学习模型的性能,并将其与VBM数据上获得的先前结果进行比较。图3显示,在当前样本量(Ntrain ≤ 10k)下,深度学习模型在所有任务和测试集上的原始图像表现都不如VBM数据。具体来说,我们观察到在外部测试集上,性别分类的ROC-AUC下降了1.6%,年龄回归的MAE增加了0.25(Ntrain = 9253,分别使用DenseNet和ResNet,这是这两个任务上表现最好的模型)。关于精神疾病的分类,这种效应更为显著,在外部测试集上,精神分裂症、双相障碍和自闭症在VBM和原始数据之间的平均AUC分别下降了14%、4%和3%。唯一的例外是内部测试的年龄预测性能,但与在VBM数据上训练的模型相比,它们在外部数据上的泛化能力仍然较差。这表明深度学习模型在原始图像上比VBM更容易对采集站点过拟合。

图3. 深度学习性能在原始脑部图像和经过广泛预处理、非线性配准的解剖灰质(GM)脑部图像(即VBM)上进行评估。结果表明,即使在大规模数据条件下,深度学习模型也无法从原始图像中提取比完全预处理图像更具判别性的特征。

在训练用于年龄回归的DenseNet的潜在空间中,我们在补充图8中观察到来自内部测试集和外部测试集的嵌入原始图像之间存在明显的分离(特别是对于20-40岁的中年参与者)。对于VBM图像则不是这种情况,在给定年龄范围内,站点间和站点内的嵌入图像在潜在空间中正确重叠(蓝色/橙色和黄色/青色)。原始编码图像在内部和外部测试集之间的这种更大差异(即域差距)可以解释图3中所示的年龄预测差异,支持了站点过拟合假设。

定量来说,我们在补充表12中显示,从训练用于分类SCZ、BD和ASD的DenseNet的准原始数据嵌入中,可以分别以70%、82%和48%的平衡准确率线性解码采集站点。这比在VBM数据上训练的相同网络高出40%以上。这表明深度神经网络无法从原始图像中压缩与疾病相关的特征,并倾向于快速过拟合扫描仪产生的噪声。

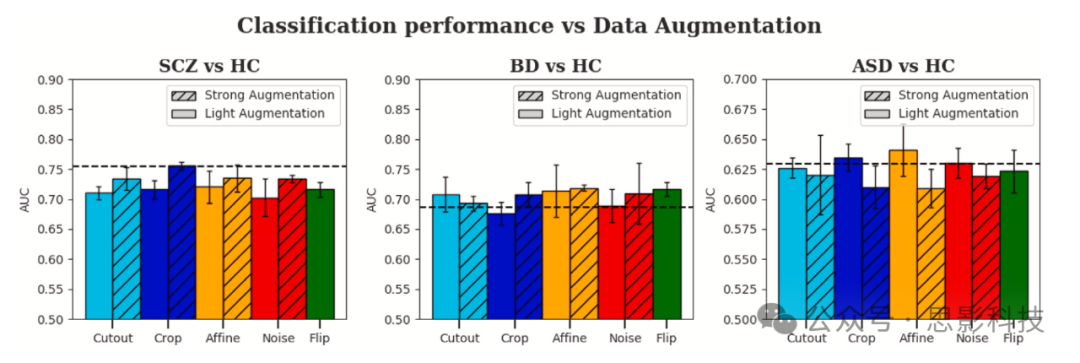

3.1.2. 数据增强并未改善性能

为了人为增加临床数据集的样本量,我们研究了VBM数据上的数据增强。令人惊讶的是,在图4中,我们没有观察到深度学习模型性能的显著改善。根据任务的不同,使用轻度或强度增强反而可能会降低性能。这表明当前的增强方法高度依赖于类别。

图4. 在VBM数据上评估了五种增强策略,使用两组不同的超参数(轻度和强度,见补充表8)。为了完整性,这些增强策略也在所有临床任务的准原始数据上进行了评估(见补充表9)。总体而言,数据增强并未显著改善所有临床任务的性能。在本研究的其余部分,我们在训练深度模型时不执行任何特定的增强。

我们在补充表9中也报告了准原始图像的性能。同样,我们观察到除了在内部测试的SCZ vs HC任务外,测试的增强方法都没有带来改善,而且性能始终远低于VBM数据的基准。因此,在本研究的其余部分,我们只使用权重衰减作为正则化技术,不使用数据增强。

3.1.3. 数据协调产生混合结果

考虑到神经影像数据的站点相关效应,我们探索了数据协调对SML和深度学习模型的益处。从补充表10中,我们观察到数据残差化对深度学习模型没有带来改善,而对于Ntrain = 9253的年龄回归任务,SML的性能略有提升。这在外部测试中无法复现(与Fortin等人在原始ComBat研究中关于年龄预测的结果一致)。然而,在精神疾病数据集上,差异更为显著,在内部测试中SML在三个任务上的AUC总体提升了1-3%。在外部测试中,改善效果不一,特别是在BD vs. HC和ASD vs. HC任务上。对于深度学习模型,我们在内部和外部测试集上都观察到性能显著下降,表明当前的残差化方法无法保持深度学习模型提取的非线性生物变异性(这与最近关于阿尔茨海默病的研究结果一致)。我们对DenseNet和ResNet进行了额外实验,明确支持这些结论;见补充表10和11。解剖MRI的数据协调技术主要为SML模型设计,其对深度学习的适应仍处于初期阶段。

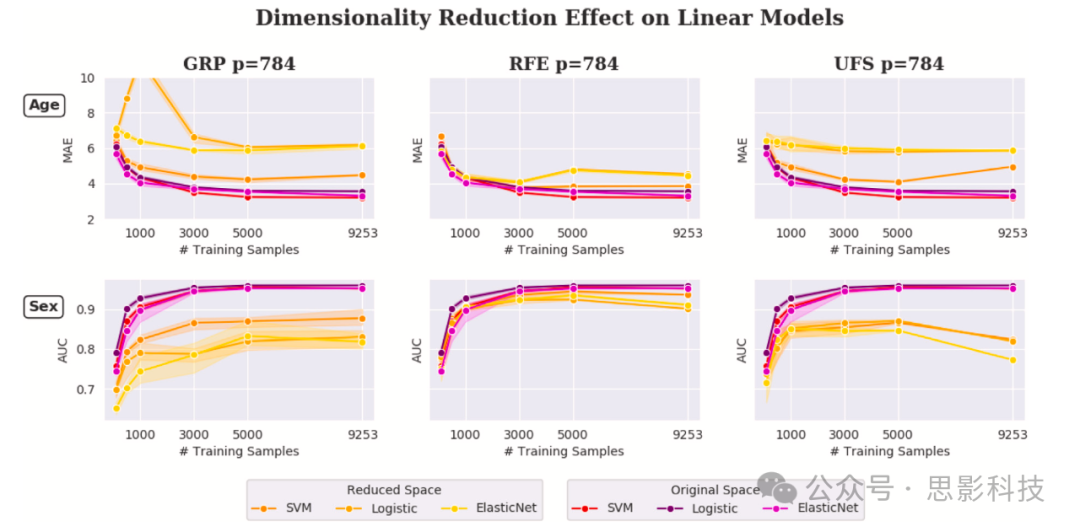

3.1.4. 降维损害SML模型性能

在图5中,我们绘制了SML模型在降维后的BHB-10K数据(p = 784个特征)上的性能,并与之前在原始数据上(约30万维)的基准结果进行比较。我们也在临床数据集上进行了相同的实验,结果报告在补充图11中。我们观察到所有模型的性能都出现明显下降,特别是使用GRP时(性别预测AUC下降12%,年龄回归MAE增加2.7,在临床数据集上使用最大训练样本量时,所有二分类任务的AUC下降>10%)。这在某种程度上是可以预期的,因为GRP完全是无监督的,即它不依赖目标变量来保留相关特征(因此可能关注一般的非生物变异性,如采集站点)。RFE似乎是表现最好的方法,但与直接应用于原始数据的正则化线性模型相比仍然表现不佳(在Ntrain = 9253时,性别分类AUC下降5%,年龄预测MAE增加0.97)。这表明在这些任务上违反了最终解决方案中的非冗余性和稀疏性假设。在外部测试集上获得了类似的结果(见补充图12)。最后,我们在UKBioBank上复制了这些发现,这是机器学习社区在先前研究中密集使用的基准资源。

图5. 在BHB-10K的3D解剖VBM图像上评估了三种降维方法,即高斯随机投影(GRP)、递归特征消除(RFE)和单变量特征选择(UFS)。

我们通过将降维后的维度设置为p = 784(从30万个灰质体素),重现了先前研究中的相同实验设置。报告了SML(包括rbf-SVM和惩罚线性模型)在降维数据上对年龄/性别预测任务(此处显示Ntrain ∈ {100, 500, 1000, 3000, 5000, 9253}的结果)和诊断分类任务(见补充图11)的性能。我们使用与之前相同的训练/验证/测试划分。为了比较,也报告了原始空间中的性能。所有模型都在内部测试(此处显示)和外部测试(见补充图12)上进行测试,得出类似结论。在所有情况下,降维都没有为SML带来改善,而且在使用UFS或GRP时显著降低了性能。

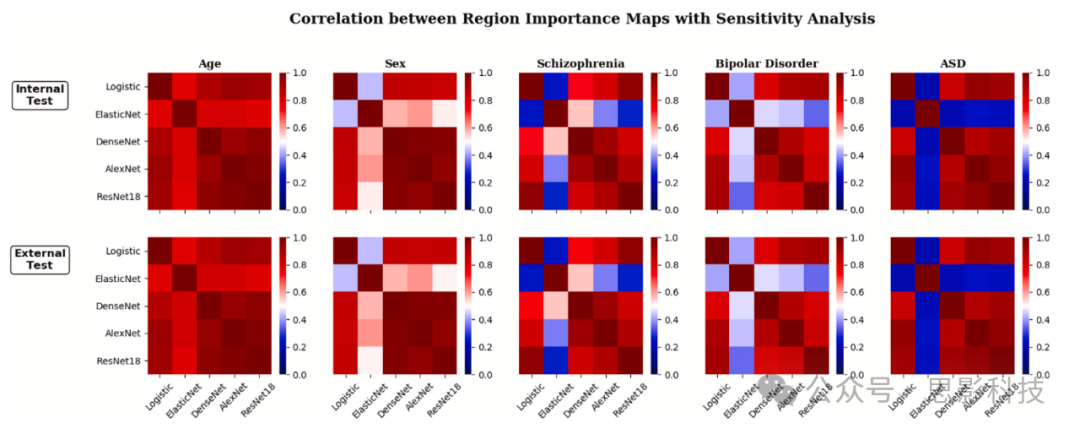

图6. 计算各任务和模型获得的脑区重要性图之间的相关矩阵

强相关性表示两个模型在给定任务上的良好一致性。对于深度学习和线性模型,每个脑区重要性图都是通过敏感性分析(即使用基于梯度的方法)获得。所有考虑的模型都使用最大数量的训练样本进行训练。脑区通过AAL图谱定义。

在这些实验中,选择的组件数量p是一个关键的超参数,在先前的研究中并未讨论。为了完整性,我们还进行了p = 10k的额外实验(见补充图13),表明通过RFE将输入大小减少30倍(灰质掩模包含约30万个体素),我们可以在年龄和性别预测上达到与原始空间相似的性能(SML模型在年龄和性别预测上分别为ΔMAE = 0.03和ΔAUC = 0.32%)。

总的来说,这些实验表明,对多站点神经影像数据的SML来说,降维并非必要,且如果没有仔细的模型选择,可能会显著降低性能。正则化SML模型也可以从超高维数据中学习。

3.2. 深度模型和线性模型在精神疾病、衰老和性别方面基于相同的脑区做出决策

图6显示了两个明显的模式,这两个模式在测试集上都可重现。首先,对于所有任务,所有深度学习模型生成的显著性图与使用ℓ2正则化的逻辑回归相似(所有任务中线性模型与所有深度学习模型之间的相关性r > 0.70)。这与最近关于应用于年龄预测、精神分裂症和双相障碍检测的SML模型的研究结果一致。线性和非线性模型都得到了类似的最终加权图,具有不同程度的噪声和稀疏性。其次,ElasticNet生成极其稀疏的图(这是预期的),但其区域与其他模型的总体相关性较差(在ASD检测任务中,ElasticNet与Logisticℓ2、DenseNet、ResNet和AlexNet之间的相关性分别为r = 0.21、r = 0.22、r = 0.25和r = 0.24)。随着任务难度的增加,这种现象更加明显(例如,AUC>95%的年龄或性别预测与AUC≈60%的ASD检测相比)。此外,为了完整性,我们还使用了基于遮挡的方法来比较敏感性分析和遮挡给出的显著性图。遮挡方法包括监测在独立遮挡每个脑区(由AAL图谱定义)时模型预测的变化。在补充材料(图9)中,我们报告了遮挡法与敏感性分析获得的显著性图之间的相关性。总的来说,我们发现这两种方法之间有很好的一致性(除了AlexNet的性别预测和DenseNet的双相障碍检测外,所有模型和任务的r > 0.70)。

3.3. 迁移学习和深度集成改善深度学习表征,在精神疾病诊断方面超越SML

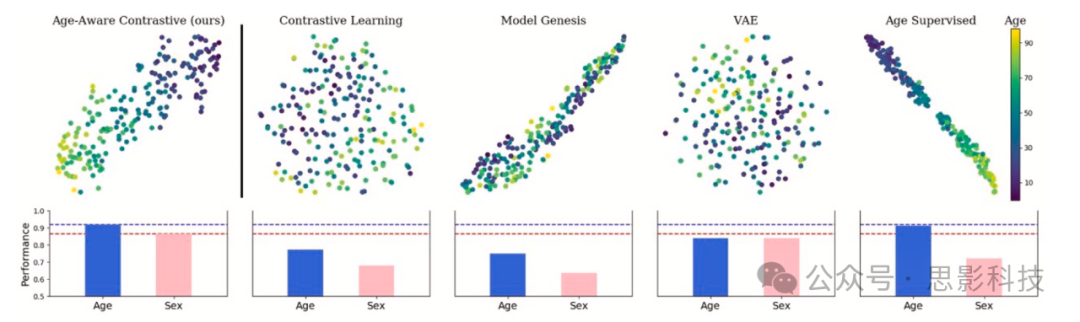

3.3.1. 探索预训练策略

在图7中,我们绘制了通过第2.12节描述的预训练模型编码的健康脑图像的潜在表征。这些脑图像来自训练期间未见过的外部数据集BSNIP。我们还报告了使用线性探测从潜在特征预测人口统计信息的解码性能。有趣的是,我们提出的Age-Aware对比模型是唯一一个很好地捕捉了年龄和性别表型的模型,即使它没有经过性别信息的训练。它在年龄方面的解码性能也更好,甚至比完全年龄监督模型更好。这可以通过之前的结果来解释,即该模型(DenseNet121)对新的外部图像的泛化性能较差(见图2)。这表明Age-Aware对比模型编码了独立于扫描仪的稳健特征。VAE虽然没有经过弱监督训练,也能很好地捕捉人口统计信息。尽管如此,它的表现仍不如我们提出的模型。

图7. 我们探索了几种基于表示学习应用于脑MRI的预训练策略,其中包括我们提出的Age-Aware对比模型。

我们绘制了来自外部BSNIP数据集(训练期间未见过)的新健康脑图像编码后的潜在特征的t-SNE表征(上图)。下方,我们报告了使用线性探测从潜在特征预测人口统计信息(年龄/性别)的解码性能(年龄使用皮尔逊相关系数,性别使用平衡准确率)。虽然Age-Aware对比模型和Age Supervised模型都在预训练期间使用年龄作为弱信号,但所有其他模型都是无监督的。除了VAE(使用较小的5层CNN架构以避免后验崩溃)和Model Genesis(按照原始方案使用UNet主干网络)外,所有模型都使用DenseNet121作为主干网络。

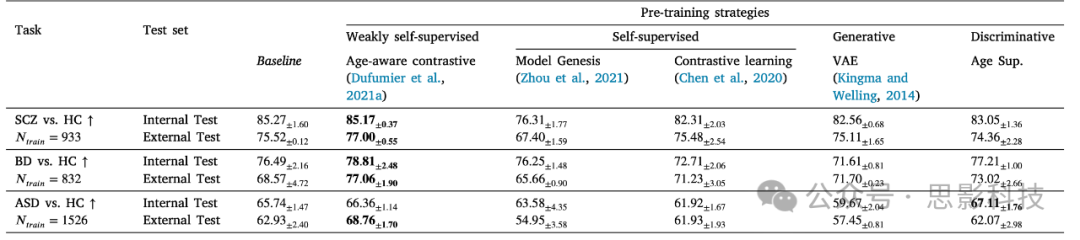

迁移到临床数据集

为了进一步比较这些策略,我们在三个分类任务上微调不同的模型,并在表3中报告性能。我们观察到,与所有其他预训练策略相比,Age-Aware对比模型在性能上有很大优势(在SCZ vs HC、BD vs HC和ASD vs HC上分别提高了+2%、+4%、+8%的AUC,按任务难度排序)。有趣的是,在预训练期间添加表型信息(特别是年龄)(无论是通过判别模型还是弱自监督模型)与完全无监督模型(自监督和生成式)相比,都能提升性能。这特别说明:(1)与年龄相关的解剖知识可以迁移用于区分广泛的精神疾病,(2)无解码器的自监督模型提供了跨站点更稳健、可重现的特征。有趣的是,以年龄预测为预训练的判别方法可以改善ASD性能。然而,这在外部测试中并未重现,表明可能过拟合于扫描仪。因此,在接下来的研究中,我们使用了Age-Aware对比模型作为预训练。

表3. 使用五种预训练策略的模型微调结果

所有模型仅使用健康大脑进行预训练。我们报告了所有模型的平均AUC(%)和通过重复每个实验三次得到的标准差。基线来自DenseNet121主干网络的结果,该网络在精神疾病分类中表现最佳,因此提供了强有力的结果。

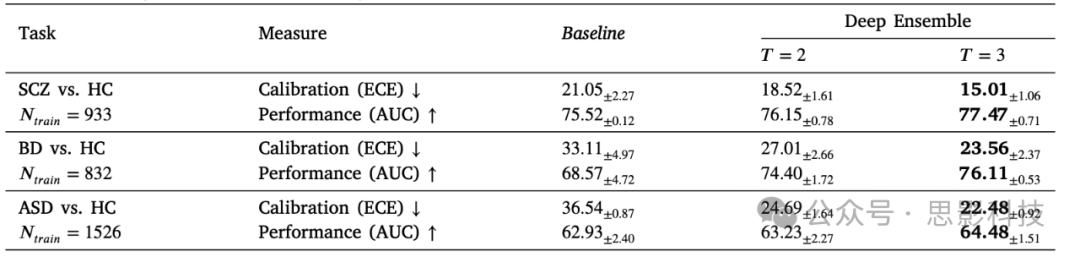

3.3.2. 知道你不知道什么是有帮助的:使用深度集成量化DNNs的不确定性

在表4中,我们展示了通过深度集成量化DNNs的不确定性可以(i)显著改善DNN的校准(量化对于给定预测的DNN置信度分数是否可信)和(ii)提高所有精神疾病预测任务的性能。我们报告了在外部测试集上使用DenseNet骨干网络和增加的集成模型数量T的结果。我们观察到,随着集成模型数量的增加,所有任务的校准都有显著改善,SCZ vs HC、BD vs HC和ASD vs HC的ECE分别降低了6%、10%和14%。有趣的是,对于较难的任务(如ASD),基线模型的校准效果更差,这表明DNNs在犯很多错误时仍然过度自信。此外,校准的改善系统性地伴随着性能的提升。

表4. 深度集成改善了所有临床任务的校准和性能

校准通过预期校准误差(ECE)衡量,性能通过ROC-AUC衡量。在这个实验中,深度集成模型取t个使用不同随机初始化进行监督训练的模型的平均表示(在softmax层之后给出)。

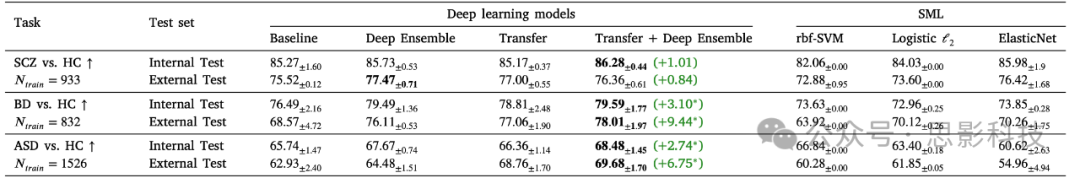

3.3.3. 结合深度集成和迁移学习超越SML并达到最先进的结果

我们展示了当我们结合图1中展示的新范式和前面描述的深度集成策略时,在精神疾病分类上的结果。我们将其与在VBM数据上训练的SML进行比较(残差数据的结果在补充材料3.1.3节中报告)。

表5. 结合深度集成学习和迁移学习改善了深度学习表征,相比SML模型表现更好,尤其是在ASD和BD检测等复杂任务上。

我们报告了所有模型的平均AUC和通过重复每个实验三次得到的标准差。所有深度学习模型都使用DenseNet121骨干网络。基线对应于从头开始在VBM图像上训练的单个网络。对于深度集成,我们聚合了t个使用不同随机初始化训练的网络。对于迁移学习,我们使用Age-Aware对比学习预训练单个网络,并在每个临床任务上微调所有权重。对于迁移+深度集成,我们聚合了三个网络,所有网络都使用Age-Aware对比学习进行预训练(仅一次),并在每个下游任务上进行微调。因此,随机性来自于每个下游任务的梯度下降优化。

绿色数字表示相对于深度学习基线的改进。

†表示与当前任务上表现最好的SML模型进行双样本t检验的显著性。

从表5中,我们观察到当结合深度集成学习和迁移学习时,相对于基线在外部测试中性能持续提升(在精神分裂症、双相障碍和自闭症谱系障碍检测上分别提升了+2.1、+4.2、+3.8% AUC)。在双相障碍和ASD检测上,DNNs与表现最好的SML模型之间的这种改进是显著的,但在精神分裂症上并不显著(在外部测试的双样本t检验中分别为p=0.31、p<0.01和p<0.01;在内部测试中分别为p=0.42、p<0.01和p<0.01)。

深度集成的结果支持这样一个假设:不同的随机初始化会导致训练后产生不同的表征。迁移学习的结果表明,在脑部成熟和衰老过程中从健康人群学习到的解剖特征可以被重新利用,从而大大改善深度学习在困难临床任务(如双相障碍和ASD检测)上的泛化能力。然而,在较容易的任务(如精神分裂症)上,深度学习的性能仍与SML模型相当,任务难度是通过线性性能来衡量的。

方差分析。

从表6中,我们观察到迁移+深度集成在所有情况下都提供了最低的方差(同时也是性能最好的模型,见表5)。有趣的是,迁移学习大大降低了SCZ vs HC的标准差,这支持了我们的假设,即解决方案被限制在相同的盆地景观中,从而证实了之前在自然和医学图像上的发现(Neyshabur等,2020)。对于BD vs HC的结果则不太一致,其中深度集成似乎是实现模型低方差的关键组成部分。

4.讨论

本研究调查了深度学习模型在大规模和中等规模多站点数据集上提取非线性特征的潜力,涉及神经影像学中的关键问题,包括个体精神疾病和年龄/性别预测,并与标准线性和核机器学习方法(SML)进行了比较。

首先,我们证实了最近的研究发现(Schulz等,2020),对在解剖神经影像学中普遍使用深度学习模型提出质疑。特别是,我们发现在从头训练的情况下,深度学习方法与SML在简单和更复杂的个体神经影像分类任务中表现无差异,这些任务包括:(1)性别预测,(2)精神分裂症检测,(3)双相障碍,以及(4)自闭症谱系障碍分类。我们在精神疾病方面的结果扩展了最近一项关于阿尔茨海默病检测基准研究(Wen等,2020)的发现,该研究表明深度学习与在ADNI(Jack等,2008)上训练的简单线性SVM表现相当——这是迄今为止最大的阿尔茨海默病神经影像研究项目(在他们的案例中,包含了每位参与者的多个时间点数据)。

尽管如此,我们确实发现深度学习在年龄回归任务上优于SML,这证实了最近关于这个主题的研究(Peng等,2021,Abrol等,2021)。不过,当图像来自训练期间从未见过的站点时,它需要大量样本才能提取出比简单正则化线性模型更好的表示。

由此产生一个问题:为什么深度学习在计算机视觉的具有挑战性的图像分类任务上优于SML,而在个体神经影像任务上却不然?

表6. 模型优化期间报告的AUC性能标准差(SD),取决于其初始化

迁移学习(TL)和迁移学习+深度集成极大地降低了SD,这表明它们并未从损失函数的初始盆地景观中大幅偏离。所有(任务,模型)对的SD都是用30次测量估计的,除了迁移+深度集成是用10次测量估计的(深度集成使用3个模型)。

这种现象的第一个原因是神经影像学中多年来精心设计的高度复杂的预处理流程,它实现了噪声降低、空间对齐和数据协调。特别是,微分同胚空间配准以及脑组织分割和其他非线性图像校正(如偏场校正、强度重标定等)在过去二十年中得到发展(Ashburner, 2007, Gaser and Dahnke, 2016),用于统计分析并允许使用简单的线性模型进行强大的统计学习。整个流程可以看作是一个复杂的非线性函数,将大脑原始图像映射到对齐良好且去噪的解剖图像,这解释了SML(包括线性和核方法)在神经影像领域的成功。第二个显而易见的原因是临床数据稀缺。脑成像产生大量但有限的输入体积,跨维度k最多只有几千个受试者。这比ImageNet少n倍,且可能多样性更低。第三个原因可能与被标记为同一诊断(如双相障碍或自闭症)的不同患者在解剖结构上的极高个体间异质性有关(Wolfers等,2018, Zabihi等,2020, Nunes等,2020)。最后这个假设得到了当前精神病学主要疾病重新概念化的进一步支持(例如通过RDoC计划)。

脑图像是否过于嘈杂?

Schulz等(2020)关于深度学习和线性模型之间相似扩展趋势的主要假设是,当输入图像被与病理相关的神经生物学改变无关的噪声(如MRI伪影)所淹没时,决策边界会线性化。这在MNIST数据集(LeCun等,1998)(包含0到9手写数字的灰度图像数据集)上通过一个简单实验得到了很好的说明:作者在图像中添加高斯噪声,噪声越强,深度神经网络和线性模型之间的学习曲线就越接近。我们认为我们在VBM vs原始图像上的实验支持了这一假设。我们展示了站点相关噪声如何在训练用于预测年龄/性别或精神状况的深度神经网络的表征空间中得到很好的保留,特别是在原始测量中,即使我们知道存在更具辨别性的信号。这一假设也在3.1节关于年龄预测的实验中得到支持:虽然SML的学习曲线在内部测试中明显比深度学习差(在𝑁𝑡𝑟𝑎𝑖𝑛 = 3𝑘时就早早达到平台期),但在外部测试中情况并非如此。这些发现表明,目前MRI中的站点相关噪声阻碍了深度神经网络利用非线性信号,从而某种程度上使其在精神疾病分类的决策边界线性化。

数据增强通常被建议作为在小型临床数据集中人为增加样本量的最简单方法。我们展示了标准几何变换在所有任务中都降低了深度神经网络在VBM和准原始数据上的性能。我们假设标准几何变换(如旋转、平移、翻转)不适用于我们的数据,因为所有图像都非线性配准到同一模板。至于高斯噪声,由于我们已经应用了平滑核来规范化数据,它似乎也是不必要的。综合这些结果突出表明,有必要专门为神经影像数据设计新的增强方案。特别是,我们认识到通过非线性深度生成模型生成有意义的合成图像的新方法正在出现(Chadebec等,2022),我们将这个研究方向留作未来工作。

从大规模健康数据集到中等规模临床研究的迁移学习:

关键的是,我们提出了一个新的迁移学习范式,用于区分精神疾病患者和对照组,在ASD分类和双相障碍检测方面达到了新的最高水平。这个范式具有通用性,不指定特定的预训练策略。它主要基于这样一个假设:使用大规模数据集捕获健康人群中与非特异性变量(如年龄、性别等)相关的生物变异性,可以在小规模队列微调期间更容易发现特定的病理变异性(如ASD检测中前额叶和颞叶的细微皮质萎缩)。我们使用年龄感知对比策略的发现表明,年龄相关特征也与BD和ASD诊断有关,支持了该领域之前的发现(如与儿童期大脑过度生长相关)。在这方面,在预训练过程中通过y-Aware对比学习整合其他表型(如认知),为迁移学习和表征学习开辟了新途径。这使我们能够根据非影像变量构建表征空间,并可能从大规模健康数据集中学习更丰富的流形。

此外,我们还展示了不确定性量化("知道你不知道什么")对深度学习模型的重要性,这可以通过深度集成来解决。考虑到它们在解决复杂任务时即使面对嘈杂数据也过于自信,对预测不确定性进行建模和量化对于计算机辅助诊断和临床试验设计至关重要。

从定量角度来看,我们发现深度学习结合迁移学习在从脑解剖成像中检测双相障碍方面建立了新的最高性能水平(在内部和外部测试中均达到>78% AUC,样本包括1173名受试者和471名BD患者),这与ENIGMA联盟最近的研究结果相比(迄今最大规模,包括3020名受试者和853名BD患者)。在他们的实验中,在对年龄、性别和站点进行线性残差调整后,在外部(和内部)测试中分别达到了≈70% AUC(≈75%)。

这些发现表明:

(i) 可以通过对健康人群的脑成像进行预训练,用深度学习学习具有判别性的可迁移解剖非线性模式;

(ii) 不同的深度学习初始化在训练后会收敛到不同的解决方案,如果将它们聚合在一起,可以超越SML;

(iii) 深度学习模型倾向于在简单任务(如精神分裂症检测)上学习简单特征,陷入简单性偏差,这促使DNN寻找最简单的特征来执行任务(从而损害在外部测试集上的泛化能力)。

有趣的是,对于本文涉及的三个临床任务中最简单的精神分裂症(相对于ML诊断准确性而言),即使在执行迁移学习或深度集成学习时,深度学习也难以找到比简单正则化线性模型更好的表征。我们假设这可能是由于简单性偏差,即使用标准训练程序(如随机梯度下降)训练的深度学习倾向于依赖最简单的特征,即使更复杂的特征可能带来更具判别性的信息。我们看到,聚合不同的从头训练的深度学习表示在SCZ检测上只带来了微小的改进(内部测试AUC +0.46%),而在BD和ASD分类上则不同(分别为+3%和+2.92% AUC),这表明不同的深度学习模型只在复杂任务上提取不同的(潜在非线性)特征。这也可以解释SCZ vs. HC在外部测试上的性能下降(与内部测试相比AUC下降9.92%),将其视为域外数据集,因为简单性偏差导致了较差的域外泛化能力。这种性能下降仅在执行迁移学习和深度集成后的SCZ vs. HC中观察到。简单性偏差是一个相对较新的概念,消除当前深度学习模型中的这种偏差仍然是一个开放性挑战。我们假设,通过避免深度学习中的简单性,我们可能也能在较简单的临床任务(如精神分裂症检测)中受益于深度学习强大的表征能力。

我们认识到当前的深度学习架构可能并不适合脑解剖数据。在自然图像上,深度学习架构(特别是CNN)带来了强大的归纳偏差(如平移不变性、层次表示),这似乎对具有挑战性的计算机视觉任务非常有益,这可能部分解释了它们的成功。特别是在MNIST上(一个广受欢迎的基准图像数据集,包含手写数字),CNN即使在训练样本仅为Ntrain=100时也能超越SML(准确率提高>15%)。另一项研究也表明,随机初始化的CNN的表征空间可以直接用于在MNIST上获得准确的结果(>90%准确率)。更值得注意的是,随机初始化(即未经训练)的CNN可以作为图像去噪、修复、图像重建和ImageNet上的物体定位的"手工制作先验",以达到最先进的结果。

另一方面,我们假设CNN当前的归纳偏差可能不足以处理所有图像已对齐且共享相同颜色和纹理的脑解剖数据(这与最近的一篇综述一致)。其他最新的深度学习架构,如Transformer,在其核心集成了注意力模块并放宽了CNN中存在的归纳偏差约束,可能是神经影像学的另一个令人兴奋的研究方向。虽然Transformer在自然图像上仍然需要海量数据(由于其灵活性),但神经影像学领域的首批相关工作已经开始出现,应该受到特别关注。

我们的发现表明,即使在大规模数据条件下,深度学习和SML也倾向于快速过拟合采集站点。在年龄回归任务中,我们观察到所有深度学习和SML模型在内部和外部测试之间都出现显著的性能下降(平均MAE下降:ΔMAE(DL) = 1.00,ΔMAE(SML) = 0.88,N = 10k张来自17个站点的图像)。在精神分裂症检测中也发现了类似的分类性能下降(1300个样本):ΔAUC(DL) = 7.81%,ΔAUC(SML) = 9.72%。这种性能下降主要可能归因于站点采集设置。此外,这表明对于来自训练阶段已见过的站点的测试图像存在系统性偏差。深度学习模型在使用原始数据时似乎比VBM在年龄回归上过拟合更严重,这解释了它们在内部和外部测试之间更大的性能下降。这与Cole等人对深度学习模型进行的扫描仪间可靠性测试结果一致。我们的结果再次支持使用手工制作的VBM预处理进行深度学习,因为它似乎能限制站点偏差(至少在年龄回归方面)。有趣的是,在阿尔茨海默病检测中也获得了类似的结果,使用来自未见过站点的原始图像时,深度学习的泛化能力较差。

总的来说,这凸显了神经影像学多站点研究中的一个反复出现的问题,即与深度学习中的数据协调和消偏相关的问题。虽然最先进的数据协调技术(Combat和线性调整回归)对临床应用中的SML部分有益,但对深度学习却不是这样(见补充材料表10)。这表明当前的协调技术仍然无法保留深度学习用于执行下游任务的非线性输入关系。在保护感兴趣变量(如生物学变量:诊断、年龄、性别,或在可信AI背景下的敏感属性)的同时从深度学习表征中移除站点信息,在计算机视觉和神经影像学领域都是一个开放性挑战。这仍然是一个相对较新的研究领域,在神经影像学中尚无基准数据集或度量标准。

通常被认为是"黑盒"的深度学习模型,我们提供了经验证据表明,随机初始化的深度学习模型基于与线性模型非常相似的脑区域做出决策。我们在内部和外部测试集上都观察到了深度学习和线性模型之间的这种一致性。这种跨深度学习和线性模型的一致性令人安心,表明深度学习模型提取的特征是可靠的。还应该注意到,不同的CNN在所有评估任务中都基于高度相似的重要性图做出决策。深度学习的可靠性对于精神病学精准医疗至关重要,这是朝着建立被临床医生接受和信任的模型迈出的第一步。

总的来说,我们的研究证实,深度学习在精神病学具有挑战性的临床应用中相对于SML的效用来自于迁移学习和深度集成学习。将这两种策略结合起来在BD和ASD上都超越了SML,并在BD方面达到了新的最高水平。虽然从头训练的深度学习在精神疾病方面并未胜过简单的线性模型,但我们展示了最近在对比学习方面的进展应用于大规模健康人群(N≈10k)使深度学习模型能够学习可重用的特征。聚合其他模态(如功能性或扩散MRI、基因组学)以进行表征学习仍然是一个令人兴奋的挑战,这可能通过对比学习来解决。这将提高我们对脑部疾病的理解,并可能通过临床结果的预测模型为精神病学中的个性化医疗铺平道路,而在不久的将来,只有小规模纵向队列的数据也将是可用的。

912

912

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?