本文介绍量化过程中的BN折叠;

以下图片引用自 Quantization and Training of Neural Networks for Efficient Integer-Arithmetic-Only Inference

BN折叠

首先介绍BN折叠;BN折叠源自 BN模块在训练阶段和推断阶段的实现差异;

如下图所示:以conv+BN为例,图1为训练阶段的BN,图2为推断阶段的BN

可以证明这样的折叠是合理的,注意图2中的w指的是卷积核;

量化中的BN折叠

对量化来说,尤其是量化感知(伪量化),我们需要保持训练阶段的伪量化和上述图2的推断阶段的量化实现是一致的,因此对训练阶段的CONV+BN二阶段步骤进行折叠,如下图3:

图3的设计思想源自图2,基本思想是训练阶段求的EMA(即图中moment及其前后步骤)拿掉后要和图2一致;

根据图3所示BN折叠,就可以对训练阶段该折叠做后训练量化或者伪量化,如下图4

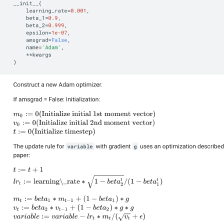

代码实现

以下代码块来自github distiller,没有完整的上下文实现,感兴趣的读者可以移步阅读

总结

- 以上简要介绍了BN折叠及其量化,思想比较巧妙,感兴趣的读者可以根据文中提到的文献进一步深入阅读,谢谢

- 理解有误的地方欢迎指正

本文详细介绍了BN(Batch Normalization)折叠的概念,这一过程源于BN在训练和推断阶段的实现差异。在量化过程中,特别是量化感知训练时,保持训练和推断的一致性至关重要。通过BN折叠,可以实现训练阶段的CONV+BN操作的整合,以适应量化需求。文章提供了训练阶段的BN折叠改造方法,并展示了量化后的流程。最后,给出了BN折叠在量化实现的代码示例,鼓励读者深入研究相关文献。

本文详细介绍了BN(Batch Normalization)折叠的概念,这一过程源于BN在训练和推断阶段的实现差异。在量化过程中,特别是量化感知训练时,保持训练和推断的一致性至关重要。通过BN折叠,可以实现训练阶段的CONV+BN操作的整合,以适应量化需求。文章提供了训练阶段的BN折叠改造方法,并展示了量化后的流程。最后,给出了BN折叠在量化实现的代码示例,鼓励读者深入研究相关文献。

316

316

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?