本文给出一个 GPT4 模型可视化token的工具网站,大家可以去上面测试一下效果。

网址:

https://platform.openai.com/tokenizer

使用说明

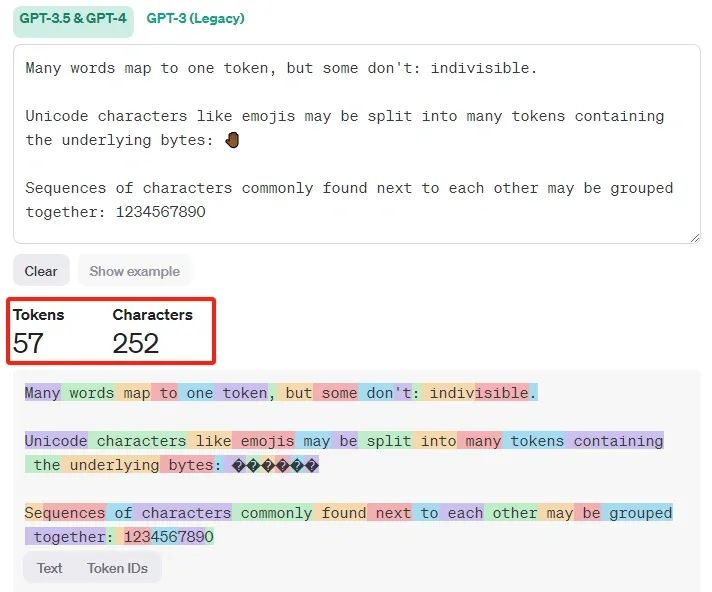

通过该网站工具,你可以了解一段文本如何被GPT-4模型token化的,以及文本的被token化之后的token总数是多少。

比如像下面这样:

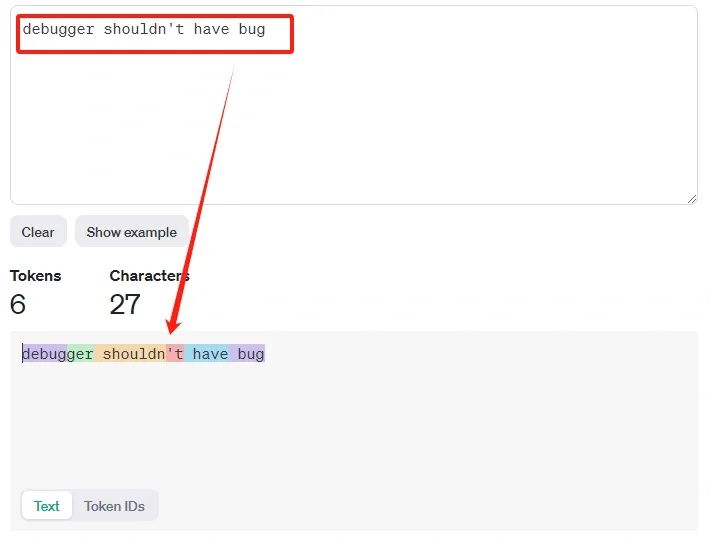

当输入文本中含有debugger时,同样被拆分为了debug和##ger,这和之前介绍token的文章时提到的是一致的,比如这篇文章:利用bert对文本token化。

这说明debug确实是一个非常常见的基础子词。

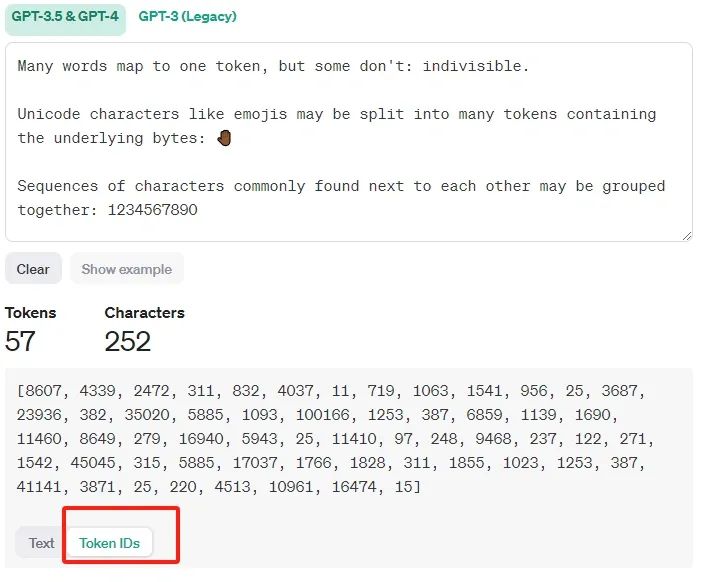

当然你也可以将token转换为tokenID来查看。关于tokenID,后面会详细介绍其作用。

需要注意的是,具体的文本token化结果与模型有关。

像GPT-3.5和GPT-4这样的模型使用的方法与旧模型(比如GPT-2)会有不同,不同的token算法对于相同的输入文本会产生不同的token序列。

按照GPT-4官方给出的经验数据:对于常见的英文文本,一个tokne大概对应4个英文字符,大约相当于 3/4 个单词。

所以100个token大约等于75个单词。

本节为一个工具介绍,仅做了解即可。

最近开始撰写《Transformer专栏》了,会以最通俗的讲解方式来讲透其中的所有算法原理和使用动机。欢迎关注。移步:我的 Transformer 专栏来了

https://blog.csdn.net/dongtuoc/article/details/138633936?spm=1001.2014.3001.5501

https://blog.csdn.net/dongtuoc/article/details/138633936?spm=1001.2014.3001.5501

2713

2713

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?