继之前基于Transformer荣登Nature子刊的Life2vec,谷歌最近又爆改Transformer提出的Infini-attention机制,实现了接近无限长度的上下文。但横空出世的Mamba,克服了Transformer核心注意力层无法扩展的问题,一度被认为颠覆了Transformer。不可否认,Transformer对llm、及与各研究领域结合的突出贡献,想要深入mamba绕不开Transformer、RNN!

研梦非凡特邀请了世界Top10高校博士,发表过10+篇顶会的杨老师,5月22日(周三)独家开讲《Transformer系列论文科研能力提升课》,带你全面掌握Attention机制,系统深入9篇优秀论文(BERT、ViT、GPT-4、扩散模型、Mamba彩蛋等),9节课掌握Transformer在NLP和CV等领域具体应用,找科研idea,算法岗面试再也不怵!(下滑查看课程大纲)

▼ 扫描二维码找助教开课

可再领取5本Transformer必读书籍pdf+116篇必读论文+文末超多科研福利

一、课程收获

✨ 9篇Transformer必读论文get!

全面掌握Attention机制在NLP、CV等研究领域的发展历程

深入理解Transformer于不同模态中的具体应用,盘点9个优秀模型的技术贡献

掌握多个研究领域的最新技术,对比分析各模态中的优劣及前景

✨ 论文读写研究能力up!

梳理9篇论文的问题提出及方法优化,拓宽研究视野

参与讲师课堂疑难讨论,快速消化知识点,提升研究能力

系统学习论文相关工作后,可在讲师指点下,围绕关心课题开展实验或理论研究

二、课程亮点

介绍Transformer模型的基础结构,及其在纯语言模型、多模态大模型中的应用

解析Transformer模型的训练及推理细节、硬件上高效运行的方法

探究Transformer模型与轻量化技术结合的潜力,比如模型的量化、剪枝、高效采样方法、内存高效读取等

展示Transformer模型在各领域中的灵活运用,包括但不限于知识图谱、问答、对话、推荐等

▼扫描二维码找助教开课

三、课程大纲

🔸第1课 Attention Is All You Need(5月22日)

论文创新点:【原始的Transformer模型】它以自注意力机制,取代了传统流程模型中的递归结构,具备比RNN等神经网络,同等或更好的语言理解能力。同时,自注意力机制加强了Transformer的并行计算能力,无需像RNN依赖于序列顺序信息,极大提升了运算效率。

直播课内容:

Transformer模型的基本结构、组成及关键组件

对比RNN和Transformer在处理序列数据时的不同策略

自注意力机制如何捕捉序列内部的长距离依赖关系、如何实现并行计算

Transformer在机器翻译、文本摘要等任务中的应用案例

🔸第2课 BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding(敬请期待)

论文创新点:【Transformer架构在NLP方向研究应用】这篇论文提出了BERT预训练模型,它采用深层双向Transformer架构,可以学习词含义的上下文信息。

直播课内容:

BERT模型在NLP任务中的革命性影响、创新点讲解、预训练目标和训练策略

MLM任务、NSP任务如何帮助模型捕捉语言的复杂性

解释Transformer的编码器结构,讨论多头注意力机制在BERT中的应用

讨论RoBERTa、ALBERT等变体对BERT模型的改进和优化

🔸第3课 (ViT) An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale(敬请期待)

论文创新点:【Transformer架构在CV方向研究应用】这篇论文提出ViT模型,实现了Transformer在计算机视觉中的首次应用。ViT demostrated 了Transformer能力在视觉任务上的潜力,突破了CNN在这方面的主导地位。

直播课内容:

学习ViT模型在图像识别任务中的创新点、影响及基本结构

ViT模型的动机和目标,对比ViT与CNN在图像处理上的差异

patches如何被编码成序列以适应Transformer模型

讨论多头自注意力机制在ViT中的应用

ViT模型的预训练策略,以及在不同规模数据集上的性能表现

🔸第4课 Swin Transformer:Hierarchical Vision Transformer using Shifted Windows(敬请期待)

论文创新点:【Transformer在高分辨率影像研究领域的应用】这篇论文提出的Swin Transformer采用了移动窗机制,将图像切分为不同視窗进行处理,实现了Transformer在高分辨率影像领域的应用。

直播课内容:

Swin Transformer如何通过移动窗机制处理高分辨率图像,及移动窗机制的工作原理

Swin Transformer的关键技术:分块标准化(Shifted Window)技术及其作用

Swin Transformer在图像识别任务中的表现:模型如何优化特征提取能力

与其他Vision Transformer的比较,Swin Transformer在高分辨率影像处理上的优势,及模型在多模态任务中的应用前景

🔸第5课 SegFormer: Simple and Efficient Design for Semantic Segmentation with Transformers(敬请期待)

论文创新点:【Transformer在语义分割方向的应用】SegFormer利用先进的TransformerEncoder-Decoder结构,在没有使用任何额外如位置编码或非局部信息的情况下,进行语义分割,并取得突出的效果。

直播课内容:

Transformer在图像分类任务中的应用,并引入其在语义分割中的潜力

Transformer结构对细粒度视觉任务的适应性,SegFormer模型的动机、目标及Encoder-Decoder结构

SegFormer如何在不同尺度上捕捉特征,其简洁性和效率,以及其对性能的影响

SegFormer的语义分割流程:将Transformer应用于语义分割任务,模型如何处理输入图像并生成分割图

🔸第6课 ViLT: Vision and Language Transformer Without Convolution or Region Supervision(敬请期待)

论文创新点:【Transformer在多模态领域的应用】这篇论文提出的ViLT是第一个不需要卷积操作和区域级监督,就可以良好实现视觉语言交互任务的Transformer模型。ViLT直接使用序列输入进行多模态融合和理解,省去了特征提取阶段,取得了和CNN相当或更好的效果。

直播课内容:

ViLT模型的核心创新、模型结构和关键组件

ViLT在处理多模态数据时,如何实现视觉和语言信息的有效融合

ViLT的效率和效果,性能评估——对比ViLT和基于CNN的模型在各项任务中的表现

ViLT如何拓展Transformers在不同模态之间的应用场景,及其在多模态任务中的潜在改进空间

🔸第7课 (GPT-4)Toolformer: Language Models Can Teach Themselves to Use Tools(敬请期待)

论文创新点:【Transformer在GPT-4的应用】这篇论文提出了Toolformer模型,它能够通过逻辑推理和自我训练学习如何使用具体工具来完成任务,而无需事先提供使用例子。Toolformer是第一个能自行学习使用工具的语言模型。

直播课内容:

语言模型在智能助手和自动化任务中的应用,创新之处和研究动机

Toolformer模型的基本结构、工作原理、关键技术,如强化学习、模仿学习等

Toolformer在各类任务上的表现,讨论模型如何推动语言模型参与更复杂的实际任务

Toolformer如何展示Transformer在语言理解方面的高级能力

🔸第8课 Scalable Diffusion Models with Transformers(敬请期待)

论文创新点:【Transformer与扩散模型结合】采用Transformer可以突破传统扩散模型在规模和效率上的限制。它利用Transformer处理高维度数据,实现了先进的可生成视觉效果。

直播课内容:

Transformer在生成扩散模型中的应用及其潜力

Transformer如何适应高维度数据处理

基于Transformer的扩散模型架构,利用Transformer生成高维度的视觉数据

对比传统扩散模型和基于Transformer的模型性能

🔸第9课 Mamba VS Transformer(惊喜彩蛋!!!)

▼ 扫描二维码找助教开课+领文末超多科研福利

四、讲师介绍

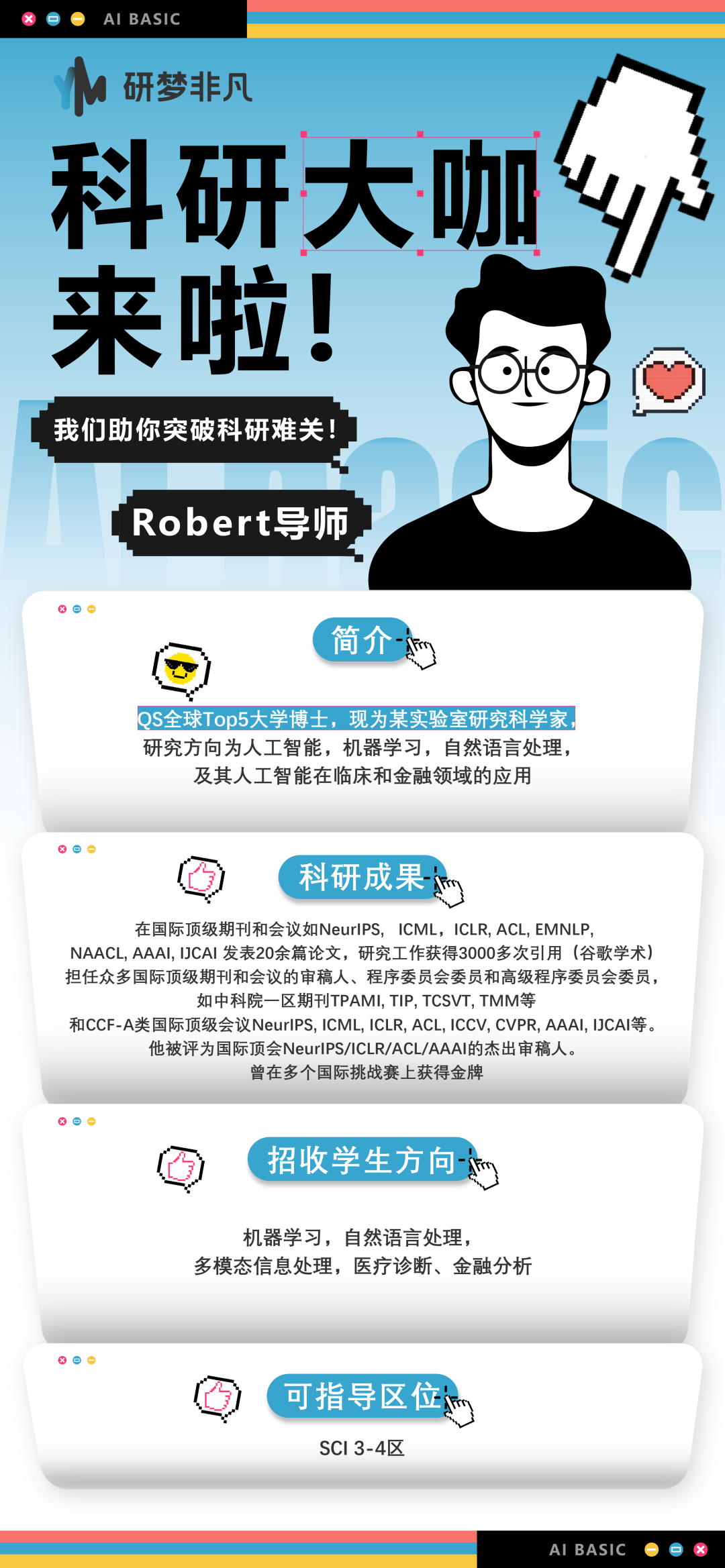

杨老师

学术背景 世界Top10大学计算机科学毕业博士。主要研究方向为计算机视觉、自然语言处理、高效的深度学习训练和推理方法、大语言模型轻量化与高效微调技术。曾在多家公司担任算法研究员,涉及计算机视觉、高效模型压缩算法、多模态大语言模型的相关研究,包括模型量化、剪枝、蒸馏、编译、高效稀疏化训练与推理

科研成果 在国际顶级会议CVPR、ICCV、EMNLP等发表10+篇论文,并担任CVPR、ICCV、ECCV、ICML、ICLR、NeurIPS等重要会议和期刊审稿人;拥有多项发明专利,指导学生有耐心,教学严谨,思维逻辑缜密,论文指导经验丰富

招收学生方向 计算机视觉、自然语言处理、高效模型压缩算法、多模态大语言模型,包括模型量化、剪枝、蒸馏、编译、高效稀疏化训练与推理、深度学习全栈研究

五、适合人群

热爱计算机科学研究,对自然语言处理、计算机视觉、大语言模型、多模态算法,尤其以Attention为主的模型核心发展脉络,拥有浓厚兴趣的同学

意向深造、跳槽、转行的在职同学

计算机科学或交叉领域的本硕博在读同学

六、课程形式及时长

上课方式 线上直播课,每节1小时左右,具体以实际时长为准

上课时间 共9节,5月22日开课,后续暂定每周1节

▼ 扫描二维码找助教开课

七、课程服务

配套课程资料:课程PPT、Transformer论文及相关开源代码

Transformer交流群(助教答疑,资料更新)

八、Q&A

Q1:学习过程中若有问题,如何咨询老师?

A:本系列课程为直播课,大家有任何疑问,可在直播间发送提问,老师会实时一一解答

Q2:课程及相关服务有效期多久?

A:课程有效期为1年

Q3:本系列课程的学习价值?

A:Transformer论文系列课价值如下:

全面掌握Attention机制在NLP、CV等研究领域的发展历程

深入理解Transformer于不同模态中的具体应用,盘点9个优秀模型的技术贡献

掌握多个研究领域的最新技术,对比分析各模态中的优劣及前景

系统学习论文相关工作后,可在讲师指点下,围绕关心课题开展实验或理论研究

▼ 扫描二维码找助教开课+领文末超多科研福利

研梦非凡两类科研论文指导方案

科研论文idea,并非拍脑门就能产生,需要经过一遍遍做实验、跑代码、改模型、思路修正。研梦非凡专业论文指导,和研梦导师一起找idea,共同解决科研问题。授之以渔——搭建论文写作框架,增删改查,针对性实验指导!哪里薄弱补哪里!

<<< 左右滑动见更多 >>>

▼ 扫描二维码咨询助教两种指导方案

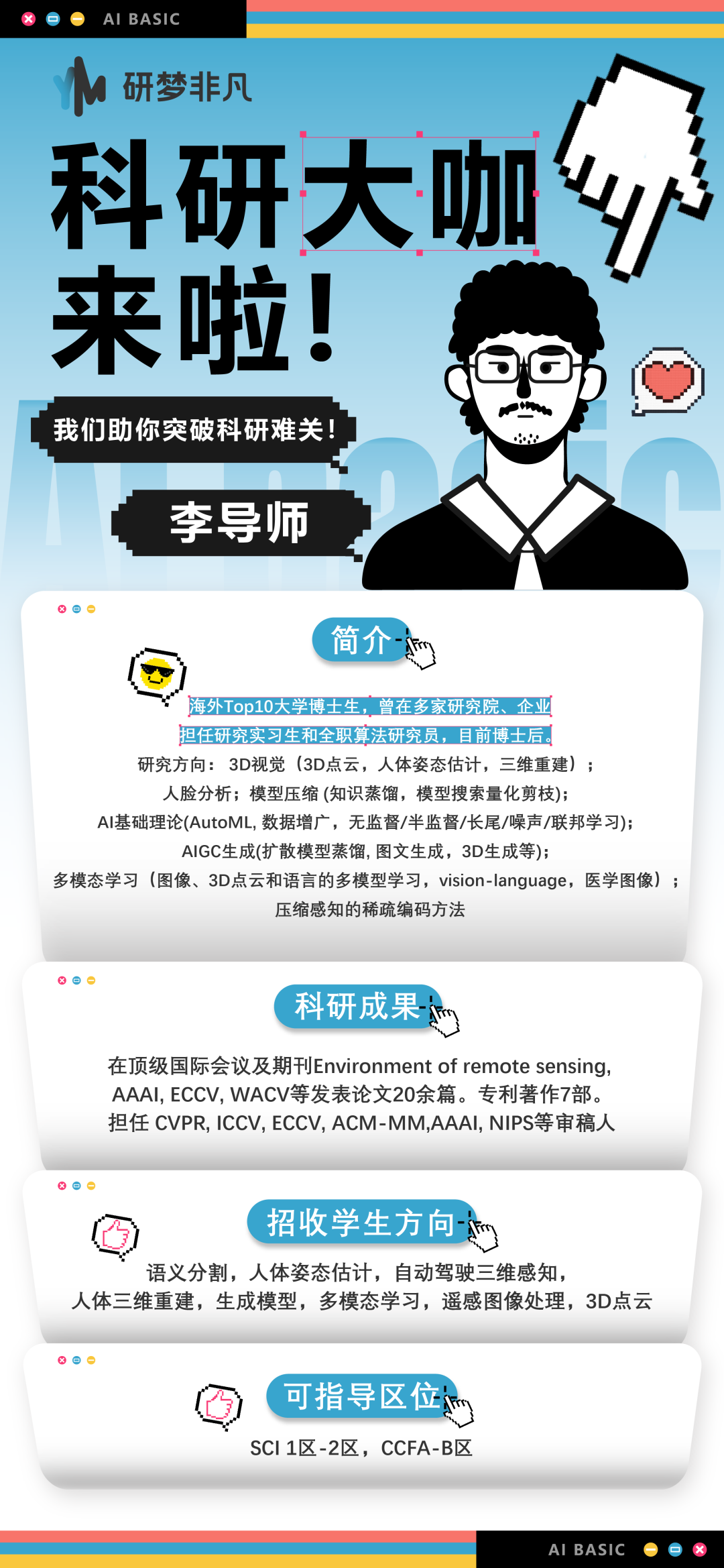

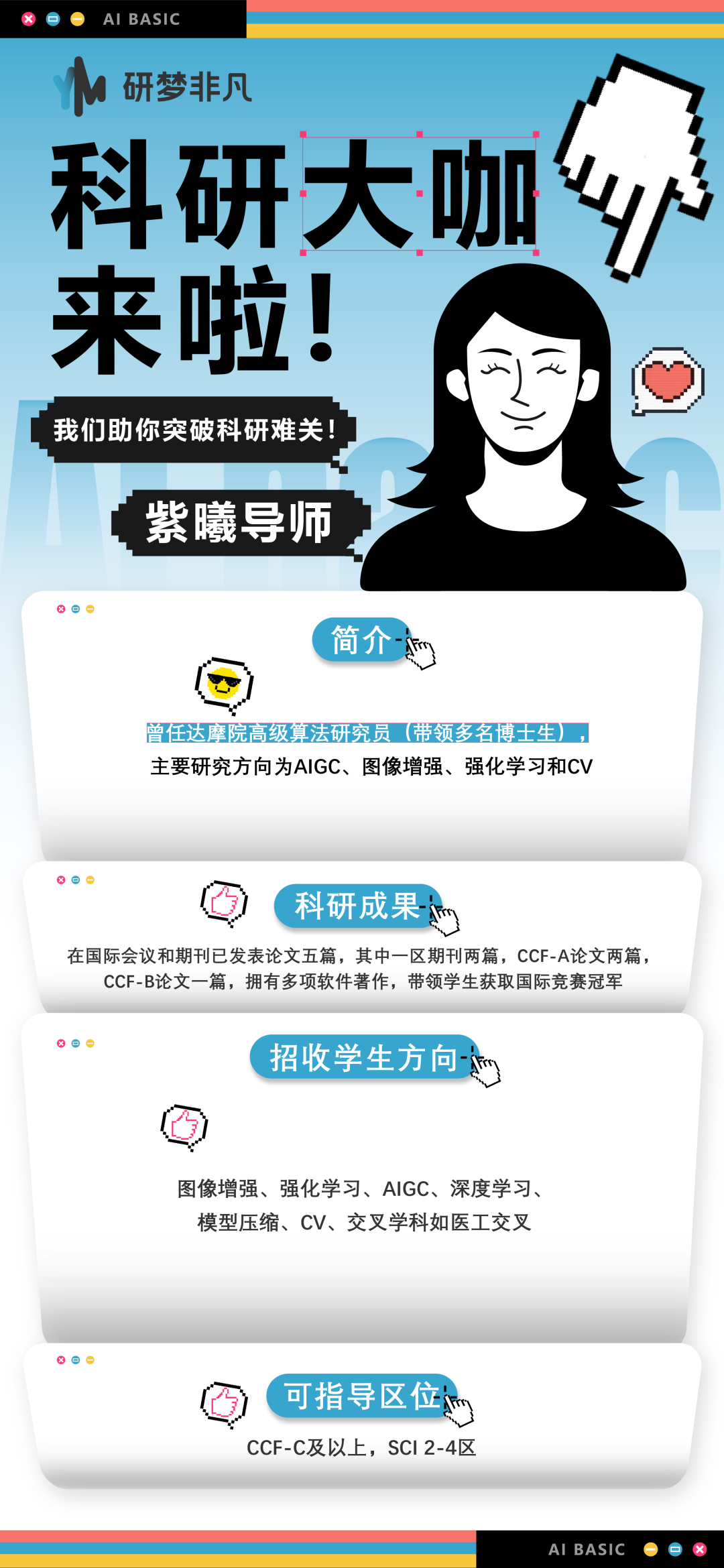

研梦非凡部分导师介绍

研梦非凡的导师,来自海外QStop200、国内华五、C9、985高校的教授/博士导师/博士后,世界500强公司算法工程师,以及国内外知名人工智能实验室研究员。

这是一支实力强大的高学历导师团队,在计算机科学、机器学习、深度学习等领域,积累了丰富的科研经历,研究成果也发表在国际各大顶级会议和期刊上,在指导学员的过程中,全程秉持初心,坚持手把手个性化带教。包括但不限于以下导师~

<<< 左右滑动见更多 >>>

▼ 扫码加助教为你匹配合适课题的大牛导师

研梦非凡科研福利

🌟90分钟人工智能零基础入门课免费领

🌟7小时科研论文写作系列课免费领

🌟14节前沿论文直播课程免费领

🌟50小时3080GPU算力免费领

🌟数百篇5月论文资料大合集免费领

🌟报名本课,赠送原价2999元的1小时导师meeting(助教+导师)

▼ 扫码领取以上6重粉丝专属科研福利!

1404

1404

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?