MCP server在很多的app上开始支持了,从以前的claude desktop,到cursor,vscode等等,甚至现在开源的软件也都开始支持mcp协议的配置了.这里主要来说一下如何在cherry studio中配置好mcp的服务.

cheery studio 中配置MCP并使用

基础配置过程

首先需要去官网下载最新版本的cherry studio:https://cherry-ai.com/download.以前的版本是不支持的.

安装完成之后,在设置中就可以看到有一个MCP服务器的选项了.接下来我们来配置一下mcp的服务,官方说明文档:https://docs.cherry-ai.com/advanced-basic/mcp

首先你需要有tools级的大语言模型的api,比如常见的claude系列等等,我这里使用的是deepseek官方的api的模型:https://api-docs.deepseek.com/zh-cn/api/deepseek-api/

可以看到这里的模型是有一个扳手的标识的,说明这个模型是可以使用工具的,只有这样才是支持使用mcp server的服务的.阿里云百炼的貌似也是支持的,我没有试过

然后我们来到mcp服务器,可以使用搜索MCP,编辑MCP配置,更多MCP.或者直接自己添加服务器(目前还不推荐)

目前添加mcp服务的方式就是去编辑MCP的json格式文件,然后去MCP的库中自己去进行匹配的,所以我们只需要编辑MCP配置就好了:

{

"mcpServers": {

"fetch": {

"isActive": true,

"command": "uvx",

"args": [

"mcp-server-fetch"

],

"name": "fetch"

}

}

}

这是一个fetch的mcp server,如果还想要其他的mcp server,可以前往更多MCP中进行查找,找到自己想要的即可.(https://mcp.so/)

json修改之后就自动会添加上服务的各种参数,我们不需要再修改.另外,如果是第一次使用mcp,一般需要先配置一下环境:

点这个地方之后,会提示你去安装两个工具,一个uv,一个bun工具,客户端有时候无法正常给你安装上,你需要去检查自己的电脑里面对应文件夹下是否有这些工具,如果没有请自己去下载安装(我测试的时候发现是uv可以安装,bun需要自己下载安装):

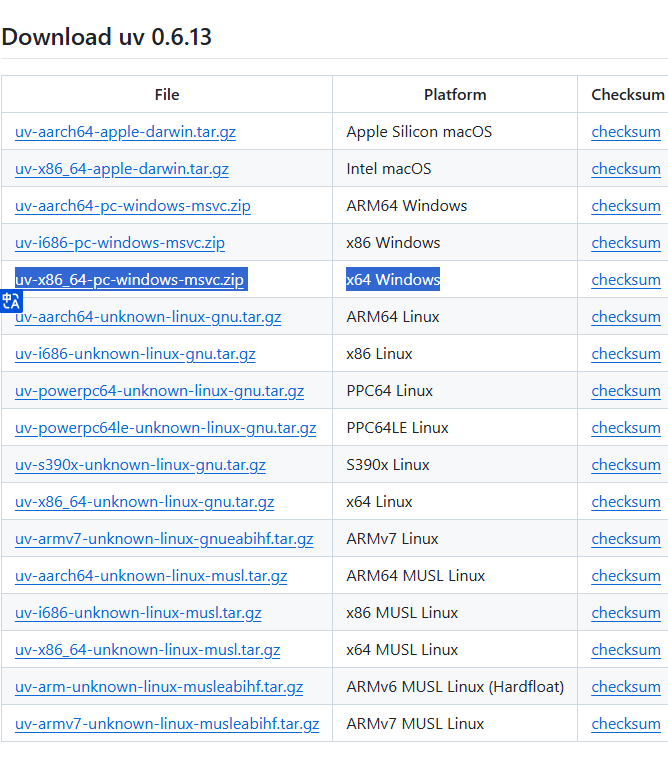

uv下载:

https://github.com/astral-sh/uv/releases

选择合适版本

bun下载:

https://github.com/oven-sh/bun/releases

选择合适版本

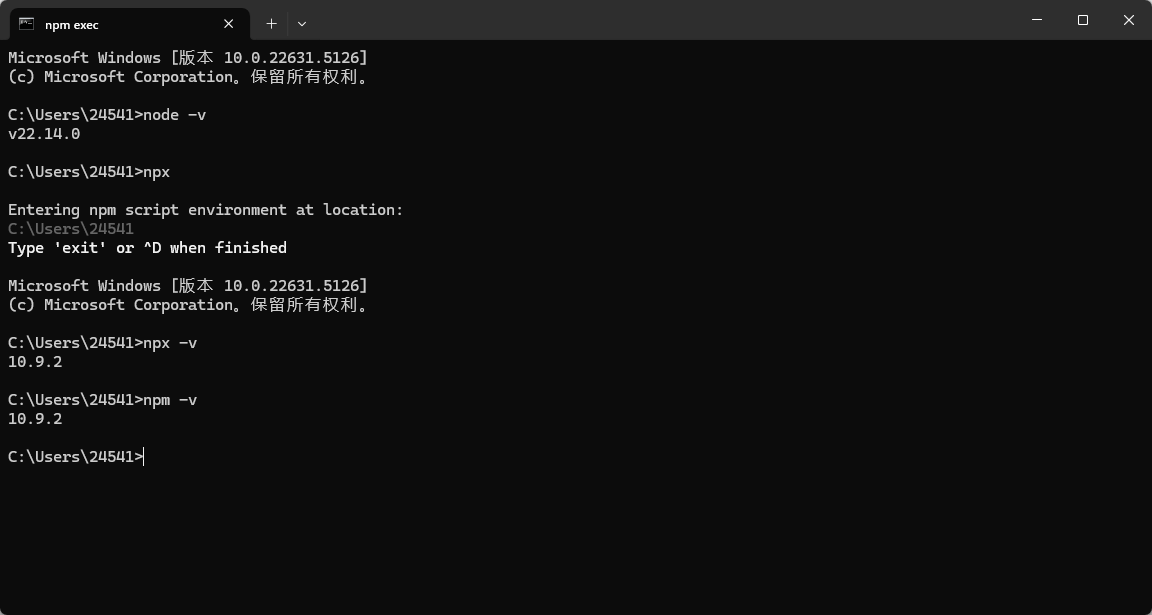

除了上面说的bun和uv的环境之外,还需要在windows中安装node.js,一个类似python的包管理的.我之前没有了解过,这里学习一下它的内容,为了更好的理解,我们把它和python类比一下.Node.js是用来运行javascript的,有了node.js,javascript就能在服务器端或者命令行环境中运行,它为javascript提供了执行环境,并且基于自身的特性,适合开发一些高性能的网络应用等.

npm在node.js项目中扮演着类似的角色,它是以node.jus的默认管理工具,有一个庞大的在线软件包仓库.需要使用javascrpt库构建web应用的express,用于操作DOM的jQuery等,类似与pip,可以通过npm install 命令来安装这些库.

最后时npx,它是一个直接运行某个可执行文件的工具,比如我们没有npm下载的库时,可以通过npx,直接在项目中引入这些库,而不需要全局安装,会自动下载并运行这些工具,后面我们很多MCP都是通过npx来直接构建运行环境的.所以这里才说一定要先安装node.js,否则cherry studio中的配置就会有问题.

官网链接:https://nodejs.org/

下载好后直接一路安装即可,它会自动添加相关的环境变量,注意文件夹需要给一下权限,下载才不会有问题!!

检查是否安装成功,打开cmd,输入node -v检验是否安装成功

都配置好之后保存.我们之前已经添加过json了,所以只需要打开MCP服务的开关就可以了:

测试一下使用:

先选好模型,然后去对话框中选择我们的mcp serve就可以使用了

我这里反复测试了一下,发现deepseek-v3这个模型无法联网,就算可以使用这个工具也没有办法去查看网络的内容,所以我们换一个能够联网的模型,我使用的阿里云百炼的qwen模型:

没有问题了:

好了这样就算是学会配置MCP了,接下来我们具体去配置自己的智能体。

这是我最后的json的配置文件(需要API和密钥的都替换成了xxx),接下来一个一个说明一下这些工具的配置和效果

{

"mcpServers": {

"playwright": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@executeautomation/playwright-mcp-server"

],

"name": "playwright"

},

"fetch": {

"isActive": true,

"disabled": false,

"timeout": 60,

"command": "uvx",

"args": [

"mcp-server-fetch"

],

"transportType": "stdio",

"name": "fetch"

},

"baidu-map": {

"isActive": true,

"disabled": false,

"timeout": 60,

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"@baidumap/mcp-server-baidu-map"

],

"env": {

"BAIDU_MAP_API_KEY": "xxx"

},

"transportType": "stdio",

"name": "baidu-map"

},

"memory": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-memory"

],

"name": "memory"

},

"filesystem": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-filesystem",

"C:\\Users\\24541",

"F:\\git\\mcp-client"

],

"name": "filesystem"

},

"desktop-commander": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@wonderwhy-er/desktop-commander"

],

"name": "desktop-commander"

},

"sequential-thinking": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-sequential-thinking"

],

"name": "sequential-thinking"

},

"github": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-github"

],

"env": {

"GITHUB_PERSONAL_ACCESS_TOKEN": "xxx"

},

"name": "github"

},

"blender": {

"isActive": true,

"command": "uvx",

"args": [

"blender-mcp"

],

"name": "blender"

}

}

}

Blender MCP

首先它要有建模的能力,首选当然是blender-mcp,这种应用类的除了要自己配置mcp之外,还会涉及到一些软件的配置,mcp的配置我们就跳过了,直接添加一下json内容:

"blender": {

"isActive": true,

"command": "uvx",

"args": [

"blender-mcp"

],

"name": "blender"

}

打开开关即可:

可用的工具还是很多的.然后还需要去配置一下blender,下载安装blender之后,去添加本地插件:

https://github.com/ahujasid/blender-mcp下载这个addon.py文件:

然后导入到blender的插件库中:

然后去连接一下mcp的server即可:

然后就可以去提出需求了:

建模结果并不理想,所以说claude、openai的模型比较强真的不是没有原因的.

百度地图

我们使用百度地图的mcp server,首先需要获取百度地图的api调用凭证前往百度地图的开放平台:

https://lbsyun.baidu.com/apiconsole/center

登录控制台后,创建一个新的应用:(初次使用需要先申请,几个小时后就审核完了会通知你的)

使用服务部分的API,然后就复制一下这个api,然后配置一下json:

"baidu-map": {

"isActive": true,

"disabled": false,

"timeout": 60,

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"@baidumap/mcp-server-baidu-map"

],

"env": {

"BAIDU_MAP_API_KEY": "你的地图API"

},

"transportType": "stdio",

"name": "baidu-map"

}

然后使用大模型进行测试即可:

Git

能够让大模型操作git仓库:

"git": {

"isActive": true,

"command": "uvx",

"args": [

"mcp-server-git",

"--repository",

"F:\\git\\hardware"

],

"name": "git"

}

这里需要给一个对应的本地的git仓库地址,然后测试一下:

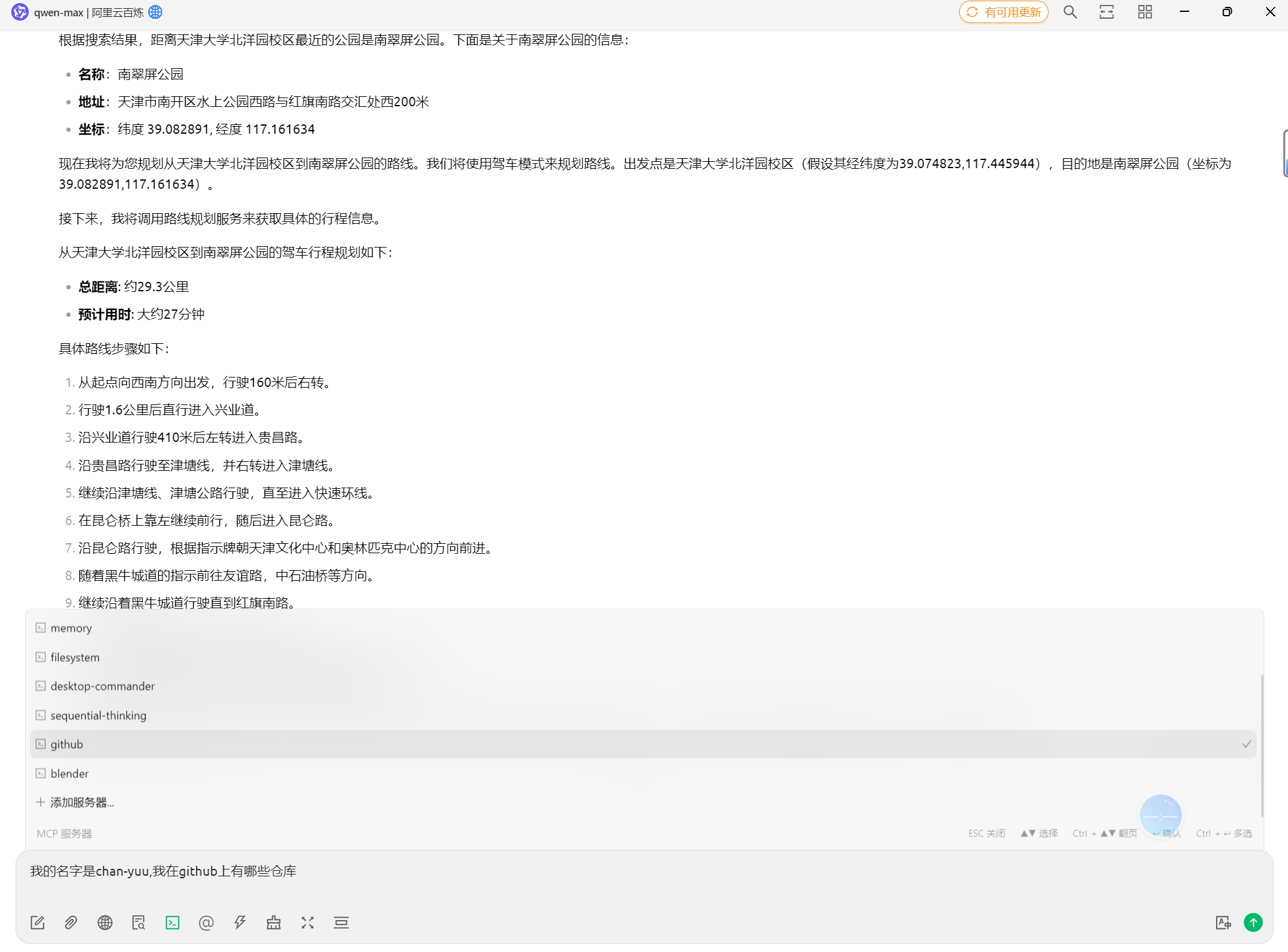

Github

"github": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-github"

],

"env": {

"GITHUB_PERSONAL_ACCESS_TOKEN": "xxx"

},

"name": "github"

}

首先要去自己的github上创建一个token密钥:,在设置里面的开发者模式,创建一个密钥,设置一下时间限制,对于所有仓库的访问,以及对于这些仓库的各种访问权限,我直接全部开放了这个token的所有权限.

生成好token后填入GITHUB_PERSONAL_ACCESS_TOKEN即可,然后我们来测试一下:

filesystem

文件系统,可以直接操作电脑上的文件内容,注意添加时需要加上自己的目录,并且好像需要有权限修改的目录才能读取内容

"filesystem": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-filesystem",

"C:\\Users\\24541",

"F:\\git\\mcp-client"

],

"name": "filesystem"

}

测试一下:

desktop-command

可以操作电脑上的文件了,之前的filesystem只是分析文件,还不能去处理本地的文件.直接上json:

"desktop-commander": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@wonderwhy-er/desktop-commander"

],

"name": "desktop-commander"

},

"sequential-thinking": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-sequential-thinking"

],

"name": "sequential-thinking"

}

直接测试一下:

知识图谱

这块的配置多一点内容,首先需要编辑一下默认的助手,填写这些提示词,也就是关于记忆知识的:

Follow these steps for each interaction:

1. User Identification:

- You should assume that you are interacting with default_user

- If you have not identified default_user, proactively try to do so.

2. Memory Retrieval:

- Always begin your chat by saying only "Remembering..." and retrieve all relevant information from your knowledge graph

- Always refer to your knowledge graph as your "memory"

3. Memory

- While conversing with the user, be attentive to any new information that falls into these categories:

a) Basic Identity (age, gender, location, job title, education level, etc.)

b) Behaviors (interests, habits, etc.)

c) Preferences (communication style, preferred language, etc.)

d) Goals (goals, targets, aspirations, etc.)

e) Relationships (personal and professional relationships up to 3 degrees of separation)

4. Memory Update:

- If any new information was gathered during the interaction, update your memory as follows:

a) Create entities for recurring organizations, people, and significant events

b) Connect them to the current entities using relations

b) Store facts about them as observations

然后配置mcp:

"memory": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-memory"

],

"name": "memory"

}

然后测试一下.先让他记住知识:

然后清楚上下文,重新询问:

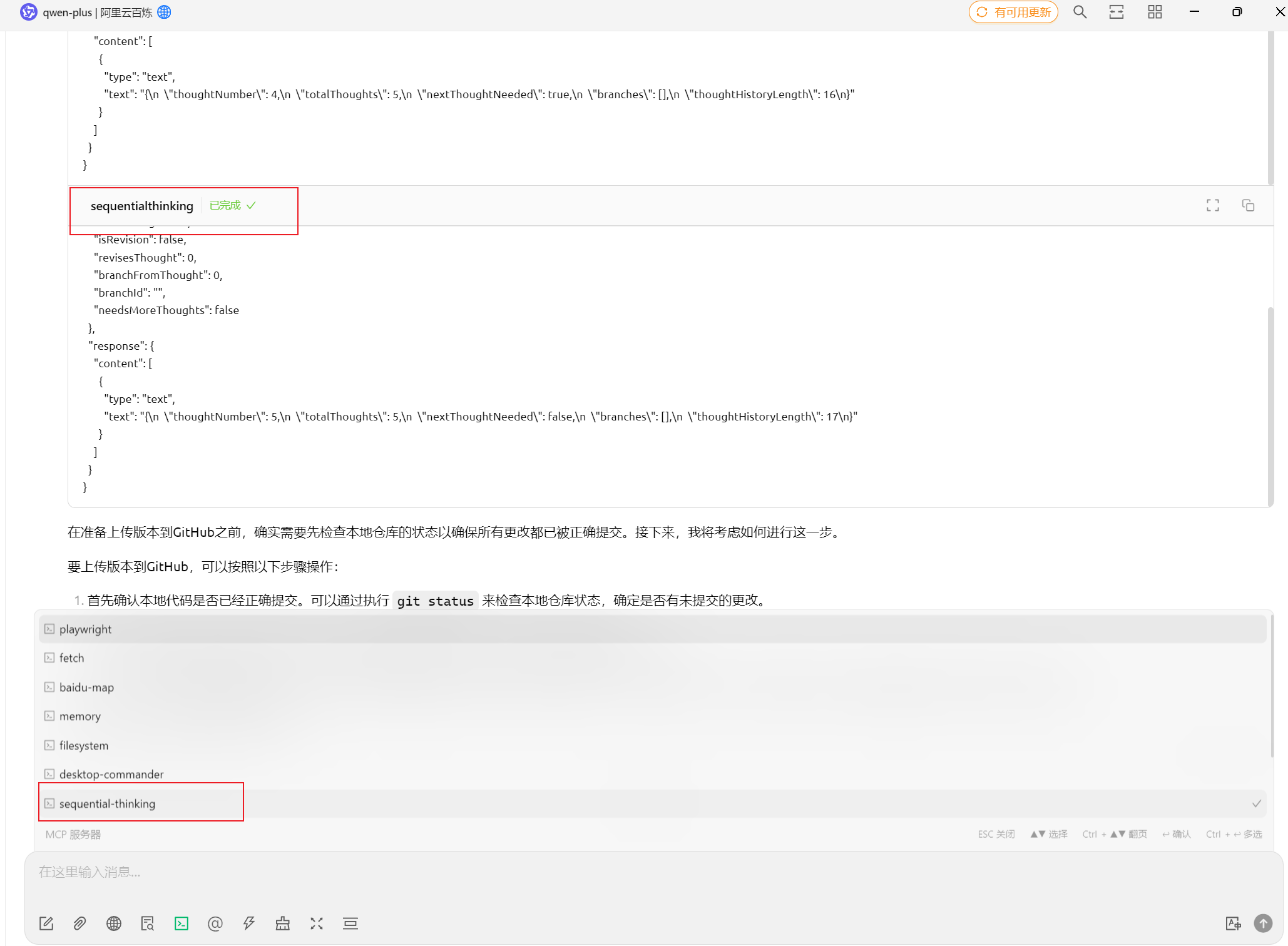

顺序思维

让大模型拆解问题,获得类似于推理模型的能力:

"sequential-thinking": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@modelcontextprotocol/server-sequential-thinking"

],

"name": "sequential-thinking"

}

然后调用顺序思维的服务:

浏览器自动化

这个比较特别,我们理解了这一个配置之后就能自己配置任务node环境的mcp服务了.

https://github.com/executeautomation/mcp-playwright

首先需要用npm工具安装全局包:

使用cmd运行

npm install -g @executeautomation/playwright-mcp-server

怎么查看是否安装呢?

npm list -g

可以看到和pip很像,这里已经安装好了.这里有一个-g全局安装的概念:

全局安装是指将软件包安装在系统的全局环境中,使得该软件包在整个系统中都可以被访问和使用,而不仅仅局限于某个特定的项目目录。与之相对的是本地安装,以下是两者的区别:

本地安装位置:本地安装的包会被安装到当前项目的node_modules目录下。例如,在项目my-project的根目录下执行npm

install some-package,则some-package会被安装到my-project/node_modules目录中。

全局安装位置:如前文所述,在 Windows 系统中,全局安装的包通常位于%AppData%\npm\node_modules目录;在 macOS 和 Linux 系统中,通常位于/usr/local/lib/node_modules目录。

这里安装的这个包其实就是一个playwright的浏览器环境给mcp使用.

然后就可以通过npx来运行对应的项目了:也就是npx命令

npx @michaellatman/mcp-get@latest install @executeautomation/playwright-mcp-server

但是我们启动mcp服务并不是直接在命令行中进行,而是配置到了cherry studio中,所以是把它填入到json配置中:

"playwright": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@executeautomation/playwright-mcp-server"

],

"name": "playwright"

}

这里的配置其实和运行那个命令没有区别.最后我们来看一下效果:

这里没有成功登录,貌似他没有填写Authenticator的权限.

matlab

这个貌似还没有很好的封装到服务器上,所以我们需要先本地安装一下:

下载一下:https://github.com/WilliamCloudQi/matlab-mcp-server

安装一下这个javascript项目:

cd matlab-mcp-server

npm install

npm run build

在build下生成了一个js文件,然后我们配置一下mcp:

"matlab-server": {

"command": "node",

"args": ["F:\\git\\matlab-mcp-server\\build\\index.js"],

"env": {

"MATLAB_PATH": "D:\\Program Files\\MATLAB\\R2023b\\bin\\matlab.exe"

},

"disabled": false,

"autoApprove": []

}

注意修改一下对应的js和matlab的位置.

应该就可以调用了…

还有很多的mcp server正在开发中,当大模型集成了这些工具之后,工作效率将成倍提升!当然,现在开源模型商其实还在追赶,claude的集成mcp工具已经非常强大了,也有自己的client客户端,期待后续的发展.后面我们可能会接触n8n,cozy这样的工作流智能体,也是类似的.

1211

1211

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?