Direct Training for Spiking Neural Networks: Faster, Larger, Better

最新推荐文章于 2024-05-20 16:35:09 发布

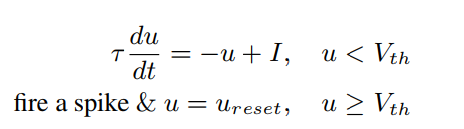

本文提出了一种直接训练深层脉冲神经网络(SNN)的算法,通过神经元正则化和精确的LIF迭代模型,实现了训练速度的显著提升和网络规模的扩大。实验表明,这种方法在保持高准确率的同时,显著减少了模拟步数,降低了功耗,适用于资源受限的场景。

本文提出了一种直接训练深层脉冲神经网络(SNN)的算法,通过神经元正则化和精确的LIF迭代模型,实现了训练速度的显著提升和网络规模的扩大。实验表明,这种方法在保持高准确率的同时,显著减少了模拟步数,降低了功耗,适用于资源受限的场景。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

298

298

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?