“震撼来袭!阿里推出了其最强大的视觉语言模型——Qwen2-VL-7B,真是太厉害了!还附上了整合包,赶紧来看看!”

各位,AI圈再次掀起热潮,真是热闹非凡!

这次轮到阿里出手了,低调却不简单,他们竟然直接开源了最强视觉语言模型Qwen2-VL-7B!后文有一键整合包的获取方式,千万不要错过!

那么,什么是视觉语言模型呢?简单来说,它就是让AI不仅能够‘理解’图片和视频,还能用语言与你进行交流!

Qwen2-VL这家伙,简直就像开了挂一样:

-

“火眼金睛”:无论图片的分辨率或比例是什么,它都能轻松识别!

-

“追剧达人”:即使是20分钟的长视频,它依然能看得津津有味,并且还能回答你的问题!

-

“贴心管家”:一旦装在手机或机器人上,它立刻就能变身为你的智能助手,帮助你处理各种事务!

-

“语言天才”:中文、英文、日文、韩文……各种语言统统不在话下!

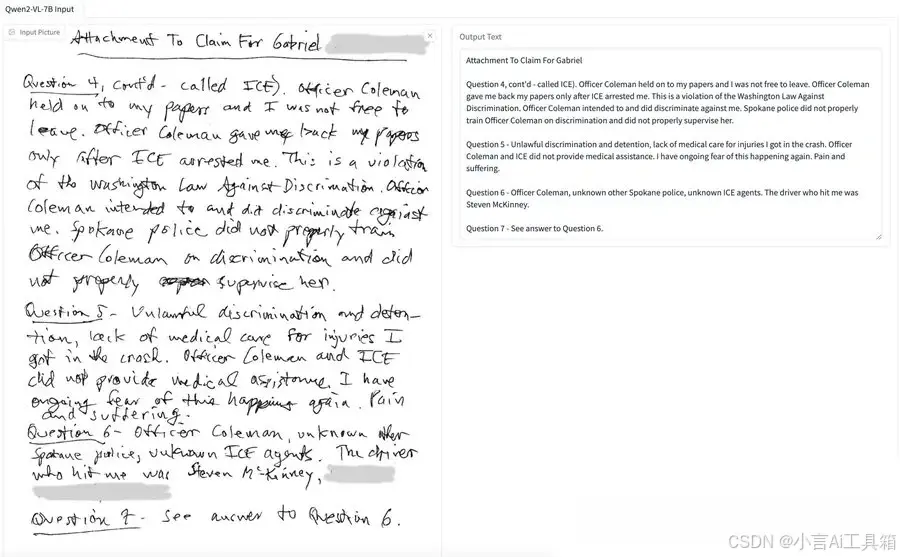

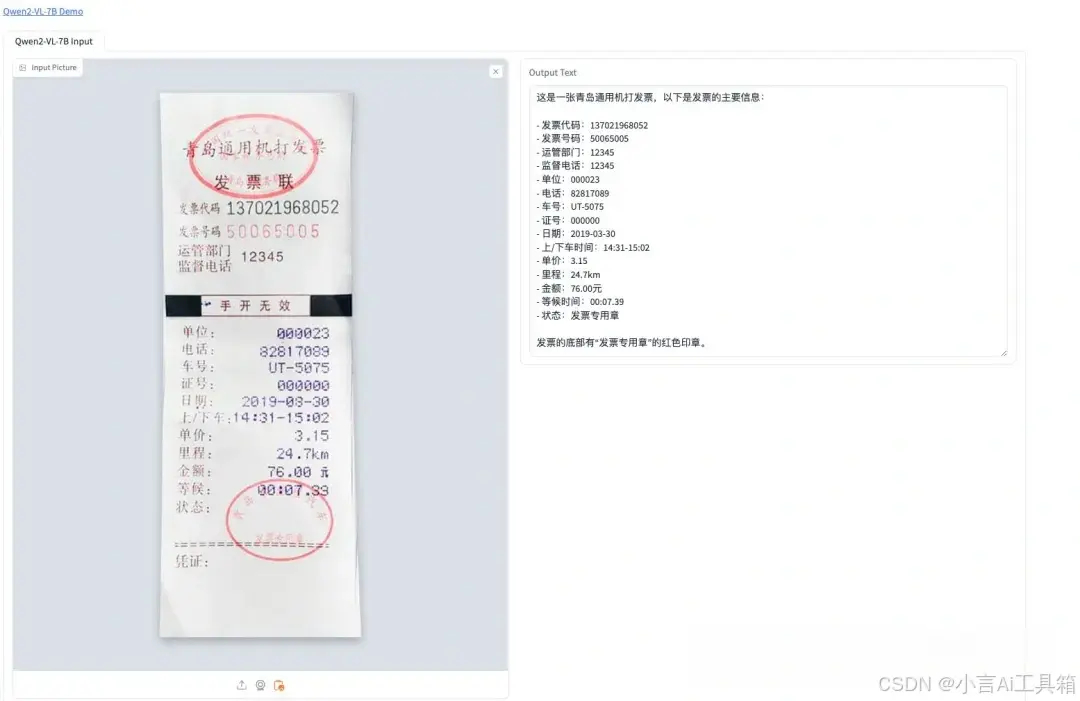

更厉害的是,它的OCR能力简直逆天!英文手写字识别准确率竟然达到了100%!中文表现也相当出色!这实在是太离谱了!

经过六大能力测试,72B的Qwen2-VL简直是碾压级别的存在,尤其是在文档理解方面,完全吊打了GPT-4o和Claude3.5-Sonnet等一众闭源模型!

最最最重要的是,阿里爸爸竟然直接开源了!

这意味着,无论是公司还是个人开发者,都可以免费使用!这一举措,简直是业界的良心之作!

开源地址:https://github.com/QwenLM/Qwen2-VL

等等!还有更劲爆的!

我已经把这套 AI 工具做成了本地一键启动的整合包!

只需轻轻一点,就能在你的电脑上轻松使用,彻底不必担心隐私泄露和环境配置的问题!

电脑配置要求:

-

Windows 10/11 64 位操作系统

-

8G 显存以上英伟达显卡

下载和使用教程:

-

下载压缩包:👉👉【Qwen2-VL-7B】(点我)👈👈

(👆👆👆安全链接,放心点击)

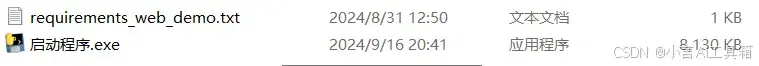

2.解压文件:解压后,最好不要有非英文路径,双击“启动程序.exe”文件运行。

3.通过浏览器进行操作:软件启动后会自动打开浏览器,界面如下所示。

怎么样,是不是超级简单?

我迫不及待想要看看开源社区的大佬们会用Qwen2-VL创造出哪些令人惊艳的应用!

AI的未来充满了无限可能,让我们一同见证这些奇迹的到来吧!

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?