易扩增子(EasyAmplicon)是一套完整的扩增子分析流程,可以实现简单易用、可重复和跨平台地开展扩增子分析,支持20余种分析方法,并生成出版级图表。详细介绍可见GitHub - YongxinLiu/EasyAmplicon: Easy Amplicon data analysis pipeline

2023年1月27日,中国农科院基因组所刘永鑫团队、中国中医医科学院陈同团队和南京农业大学文涛团队等在 iMeta 在线发表了题为 “EasyAmplicon: An easy-to-use, open-source, reproducible, and community-based pipeline for amplicon data analysis in microbiome research ” 的文章。(DOI: https://doi.org/10.1002/imt2.83)

本文将以美吉公司为例,详细介绍公司测序原始数据如何导入EasyAmplicon工作流。

一、准备工作:

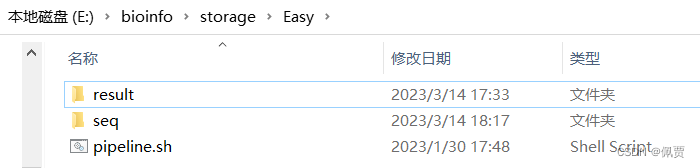

1.创建工作目录,创建reslut和seq子目录。

2.在result目录中创建metadata_raw.txt并编辑。

3.将公司测序原始数据保存于seq目录,根据metadata中SampleID修改对应的测序文件名称。

二、:操作

根据EasyAmplicon/pipeline.sh at master · YongxinLiu/EasyAmplicon · GitHub进行操作

4. 去冗余挑选OTU/ASV Dereplicate and cluster/denoise之前的步骤可以根据以下代码进行调整。

#####本教程仅适用于美吉公司测序文件,其余公司暂未测试#####

## 0. 准备工作

# 1. 设置工作目录(wd)、软件数据库目录(db)和环境变量(wd和db根据情况自行修改)

# 2. 并进入工作目录

wd=/e/bioinfo/storage/Easy

db=/e/bioinfo/storage/_Package/EasyMicrobiome

PATH=$PATH:${db}/win

cd ${wd}

## 1. 起始文件 start files

# 1. 分析流程:pipeline.sh(https://github.com/YongxinLiu/EasyAmplicon/blob/master/pipeline.sh)

# 2. 样本信息:metadata_raw.txt(保存于result目录,参照图例自行编辑)

# 3. 测序文件:***.fastq.gz(保存于seq目录,源文件在data.799F_1193R\valid)

# 根据metadata中SampleID修改对应的测序文件名称

# 4. 创建临时文件存储目录,分析结束可删除

mkdir -p temp

### 1.1. 元数据/实验设计 metadata

csvtk -t stat result/metadata_raw.txt

cat -A result/metadata_raw.txt | head -n3

# windows用户结尾有^M,运行sed命令去除,再用cat -A检查

sed 's/\r//' result/metadata_raw.txt > result/metadata.txt

cat -A result/metadata.txt | head -n3

### 1.2. 流程和数据库 pipeline & database

# 数据库第一次使用必须解压,以后可跳过此段

# usearchs可用16S/18S/ITS数据库:RDP, SILVA和UNITE,本地文件位置 ${db}/usearch/

# usearch数据库database下载页: http://www.drive5.com/usearch/manual/sintax_downloads.html

# 解压16S RDP数据库,gunzip解压缩,seqkit stat统计

# 保留原始压缩文件

gunzip -c ${db}/usearch/rdp_16s_v18.fa.gz > ${db}/usearch/rdp_16s_v18.fa

seqkit stat ${db}/usearch/rdp_16s_v18.fa # 2.1万条序列

# 解压ITS UNITE数据库,mv改名简化

gunzip -c ${db}/usearch/utax_reference_dataset_all_29.11.2022.fasta.gz >${db}/usearch/unite.fa

# mv ${db}/usearch/utax_reference_dataset_all_29.11.2022.fasta ${db}/usearch/unite.fa

seqkit stat ${db}/usearch/unite.fa # 32.6万

# Greengene数据库用于功能注释: ftp://greengenes.microbio.me/greengenes_release/gg_13_5/gg_13_8_otus.tar.gz

# 默认解压会删除原文件,-c指定输出至屏幕,> 写入新文件(可改名)

gunzip -c ${db}/gg/97_otus.fasta.gz > ${db}/gg/97_otus.fa

seqkit stat ${db}/gg/97_otus.fa

## 2. 单端文件改名 Single-end reads rename

gunzip seq/*.gz

i=R1 # i为metadata中SampleID第一个样品的名称

time for i in `tail -n+2 result/metadata.txt|cut -f1`;do

usearch -fastx_relabel seq/${i}.fastq -fastqout temp/${i}.merged.fastq -prefix ${i}.

done

### 2.1 改名后序列整合 integrate renamed reads

#合并所有样品至同一文件

cat temp/*.merged.fastq > temp/all.fastq

# 查看序列名,“.”之前是否为样本名,样本名绝不允许有点 (".")

# 后面分析获得特征表后要看一眼有没有问题,遇到内存不足问题,也要回头来排查。

head -n 6 temp/all.fastq|cut -c1-60

## 3. 切除引物与质控 Cut primers and quality filter

# 公司已经去除barcode和引物,参数填0即可

time vsearch --fastx_filter temp/all.fastq \

--fastq_stripleft 0 --fastq_stripright 0 \

--fastq_maxee_rate 0.01 \

--fastaout temp/filtered.fa

# 查看文件了解fa文件格式

head temp/filtered.fa

##之后步骤参照pipeline.sh(https://github.com/YongxinLiu/EasyAmplicon/blob/master/pipeline.sh)即可。

1031

1031

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?