新浪张俊林–中国人工智能学会演讲

文章目录

什么是大模型的涌现能力

涌现: 许多小实体相互作用产生了大实体,大实体展现了组成它的小实体所不具有的特性

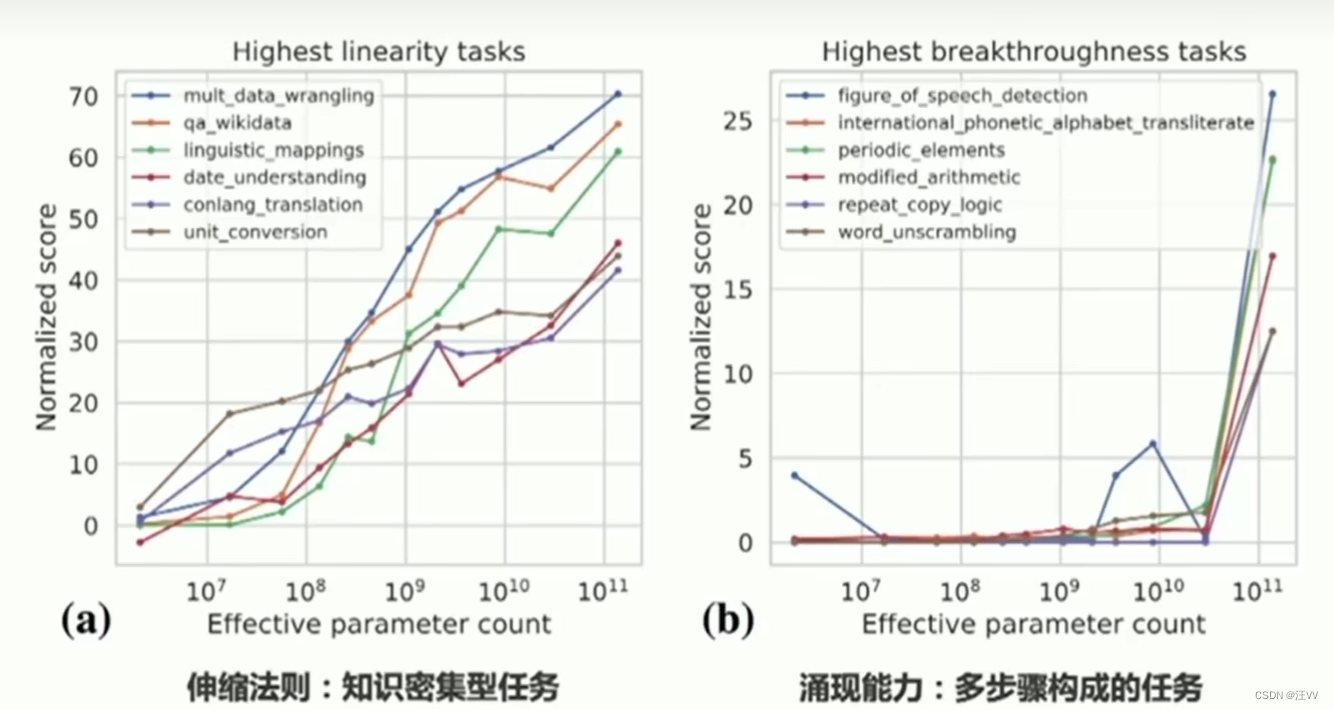

大语言模型的规模效应:下游任务表现-伸缩法则&&涌现能力

左侧任务:随着参数规模增大,知识的增长,效果越来越好

例如:多数据清洗和转换、基于维基数据的知识问答、语言映射、日期理解、虚构语言翻译、单位转换任务

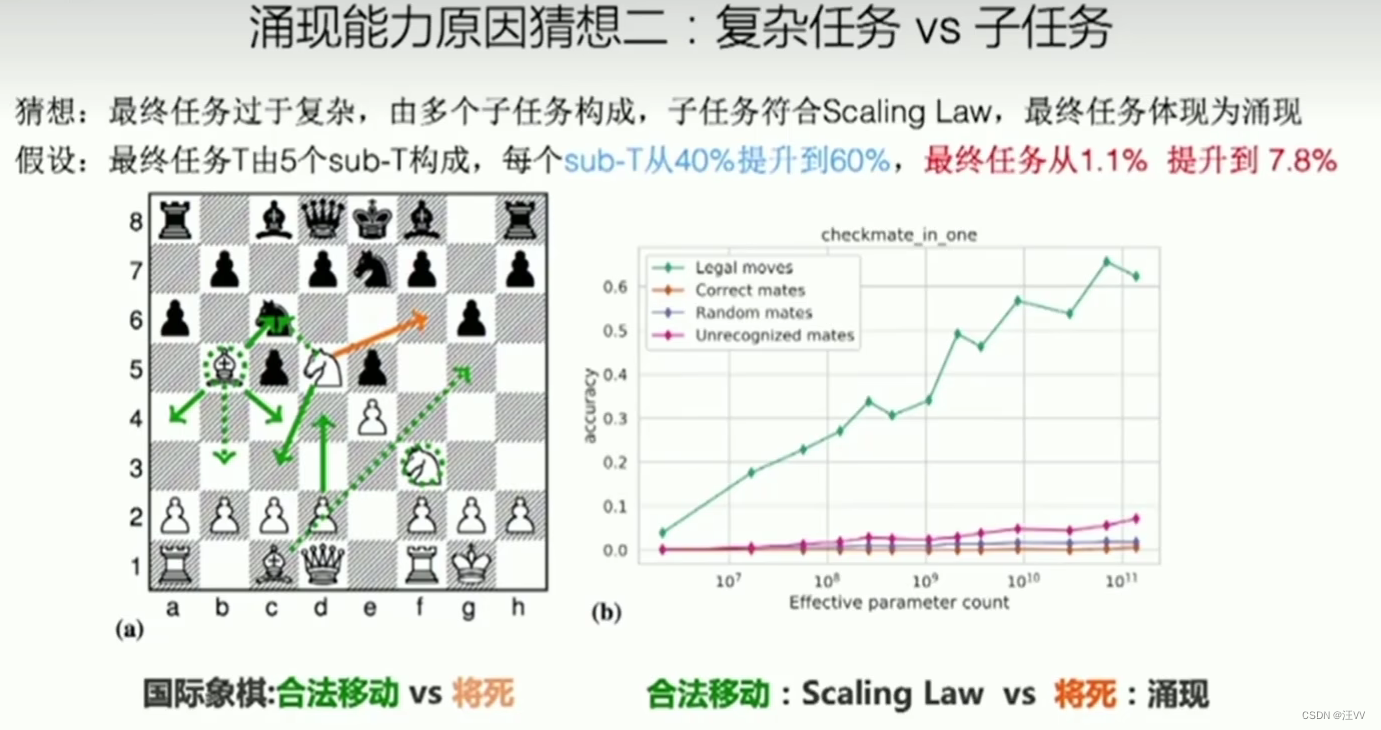

右侧任务:涌现能力的一种体现,在参数规模小的时候体现一种随机性,看不出来有没有效果。大部分是由多步构成的一个复杂任务

例如:词性消歧、国际音标转写、周期表元素识别、修改后的算术、重复复制逻辑、单词反混淆

随着模型推大,效果一开始下降,当规模再增大时会上升,原因未知,但是这类任务加入COT就会转化为伸缩法则,效果持续上升。

大模型的涌现,很多任务在小规模上不能实现,但是大规模上能做。因此在当前不能做的任务,为了验证,只需要推大模型。

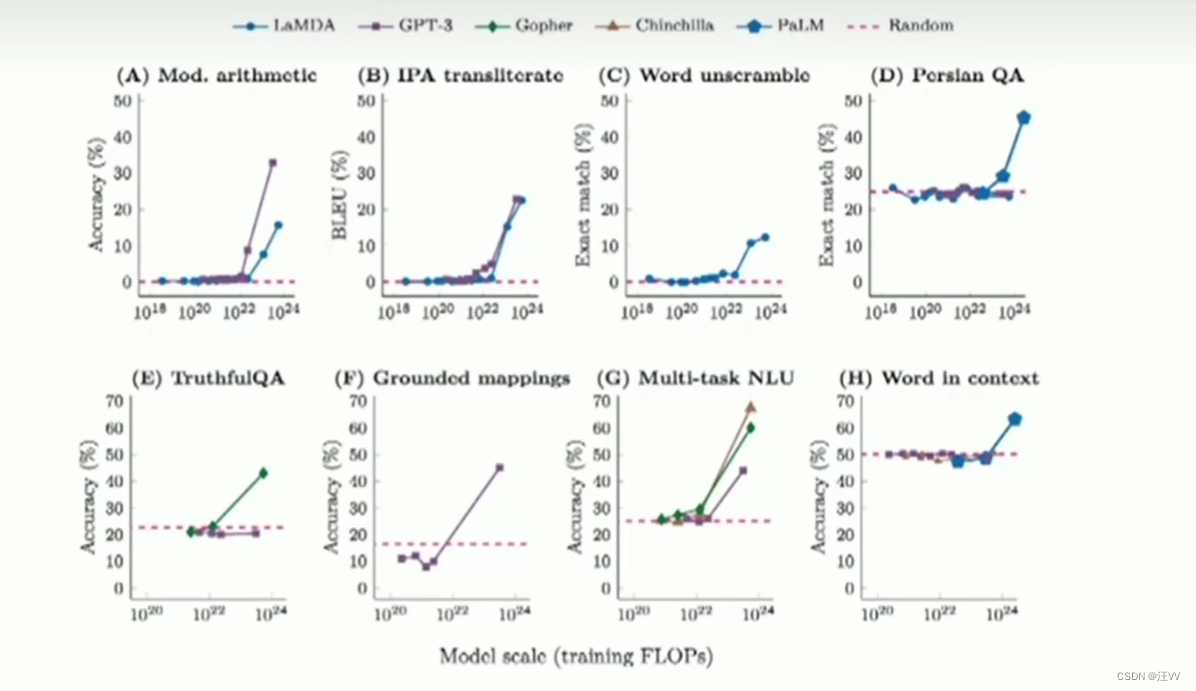

LLM表现的涌现能力

1. In Context Learning – 情景学习

给LLM几个示例,不需要调整模型参数,LLM就可以解决某个领域的问题。

在不同任务上的应用。

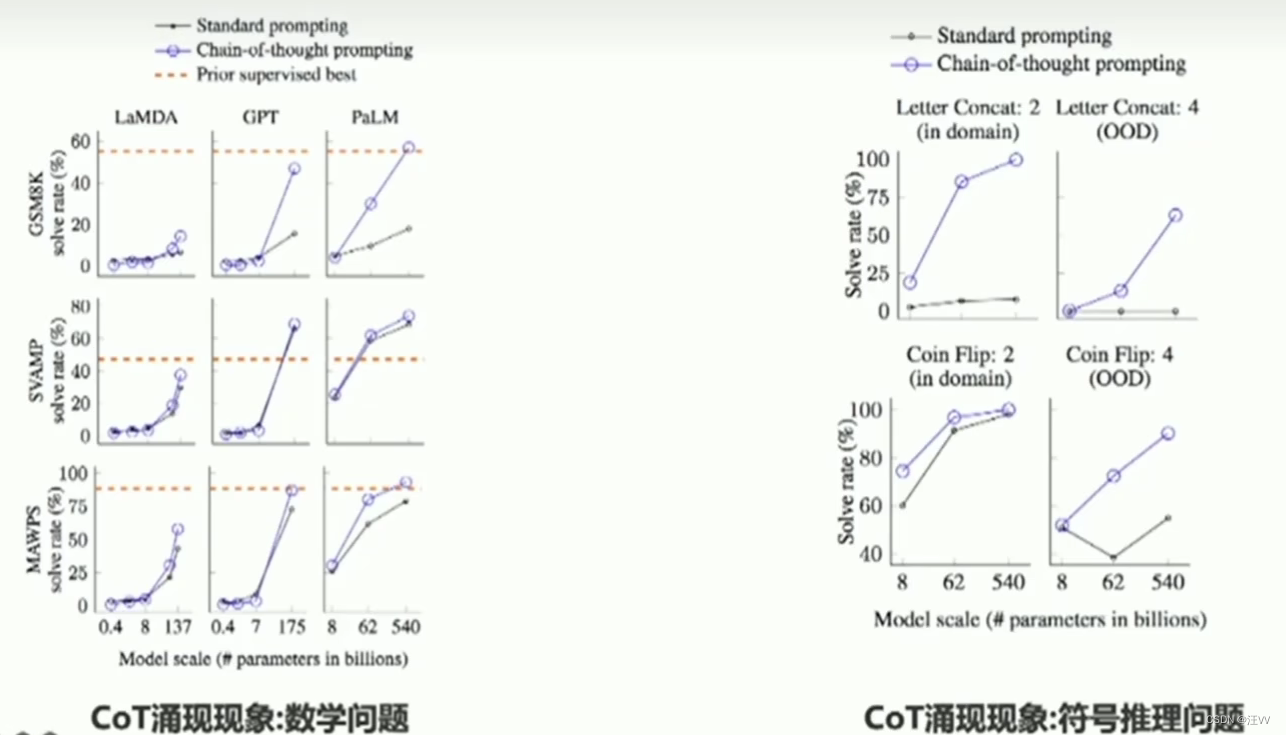

2. CoT

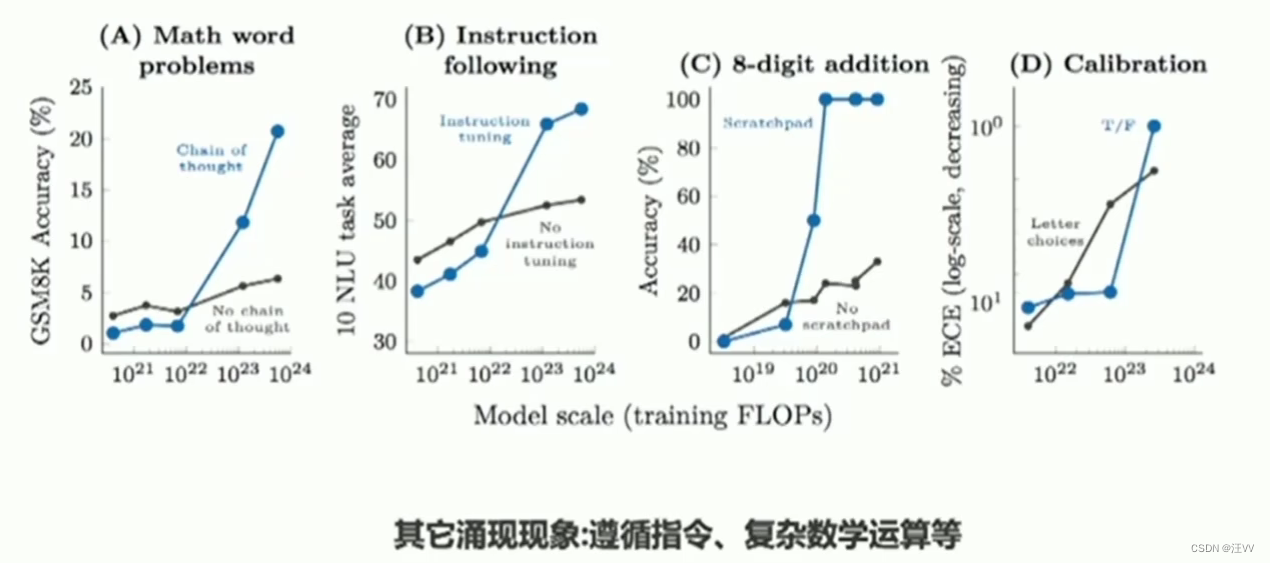

3. 其他涌现能力

LLM模型规模和涌现能力的关系

模型规模和涌现能力的关系: In Context Learning

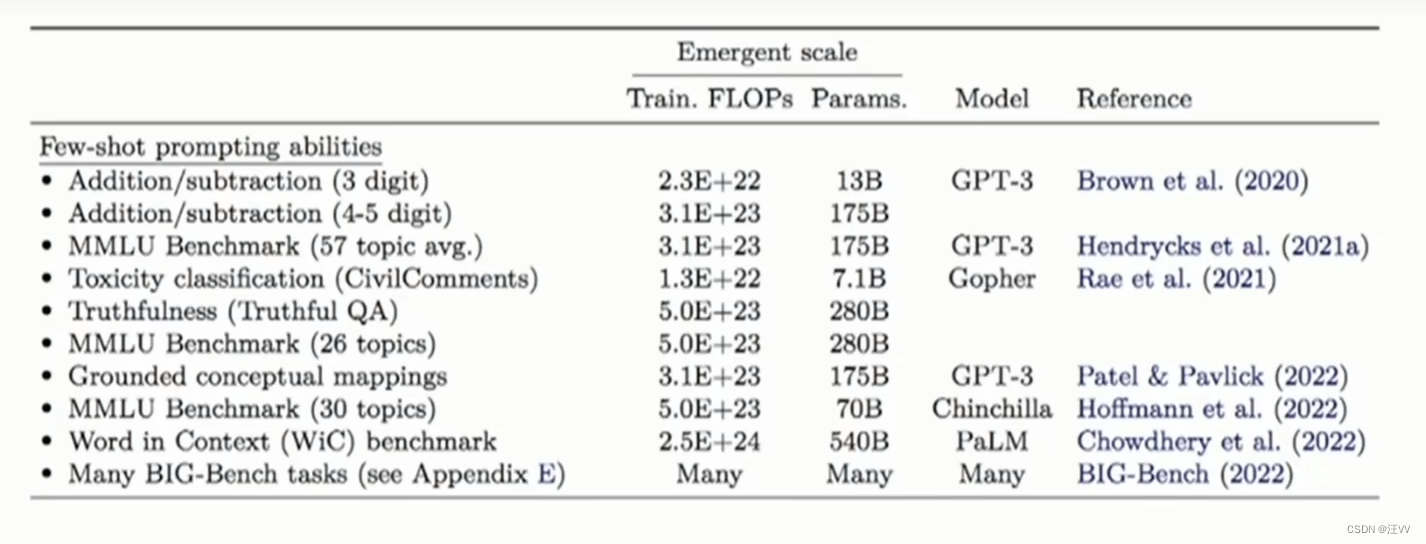

与具体任务/具体模型有关:某些任务13B规模即可,有些任务需要540B,大部分需要达到70B

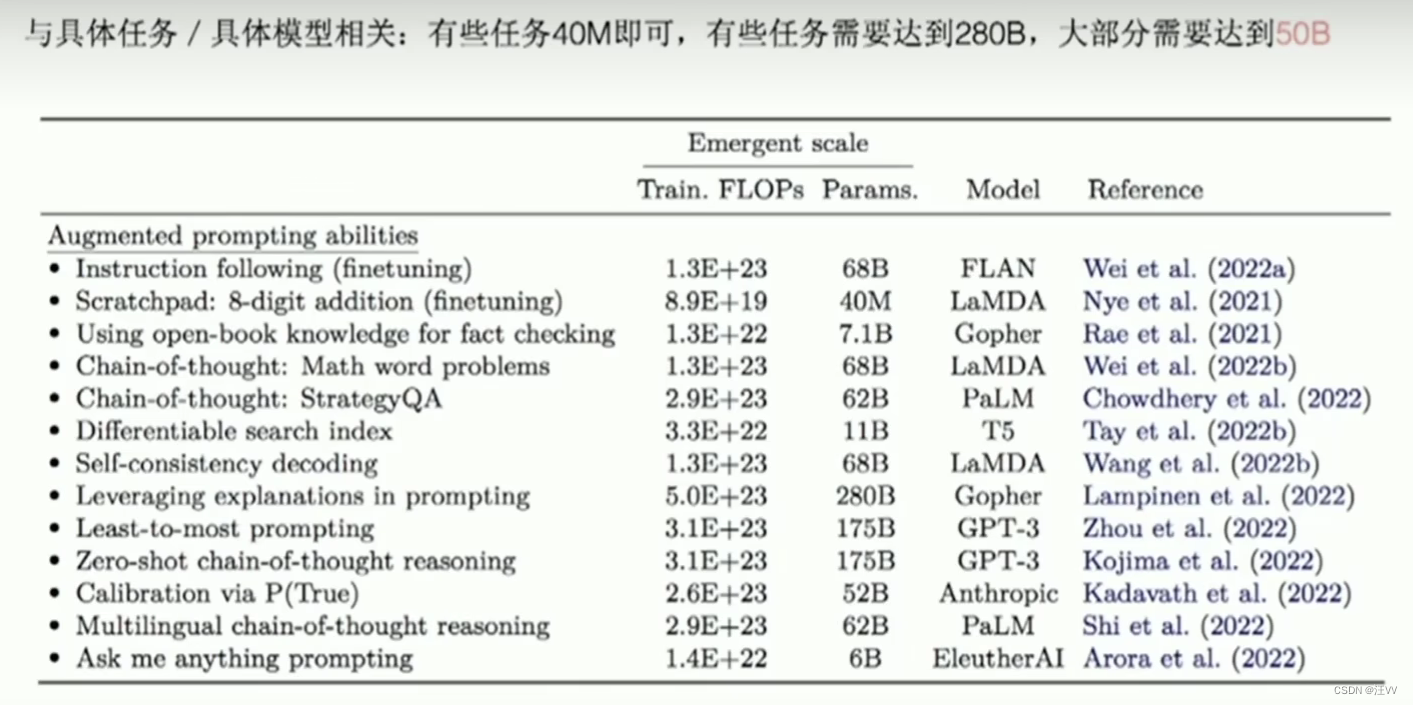

模型规模和涌现能力的关系: CoT等其他涌现能力

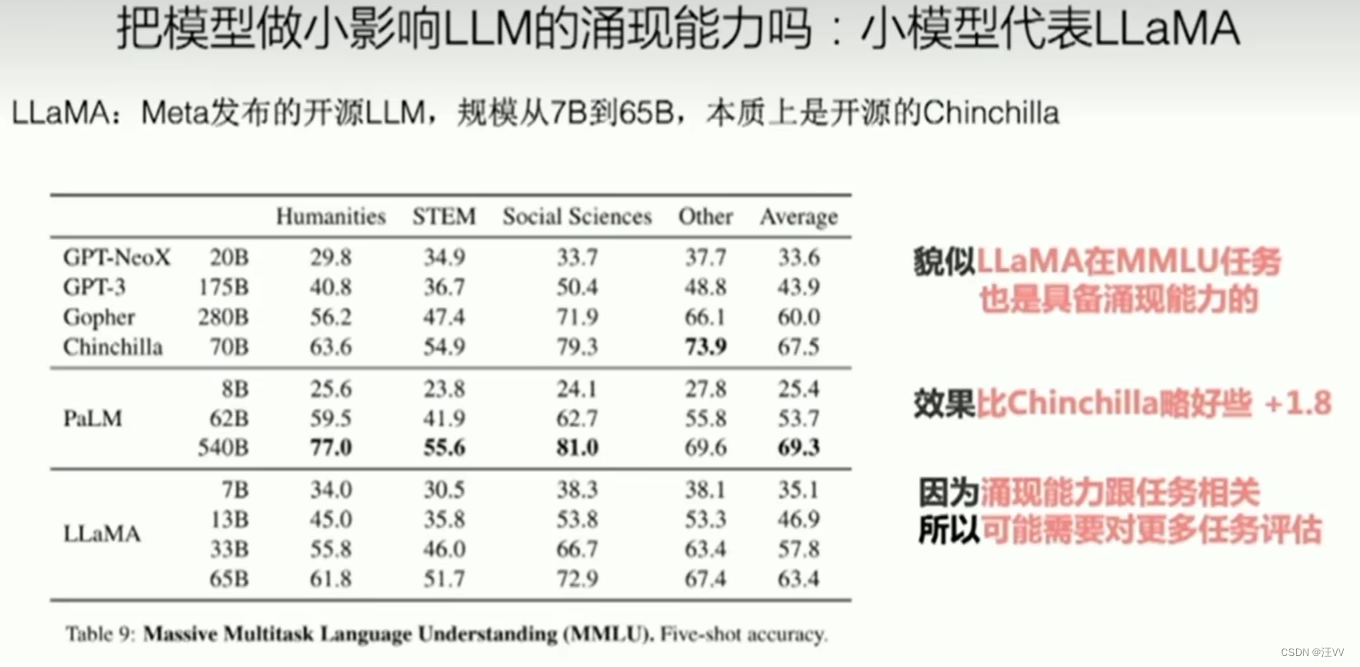

尝试做小模型?

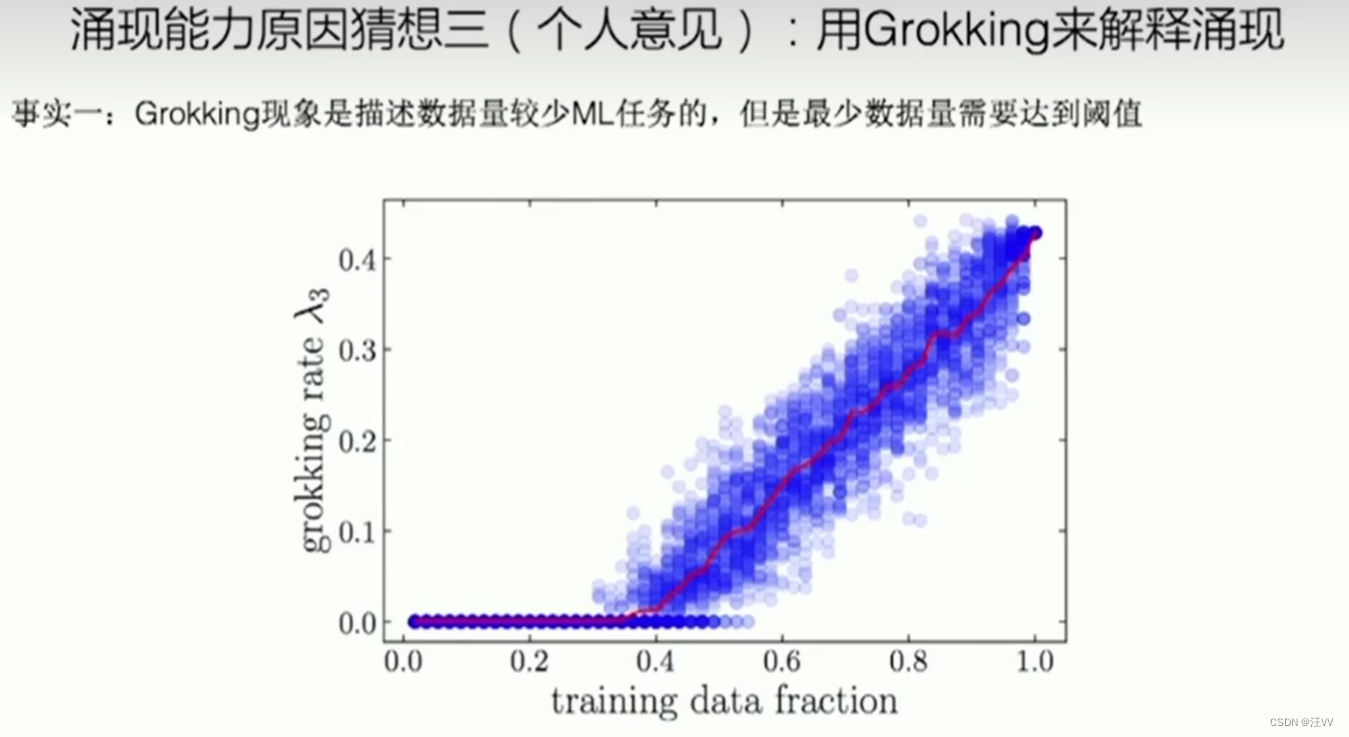

模型训练中的顿悟现象:Grokking

Grokking:训练数据较少的某些数学任务(取余问题),训练过程三阶段(记忆期、平台期、泛化期)

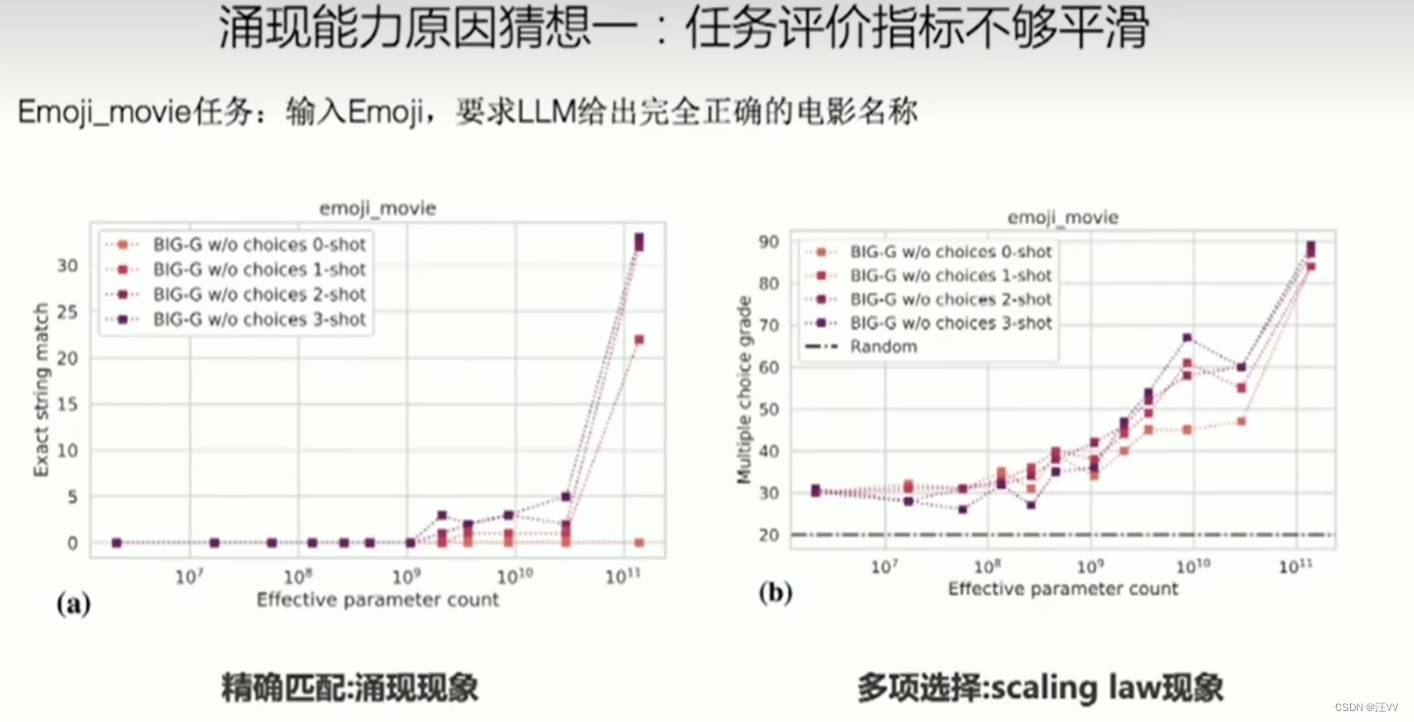

LLM涌现能力的可能原因

1995

1995

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?