源自:系统仿真学报

作者:徐艺博 于清华 王炎娟 郭策 冯世如 卢惠民

摘

要

面向利用多枚巡飞弹对地面高防御移动目标进行打击的任务场景,提出一种基于多源信息融合的巡飞弹对地移动目标识别与毁伤评估方法。基于IoU判定实现红外图像与可见光图像的多源信息融合;提出一种基于YOLO-VGGNet的两阶段紧耦合的巡飞弹对地移动目标毁伤评估方法,利用卷积神经网络深度语义信息提取的优势,引入红外毁伤信息,实现对地面移动目标的在线实时毁伤评估。实验结果表明:基于多源信息融合的目标识别算法有效提升了巡飞弹对地面移动目标识别的有效性;基于YOLO-VGGNet的在线实时毁伤等级评估方法较传统基于图像变化检测与基于两阶段卷积神经网络的方法评估准确率分别提升19%和10.25%。

关键词

多源信息融合, 毁伤评估, 卷积神经网络, YOLO-VGGNet, 在线实时评估

引言

现代战争中,分布式、集群化、协同化作战方兴未艾,面对具有高目标价值和强防御能力的敌方目标威胁,与单枚导弹相比,利用导弹集群进行智能化协同作战,可以提高体系突防能力、感知探测能力和目标打击饱和度,但同时也对导弹自身环境观测和目标状态感知能力提出了新的挑战[1]。面对具有高防御能力的敌方目标威胁,单枚导弹可能无法有效摧毁,需要使用多枚导弹进行联合打击。对受打击后的目标进行毁伤评估不仅可以节省弹药、确定目标打击优先级,而且还可以实现对地面目标的饱和式攻击,客观评价战场态势[2-3]。本文以巡飞弹组成的弹群为研究背景,巡飞弹是集无人机与导弹优势的察打一体化小型智能弹药,弹群在执行任务时,每个节点基于自身弹载传感器,对地面目标进行位置与状态的感知,并基于弹间通信机制进行不同节点的信息交互。

基于图像对地面目标进行毁伤评估一直是军事智能感知领域的重难点问题,其核心是分析评估方法。除人工判读外,主要有贝叶斯网络法[4]、主成分分析法(PCA)[5]、模糊综合评判法[6]、神经网络分析法等。基于贝叶斯网络的评估方法多采用机器判读,可以综合各种不同类型的信息,具有评估时间短,对不确定性问题定量分析的优点。田福平等[7]利用贝叶斯网络在非精确知识表达与推理领域的优势,综合考虑目标价值、打击难度、打击效果等因素,对目标进行整体作战效果的评估;马晓明等[8]利用贝叶斯网络在不确定性问题上的计算优势,运用GeNle软件建立了目标毁伤效果评估的贝叶斯网络,对目标舰船毁伤效果进行推理评估;杨凯达[9]基于加入毁伤时间流的动态贝叶斯网络有效克服了传统方法的主观性和不确定性,评估准确率得到较大提升,适用于战时精准目标的毁伤效果评估。尽管贝叶斯方法能够对不确定性问题进行定量分析,但它们往往不能利用人的经验知识,无法抓住问题的主要矛盾。

PCA主要采用降维的思想,把图像中复杂的特征表示转化为少数评价指标,作为衡量图像变化程度的特征量[10]。Li等[11]将PCA与合成孔径雷达(SAR)多纹理特征提取的优势相结合,减少数据计算量,评估地面建筑物的毁伤程度;Wu等[12]将PCA与卷积映射网络相结合,实现不同时间段高分辨率图像的变化检测;Osama等[13]提出一种改进的PCA-NLM(nonlocal means)方法,用于不同时间段SAR图像的城市发展变化检测。基于PCA的评估方法可以有效减轻数据处理量并抓住主要矛盾,但抗干扰性较差,易受地面其他变化因素的影响。

传统基于图像变化检测的毁伤评估方法主要针对固定的地面目标(建筑、桥梁、机场) [14],一般分为3个步骤:①对打击前后图像进行配准;②检测受打击的目标区域;③基于图像变化检测对目标毁伤效果进行评估,本质上是“特征提取”问题,需要使用多种图像处理算法,如图像预处理、图像配准、图像辐射校正等,这就不可避免地引入多重误差。固定目标图像变化检测的关键在于打击前后图像的高精度配准,与固定目标不同的是,地面移动目标在执行任务时,时刻处于运动状态,目标受打击并不意味着运动能力的丧失。传统方法往往依赖后方的控制中心,无法仅基于巡飞弹的自身硬件资源进行在线图像处理,考虑信息传递与图像处理造成的时空滞后性,无法满足弹群实际的作战需求[15]。因此,巡飞弹对地面移动目标的识别与毁伤评估应当是实时且在线的,传统基于图像变化检测的毁伤评估方法并不适用于地面移动目标。同时,被攻击目标由于其特殊性与保密性,数量较少且难以获取,这都对基于弹群作战的毁伤评估研究造成很大困难。

卷积神经网络(CNN)在图像领域取得了很大的成功,特别是在目标检测分类领域,在一些大型数据集的测试中,深度卷积神经网络的识别率早已超过人类[16]。基于神经网络方法的优势是可以通过大量数据的学习,提取深层次的语义特征,而不仅是物理、像素空间特征,并且满足在线实时要求。因此,大量基于神经网络的毁伤评估研究也不断涌现。余丽山等[17]基于BP神经网络突出的非线性映射能力和柔性的网络结构对飞机的抗毁能力进行评估;张宗腾等[18]基于改进的GA-BP神经网络对飞机系统各部件的毁伤程度进行评估,提升了模型的泛化能力和全局寻优能力;Shen等[19]使用卫星图像,基于改进的BDANet网络结构充分利用CNN语义特征提取的优势对地面建筑进行毁伤评估,取得了较好的评估效果;Sarath等[20]采用Mask-RCNN神经网络对道路交通中的车辆擦伤区域进行毁伤评估,减轻了车辆保险公司人员的工作量。

上述基于单阶段神经网络的方法虽然可以提取目标的深度语义信息,但是当面对大量需要处理的图像时,并非每一张图片都需要细致的评估,因为对每一帧图像都进行细致的评估是十分耗时的。且单阶段评估方法不适用于地面移动目标的评估,在图像中识别出目标所在区域的同时对区域中的目标进行毁伤评估是不现实的。部分研究者提出两阶段神经网络评估方法,先采用一个轻量化的网络进行粗略评估来判断是否需要进一步处理。Alqahtani等[21]针对机械结构损坏的问题,设计了一个两阶段毁伤评估网络,该网络由两个子神经网络构成,分别检测目标结构是否受损以及受损程度,有效提升了评估的准确率与计算效率;Xu等[22]提出一种两阶段屋顶受损评估方法,用于评估台风后屋顶的受损程度,两个子神经网络分别用于评估房屋是否受损以及受损程度。

虽然基于两阶段神经网络的评估方法可以充分利用CNN深度语义信息提取的优势,同时满足实时在线条件,提升评估的准确率和效率,但仅是针对单一的目标类型,两网络之间的联系仅基于第1个子网络的先验分类信息。如果仅基于第2个子神经网络对多种类型目标进行毁伤评估,神经网络难免会混淆不同目标的毁伤特征,比如,火焰对军帐来说是致命的,而对于坦克却无关紧要。Tang等[23]针对特定类别的目标,训练相应的毁伤评估模型,将两个神经网络进行串联,第1个网络用于区分不同的自然灾害类型,第2个网络基于第1个网络的先验分类信息采用相应自然灾害的评估模型进行毁伤评估。虽然实现了不同目标毁伤程度的评估,但两网络之间的联系依然很弱,仅是自然灾害的分类信息。对地面移动目标的毁伤评估与自然灾害不同,不仅需要有目标分类信息,还要包含目标位置信息,同时为避免不同目标毁伤特征的相互影响,最好可以将不同目标类别分别进行评估。

为解决以上问题,本文提出一种基于YOLO-VGGNet的双阶段紧耦合的对地目标识别与毁伤评估方法,充分利用CNN对目标高级语义信息提取和检测框尺度变化的优势,更好地提取目标毁伤特征,有效排除战场浓烟、火花、弹坑的影响,同时避免不同目标毁伤特征的相互干扰,满足弹群作战的在线实时要求,提高了巡飞弹对地目标毁伤状态评估的准确率和效率。

1 基于多源信息融合的对地目标识别

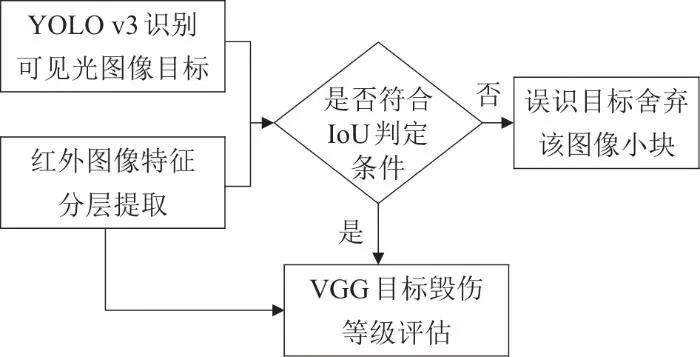

巡飞弹对感知的RGB图像与红外图像进行实时的特征提取,并将识别框进行叠加,基于IoU判定进行信息融合。将符合判定条件的识别框输入VGG系列网络中,同时引入红外毁伤信息进行毁伤等级的评估,流程如图1所示。

图1 弹群节点对地目标识别与毁伤评估流程图

1.1 YOLO v3检测可见光图像目标

由于地面目标时刻处于运动状态,本文采用YOLO v3在线实时地对可见光图像中的目标进行检测、分类与定位。G 为输入RGB图像,YOLO v3网络可表示为

(1)

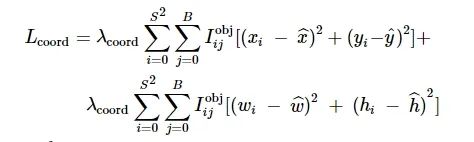

式中:θweight 为网络的权重参数;Gn 为RGB图像中包含目标的图像小块,主要有识别框位置信息Pm=[xm,ym,wm,hm] 、目标的种类Cm 、目标的置信度Qm 。网络的损失函数为

![]()

(2)

式中:Lconfi 为置信度误差;Lclass 为目标类别误差;Lcoord 为坐标预测误差,它们分别负责对目标进行检测、分类与定位。

(3)

式中:λcoord 为坐标误差权重;S2 为输入图像划分的网格数;B 为每个方格生成的先验框;

![]()

为第i 个方格的第j 个先验框是否对该目标负责。如果是,则

![]()

为1,否则为0;

![]()

为目标框真值,分别代表目标的x 与y 方向位置、识别框的宽与高。Lcoord 越小,说明识别框定位越准确。

在仿真场景中收集包含不同毁伤状态的4种军事目标图像:坦克、雷达、补给车、军帐共1 250张图片,为加快训练速度,采用Darknet53标准预训练权重,训练过程中,学习率为0.001,批处理大小为8,训练100个周期。

1.2 红外特征提取

巡飞弹在接收到红外图像之后,先将图像转化为灰度图,增加灰度等级滤波器,将灰度划分为17个等级,对应0~255中15的倍数,设置处于每一灰度区间的灰度值等于该等级的最高值,以此突出灰度图像的层次感。将红外图像的检测强度按图像灰度值划分为3个层级:强辐射(灰度值>180)、中等辐射(90<灰度值≤180)、普通辐射(灰度值≤90)。强辐射主要针对车辆目标、中等辐射主要针对建筑与军帐、普通辐射是环境正常的红外强度。下文检测的红外物体均指强辐射与中等辐射。

选用3×3的开运算滤波器,可最大程度地通过腐蚀膨胀,既不破坏图像原有的目标信息,又能部分排除地面红外噪点的干扰。经过前两步,大大提高了红外掩膜的识别准确度和方框的定位精度。

红外特征提取算法:

(4)

式中:I 为红外图像;φgray 为灰度等级滤波器;φopen 为开运算滤波器;In 为识别的红外目标图像小块;Pm 为图像小块的位置信息;Sm 为图像小块的辐射等级以及包含的火焰、残骸等毁伤红外权重。

1.3 基于IoU判定的信息融合

将红外图像与可见光图像识别信息进行融合,可结合可见光图像分辨率高、识别对比度好与红外图像受环境影响小、准确度高、能识别伪装的优势,提高巡飞弹对地目标识别的有效性。

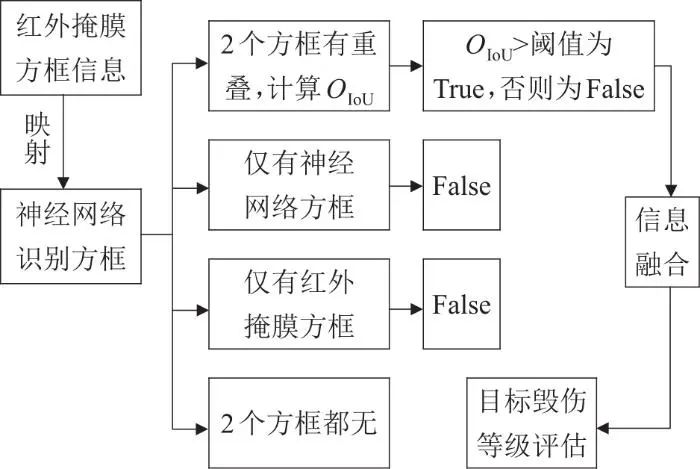

由于可见光与红外图像分辨率大小不同,将从红外图像提取得到的掩膜方框经过缩放映射到RGB图像识别结果中,得到包含2种方法识别的方框信息,如图2所示,绿色框为红外检测结果,蓝色框为神经网络检测结果。

图2 识别框叠加效果(a) 单目标 (b) 多目标

IoU是目标检测算法中用来评价2个矩形框之间相似度的指标,IoU的值越大,说明预测结果与真实结果越接近,值越小说明预测结果越差。OIoU=2 个矩形框相交的面积/2个矩形框相并的面积,IoU定义如图3所示。

图3 IoU的定义

当神经网络输出的方框与红外掩膜方框有重叠时,计算两方框之间的IoU值,当OIoU 阈值时,判定该区域存在识别目标,并将神经网络识别框作为图像小块输入目标毁伤等级评估网络;当OIoU ≤阈值时,两个方框均舍弃。当只有红外掩膜方框而没有神经网络方框时,判定为地面红外干扰物体,舍弃;当只有神经网络方框而没有红外掩膜方框时,判定为神经网络误识目标,舍弃。多源信息融合与IoU判定流程如图4所示。

图4 多源信息融合与IoU判定

将识别出的红外与RGB图像小块输入IoU判定模块,由于RGB图像识别对比度好,所以最终输出符合判定条件的RGB图像小块:

![]()

(5)

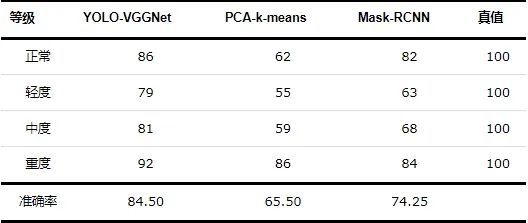

2 基于YOLO-VGGNet的毁伤等级评估

将经过多源信息融合与IoU判定的包含目标的RGB图像小块经过裁剪后输入VGG系列网络中进行毁伤等级的评估,由于不同目标的结构特性、毁伤特征有很大区别,因此,需针对不同目标设计相应的VGG毁伤评估模型,如图5所示。VGG_1、VGG_2、VGG_3、VGG_4分别评估坦克、雷达、补给车与军帐的毁伤等级。

图5 VGG毁伤等级评估

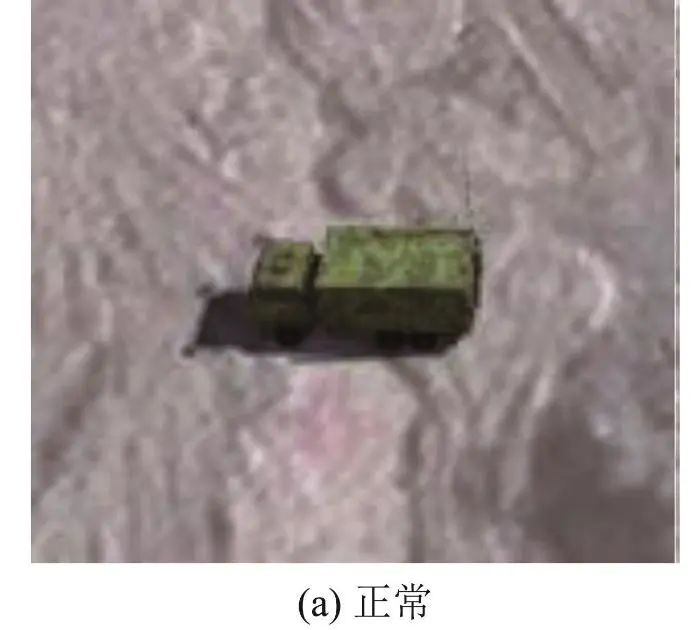

将目标的毁伤状态划分为4个等级:正常、轻度毁伤、中度毁伤、重度毁伤。正常是未受到打击的目标,轻度毁伤是受到打击后功能不受影响的目标,中度毁伤是受到打击后部分功能丧失的目标,重度毁伤是受到打击后功能完全丧失的目标。补给车的不同毁伤状态如图6所示。

图6 补给车不同毁伤状态

作为一个分类任务,VGG网络的损失函数仅包含分类误差:

(6)

式中:y' 为图像小块的真实标签;y 为VGG网络的预测值;

![]()

为预测类别与真实类别的误差;α 为VGG的损失网络;Cl 为网络的层数;ClHlWl 为第l 层特征图的大小。由于传统L2 损失函数与人眼感知到的特征并不匹配,而基于人眼感知的感知损失函数能够排除图像中无关的因素,如弹坑、浓烟,更好地提取符合人类视觉的目标特征,因此,采用基于人眼感知的损失函数代替L2 损失函数。VGG系列网络为

式中:

![]()

为相应网络的权重;Sm 为引入的红外毁伤权重。

考虑实际军事目标的保密性与隐蔽性, 可用于训练与测试的样本数量较少且难以获取,因此,采用基于迁移学习微调的训练方法,可以在训练数据集较少的情况下保证模型的准确性。微调法在训练过程中对中间卷积层参数进行微调,与冻结法相比(卷积层参数冻结不变,仅训练最后的全连接层),训练出的模型参数对识别目标更敏感,模型泛化性能更好。在仿真环境中针对不同类别目标,收集不同毁伤状态的军事目标图片,VGG-1、VGG-2、VGG-3和VGG-4均收集250张图片,200张作为训练集与验证集,50张作为测试集。基于VGG预训练模型,修改最后全连接层的输出为4,训练参数中,学习率为0.001,批处理大小为32,训练周期为20。

3 仿真实验结果与分析

由于当前国内对毁伤评估的研究尚未形成完整的体系,很少有针对地面移动目标毁伤评估的图像数据集。因此,本文基于Unity仿真图像进行实验。仿真平台分为服务器端与客户端,服务器端将弹群在仿真环境中实时感知的地面RGB图像与红外图像发送给客户端。客户端在接收到图像的同时,随即展开对地目标的识别与毁伤评估任务。

随机初始化弹群飞行轨迹,设计仿真环境与3D目标毁伤模型。为使仿真环境更加贴近真实世界并简化评估模型,除添加环境图像噪声、地面建筑、小车、大巴等自然干扰外,同时增添对抗性的神经网络欺骗目标(木质或充气的伪装目标,颜色纹理特征与军事目标相近)和弹坑、火花、浓烟等打击效果,测试所提算法对地目标识别与毁伤评估的有效性。

3.1 多源信息融合验证与分析

将红外图像与可见光图像进行融合并进行在线实时目标检测具有重要的军事应用价值,俄乌战争期间,乌克兰就用木质的目标吸引俄军高价值导弹;二战时期,盟军也用充气的坦克模型达到威慑纳粹的目的。本文在仿真环境中部署木质和欺骗性的军事装备,以此模拟敌方的干扰,仿真环境中的自然物与道路街道中的小车、大巴同样会对目标识别造成影响。

与单模态目标识别相比,通过将可见光图像与红外图像识别框叠加,并采用IoU判定进行信息融合的方法,可以综合不同模态图像信息提取的优势,排除地面小车、木质或充气伪装物,以及部分神经网络误识的影响,提升巡飞弹对地目标检测分类的有效性。

由于不同目标红外辐射强度不同,坦克、雷达与补给车红外辐射强度较大,而军帐与地面建筑辐射强度相近,采用强辐射与中等辐射进行分层检测。实验测试了5个弹群节点对地目标识别效果,如表1所示。

表1 巡飞弹对地目标识别结果

红外目标识别一栏表示每个节点检测到的强辐射与中等辐射的目标个数,强辐射主要针对车辆目标,中等辐射针对建筑与军帐。综合5组数据,信息融合之后的目标误识率较单模态可见光减少约18.7%。主要原因在于神经网络在面对木质或充气的伪装目标时误识的概率比较高,如图7(a)(d)所示,通过引入红外信息,排除部分无热源误识目标的影响,但仍存在既能欺骗神经网络又含有红外信息的干扰物,如图7(b)所示。

图7 部分实验测试结果

3.2 基于YOLO-VGGNet的毁伤等级评估

面向利用弹群对地面高防御移动目标协同作战的任务场景,基于弹载传感器自主对地面目标进行识别与毁伤评估,不仅能有效对目标进行杀伤,而且还能节省弹药,提升弹群整体的作战水平。本文在仿真环境中随机部署不同类型、不同毁伤等级的军事目标模型,为更加贴合真实巡飞弹打击效果,目标周围布置大小形状不同的弹坑、浓烟、火花,在不改变弹群飞行轨迹及运动参数的前提下,仅基于弹载传感器自主对地面目标的状态进行感知。

在基于多源信息融合得出目标的种类与位置信息之后,根据提出的YOLO-VGGNet方法对识别目标进行毁伤等级的评估。在YOLO v3对地面目标检测、分类、定位的基础上,采用传统基于图像变化检测的PCA-k-means方法和基于Mask-RCNN的两阶段毁伤评估方法对图像小块中的目标进行毁伤评估对比。

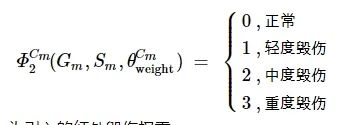

首先,采用传统基于图像变化检测的PCA-k-means方法进行测试。PCA方法将复杂的图像特征转化为少数具有代表的特征量,保留图像中重要的特征部分。k-means聚类使得各聚类本身尽可能紧密,而不同目标尽可能分开。该方法需要对打击前后的图像进行预处理,包括原始图像配准、裁剪目标所在的图像小块(每块图像小块统一大小为300像素×300像素)。然后,检测图像变化区域,得出图像变化区域占图像小块的比例。最后,根据该比例大小设置相应的目标毁伤等级。设置灰度分割阈值为120,超过该阈值认为该像素点发生了变化,反之未变化。根据变化的像素点个数占图像小块的比例划分毁伤等级:

(7)

PCA-k-means部分测试结果如图8所示。

图8 PCA-k-means评估效果

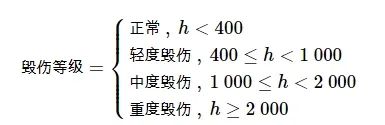

基于图像变化检测的传统方法专注于物理、像素空间,目标周围的浓烟、火花、弹坑均能对评估结果造成很大影响。但是,目标周围环境的变化与目标的毁伤等级并不是严格正相关的,部分变化因素对目标的毁伤状况关系不大,如浓烟、弹坑虽然变化区域较大,但对目标造成的实际影响有限;火花虽然变化区域较小,但对军帐却是致命的。我们同样对比了基于Mask-RCNN的两阶段卷积神经网络毁伤评估方法,实验结果如表2所示。

表2 毁伤等级评估结果 (%)

真值栏为该状态的总目标个数,YOLO-VGGNet栏、PCA-k-means栏和Mask-RCNN栏为该方法评估正确的目标个数。实验结果表明:基于YOLO-VGGNet的两阶段毁伤评估平均评估准确率较PCA-k-means和Mask-RCNN方法分别高19%和10.25%。

基于Mask-RCNN的两阶段卷积神经网络方法,可以充分利用卷积神经网络对图像目标深层次语义特征提取的优势,减少与目标毁伤状态无关因素的干扰,同时满足巡飞弹在线实时评估的需求。但由于不同目标的结构特征、功能特征和抗毁特性不同,单一的评估网络往往会混淆同一类型目标与不同类型目标之间的毁伤特征,例如,火花、浓烟对于军帐来说比较致命,但对于坦克没太大影响。还有一些关键部位的损伤对目标的功能影响也不同,雷达支架损坏与雷达天线损坏造成的影响不同,补给车轮廓变形与坦克装甲破损对自身影响也大不一样。

为避免网络训练过程中混淆同一类型目标或不同类型目标之间的毁伤特征,针对特定种类目标训练相应的毁伤评估模型十分必要。本文提出的基于YOLO-VGGNet的两阶段紧耦合毁伤评估方法,可以在YOLO对目标的检测、分类与定位的先验信息基础上,以图像小块的形式将每一目标单独进行裁剪,充分利用图像变化的尺度优势,减少评估区域,更好地提取评估对象的特征。同时引入毁伤红外特征并采用针对特定种类目标训练的模型进行毁伤评估,既能充分利用卷积神经网络高级语义特征提取的优势,有效排除战场浓烟、弹坑的影响,又能利用有限的毁伤红外特征,并避免单个评估网络混淆同一类型目标与不同类型目标的毁伤特征,从而取得更好的毁伤等级评估结果,如图9所示。

图9 YOLO-VGGNet评估效果

实际测试中,巡飞弹每秒接收15帧分辨率为720×540的可见光图像,YOLO v3将图像中识别出的目标小块存储在内存的缓冲区中,平均每帧图像处理耗时32 帧/s,VGG_1系列网络分别对内存中包含特定种类的图像小块进行并行的毁伤等级评估。在对VGG_1系列网络单独进行测试时,以300×300的图像小块为例,VGG_1系列网络平均处理速率为125 帧/s,满足巡飞弹对地移动目标在线检测与实时评估的要求。

本文在仿真实验验证的基础上,通过类激活映射方法可视化卷积过程中提取的权重信息,初步验证了提出的YOLO-VGGNet方法在真实军事图像的有效性,更多基于真实军事图像的毁伤评估有待进一步研究。

4 结论

本文采用红外与可见光信息融合方法研究基于视觉的巡飞弹对地典型移动目标的识别与毁伤评估,实现对地面目标的在线实时状态感知。研究主要贡献与创新点如下:

(1) 设计基于IoU判定的红外与可见光图像信息融合方法。对红外特征进行分层提取,并采用IoU判定与可见光信息进行融合,可以识别敌方木质或者充气的对抗性伪装目标欺骗,排除地面建筑、车辆等干扰目标对神经网络误识造成的影响,提升巡飞弹对地目标识别的有效性。同时将红外毁伤信息作为权重因子引入毁伤评估中。

(2) 设计了基于YOLO-VGGNet的在线实时对地移动目标识别与毁伤评估网络,并与传统基于图像变化检测和两阶段CNN的方法进行对比。实验结果表明:基于YOLO-VGGNet的两阶段巡飞弹对地目标毁伤评估方法,满足弹群任务在线实时的作战需求,能够充分利用CNN对目标语义信息提取的优势,不仅能够减少目标周围浓烟、弹坑的不利影响,而且可以有效利用有限的毁伤红外辐射并避免评估网络混淆同种类型目标与不同类型目标的毁伤特征。较传统基于图像变化检测的PCA-k-means方法与基于Mask-RCNN的两阶段评估方法具有明显优势,评估准确率分别提升19%和10.25%。

(3) 设计一套基于多源信息融合的弹群对地目标识别与毁伤评估仿真环境与典型军事目标3D毁伤模型,并基于Unity开展弹群对指定区域的侦察与目标状态感知任务,有利于进一步开展弹群对地目标的指挥决策研究。

本文就巡飞弹对地移动目标的识别与毁伤评估进行研究,相关工作有望显著提升弹群整体的作战性能。受限于仿真环境与真实图像的差别,虽然尽可能贴近真实场景,在仿真环境中加入了环境噪声、弹坑、火花等干扰,但离真实目标图像还有一定距离。接下来将进一步使用真实图像进行研究,验证评估算法的有效性。同时,当前的目标毁伤状态感知程度有限,无法精准判断目标的受损部位,下一步将尝试分离目标的关键功能性部件,实现巡飞弹对地目标的功能性毁伤评估。

声明:公众号转载的文章及图片出于非商业性的教育和科研目的供大家参考和探讨,并不意味着支持其观点或证实其内容的真实性。版权归原作者所有,如转载稿涉及版权等问题,请立即联系我们删除。

“人工智能技术与咨询” 发布

465

465

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?