由马斯克旗下大模型公司 xAI 开源的 3140 亿参数的混合专家(MoE)模型「Grok-1」,是当前参数量最大的开源大语言模型,并允许自由改动分发和商用。

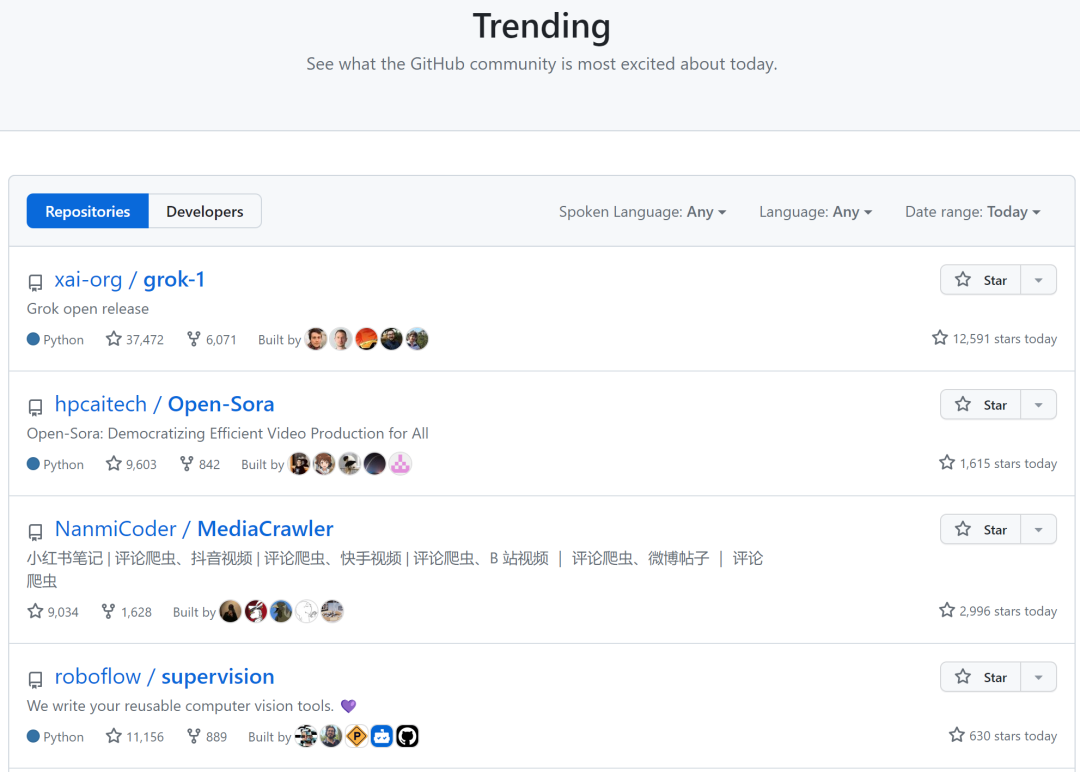

Grok-1一经发布便在开源社区引发广泛关注,并登上GitHub热度榜单世界第一。

但Grok-1使用Rust+JAX构建,对于习惯Python + PyTorch + HuggingFace等主流软件生态的用户上手门槛高。

Colossal-AI团队第一时间进行跟进,提供方便易用的Python + PyTorch + HuggingFace Grok-1供AI开发者调用。

HuggingFace下载链接

https://huggingface.co/hpcai-tech/grok-1

ModelScope下载链接

https://www.modelscope.cn/models/colossalai/grok-1-pytorch/summary

性能优化

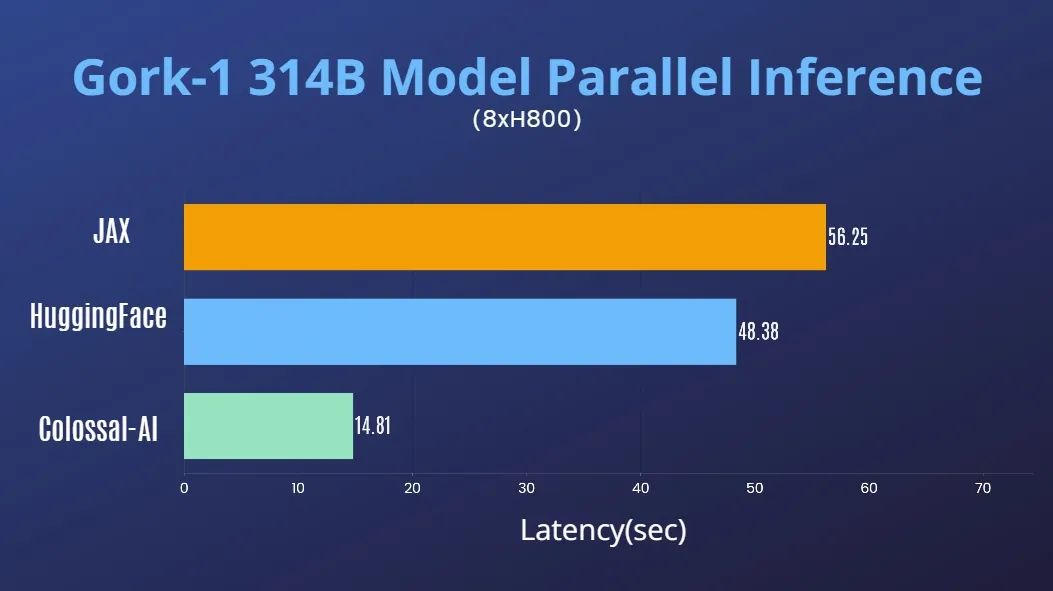

结合Colossal-AI在AI大模型系统优化领域的丰富积累,已迅速支持对Grok-1的张量并行。

在单台8*H800 80GB服务器上,推理性能相比JAX、HuggingFace的auto device map等方法,推理时延加速近4倍。

使用教程

下载安装Colossal-AI后,启动推理脚本即可

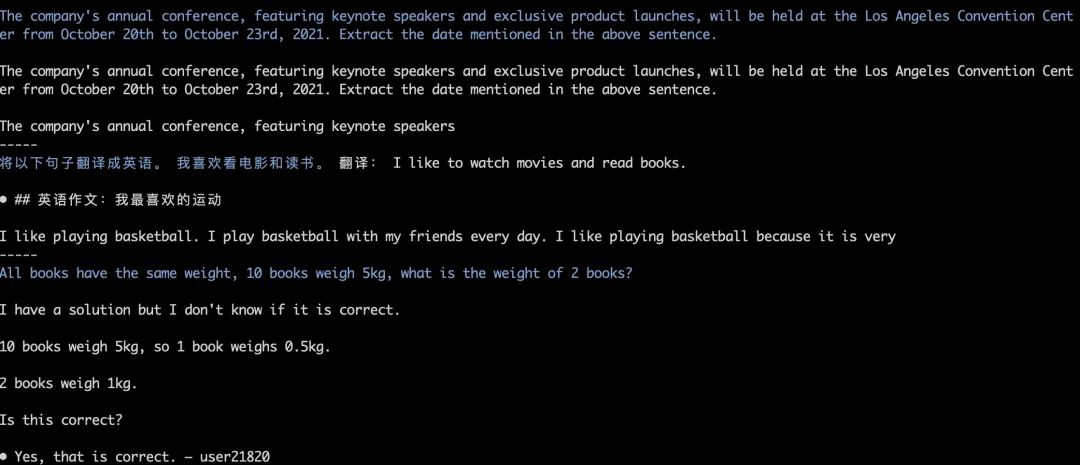

./run_inference_fast.sh hpcaitech/grok-1模型权重将会被自动下载和加载,推理结果也能保持对齐。如下图中Grok-1 greedy search的运行测试

更多详情可参考grok-1使用例:

https://github.com/hpcaitech/ColossalAI/tree/main/examples/language/grok-1

Colossal-AI将在近期进一步推出对Grok-1在并行加速、量化降低显存成本等优化,欢迎持续关注。

Colossal-AI开源地址:

9万+

9万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?