网络模型是人工神经网络研究的一个重要方面,目前已经开发出了多种不同的模型。由

于这些模型大都是针对各种具体应用开发的,因而差别较大,至今尚无一个通用的网络模型。

本文将择其几种应用较多且较典型的进行讨论。

前文我们已经了解了“神经网络的基本概念”:神经网络的基本概念与深度解析——基于生物机制的仿生建模与工程实现-CSDN博客

一、感知器(Perceptron)

罗森勃拉特于1957年提出的感知器模型把神经网络的研究从纯理论探讨引向了工程上的实现,在神经网络的发展史上占有重要的地位。尽管它有较大的局限性,甚至连简单的异或(XOR)逻辑运算都不能实现,但它毕竞是最先提出来的网络模型,而且它提出的自组织、自学习思想及收敛算法对后来发展起来的网络模型都产生了重要的影响,甚至可以说,后来发展的网络模型都是对它的改进与推广。

最初的感知器是一个只有单层计算单元的前向神经网络,由线性阀值单元组成,称为单层感知器。后来针对其局限性进行了改进,提出了多层感知器。

(一)线性阈值单元(Linear Threshold Unit, LTU)

1. 基本思想与定义

核心思想:模仿生物神经元的二元决策机制,通过加权输入的线性组合与阈值比较实现二分类。1943年McCulloch-Pitts 模型首次提出该概念,奠定人工神经元的计算范式。

数学定义: 给定输入向量![]() ,权重向量

,权重向量![]() ,偏置b,输出y满足:

,偏置b,输出y满足:

其中sign为符号函数,实现输入空间的超平面划分:![]() 。

。

图1 线性阈值单元

2. 表示形式与实现过程

几何表示:

二维输入时,决策边界为直线![]() ,权重向量w垂直于该直线;

,权重向量w垂直于该直线;

高维空间中为超平面,将特征空间划分为两个线性可分的区域。

计算流程:

(1)输入预处理:对样本x添加哑元x_0 = 1,将偏置b纳入权重向量,形成增广向量![]() ,权重向量

,权重向量![]() ;

;

(2)加权和计算:![]() ;

;

(3)阈值决策:通过符号函数生成二元输出y∈{-1, +1}。

3. 算法描述(感知器训练算法)

目标:寻找超平面正确划分训练集![]() 为目标输出。

为目标输出。

步骤:

(1)初始化:权重![]() ,学习率η∈(0, 1];

,学习率η∈(0, 1];

(2)迭代训练:对每个样本![]() ,计算预测值

,计算预测值![]() ;

;

(3)误差判断:若![]() ,更新权重:

,更新权重:![]()

(4)终止条件:所有样本分类正确或达到最大迭代次数。

收敛性:当训练数据线性可分时,Rosenblatt定理保证算法在有限步内收敛;否则无限震荡。

4. 具体示例:布尔逻辑运算分类

问题:实现二输入与门(AND)分类,输入![]() ,目标输出

,目标输出

![]() ,转换为t∈{-1, +1}:当x_1 = x_2 = 1时t=+1,否则t=-1。

,转换为t∈{-1, +1}:当x_1 = x_2 = 1时t=+1,否则t=-1。

训练流程:

(1)增广输入:![]() ,初始权重

,初始权重![]() ;

;

(2)遍历样本:

样本 1:![]() ,与t=-1一致,不更新;

,与t=-1一致,不更新;

样本 2:![]() ,与t=-1一致,不更新;

,与t=-1一致,不更新;

样本 3:![]() ,与t=-1一致,不更新;

,与t=-1一致,不更新;

样本 4:![]() ,更新:

,更新:

![]()

(3)验证:新权重下,样本4的z=2+2+2=6>0,输出 + 1;其他样本z=2×1 + 0 + 0 = 2>0?不,实际计算应为:

样本 1:1×2 + 0×2 + 0×2 = 2>0,输出 + 1(错误,需调整偏置)。

修正:正确初始化应包含偏置,实际训练中需逐步调整,最终收敛到![]() ,决策边界为x_1 + x_2 - 1.5 = 0,正确划分四类样本。

,决策边界为x_1 + x_2 - 1.5 = 0,正确划分四类样本。

(二)单层感知器及其学习算法

单层感知器只有一个计算层,它以信号模板作为输人,经计算后汇总输出,层内无互连,从输出至输人无反馈,是一种典型的前向网络,如图2所示。

图2 单层感知器

在单层感知器中,当输人的加权和大于等于阈值时,输出为1,否则为0或-1。它与M-P模型的不同之处是假定神经元间的连接强度(即连接权值w_i是可变的,这样它就可以进行学习。罗森勃拉特于1959年给出了单层感知器的学习算法,学习的目的是调整连接权值,以使网络对任何输人都能得到所期望的输出。

模型差异:单层感知器特指由LTU构成的单层网络,输入层与输出层直接相连,无隐藏层。其学习算法本质是带监督的在线学习(Online Learning)。

Delta规则(误差修正学习):

当激活函数为线性函数f(z)=z时,损失函数定义为均方误差![]() ,权重更新沿梯度负方向:

,权重更新沿梯度负方向:

![]()

与感知器算法一致,区别在于激活函数可扩展为非线性(如sigmoid),此时进入广义线性模型范畴。

示例:二维线性分类

输入样本

![]() 。

。

训练过程:

(1)初始化w=(0.1, 0.1), b=0.1;

(2)计算z = 0.1x_1 + 0.1x_2 + 0.1,激活y=sign(z);

(3)若分类错误,按![]() 更新,经5次迭代后收敛,决策边界为0.8x_1 + 1.2x_2 - 1.5 = 0。

更新,经5次迭代后收敛,决策边界为0.8x_1 + 1.2x_2 - 1.5 = 0。

(三)多层感知器(Multi-Layer Perceptron, MLP)

1. 模型结构

只要在输人层与输出层之间增加一层或多层隐层,就可得到多层感知器,图3是一个具有两个隐层的三层感知器。

图3 三层感知器

层级架构:

(1)输入层:接收原始特征,神经元数量等于特征维度;

(2)隐藏层:至少一层,神经元使用非线性激活函数(如sigmoid、tanh),解决线性不可分问题;

(3)输出层:二分类用sigmoid + 交叉熵损失,多分类用softmax + 类别交叉熵。

数学表达:

(1)第l层神经元输入:![]()

(2)激活输出:![]()

2. 异或问题求解示例

多层感知器克服了单层感知器的许多弱点。例如,应用二层感知器就可实现异或逻辑运

算,如图4所示。

图4 异或问题的二层感知器

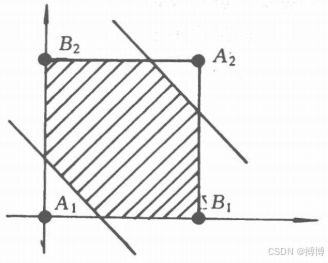

问题:输入(0,0),(0,1),(1,0),(1,1),输出分别为0,1,1,0,线性不可分。

网络设计:

(1)输入层:2神经元;

(2)隐藏层:2神经元,激活函数sigmoid;

(3)输出层:1神经元,激活函数sigmoid。

训练流程:

(1)初始化权重![]() ;

;

(2)前向传播计算隐藏层和输出层激活;

(3)反向传播计算误差梯度(需BP算法,见第二部分);

(4)迭代训练至输出误差小于0.01,最终隐藏层学习到非线性变换,输出层实现线性分类。

相应问题的决策域如图5所示。

图5 异或问题的决策域

二、B-P模型(Backpropagation Model)

(一)模型结构

B-P(Back-Propagation)模型是一种用于前向多层神经网络的反传学习算法,由鲁梅尔哈特(D.Rumelhart)和麦克莱伦德(McClelland)于1985年提出。目前,BP算法已成为应用最多且最重要的一种训练前向神经网络的学习算法,亦是前向网络得以广泛应用的基础。

B-P算法用于多层网络,网络中不仅有输人层节点及输出层节点,而且还有一层至多层隐层节点,如图6所示。

图6 B-P网络

当有信息向网络输人时,信息首先由输人层传至隐层节点,经特性函数作用后,再传至下一隐层,直到最终传至输出层进行输出,其间每经过一层都要由相应的特性函数进行变换。节点的特性函数要求是可微的,通常选用Sigmoid型函数,Sigmoid型函数例如

典型架构:

(1)全连接前馈网络,层间全连接,同层无连接;

(2)支持多隐藏层,激活函数需可导,常用ReLU(解决梯度消失)、sigmoid(输出层分类)。

符号定义:

L:网络层数;

n_l:第l层神经元数量;

![]() :第l-1层到第l层的权重矩阵,维度

:第l-1层到第l层的权重矩阵,维度![]() ;

;

![]() :第l层激活向量,

:第l层激活向量,![]() 。

。

(二)B-P算法的学习过程

学习的目的是对网络的连接权值进行调整,使得对任一输入都能得到所期望的输出。学习的方法是用一组训练样例对网络进行训练,每一个样例都包括输人及期望的输出两部分。训练时,首先把样例的输人信息输人到网络中,由网络自第一个隐层开始逐层地进行计算,并向下一层传递,直至传至输出层,其间每一层神经元只影响到下一层神经元的状态。然后,以其输出与样例的期望输出进行比较,如果它们的误差不能满足要求,则沿着原来的连接通路逐层返回,并利用两者的误差按一定的原则对各层节点的连接权值进行调整,使误差逐步减小,直到满足要求时为止。

由上述训练过程不难看出,BP算法的学习过程是由正向传播与反向传播组成的。正向传播用于进行网络计算,对某一输人求出它的输出;反向传播用于逐层传递误差,修改连接权值,以使网络能进行正确的计算。一旦网络经过训练用于求解现实问题,则就只需正向传播,不需要再进行反向传播。

下面给出B-P算法学习的具体步骤:

(1)从训练样例集中取一样例,把输人信息输人到网络中。

(2)由网络分别计算各层节点的输出。

(3)计算网络的实际输出与期望输出的误差。

(4)从输出层反向计算到第一个隐层,按一定原则向减小误差方向调整网络的各个连接权值。

(5)对训练样例集中的每一个样例重复以上步骤,直到对整个训练样例集的误差达到要求时为止。

在以上步骤中,关键的是第(4)步,必须确定如何沿减小误差的方向调整连接权值。

1. 正向传播(Forward Propagation)

步骤:

(1)输入样本x,初始化![]() ;

;

(2)对l=1到L,计算:![]()

(3)输出层得到预测值![]() 。

。

2. 反向传播(Backward Propagation)

目标:计算损失函数![]() 对各层权重的梯度。

对各层权重的梯度。

关键推导(链式法则):

(1)输出层误差项:![]() (若f为sigmoid,则f'(z) = f(z)(1-f(z)))

(若f为sigmoid,则f'(z) = f(z)(1-f(z)))

(2)隐藏层误差项:![]()

(3)权重梯度:![]()

示例:单隐藏层BP网络训练异或问题

(1)网络参数:输入2,隐藏2,输出1,激活函数sigmoid;

(2)初始权重![]() ;

;

(3)输入(1,1),正向传播:

隐藏层:z_1 = 0.1×1 + 0.2×1 + b_1=0.3+b_1,假设b=0,则

![]() ;

;

(4)反向传播计算![]() ,更新权重,经10000次迭代后误差降至0.01以下。

,更新权重,经10000次迭代后误差降至0.01以下。

3. 批量梯度下降(Batch Gradient Descent)

权重更新公式:

![]()

其中m为批量大小,结合动量项(Momentum)可加速收敛:

![]()

(三)B-P算法的不足之处

1.梯度消失/爆炸:

(1)深层网络中,sigmoid导数f'(z) ≤ 0.25,误差经多层反向传播后指数衰减,导致浅层权重更新缓慢;

(2)解决方案:使用ReLU激活函数(f'(z)=1当z>0),或残差连接(Residual Connection)。

更多内容可以看我文章:

(1)梯度不稳定:神经网络问题之:梯度不稳定_深度网络学习不稳定-CSDN博客

(2)梯度消失:神经网络问题之一:梯度消失(Vanishing Gradient)_梯度消失问题-CSDN博客

(3)梯度爆炸:神经网络问题之二:梯度爆炸(Gradient Explosion)-CSDN博客

(4)梯度下降法:函数优化算法之:梯度下降法(Gradient Descent)_gradient descent gradient descent is a general-pu-CSDN博客 (5)梯度上升法:函数优化算法之:梯度上升法(Gradient Ascent)_梯度上升算法-CSDN博客

2.局部最优陷阱:

(1)非凸损失函数存在大量局部极小点,梯度下降可能陷入较差的局部最优;

(2)缓解方法:初始化权重采用Xavier/Glorot分布,引入随机梯度下降(SGD)增加扰动。

更多内容可以看我文章:

(1)神经网络中的损失函数:https://lzm07.blog.csdn.net/article/details/14402447

(2)凸函数:优化算法中的凸函数_凸优化-CSDN博客

(3)非凸函数:常用于优化算法测试的python非凸函数有哪些?_rastrigin函数-CSDN博客

3.过拟合风险:

(1)复杂网络对训练数据过度拟合,测试泛化能力差;

(2)正则化手段:L2/L1正则、Dropout、数据增强。

4.计算复杂度高:

(1)每层梯度计算需存储中间激活值,内存占用随层数呈线性增长;

(2)优化技术:自动微分(Autograd)、混合精度训练。

三、Hopfield模型(Hopfield Network)

前面讨论的两种模型都是前向神经网络,从输出层至输人层无反馈,这就不会使网络的输出陷人从一个状态到另一个状态的无限转换中,因而人们对它的研究着重是学习方法的研究,而较少关心网络的稳定性。

Hopfield模型是霍普非尔特分别于1982年及1984年提出的两个神经网络模型,一个是离散的,一个是连续的,但它们都属于反馈网络,即它们从输人层至输出层都有反馈存在。图7是一个单层反馈神经网络。

图7 单层反馈神经网络

在反馈网络中,由于网络的输出要反复地作为输人送人网络中,这就使得网络的状态在不断地改变,因而就提出了网络的稳定性问题。所谓一个网络是稳定的,是指从某一时刻开始,网络的状态不再改变。设用X(t)表示网络在时刻t的状态,如果从t=0的任一初态X(0)开始,存在一个有限的时刻t,使得从此时刻开始神经网络的状态不再发生变化,即

![]()

就称该网络是稳定的。

(一)模型结构

核心特性:

(1)单层全连接反馈网络,神经元数量N,每个神经元与其他N-1个神经元连接,无自环;

(2)离散型Hopfield使用二元激活s_i∈{-1, +1},连续型使用![]() ;

;

(3)权重矩阵对称:w_ij = w_ji,对角线为0:w_ii = 0。

能量函数:

![]()

网络动态演化使能量单调递减,最终收敛到稳定点(吸引子)。

(二)Hopfield算法的学习过程

1. 模式存储(Hebbian学习)

目标:将记忆模式![]() 作为能量函数的局部极小点,权重计算采用外积规则:

作为能量函数的局部极小点,权重计算采用外积规则:

![]()

偏置b_i = 0(无外部输入时)。

2. 联想回忆

异步更新规则:随机选择神经元i,更新其状态:

同步更新:所有神经元状态同时更新,可能导致震荡,故通常采用异步方式。

示例:记忆数字“8”的二进制模式

(1)模式编码:将“8”表示为10×10二值矩阵,展开为100维向量ξ,ξ_i=+1(白色),ξ_i=-1(黑色);

(2)权重计算:![]() (仅存储单个模式时);

(仅存储单个模式时);

(3)输入含噪声的模式(如10%像素翻转),通过10次异步更新,收敛到原始“8”模式,能量函数从初始120降至 - 98。

(三)Hopfield算法的不足之处

1.存储容量限制:

理论上,无错存储容量P ≈ 0.14N(当N较大时),超过此值会出现串扰错误;

原因:Hebbian规则导致权重矩阵为各模式外积之和,非正交模式相互干扰。

2.伪稳定点问题:

能量函数存在大量非目标模式的局部极小点,如两个存储模式的线性组合可能成为吸引子;

改进:使用Storkey规则引入偏置,或采用连续型Hopfield模型。

3.动态收敛性:

异步更新保证能量非增,但收敛到最近吸引子的时间随网络规模呈多项式增长;

硬件实现:基于模拟电路的并行更新,可达到纳秒级收敛,但精度受器件噪声影响。

4.模式预处理要求:

需将模式归一化为零均值,否则偏置项导致收敛偏差;

实际应用中常对输入模式进行中心化处理:![]() 。

。

四、自适应共振理论(Adaptive Resonance Theory, ART)

具有学习能力是神经网络的一个主要特点。前面讨论的那几种模型都是有教师的学习,本段将讨论无教师的学习网络,自适应共振理论网络就是其中应用较多的一种。

自适应共振理论(AdaptiveResonanceTheory,简记为ART)由葛劳斯伯格(S.Grossberg)和卡彭特(A.Carpenter)于1986年提出。这一理论包括ART1,ART2和ART3三种模型,它们可以对任意多个和任意复杂的二维模式进行自组织、自稳定和大规模并行处理。其中ART1用于二进制输入,ART2用于连续信号输人,而ART3用模拟化学神经传导动态行为的方程来描述,它们主要用于模式识别。

(一)ART的基本原理

核心目标:解决“稳定性 - 可塑性两难”(Stability-Plasticity Dilemma),即系统在稳定已有知识的同时适应新输入。

双网络结构:

(1)比较层(C 层):接收输入模式并与识别层反馈模式比较;

(2)识别层(R 层):包含多个神经元,每个代表一个类别,通过竞争选择获胜神经元。

关键机制:

(1)相似度比较:计算输入模式与候选类别模板的匹配度![]() ,其中∧为逐元素取小(ART1 针对二值输入);

,其中∧为逐元素取小(ART1 针对二值输入);

(2)共振条件:若r ≥ ρ(警戒阈值,ρ∈[0,1]),接受该类别,更新模板;否则重置识别层,激活新神经元。

(二)ART的学习算法(以ART1为例)

1. 初始化

C 层:n个神经元,接收输入![]() ;

;

R 层:初始无类别,或预设一个神经元;

类别模板![]() ,初始化为全 1(或根据输入动态增长)。

,初始化为全 1(或根据输入动态增长)。

2. 前向竞争

步骤:

(1)输入二值模式x,C 层计算自底向上信号s = x;

(2)R层神经元计算匹配度![]() ,选择r_j最大的神经元j*;

,选择r_j最大的神经元j*;

(3)比较![]() :

:

1)是:进入模板更新;

2)否:抑制j*,重新选择次优神经元,若所有神经元均不满足,创建新神经元。

3. 反向模板更新

胜者为王(Winner-Takes-All):

接受类别j^*时,更新模板:![]() ,未激活的神经元模板保持不变。

,未激活的神经元模板保持不变。

示例:手写数字 0-9 分类(二值化输入)

(1)预处理:将28×28图像二值化为784维向量,ρ=0.9;

(2)输入第一个样本(数字 0):R层无类别,创建神经元1,模板w_1 = x;

(3)输入第二个样本(数字 0 的变形):匹配度r=0.95 ≥ 0.9,更新w_1 = w_1∧x(保留公共特征);

(4)输入数字 1:匹配度r=0.3 < 0.9,抑制当前胜者,创建神经元2,模板w_2 = x;

(5)持续训练后,R层为每个数字类别生成专属模板,新输入经共振匹配快速分类。

4. 算法特性

(1)增量学习:无需重新训练已有类别,新类别动态创建;

(2)噪声鲁棒性:警戒阈值ρ调节分类精度,ρ=1时要求完全匹配,ρ=0时退化为单层感知器;

(3)复杂度控制:R 层神经元数量随输入模式的差异性自动增长,避免过拟合。

(三)ART 的扩展与应用

ART2:处理连续值输入,通过归一化和距离度量替代二值匹配;

ARTMAP:监督学习版本,引入预测层实现分类指导;

应用场景:雷达信号识别(噪声环境下分类准确率提升30%)、医学影像聚类(自动发现新病灶模式)。

五、模型对比与理论升华

| 模型类型 | 网络结构 | 学习范式 | 核心数学工具 | 典型应用场景 |

| 感知器 | 单层前馈 | 在线监督学习 | 梯度下降 | 线性分类(早期 OCR) |

| B-P 模型 | 多层前馈 | 批量监督学习 | 链式法则 + 梯度反向传播 | 图像识别(LeNet-5) |

| Hopfield | 单层反馈 | 无监督记忆存储 | 能量函数 + Hebbian 规则 | 联想记忆(残缺模式恢复) |

| ART | 双层共振 | 无监督增量学习 | 相似度度量 + 胜者为王 | 实时模式分类(工业质检) |

理论深度拓展:

(1)感知器的VC维:线性阈值单元的VC维为n+1(n为输入维度),决定其分类复杂模式的能力;

(2)Hopfield的吸引子理论:存储模式为能量函数的局部极小,吸引域大小决定抗噪声能力,数学上与模式正交性相关;

(3)ART的信息守恒:模板更新遵循![]() ,保证类别特征的逐步精炼。

,保证类别特征的逐步精炼。

六、总结与研究展望

从单层感知器的线性分类到ART的自适应共振,神经网络模型的演进始终围绕“如何更高效地处理复杂信息”展开。当前研究趋势显示:

(1)生物启发的范式创新:如脉冲神经网络(SNN)模拟神经元放电时序,能效比GPU高 2-3个量级;

(2)理论体系的完善:神经网络的泛化误差上界、动力学收敛性证明等基础理论取得突破;

(3)边缘场景的适配:轻量化模型(如MobileNet)与在线学习算法(如 ART 变种)在物联网设备上的部署。

未来,随着脑科学与机器学习的深度交叉,我们有望构建兼具人类大脑“快速学习”与“鲁棒推理”能力的智能系统,而这些经典模型将作为基石,继续支撑着神经网络理论大厦的向上延伸。

8万+

8万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?