InfiAgent-DABench: Evaluating Agents on Data Analysis Tasks

论文的主要内容和贡献

- 引入InfiAgent-DABench基准:这是首个专门评估基于大语言模型(LLM)的代理在数据分析任务中表现的基准。

- DAEval数据集:基准包含一个名为DAEval的数据集,其中有257个数据分析问题,这些问题是从52个CSV文件中衍生出来的。

- 代理框架:论文介绍了一个代理框架,该框架结合了LLM,用于执行数据分析任务和进行评估。

- 格式提示技术:由于数据分析问题通常是开放式的,难以自动评估,作者采用了格式提示技术,将每个问题转换为封闭格式,以便自动评估。

- 广泛的基准测试:论文对34个LLM进行了广泛的基准测试,揭示了当前在数据分析任务中遇到的挑战。

- 开发DAAgent:基于他们的代理框架,作者开发了一个专门的代理,名为DAAgent,其在DABench上的表现超过了GPT-3.5,提升了3.9%。

- 资源发布:InfiAgent-DABench的评估数据集和工具包已在GitHub上发布,供其他研究人员使用。

目录

C. InfiAgent-DABench与Qwen-Agent代码解释器基准的比较

P. InfiAgent-DABench: 数据分析任务中的评估代理

C. InfiAgent-DABench与Qwen-Agent代码解释器基准的比较

P. InfiAgent-DABench: 数据分析任务中的评估代理

1. 引言

- 背景和动机:

- 基于大语言模型(LLM)的代理在人工智能领域非常受欢迎,被认为是通用人工智能(AGI)的原型。这些代理具备推理、规划、记忆和使用工具的能力。

- 大量的LLM代理已经被开发出来,例如AutoGPT、BabyAGI和AgentGPT。

- 数据分析任务被发现对LLM代理来说具有挑战性但非常实用。

- 数据分析的重要性:

- 数据分析是一个系统的过程,涉及检查、清洗、转换和建模数据,以发现有用信息、得出结论并支持决策。它应用于商业智能、医疗保健、金融和科学研究等多个领域。

- LLM代理在数据分析中的应用:

- 一个典型的数据分析问题需要解决者与数据文件和代码执行器交互来获得解决方案,这需要LLM在自然语言和代码方面的协调能力。

- OpenAI的高级数据分析(ADA)是第一个有效帮助用户分析数据文件并执行编程代码的商业LLM代理。许多开发者在此基础上也制定了开源的数据分析代理。

- 现有问题和研究动机:

- 尽管有很多用于代码完成任务的基准,例如HumanEval、MBPP和DS-1000,但它们大多不适用于评估需要复杂能力(如规划、自我调试)的LLM代理。

- 因此,作者提出了InfiAgent-DABench,这是首个用于评估数据分析任务中代理的基准。

- InfiAgent-DABench的构建:

- 该基准包含257个与52个CSV文件相关的问题,涵盖现实的数据分析需求和广泛的领域。

- 作者从GitHub抓取CSV文件,并指示GPT-4根据文件和数据分析的关键概念生成开放性问题。

- 通过格式提示技术生成包含详细约束和格式要求的问题,以便自动评估。

- 数据集经过多维度的人类专家严格评估,不合格样本被过滤。

- 评估和结果:

- 作者构建了一个代理框架来支持LLM执行数据分析任务,评估了34个最先进的LLM,发现它们在处理数据分析任务时面临挑战。

- 为了促进开源LLM的数据分析能力,作者开发了一个名为DAInstruct的指令调整数据集,并在此基础上进一步开发了专注于数据分析的DAAgent。最大模型DAAgent-34B在数据分析任务上的表现比GPT-3.5提高了3.9%。

- 主要贡献:

- 提出了InfiAgent-DABench,这是首个用于评估数据分析任务中代理的基准。

- 基准测试了34个LLM,发现即使是最先进的LLM在处理数据分析任务时仍然面临挑战。

- 提出了一个用于数据分析任务的指令调整数据集DAInstruct,并开发了开源数据分析代理DAAgent,其在数据分析任务上的表现比GPT-3.5提高了3.9%。

这篇论文第二部分介绍了InfiAgent-DABench基准,用于评估基于LLM的代理在数据分析任务上的性能。具体来说,基准测试包括两个主要组件:DAEval评估数据集和代理框架。以下是详细内容:

2. InfiAgent-DABench基准

InfiAgent-DABench是一个评估基于LLM的代理在数据分析任务上的性能的基准。它包含两个主要组件:

- DAEval评估数据集:用于评估数据分析封闭问题的数据集。

- 代理框架:允许LLM在代理设置中解决数据分析问题。

2.1 数据集建设

- 文件集合:

- 从GitHub收集现实世界的CSV文件。

- 选择标准包括:有意义的场景、语言主要为英语、列数大于5、最小行数为20。

- 描述生成:

- 利用GPT-3.5总结每个CSV文件的列名和内容描述、数据类型、缺失值等信息。

- 概念确定:

- 通过专家访谈确定数据分析中的关键概念,确保数据集与现实需求一致。

- 开放式问题生成:

- 利用GPT-4根据文件描述和预定义概念生成开放式问题,确保问题涉及多个概念且没有重复。

- 约束条件和格式化需求的生成:

- 通过格式提示技术将开放式问题转换为封闭形式的问题,以便于自动评估。

- 响应收集:

- 利用OpenAI ADA生成封闭问题的答案,只有在多次尝试中生成一致答案时才保留。

2.2 代理框架

- 建立了一个代理框架,支持LLM进行数据分析任务,包括推理、与文件交互和调用Python代码等功能。

2.3 人工评估

为了确保数据集质量,进行了深入的人工评估。邀请专家对数据集进行评估,并与GPT-4生成的问题进行比较。

- 评估指标:

- 适宜性:CSV文件是否适合数据分析。

- 合理性:问题、约束和格式要求是否自然合理。

- 价值:问题在实际应用中的价值。

- 限制:约束是否足够严格以确保答案唯一性。

- 对齐情况:问题与数据文件的对齐情况。

- 正确性:问题的标签是否正确。

- 数据集质量:

- 邀请人类专家评估生成的数据集,删除不合格的样本。

- 结果显示,85%的样本是合格的,证明了数据集构建方法的有效性。

- 人与GPT-4比较:

- 专家编写数据分析问题,并对生成的问题进行评分。

- 比较人工和GPT-4生成的问题的难度,计算胜率反映问题的相对难度。

人工制作和GPT-4生成的问题之间的比较 结果。我们发现GPT4生成的问题利用了限制性、对齐和 难度,并且在合理性和价值方面的表现略好,这表明 DAEval与人工数据集具有可比性。

文件所在域的分布。为简洁起见,我们使用每个类别的第一个单词作为标签。

2.4 基准统计

在本节中,我们提供了DAEval的统计数据。我们将数据集分为验证集和测试集。验证集是公开的,包括257个问题和52个CSV文件,剩下的部分用于测试集以避免数据泄露。所有后续信息均基于验证集。

基本统计

表3列出了文件和问题的基本统计信息,包括文件数量、问题数量、子问题数量等。

文件的领域

图3展示了文件分布的不同领域。我们借助GPT-3.5将文件聚类为9个领域。结果显示,我们的数据集涵盖了广泛的领域。有关领域和相应描述的详细信息列在附录G中。

问题的概念

图4展示了问题涉及的不同概念的分布。表4显示了基于涉及概念数量的问题分布。数据显示,大多数问题涉及1或2个概念。这是合理的,因为在一个问题中涉及很多概念的情况并不常见。

问题的难度

我们利用GPT-4对DAEval中的问题难度进行了定量评估。问题被分为三个级别:简单、中等和困难。表4展示了这些难度级别在不同概念和每个问题的概念数量中的分布。定量评估的详细方法描述在附录K中。这表明DAEval中的问题难度范围广泛,确保了全面的评估。

2.5 指令调整数据集

在本节中,我们介绍DAInstruct,一个用于数据分析的指令调优数据集,我们在其上训练DAAgent,一个用于数据分析的专门代理。对DAInstruct的收集分三步进行:为CSV文件创建一组不同的数据分析问题通过我们的代理框架收集这些问题的响应轨迹。使用规则和GPT-4过滤低质量样本。结构的统计信息见附录l。另外,在附录O中提供了对DAInstruct的一个案例研究。

以下部分将详细介绍这些步骤。

问题生成。我们使用GPT-4生成一组与数据分析相关的关键字。然后,这些关键词经过人工筛选过程,以确保相关性和准确性。然后,提示GPT-4类似DAEval中的文件描述,以及以上关键字,为每个CSV文件生成问题。关键字和提示符见附录M。

响应收集。在这一步中,我们利用代理框架以ReAct (Yao et al, 2023)的方式生成响应。它是解决问题步骤的迭代,其中GPT-4以会话形式与代码执行环境进行交互。该过程包括推理、代码编写、执行和基于所获得的结果的迭代细化。详情见附录N。

过滤。此步骤涉及使用规则和GPT4进行过滤。采用特定的规则来识别和消除具有幻觉和不完全解的数据。然后,使用GPT-4对数据进行过滤。该标准包括五个方面:Python代码的相关性、对系统通知的解释、简洁性、对Python沙箱环境的理解以及解决方案的提供。所有提示都可以在附录M中找到。

A. 限制与未来工作

我们基准测试的一个显著限制是未包括与数据可视化相关的问题。在专家访谈中,我们认识到可视化在数据分析中的重要作用。然而,设计封闭式的可视化问题非常具有挑战性,因为结果通常是图像而不是文本。为了进行评估,有两种潜在的方法:

- 评估代码正确性:这种方法允许在评估中使用仅限文本的LLM。虽然可以利用现有的LLM,但这种方法可能导致不准确。在数据分析任务中,主要目标是生成准确的视觉表示,而不仅仅是底层代码。在某些情况下,仅从代码进行评估可能难以实现精确的评估。

- 使用多模态模型进行评估:Bai等人(2023)利用像GPT-4(Vision)(OpenAI,2023b)这样的视觉语言模型作为评估者。这种方法直接评估视觉输出的准确性。尽管该方法在评估最终产品方面具有优势,但当前的多模态模型性能欠佳且成本高昂,导致对数据可视化的评估效果不佳。

上述两种方法均无法达到封闭式评估的准确性和便利性。我们将数据分析中的可视化精确评估作为未来研究的方向。

B. 详细相关工作

B.1 代码LLMs

代码LLM是专门用于理解和生成编程代码的大型语言模型。这些LLM在过去几年中发展迅速(Zan等,2023;Zhang等,2023b)。Codex(Chen等,2021)是其中最著名的模型之一,由OpenAI提供商业API。同时,研究人员开发了大量开源代码LLM,例如Code Llama(Roziere等,2023)、WizardCoder(Luo等,2023)、XwinCoder(Team,2023c)和DeepSeek Coder(DeepSeek,2023)。

B.2 代码基准测试

近年来,提出了各种不同任务的基准测试来评估代码模型。CodeXGLUE(Lu等,2021)是一个综合基准,涵盖代码理解和生成的任务。此外,一些基准测试专注于代码生成,尤其是在竞赛级别(Chen等,2021;Austin等,2021;Hendrycks等,2021;Li等,2022)。DS-1000(Lai等,2023)是一个用于数据科学代码生成的基准。Bai等(2023)创建了一个包含数学、数据可视化和其他通用任务的数据集,以评估LLM使用Python代码解释器的能力。在附录C中,我们对InfiAgent-DABench和这项工作进行了更详细的比较。

C. InfiAgent-DABench与Qwen-Agent代码解释器基准的比较

InfiAgent-DABench与Qwen-Agent(Bai等,2023)代码解释器基准之间有两个主要区别:

- 我们在数据分析任务中基准测试LLM,涵盖一系列概念,而Bai等(2023)仅包含少量数据分析问题,主要集中在数据可视化及其其他通用任务上。

- 我们的基准采用封闭式评估正确性,不依赖任何外部模型作为评估者。更重要的是,Bai等(2023)利用当前的多模态模型评估数学和数据可视化问题的代码正确性,但对于其通用任务仅评估代码可执行性。

D. 在InfiAgent-DABench上的性能

表6展示了不同模型在InfiAgent-DABench中的准确率。图7则通过雷达图展示了涉及不同概念问题的性能。

E. DAEval构建的提示

在本节中,我们列出了问题生成过程中使用的所有提示。

E.1 描述生成

表7展示了描述生成的提示。

E.2 问题生成

表8展示了问题生成的提示。我们以如下方式提示GPT-4:

- 生成三个仅包含一个概念的简单问题。

- 生成三个涉及一个或多个概念的复杂问题。

- 生成三个涉及多个概念的更复杂问题。

E.3 约束和格式要求生成

表9展示了约束和格式要求生成的提示。

F. 关键概念的详细信息

表10展示了数据分析中的关键概念及其相应解释,这些解释是通过专家访谈获得的。我们使用GPT-3.5帮助我们总结访谈记录。由于某些原因,我们无法直接公开这些记录。

G. 领域的详细信息

我们在GPT-3.5的帮助下将CSV文件聚类成9个领域。表11展示了领域的名称及其相应解释。

H. 试验的详细信息

我们随机抽取了119个问题及其对应的答案,涉及GPT-4、GPT-3.5和DAAgent-34B,并要求人类专家和GPT-4基于相同的标准进行评估。每个答案根据解决问题的程度进行评分:0:没有解决问题或几乎没有解决,1:部分解决问题,2:大部分解决问题且仅有小错误,3:完全准确地解决问题。表12展示了人类专家与GPT-4的一致率。我们发现,当GPT-4作为数据分析任务的评估者时,其与人类专家的一致率约为67%,显然不能作为基准的满意评估者。

以下是关于 InfiAgent-DABench 项目在数据分析任务中评估智能体的研究内容的中文概要:

I.生成问题的扩展案例研究

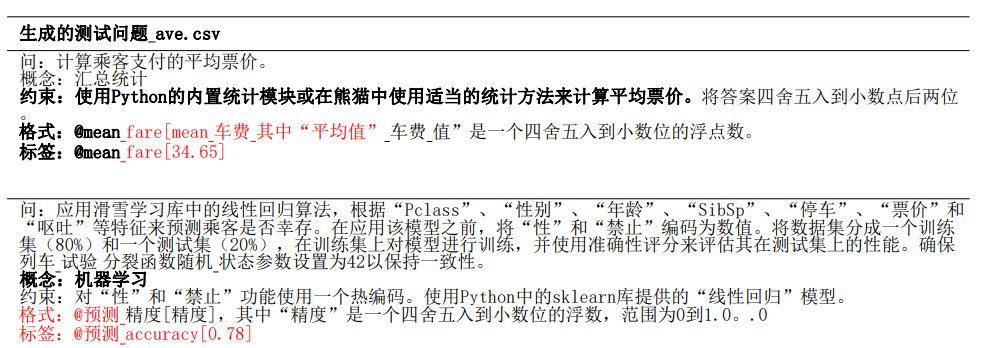

表13展示了为test ave.csv文件生成的几个问题。这份文件细致地记录了泰坦尼克号上乘客的个人信息和旅行细节,包括他们的生存状态、舱位、姓名、性别、年龄和登船地点等方面。

根据特定的问题和约束,生成的问题包括一个或多个子问题。

J. 问卷和坏案例分析

J.1. 对匿名问题

从人类和 GPT-4 生成的问题中随机抽取了 216 对匿名问题(108 对为单一概念问题,108 对为多概念问题)。单一概念问题只与其他单一概念问题进行比较,多概念问题同理。表 15 显示了专家的问卷内容。: 从人类和 GPT-4 生成的问题中随机抽取了 216 对匿名问题(其中 108 对为单一概念问题,108 对为多概念问题)。单一概念问题只与其他单一概念问题进行比较,多概念问题同理。表 15 显示了专家的问卷内容。

J.2. 坏案例分析

表 16 展示了人类评估中发现的两个坏案例。

-

- 案例一: 发现 2019-08 edges.csv 文件中的 "Type" 列所有值都相同,因此使用随机森林分类器进行预测是没有意义的,这不符合我们的对齐标准。

- 案例二: 问题提到“给定的日期”,但在后续约束中没有提供具体日期,因此不符合我们的限制性标准。

J.3. 人类与 GPT-4 的比较设置

- 专家参与: 邀请了 3 位具有数据分析技能的专家为 9 个 CSV 文件编写了 54 个问题。每个文件有 3 个单一概念问题和 3 个多概念问题。

- 数据集: 将人类专家和 GPT-4 针对同一文件生成的问题结合,形成了一个包含 102 个问题的数据集用于评估。另外,为了评估难度,我们随机抽取了 216 对人类生成和 GPT-4 生成的问题对。所有问题在这个阶段对专家都是匿名的。

K. 评估难度的方法

- 难度评估: 随机抽取了 80 组,每组包含 5 个问题。

- 排名: GPT-4 根据数据处理复杂性、领域特定知识和编码复杂度对每组问题进行难度排名。每组重复排名 100 次以确保结果的稳健性。每个问题根据其排名获得分数,最具挑战性的问题得 5 分,最不具挑战性的问题得 0 分。然后计算每个问题的平均分数,得出数值难度排名。根据这些排名,问题被分为三种难度等级:简单(0 到 1.667 分)、中等(1.667 到 3.335 分)和困难(3.335 到 5 分)。

L. DAInstruct 统计数据

- 数据样本: DAInstruct 包含 5131 个数据样本,涉及 631 个 CSV 文件,ReAct 对话的平均长度为 5.18。

M. DAInstruct 生成提示

- 问题生成: 表 17 列出了用于生成问题的关键词和提示语。

- 过滤: 表 18 列出了用于过滤的提示语。

- 内容审核: 表 19 列出了用于内容审核的提示语。

N. 指令微调数据收集

- 数据收集方法: 在数据收集方法中,GPT-4 与我们的智能体框架进行迭代问题解决对话。对话从提供 CSV 文件和相关问题开始,GPT-4 处理这些信息并提出代码解决方案,然后执行这些代码。执行结果反馈到对话中,使 GPT-4 能够完善其响应并提出进一步的迭代。此循环持续进行,直到 GPT-4 确定累积的信息足以最终回答问题。一个关键方面是提示语的设计,它引导 GPT-4 的输出朝向有效的问题解决。表 20 列出了过程中使用的提示语。为了应对幻觉(GPT-4 可能生成虚构结果)的挑战,提示语中明确指示禁止 GPT-4 执行代码。

O. DAInstruct 案例研究

- 案例研究: 表 21 展示了 DAInstruct 的一个案例研究,突出了 GPT-4 与用户之间的对话,用户提出问题并执行生成的代码。这种迭代对话持续进行,直到 GPT-4 得出结论性解决方案。

P. InfiAgent-DABench: 数据分析任务中的评估代理

P.1 评估提示

表22展示了评估使用的标准提示模板。此外,我们对Abab5.5-Chat的标准模板进行了略微修改,以使其输出符合代理框架的格式要求。具体地,我们添加了以下提示:“注意,在给出最终答案之前,您必须输出字符串‘I now know the final answer’。”

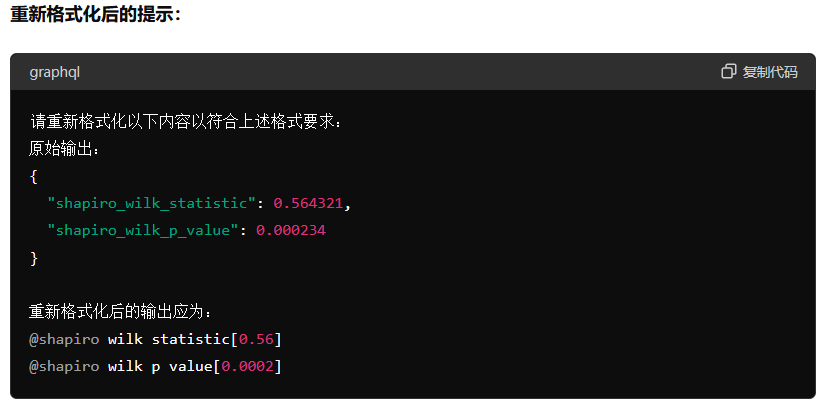

Q. 重新格式化的详细信息

本节中,我们通过消融研究展示了在模型原始响应之后添加重新格式化步骤的必要性,因为大多数模型在严格遵守格式要求方面存在困难,而格式要求对于闭合式评估至关重要。此外,我们还进行了手动检查,以确保此重新格式化步骤不会因引入外部错误而影响评估结果。我们使用gpt-3.5-turbo-16k-0613进行重新格式化。重新格式化的提示在附录Q.3中。

Q.1 消融研究

我们添加了一个额外的重新格式化步骤,使用GPT-3.5将原始响应转换为所需格式。我们在两种设置下进行了消融研究:

- 无重新格式化:直接在一个阶段用问题、约束和格式要求提示模型。

- 有重新格式化:首先用问题和约束提示模型,然后使用GPT-3.5重新格式化原始响应,模型包括GPT-4、Qwen-72B-Chat、Qwen-14B-Chat和Mixtral-7B-Instruct-v0.2。

表23显示了结果,即使是最强大的模型如GPT-4,如果不进行重新格式化,性能也下降约6%,而较弱的模型如Mistral-7B的性能下降最多可达32%,这表明在评估中添加重新格式化步骤的必要性。

Q.2 手动检查

我们随机抽取了50个问题及其对应的模型原始响应以及经过重新格式化步骤处理的响应,手动检查此步骤是否会为评估引入额外错误。我们发现GPT-3.5能够在所有样本中将响应重新格式化为所需格式,这意味着此额外步骤通常不会影响结果。

Q.3 重新格式化的提示

image-20240701152255584

image-20240701152316307

表24展示了在重新格式化步骤中使用的提示。

3.实验

3.1 设置

3.1.1 模型

我们将基准测试的模型分为四组:专有模型、开源通用LLM、开源代码LLM和代理框架。

- 专有模型:此组包括作为商业服务提供的LLM,提供API访问以便集成到各种应用程序中。我们对以下模型进行了基准测试:OpenAI GPT-4 (OpenAI, 2023b)、GPT-3.5 (OpenAI, 2023a)、Claude-2.1 (Anthropic, 2023)、Abab5.5 (MiniMax, 2023) 和 Gemini-Pro (Team et al., 2023)。

- 开源通用LLM:此类别包括为广泛任务和应用设计的开源LLM。我们基准测试了以下模型:Vicuna (Chiang et al., 2023)、ChatGLM (Zeng et al., 2022)、Baichuan (Yang et al., 2023)、Qwen (Bai et al., 2023)、InternLM (Team, 2023a)、AgentLM (Zeng et al., 2023)、Mistral (Mistral.ai, 2023) 和 Yi (01ai, 2023)。

- 开源代码LLM:这些是专为理解和生成编程代码而定制的LLM。我们的实验涵盖了以下模型:Code Llama (Roziere et al., 2023)、WizardCoder (Luo et al., 2023)、Phind CodeLlama (Phind, 2023)、DeepSeek Coder (DeepSeek, 2023) 和 XwinCoder (Team, 2023c)。

- 代理框架:这些框架包含一个或多个基于LLM的代理,能够进行推理、规划和使用工具。我们对单代理框架XAgent (Team, 2023b)、Qwen-Agent (Bai et al., 2023) 和多代理框架AutoGen (Wu et al., 2023) 进行了评估。我们使用GPT-4作为XAgent和AutoGen的LLM,并使用Qwen-72B-Chat作为Qwen-Agent的LLM。

3.1.2 实施细节

评估过程。我们首先用文件、问题和约束条件提示代理。代理通过对外部Python沙箱的调用进行响应。然后,我们使用GPT3.5将响应重新格式化为格式要求。最后,我们使用正则表达式匹配来绘制答案,并将其与标签进行比较。

图5展示了评估过程中一个案例的流程。除了现成的框架外,所有实验都基于我们的代理框架。我们首先使用文件、问题和约束条件提示LLM。考虑到大多数模型难以完全遵循格式要求,我们在原始响应之后添加了一个重新格式化步骤,通过一次性提示来格式化响应。我们对这一重新格式化步骤进行了消融研究和人工检查,表明该步骤不会影响评估的准确性。有关重新格式化的更多详细信息,请参见附录Q。其他实施细节见附录P。

3.2 结果

图6。在InfiAgent-DABench中进行基准测试的模型的性能。模型分为4组:专有模型、开源通用llm、开源代码llm、代理框架。代 理框架后面的llm显示在括号中。我们也报告我们的代理。已知大小的模型用点表示,而未知大小的模型用水平线表示。

图6显示了在DAEval验证集上基准测试的不同模型的性能和模型大小。我们在附录D中提供了精确的性能数据。

3.3 发现

基于上述结果,我们有几个关键发现:

- 数据分析任务对当前的LLM具有挑战性。在所有基准模型中,GPT-4以78.99%的准确率优于其他模型,这表明即使是最先进的模型也有显著的改进空间,因为DAEval中的性能上限为100%。值得注意的是,表现最好的开源LLM Qwen-72B-Chat仍比GPT-4落后19%。专有模型和开源模型之间的巨大差距表明,需要增强开源LLM在数据分析任务中的性能。

- 最强大的开源LLM实现了与GPT-3.5相当的性能。我们发现,开源LLM在过去一段时间内发展迅速。尽管早期的开源模型与专有模型之间存在明显差距,但它们正在快速赶上。Qwen-72B-Chat达到了59.92%,在开源模型中表现最好,仅比GPT-3.5低0.78%,甚至比Gemini-Pro高出3.50%。

- DAAgent的性能优于GPT-5。我们最大的模型DAAgent-34B,通过从CodeLlama的DAInstruct进行指令调优,实现了比GPT-5高89%的性能,尽管它的参数比专有模型少得多。此外,表5比较了DAAgent与相应大小的Code Llama的性能,展示了在DAInstruct上进行指令调优带来的显著性能提升。所有这些表明,DAInstruct是一个有效的指令调优数据集,能够提升模型在数据分析方面的能力。

4.相关工作

基于LLM的代理的快速发展需要精确、全面的评价方法,但目前仍是一个挑战。最近的研究引入了几个新的评估设置,从不同角度进行评估:

- Web环境中的基准测试:WebShop (Yao et al., 2022a)WebArena (Zhou et al., 2023)

- 使用工具的基准测试:ToolBench (Qin et al., 2023b)Gentopia (Xu et al., 2023a)

在我们的工作中,我们提出了针对数据分析任务的代理评估方法InfiAgent-DABench。这类任务对LLM产生结构化和精确的中间可执行步骤有更高的要求。

与InfiAgent-DABench相关的另一系列工作是Code LLM和相应的评估。这些模型专注于理解和生成编程代码,并在过去几年中迅速发展(Zan et al., 2023; Zhang et al., 2023b; Chen et al., 2021; Roziere et al., 2023; Luo et al., 2023)。各种基准测试也已提出,例如:CodeXGLUE (Lu et al., 2021)DS-1000 (Lai et al., 2023)

然而,这些基准测试仍然缺乏全面的评估,无法完全检查代理在端到端任务解决能力方面的表现。关于Code LLM和相关基准测试的更多细节可以在附录B中找到。

5.总结

我们介绍了第一个专门用于评估基于LLM的代理在数据分析任务中表现的基准测试——InfiAgent-DABench。通过对34个前沿LLM进行广泛的基准测试,我们发现当代模型在有效管理数据分析任务方面仍然面临挑战。

此外,我们开发了DAAgent,一个专门用于数据分析的代理,并在DAInstruct上进行训练。DAInstruct是一个使用GPT-4生成的数据分析任务数据集,专为指令调优设计。我们的贡献不仅为评估数据分析中基于LLM的代理提供了一个有价值的基准,还提供了对这些模型在该领域的当前能力和局限性的深刻见解。

InfiAgent-DABench: Evaluating Agents on Data Analysis Tasks

论文的主要内容和贡献

- 引入InfiAgent-DABench基准:这是首个专门评估基于大语言模型(LLM)的代理在数据分析任务中表现的基准。

- DAEval数据集:基准包含一个名为DAEval的数据集,其中有257个数据分析问题,这些问题是从52个CSV文件中衍生出来的。

- 代理框架:论文介绍了一个代理框架,该框架结合了LLM,用于执行数据分析任务和进行评估。

- 格式提示技术:由于数据分析问题通常是开放式的,难以自动评估,作者采用了格式提示技术,将每个问题转换为封闭格式,以便自动评估。

- 广泛的基准测试:论文对34个LLM进行了广泛的基准测试,揭示了当前在数据分析任务中遇到的挑战。

- 开发DAAgent:基于他们的代理框架,作者开发了一个专门的代理,名为DAAgent,其在DABench上的表现超过了GPT-3.5,提升了3.9%。

- 资源发布:InfiAgent-DABench的评估数据集和工具包已在GitHub上发布,供其他研究人员使用。

1. 引言

- 背景和动机:

- 基于大语言模型(LLM)的代理在人工智能领域非常受欢迎,被认为是通用人工智能(AGI)的原型。这些代理具备推理、规划、记忆和使用工具的能力。

- 大量的LLM代理已经被开发出来,例如AutoGPT、BabyAGI和AgentGPT。

- 数据分析任务被发现对LLM代理来说具有挑战性但非常实用。

- 数据分析的重要性:

- 数据分析是一个系统的过程,涉及检查、清洗、转换和建模数据,以发现有用信息、得出结论并支持决策。它应用于商业智能、医疗保健、金融和科学研究等多个领域。

- LLM代理在数据分析中的应用:

- 一个典型的数据分析问题需要解决者与数据文件和代码执行器交互来获得解决方案,这需要LLM在自然语言和代码方面的协调能力。

- OpenAI的高级数据分析(ADA)是第一个有效帮助用户分析数据文件并执行编程代码的商业LLM代理。许多开发者在此基础上也制定了开源的数据分析代理。

- 现有问题和研究动机:

- 尽管有很多用于代码完成任务的基准,例如HumanEval、MBPP和DS-1000,但它们大多不适用于评估需要复杂能力(如规划、自我调试)的LLM代理。

- 因此,作者提出了InfiAgent-DABench,这是首个用于评估数据分析任务中代理的基准。

- InfiAgent-DABench的构建:

- 该基准包含257个与52个CSV文件相关的问题,涵盖现实的数据分析需求和广泛的领域。

- 作者从GitHub抓取CSV文件,并指示GPT-4根据文件和数据分析的关键概念生成开放性问题。

- 通过格式提示技术生成包含详细约束和格式要求的问题,以便自动评估。

- 数据集经过多维度的人类专家严格评估,不合格样本被过滤。

- 评估和结果:

- 作者构建了一个代理框架来支持LLM执行数据分析任务,评估了34个最先进的LLM,发现它们在处理数据分析任务时面临挑战。

- 为了促进开源LLM的数据分析能力,作者开发了一个名为DAInstruct的指令调整数据集,并在此基础上进一步开发了专注于数据分析的DAAgent。最大模型DAAgent-34B在数据分析任务上的表现比GPT-3.5提高了3.9%。

- 主要贡献:

- 提出了InfiAgent-DABench,这是首个用于评估数据分析任务中代理的基准。

- 基准测试了34个LLM,发现即使是最先进的LLM在处理数据分析任务时仍然面临挑战。

- 提出了一个用于数据分析任务的指令调整数据集DAInstruct,并开发了开源数据分析代理DAAgent,其在数据分析任务上的表现比GPT-3.5提高了3.9%。

这篇论文第二部分介绍了InfiAgent-DABench基准,用于评估基于LLM的代理在数据分析任务上的性能。具体来说,基准测试包括两个主要组件:DAEval评估数据集和代理框架。以下是详细内容:

2. InfiAgent-DABench基准

InfiAgent-DABench是一个评估基于LLM的代理在数据分析任务上的性能的基准。它包含两个主要组件:

- DAEval评估数据集:用于评估数据分析封闭问题的数据集。

- 代理框架:允许LLM在代理设置中解决数据分析问题。

2.1 数据集建设

- 文件集合:

- 从GitHub收集现实世界的CSV文件。

- 选择标准包括:有意义的场景、语言主要为英语、列数大于5、最小行数为20。

- 描述生成:

- 利用GPT-3.5总结每个CSV文件的列名和内容描述、数据类型、缺失值等信息。

- 概念确定:

- 通过专家访谈确定数据分析中的关键概念,确保数据集与现实需求一致。

- 开放式问题生成:

- 利用GPT-4根据文件描述和预定义概念生成开放式问题,确保问题涉及多个概念且没有重复。

- 约束条件和格式化需求的生成:

- 通过格式提示技术将开放式问题转换为封闭形式的问题,以便于自动评估。

- 响应收集:

- 利用OpenAI ADA生成封闭问题的答案,只有在多次尝试中生成一致答案时才保留。

2.2 代理框架

- 建立了一个代理框架,支持LLM进行数据分析任务,包括推理、与文件交互和调用Python代码等功能。

2.3 人工评估

为了确保数据集质量,进行了深入的人工评估。邀请专家对数据集进行评估,并与GPT-4生成的问题进行比较。

- 评估指标:

- 适宜性:CSV文件是否适合数据分析。

- 合理性:问题、约束和格式要求是否自然合理。

- 价值:问题在实际应用中的价值。

- 限制:约束是否足够严格以确保答案唯一性。

- 对齐情况:问题与数据文件的对齐情况。

- 正确性:问题的标签是否正确。

- 数据集质量:

- 邀请人类专家评估生成的数据集,删除不合格的样本。

- 结果显示,85%的样本是合格的,证明了数据集构建方法的有效性。

- 人与GPT-4比较:

- 专家编写数据分析问题,并对生成的问题进行评分。

- 比较人工和GPT-4生成的问题的难度,计算胜率反映问题的相对难度。

人工制作和GPT-4生成的问题之间的比较 结果。我们发现GPT4生成的问题利用了限制性、对齐和 难度,并且在合理性和价值方面的表现略好,这表明 DAEval与人工数据集具有可比性。

文件所在域的分布。为简洁起见,我们使用每个类别的第一个单词作为标签。

2.4 基准统计

在本节中,我们提供了DAEval的统计数据。我们将数据集分为验证集和测试集。验证集是公开的,包括257个问题和52个CSV文件,剩下的部分用于测试集以避免数据泄露。所有后续信息均基于验证集。

基本统计

表3列出了文件和问题的基本统计信息,包括文件数量、问题数量、子问题数量等。

文件的领域

图3展示了文件分布的不同领域。我们借助GPT-3.5将文件聚类为9个领域。结果显示,我们的数据集涵盖了广泛的领域。有关领域和相应描述的详细信息列在附录G中。

问题的概念

图4展示了问题涉及的不同概念的分布。表4显示了基于涉及概念数量的问题分布。数据显示,大多数问题涉及1或2个概念。这是合理的,因为在一个问题中涉及很多概念的情况并不常见。

问题的难度

我们利用GPT-4对DAEval中的问题难度进行了定量评估。问题被分为三个级别:简单、中等和困难。表4展示了这些难度级别在不同概念和每个问题的概念数量中的分布。定量评估的详细方法描述在附录K中。这表明DAEval中的问题难度范围广泛,确保了全面的评估。

2.5 指令调整数据集

在本节中,我们介绍DAInstruct,一个用于数据分析的指令调优数据集,我们在其上训练DAAgent,一个用于数据分析的专门代理。对DAInstruct的收集分三步进行:为CSV文件创建一组不同的数据分析问题通过我们的代理框架收集这些问题的响应轨迹。使用规则和GPT-4过滤低质量样本。结构的统计信息见附录l。另外,在附录O中提供了对DAInstruct的一个案例研究。

以下部分将详细介绍这些步骤。

问题生成。我们使用GPT-4生成一组与数据分析相关的关键字。然后,这些关键词经过人工筛选过程,以确保相关性和准确性。然后,提示GPT-4类似DAEval中的文件描述,以及以上关键字,为每个CSV文件生成问题。关键字和提示符见附录M。

响应收集。在这一步中,我们利用代理框架以ReAct (Yao et al, 2023)的方式生成响应。它是解决问题步骤的迭代,其中GPT-4以会话形式与代码执行环境进行交互。该过程包括推理、代码编写、执行和基于所获得的结果的迭代细化。详情见附录N。

过滤。此步骤涉及使用规则和GPT4进行过滤。采用特定的规则来识别和消除具有幻觉和不完全解的数据。然后,使用GPT-4对数据进行过滤。该标准包括五个方面:Python代码的相关性、对系统通知的解释、简洁性、对Python沙箱环境的理解以及解决方案的提供。所有提示都可以在附录M中找到。

A. 限制与未来工作

我们基准测试的一个显著限制是未包括与数据可视化相关的问题。在专家访谈中,我们认识到可视化在数据分析中的重要作用。然而,设计封闭式的可视化问题非常具有挑战性,因为结果通常是图像而不是文本。为了进行评估,有两种潜在的方法:

- 评估代码正确性:这种方法允许在评估中使用仅限文本的LLM。虽然可以利用现有的LLM,但这种方法可能导致不准确。在数据分析任务中,主要目标是生成准确的视觉表示,而不仅仅是底层代码。在某些情况下,仅从代码进行评估可能难以实现精确的评估。

- 使用多模态模型进行评估:Bai等人(2023)利用像GPT-4(Vision)(OpenAI,2023b)这样的视觉语言模型作为评估者。这种方法直接评估视觉输出的准确性。尽管该方法在评估最终产品方面具有优势,但当前的多模态模型性能欠佳且成本高昂,导致对数据可视化的评估效果不佳。

上述两种方法均无法达到封闭式评估的准确性和便利性。我们将数据分析中的可视化精确评估作为未来研究的方向。

B. 详细相关工作

B.1 代码LLMs

代码LLM是专门用于理解和生成编程代码的大型语言模型。这些LLM在过去几年中发展迅速(Zan等,2023;Zhang等,2023b)。Codex(Chen等,2021)是其中最著名的模型之一,由OpenAI提供商业API。同时,研究人员开发了大量开源代码LLM,例如Code Llama(Roziere等,2023)、WizardCoder(Luo等,2023)、XwinCoder(Team,2023c)和DeepSeek Coder(DeepSeek,2023)。

B.2 代码基准测试

近年来,提出了各种不同任务的基准测试来评估代码模型。CodeXGLUE(Lu等,2021)是一个综合基准,涵盖代码理解和生成的任务。此外,一些基准测试专注于代码生成,尤其是在竞赛级别(Chen等,2021;Austin等,2021;Hendrycks等,2021;Li等,2022)。DS-1000(Lai等,2023)是一个用于数据科学代码生成的基准。Bai等(2023)创建了一个包含数学、数据可视化和其他通用任务的数据集,以评估LLM使用Python代码解释器的能力。在附录C中,我们对InfiAgent-DABench和这项工作进行了更详细的比较。

C. InfiAgent-DABench与Qwen-Agent代码解释器基准的比较

InfiAgent-DABench与Qwen-Agent(Bai等,2023)代码解释器基准之间有两个主要区别:

- 我们在数据分析任务中基准测试LLM,涵盖一系列概念,而Bai等(2023)仅包含少量数据分析问题,主要集中在数据可视化及其其他通用任务上。

- 我们的基准采用封闭式评估正确性,不依赖任何外部模型作为评估者。更重要的是,Bai等(2023)利用当前的多模态模型评估数学和数据可视化问题的代码正确性,但对于其通用任务仅评估代码可执行性。

D. 在InfiAgent-DABench上的性能

表6展示了不同模型在InfiAgent-DABench中的准确率。图7则通过雷达图展示了涉及不同概念问题的性能。

E. DAEval构建的提示

在本节中,我们列出了问题生成过程中使用的所有提示。

E.1 描述生成

表7展示了描述生成的提示。

E.2 问题生成

表8展示了问题生成的提示。我们以如下方式提示GPT-4:

- 生成三个仅包含一个概念的简单问题。

- 生成三个涉及一个或多个概念的复杂问题。

- 生成三个涉及多个概念的更复杂问题。

E.3 约束和格式要求生成

表9展示了约束和格式要求生成的提示。

F. 关键概念的详细信息

表10展示了数据分析中的关键概念及其相应解释,这些解释是通过专家访谈获得的。我们使用GPT-3.5帮助我们总结访谈记录。由于某些原因,我们无法直接公开这些记录。

G. 领域的详细信息

我们在GPT-3.5的帮助下将CSV文件聚类成9个领域。表11展示了领域的名称及其相应解释。

H. 试验的详细信息

我们随机抽取了119个问题及其对应的答案,涉及GPT-4、GPT-3.5和DAAgent-34B,并要求人类专家和GPT-4基于相同的标准进行评估。每个答案根据解决问题的程度进行评分:0:没有解决问题或几乎没有解决,1:部分解决问题,2:大部分解决问题且仅有小错误,3:完全准确地解决问题。表12展示了人类专家与GPT-4的一致率。我们发现,当GPT-4作为数据分析任务的评估者时,其与人类专家的一致率约为67%,显然不能作为基准的满意评估者。

以下是关于 InfiAgent-DABench 项目在数据分析任务中评估智能体的研究内容的中文概要:

I.生成问题的扩展案例研究

表13展示了为test ave.csv文件生成的几个问题。这份文件细致地记录了泰坦尼克号上乘客的个人信息和旅行细节,包括他们的生存状态、舱位、姓名、性别、年龄和登船地点等方面。

根据特定的问题和约束,生成的问题包括一个或多个子问题。

J. 问卷和坏案例分析

J.1. 对匿名问题

从人类和 GPT-4 生成的问题中随机抽取了 216 对匿名问题(108 对为单一概念问题,108 对为多概念问题)。单一概念问题只与其他单一概念问题进行比较,多概念问题同理。表 15 显示了专家的问卷内容。: 从人类和 GPT-4 生成的问题中随机抽取了 216 对匿名问题(其中 108 对为单一概念问题,108 对为多概念问题)。单一概念问题只与其他单一概念问题进行比较,多概念问题同理。表 15 显示了专家的问卷内容。

J.2. 坏案例分析

表 16 展示了人类评估中发现的两个坏案例。

-

- 案例一: 发现 2019-08 edges.csv 文件中的 "Type" 列所有值都相同,因此使用随机森林分类器进行预测是没有意义的,这不符合我们的对齐标准。

- 案例二: 问题提到“给定的日期”,但在后续约束中没有提供具体日期,因此不符合我们的限制性标准。

J.3. 人类与 GPT-4 的比较设置

- 专家参与: 邀请了 3 位具有数据分析技能的专家为 9 个 CSV 文件编写了 54 个问题。每个文件有 3 个单一概念问题和 3 个多概念问题。

- 数据集: 将人类专家和 GPT-4 针对同一文件生成的问题结合,形成了一个包含 102 个问题的数据集用于评估。另外,为了评估难度,我们随机抽取了 216 对人类生成和 GPT-4 生成的问题对。所有问题在这个阶段对专家都是匿名的。

K. 评估难度的方法

- 难度评估: 随机抽取了 80 组,每组包含 5 个问题。

- 排名: GPT-4 根据数据处理复杂性、领域特定知识和编码复杂度对每组问题进行难度排名。每组重复排名 100 次以确保结果的稳健性。每个问题根据其排名获得分数,最具挑战性的问题得 5 分,最不具挑战性的问题得 0 分。然后计算每个问题的平均分数,得出数值难度排名。根据这些排名,问题被分为三种难度等级:简单(0 到 1.667 分)、中等(1.667 到 3.335 分)和困难(3.335 到 5 分)。

L. DAInstruct 统计数据

- 数据样本: DAInstruct 包含 5131 个数据样本,涉及 631 个 CSV 文件,ReAct 对话的平均长度为 5.18。

M. DAInstruct 生成提示

- 问题生成: 表 17 列出了用于生成问题的关键词和提示语。

- 过滤: 表 18 列出了用于过滤的提示语。

- 内容审核: 表 19 列出了用于内容审核的提示语。

N. 指令微调数据收集

- 数据收集方法: 在数据收集方法中,GPT-4 与我们的智能体框架进行迭代问题解决对话。对话从提供 CSV 文件和相关问题开始,GPT-4 处理这些信息并提出代码解决方案,然后执行这些代码。执行结果反馈到对话中,使 GPT-4 能够完善其响应并提出进一步的迭代。此循环持续进行,直到 GPT-4 确定累积的信息足以最终回答问题。一个关键方面是提示语的设计,它引导 GPT-4 的输出朝向有效的问题解决。表 20 列出了过程中使用的提示语。为了应对幻觉(GPT-4 可能生成虚构结果)的挑战,提示语中明确指示禁止 GPT-4 执行代码。

O. DAInstruct 案例研究

- 案例研究: 表 21 展示了 DAInstruct 的一个案例研究,突出了 GPT-4 与用户之间的对话,用户提出问题并执行生成的代码。这种迭代对话持续进行,直到 GPT-4 得出结论性解决方案。

P. InfiAgent-DABench: 数据分析任务中的评估代理

P.1 评估提示

表22展示了评估使用的标准提示模板。此外,我们对Abab5.5-Chat的标准模板进行了略微修改,以使其输出符合代理框架的格式要求。具体地,我们添加了以下提示:“注意,在给出最终答案之前,您必须输出字符串‘I now know the final answer’。”

Q. 重新格式化的详细信息

本节中,我们通过消融研究展示了在模型原始响应之后添加重新格式化步骤的必要性,因为大多数模型在严格遵守格式要求方面存在困难,而格式要求对于闭合式评估至关重要。此外,我们还进行了手动检查,以确保此重新格式化步骤不会因引入外部错误而影响评估结果。我们使用gpt-3.5-turbo-16k-0613进行重新格式化。重新格式化的提示在附录Q.3中。

Q.1 消融研究

我们添加了一个额外的重新格式化步骤,使用GPT-3.5将原始响应转换为所需格式。我们在两种设置下进行了消融研究:

- 无重新格式化:直接在一个阶段用问题、约束和格式要求提示模型。

- 有重新格式化:首先用问题和约束提示模型,然后使用GPT-3.5重新格式化原始响应,模型包括GPT-4、Qwen-72B-Chat、Qwen-14B-Chat和Mixtral-7B-Instruct-v0.2。

表23显示了结果,即使是最强大的模型如GPT-4,如果不进行重新格式化,性能也下降约6%,而较弱的模型如Mistral-7B的性能下降最多可达32%,这表明在评估中添加重新格式化步骤的必要性。

Q.2 手动检查

我们随机抽取了50个问题及其对应的模型原始响应以及经过重新格式化步骤处理的响应,手动检查此步骤是否会为评估引入额外错误。我们发现GPT-3.5能够在所有样本中将响应重新格式化为所需格式,这意味着此额外步骤通常不会影响结果。

Q.3 重新格式化的提示

image-20240701152255584

image-20240701152316307

表24展示了在重新格式化步骤中使用的提示。

3.实验

3.1 设置

3.1.1 模型

我们将基准测试的模型分为四组:专有模型、开源通用LLM、开源代码LLM和代理框架。

- 专有模型:此组包括作为商业服务提供的LLM,提供API访问以便集成到各种应用程序中。我们对以下模型进行了基准测试:OpenAI GPT-4 (OpenAI, 2023b)、GPT-3.5 (OpenAI, 2023a)、Claude-2.1 (Anthropic, 2023)、Abab5.5 (MiniMax, 2023) 和 Gemini-Pro (Team et al., 2023)。

- 开源通用LLM:此类别包括为广泛任务和应用设计的开源LLM。我们基准测试了以下模型:Vicuna (Chiang et al., 2023)、ChatGLM (Zeng et al., 2022)、Baichuan (Yang et al., 2023)、Qwen (Bai et al., 2023)、InternLM (Team, 2023a)、AgentLM (Zeng et al., 2023)、Mistral (Mistral.ai, 2023) 和 Yi (01ai, 2023)。

- 开源代码LLM:这些是专为理解和生成编程代码而定制的LLM。我们的实验涵盖了以下模型:Code Llama (Roziere et al., 2023)、WizardCoder (Luo et al., 2023)、Phind CodeLlama (Phind, 2023)、DeepSeek Coder (DeepSeek, 2023) 和 XwinCoder (Team, 2023c)。

- 代理框架:这些框架包含一个或多个基于LLM的代理,能够进行推理、规划和使用工具。我们对单代理框架XAgent (Team, 2023b)、Qwen-Agent (Bai et al., 2023) 和多代理框架AutoGen (Wu et al., 2023) 进行了评估。我们使用GPT-4作为XAgent和AutoGen的LLM,并使用Qwen-72B-Chat作为Qwen-Agent的LLM。

3.1.2 实施细节

评估过程。我们首先用文件、问题和约束条件提示代理。代理通过对外部Python沙箱的调用进行响应。然后,我们使用GPT3.5将响应重新格式化为格式要求。最后,我们使用正则表达式匹配来绘制答案,并将其与标签进行比较。

图5展示了评估过程中一个案例的流程。除了现成的框架外,所有实验都基于我们的代理框架。我们首先使用文件、问题和约束条件提示LLM。考虑到大多数模型难以完全遵循格式要求,我们在原始响应之后添加了一个重新格式化步骤,通过一次性提示来格式化响应。我们对这一重新格式化步骤进行了消融研究和人工检查,表明该步骤不会影响评估的准确性。有关重新格式化的更多详细信息,请参见附录Q。其他实施细节见附录P。

3.2 结果

图6。在InfiAgent-DABench中进行基准测试的模型的性能。模型分为4组:专有模型、开源通用llm、开源代码llm、代理框架。代 理框架后面的llm显示在括号中。我们也报告我们的代理。已知大小的模型用点表示,而未知大小的模型用水平线表示。

图6显示了在DAEval验证集上基准测试的不同模型的性能和模型大小。我们在附录D中提供了精确的性能数据。

3.3 发现

基于上述结果,我们有几个关键发现:

- 数据分析任务对当前的LLM具有挑战性。在所有基准模型中,GPT-4以78.99%的准确率优于其他模型,这表明即使是最先进的模型也有显著的改进空间,因为DAEval中的性能上限为100%。值得注意的是,表现最好的开源LLM Qwen-72B-Chat仍比GPT-4落后19%。专有模型和开源模型之间的巨大差距表明,需要增强开源LLM在数据分析任务中的性能。

- 最强大的开源LLM实现了与GPT-3.5相当的性能。我们发现,开源LLM在过去一段时间内发展迅速。尽管早期的开源模型与专有模型之间存在明显差距,但它们正在快速赶上。Qwen-72B-Chat达到了59.92%,在开源模型中表现最好,仅比GPT-3.5低0.78%,甚至比Gemini-Pro高出3.50%。

- DAAgent的性能优于GPT-5。我们最大的模型DAAgent-34B,通过从CodeLlama的DAInstruct进行指令调优,实现了比GPT-5高89%的性能,尽管它的参数比专有模型少得多。此外,表5比较了DAAgent与相应大小的Code Llama的性能,展示了在DAInstruct上进行指令调优带来的显著性能提升。所有这些表明,DAInstruct是一个有效的指令调优数据集,能够提升模型在数据分析方面的能力。

4.相关工作

基于LLM的代理的快速发展需要精确、全面的评价方法,但目前仍是一个挑战。最近的研究引入了几个新的评估设置,从不同角度进行评估:

- Web环境中的基准测试:WebShop (Yao et al., 2022a)WebArena (Zhou et al., 2023)

- 使用工具的基准测试:ToolBench (Qin et al., 2023b)Gentopia (Xu et al., 2023a)

在我们的工作中,我们提出了针对数据分析任务的代理评估方法InfiAgent-DABench。这类任务对LLM产生结构化和精确的中间可执行步骤有更高的要求。

与InfiAgent-DABench相关的另一系列工作是Code LLM和相应的评估。这些模型专注于理解和生成编程代码,并在过去几年中迅速发展(Zan et al., 2023; Zhang et al., 2023b; Chen et al., 2021; Roziere et al., 2023; Luo et al., 2023)。各种基准测试也已提出,例如:CodeXGLUE (Lu et al., 2021)DS-1000 (Lai et al., 2023)

然而,这些基准测试仍然缺乏全面的评估,无法完全检查代理在端到端任务解决能力方面的表现。关于Code LLM和相关基准测试的更多细节可以在附录B中找到。

5.总结

我们介绍了第一个专门用于评估基于LLM的代理在数据分析任务中表现的基准测试——InfiAgent-DABench。通过对34个前沿LLM进行广泛的基准测试,我们发现当代模型在有效管理数据分析任务方面仍然面临挑战。

此外,我们开发了DAAgent,一个专门用于数据分析的代理,并在DAInstruct上进行训练。DAInstruct是一个使用GPT-4生成的数据分析任务数据集,专为指令调优设计。我们的贡献不仅为评估数据分析中基于LLM的代理提供了一个有价值的基准,还提供了对这些模型在该领域的当前能力和局限性的深刻见解。

271

271

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?