Reformer模型是一种改进的Transformer模型,旨在提高其计算效率和内存使用。Transformer模型在处理长序列数据时计算复杂度较高(O(n^2)),且内存消耗巨大。Reformer通过引入局部敏感哈希(LSH)和可逆网络(Reversible Layers)技术来解决这些问题。

以下是Reformer模型的两个核心改进:

局部敏感哈希(Locality-Sensitive Hashing, LSH)是一种用于高维数据降维和最近邻搜索的技术。其核心思想是通过哈希函数将相似的数据点映射到相同的哈希桶中,从而在低维空间中保留高维空间的相似性。这样可以大幅减少计算复杂度,特别是在处理大规模数据时。

局部敏感哈希(Locality-Sensitive Hashing, LSH)

LSH 的基本原理

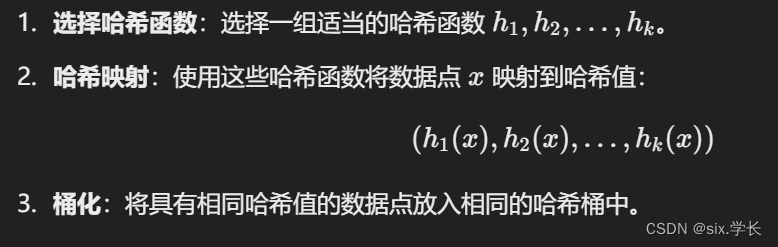

LSH 使用一组哈希函数来将高维数据点映射到低维空间中,并确保相似的数据点被哈希到相同或相近的桶中。每个哈希函数都具有以下性质:

- 概率性近似:相似的数据点被哈希到同一个桶中的概率较高,而不相似的数据点被哈希到同一个桶中的概率较低。

- 距离保留:哈希函数能够保留数据点之间的相对距离,即高维空间中距离较近的数据点在低维空间中也应距离较近。

LSH 的过程

举例说明

假设我们有一组二维数据点,我们可以通过简单的哈希函数将其映射到一个一维空间中。比如:

- 数据点 A (1, 2)

- 数据点 B (2, 3)

- 数据点 C (10, 12)

通过这种方式,LSH 可以有效地将相似的数据点聚集在一起,从而在大规模数据处理中大幅减少计算量。

应用场景

- 近似最近邻搜索:在大数据集上查找与给定查询点最相似的数据点,LSH 可以显著减少计算量。

- 图像检索:通过哈希图像特征向量,可以快速检索与查询图像相似的图像。

- 文本相似性搜索:在文档中查找与给定文本相似的文档。

Reformer中的LSH应用

在Reformer模型中,LSH用于改进注意力机制。传统的注意力机制需要计算每个单词与序列中所有其他单词的注意力得分,计算复杂度为 (O(n2))。而通过LSH,Reformer模型可以将相似的单词哈希到相同的桶中,只计算桶内单词的注意力得分,将计算复杂度降低到 (O(n log n))。

例如,处理一个长度为10,000的文本序列,传统Transformer需要计算10,0002次操作,而Reformer通过LSH只需计算哈希桶中的局部注意力,大幅减少计算量,从而提高模型效率和处理长序列的能力。

总之,LSH 是一种高效的数据降维和最近邻搜索技术,通过在Reformer模型中的应用,显著改进了注意力机制的计算效率和内存使用。

2. 可逆网络(Reversible Layers)

可逆网络(Reversible Layers)是一种神经网络架构设计,允许通过输出直接恢复输入,从而在训练过程中节省内存。传统神经网络在进行反向传播时,需要存储每一层的中间激活值,而可逆网络通过其结构特点避免了这一点,只需存储少量信息。

可逆网络的基本原理

在传统的神经网络中,每一层的输出都是下一层的输入,这些中间输出值在反向传播时需要被用来计算梯度。因此,需要大量内存来存储这些中间结果。而可逆网络通过设计特殊的层,使得这些中间值可以在反向传播时被重构,从而减少内存需求。

Reversible Residual Network (RevNet)

一种典型的可逆网络结构是可逆残差网络(RevNet),它通过将输入分成两部分,并通过一系列可逆操作来计算输出。

假设输入为 ((x_1, x_2)),可逆层的计算如下:

举例说明

假设我们有一个输入向量 (x = (x1, x2)),通过以下可逆层计算:

Reformer中的可逆网络

在Reformer模型中,可逆网络被用于减少内存使用,特别是在处理长序列数据时。Reformer结合可逆网络和局部敏感哈希(LSH)注意力机制,既能处理长序列数据,又能有效节省内存。

优点

- 内存节省:无需存储每层的中间激活值,大大减少了内存使用。

- 适用于深度网络:特别适用于需要训练深层次网络的场景,如自然语言处理和计算机视觉任务。

- 简化反向传播:由于可以直接从输出重构输入,反向传播过程变得更加简单和高效。

总结

可逆网络(Reversible Layers)通过设计特殊的可逆层,使得神经网络在反向传播时可以从输出重构输入,从而大幅减少内存使用。这一技术在处理长序列数据和深层网络训练时特别有用,并被成功应用于如Reformer模型等高效神经网络架构中。

Reformer的优势

- 计算效率更高:通过LSH注意力机制,Reformer将计算复杂度从O(n^2)降低到O(n log n)。

- 内存使用更少:通过可逆网络,Reformer大幅减少了中间状态的存储需求,使其能够处理更长的序列。

举例说明

假设我们有一个长度为10,000的文本序列,传统Transformer需要计算每个单词与其他所有单词的注意力得分,总计算量为10,0002 = 100,000,000次操作。而Reformer通过LSH,将单词分配到不同的哈希桶中(假设每个桶包含100个单词),那么只需计算100个单词内部的注意力得分,总计算量为10,000 * 100 = 1,000,000次操作,显著减少了计算量。

此外,由于Reformer的可逆网络,内存需求也大大降低,使其可以在处理超长文本时更加高效。

综上所述,Reformer模型通过引入LSH注意力机制和可逆网络,成功地在保持Transformer模型强大功能的同时,提高了计算效率并减少了内存消耗,非常适合处理长序列数据。

635

635

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?