📄 论文信息

- 标题: MedCLIP-SAM: Medical Image Segmentation with CLIP-driven Prompting

- 作者: Taha Koleilat, Hojat Asgariandehkordi, Hassan Rivaz, Yiming Xiao

- 机构: Concordia University, Montreal, Canada

- 🔗 GitHub 源码地址

🎯 一、研究背景与动机

医学图像分割对疾病诊断、治疗规划等场景至关重要,但现有方法面临以下挑战:

🔸 标注数据有限

🔸 模型跨任务/模态泛化能力弱

🔸 缺乏交互性与可解释性

✨ 基础模型(如 CLIP 和 SAM)的出现带来了新的可能性。本研究首次将 BiomedCLIP 与 SAM 融合,提出框架 MedCLIP-SAM,实现:

- 🧠 文本引导的图像分割

- ❄️ 零样本(zero-shot)分割

- 🔧 弱监督(weakly-supervised)学习

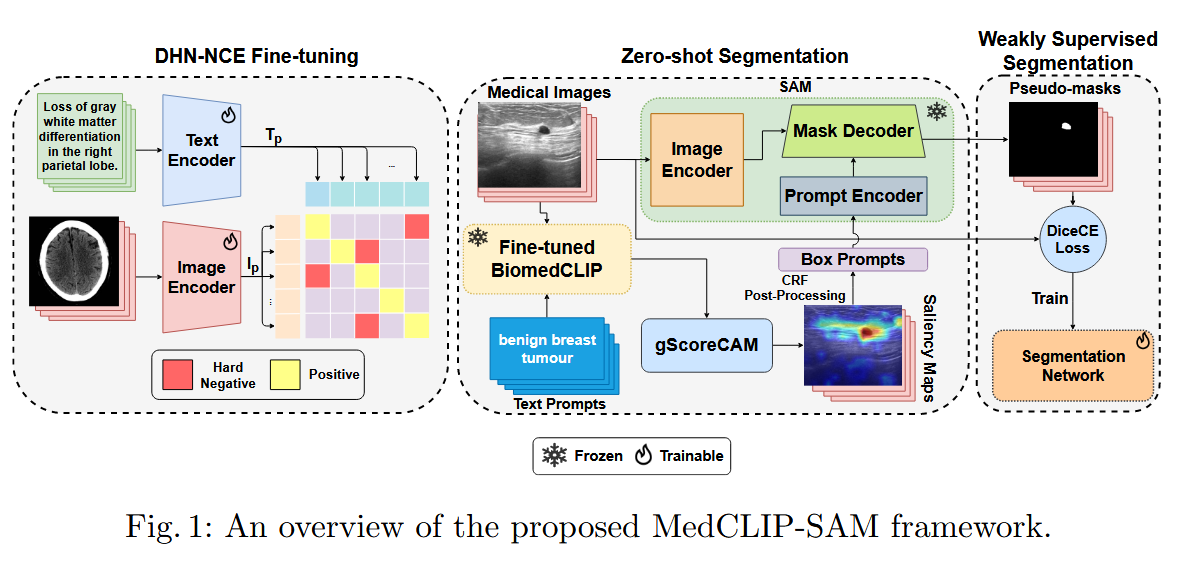

🧩 二、方法总览

三个阶段:

- ⚙️ DHN-NCE 微调

- 🧊 Zero-shot 分割

- 🛠️ 弱监督训练

🔧 三、DHN-NCE 微调阶段

输入: 医学图像 + 医学文本描述

处理流程:

- 📷 图像编码器(Image Encoder) → 提取视觉特征 ( I_p )

- 📝 文本编码器(Text Encoder) → 提取语义特征 ( T_p )

- 💥 使用 DHN-NCE 损失函数(强调 hard negative),优化 BiomedCLIP 语义对齐能力

结果: BiomedCLIP 学会精准对齐医学图像与描述之间的语义关系

🧊 四、零样本分割(Zero-shot Segmentation)

输入: 医学图像 + 文本提示(如 “benign breast tumour”)

流程:

- 📥 图像 & 文本 →❄️Fine-tuned BiomedCLIP → 提取特征

- 🔍 gScoreCAM → 显著性图 + CRF后处理 → 得到 提示框 (Box Prompt)

- ✂️ SAM → 使用 box prompt 和图像 → 生成伪掩膜(pseudo-mask)

结果: 在 无人工掩膜标签情况下,输出具备语义引导的分割结果 ✅

🛠️ 五、弱监督训练(Weakly Supervised Segmentation)

输入: 上一阶段得到的伪掩膜

流程:

- 🏗️ 使用伪掩膜作为弱标签

- 🔄 训练额外分割网络(如 Residual U-Net)

- 📉 损失函数:Dice + Cross Entropy(DiceCE)

结果: 提升伪掩膜质量,获得更高精度的分割输出 🎯

🧪 六、数据集设置

| 📚 数据集 | 🔬 模态 | 🎯 任务 | 📊 数据划分 |

|---|---|---|---|

| BUSI | 乳腺超声 | 乳腺肿瘤分割 | 训练600 + 验证65 + 测试98 |

| Brain Tumor MRI | 脑 MRI | 脑肿瘤分割 | 训练1462 + 验证400 + 测试400 |

| COVID-19 X-ray | 胸部 X-ray | 肺部分割 | 训练16280 + 验证1372 + 测试957 |

💡 七、创新亮点

✅ 首次将 CLIP 与 SAM 融合用于医学图像

✅ 提出 DHN-NCE:处理难负样本的对比损失

✅ 将 gScoreCAM 引入医学图像分析

✅ Zero-shot 分割性能强,可与部分有监督方法媲美

✅ 支持多模态、多任务分割,适应性强

🔭 八、未来方向

- 🌐 扩展到更多模态(如3D CT、MRI)

- 💬 探索更复杂的自然语言提示工程

- 🧠 与临床系统深度融合,提升实用性

3042

3042

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?