SAM 和 CLIP 联合的风吹到了医学图像分割~

MedCLIP-SAM:一种通用医学图像分割新框架,将 CLIP 和 SAM 基础模型相结合,以获得基于文本提示的通用医学图像分割,并提出 DHN-NCE 新损失函数,性能表现出色~

论文:MedCLIP-SAM: Bridging Text and Image Towards Universal Medical Image Segmentation

代码:https://github.com/HealthX-Lab/MedCLIP-SAM

0、摘要

解剖结构和病理的医学图像分割在现代临床诊断、疾病研究和治疗规划中至关重要。到目前为止,基于深度学习的分割技术已经取得了很大的进展,但大多数方法仍然缺乏数据效率、通用性和可交互性。

因此,基于更少的标记数据集,开发新的、精确的分割方法,在医学图像分析中非常重要。

近年来,基础模型(foundation models)的出现,如 CLIP 和分割任意模型(SAM),具有全面的跨域表示,为交互式和通用的图像分割打开了大门。然而,对这些模型进行数据高效的医学图像分割的探索仍然有限。

本文提出了一个新的框架,称为 MedCLIP-SAM(帅气的名字彰显着它的不平凡o( ̄▽ ̄)ブ),它结合了 CLIP 和 SAM 模型,在 zero-shot 和弱监督设置下使用文本提示生成临床图像的分割。

本文采用了一种新的解耦强负噪声对比估计( Decoupled Hard Negative Noise Contrastive Estimation,DHN-NCE)损失来微调 BiomedCLIP 模型,利用最近的 gScoreCAM 来生成 prompts,以在 zero-shot 设置下从 SAM 获得分割掩码。

此外,本文还探索了在弱监督范式中使用 zero-shot 分割标签来进一步提高分割质量。

在三种不同的分割任务和医学图像模态(乳腺肿瘤超声、脑肿瘤MRI和肺x射线)上测试,本文提出的框架具有极好的准确性。

1、引言

1.1、当前深度学习(DL)技术在医学图像分割中的局限

(1)缺乏注释良好的大型数据集是DL模型开发的一个主要瓶颈;(是是是…标注难)

(2)缺乏可交互性和可解释性限制了这些方法的可信度;(是是是…医学讲究可解释)

(3)大多数训练的模型都是针对专门的任务或模态的,灵活性较低;(是是是…训练个专门任务的都不容易)

1.2、曙光:CLIP 和 SAM

(1)CLIP 和 SAM 为交互式和通用的医学图像分割打开了大门;

(2)BiomedCLIP 和 MedSAM 对数百万生物医学数据进行了预先训练,实现了 CLIP 和 SAM 从自然图像到医学图像的转换;

(3)更有效的参数微调方法有利于进一步提高这些基础模型在放射学应用中的性能;

(4)SAM 需要交互式指导分割,一些研究在没有 prompts 的情况下微调 SAM,通过分类任务的 CAM 来产生 prompts,并基于弱监督优化其输出;

1.3、本文贡献

(1)提出了一种新的 CLIP 训练/微调方法,称为解耦强负噪声对比估计(DHN-NCE);

(2)首次提出了一种将 CLIP 和 SAM 相结合的 zero-shot 医学图像分割方法;

(3)通过进一步细化 zero-shot 分割结果,探索了一种弱监督分割策略,并在三种不同的分割任务和影像模态上得到了广泛的验证;

2、方法

如下图所示,包括三个阶段:

(1)使用 DHN-NCE 损失微调 BiomedCLIP;

(2)在文本提示的引导下, zero-shot 分割;

(3)基于弱监督分割的潜在标签细化;

2.1、高效的 BiomedCLIP 微调与 DHN-NCE 损失

2.1.1、DHN-NCE 损失

CLIP 使用图像编码器和文本编码器提取图像和文本的特征,并将它们分别投影为相同维数的向量: I p , i {\bold{I}_{p,i}} Ip,i 和 T p , i {\bold{T}_{p,i}} Tp,i ,通过对比学习,学习图像和文本向量共享的嵌入空间,使相似的对(图像及其描述)距离更近,不同的对距离更远;

BiomedCLIP 是在医学图像和临床文本上训练的,进一步微调有利于医学特定的图像任务;

然而在 CLIP 的训练中,采用传统的 InfoNCE 损失,负正耦合(negative-positive-coupling,NPC)效应可能导致次优学习效率,特别是在小批次处理中,对于医学图像,同一成像类别内的病例之间更细微的鉴别可能是困难的。

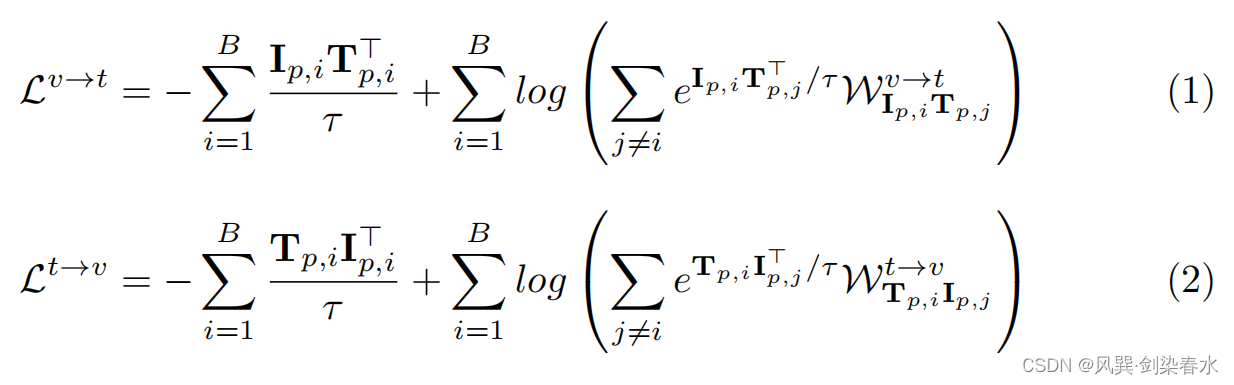

提出了解耦强负噪声对比估计(DHN-NCE)损失:

(1)将 InfoNCE 损失与强负采样(hard negative sampling)相结合,以关注“相近样本”;

(2)通过删除分母中的正项来增加解耦对比学习,以允许更小的批处理大小;

具体实现是,损失函数

L

D

H

N

−

N

C

E

{L_{DHN−NCE}}

LDHN−NCE 使用加权函数(

W

I

p

,

i

T

p

,

j

v

→

t

{W_{\bold{I}_{p,i} \bold{T}_{p,j}}^{v→t}}

WIp,iTp,jv→t,

W

T

p

,

i

I

p

,

j

t

→

v

{W_{\bold{T}_{p,i} \bold{I}_{p,j}}^{t→v}}

WTp,iIp,jt→v),通过图像到文本和文本到图像的硬度参数

β

1

,

β

2

≥

0

{β1,β2≥0}

β1,β2≥0 ,来增加对恰好非常接近锚点的负值的惩罚;

t

→

v

{t→v}

t→v 表示文本到图像,

v

→

t

{v→t}

v→t 表示图像到文本,

B

{B}

B 为 batch size,

τ

{\tau}

τ 为温度参数;

2.1.2、BiomedCLIP 微调

利用具有不同放射学模态的公共数据集MedPix,使用 DHN-NCE 损失,对BiomedCLIP模型进行微调;

(1)backbone:使用了基础 Vision Transformer 和 PubMedBERT 作为图像和文本编码器;

(2)文本清理:删除任何特殊字符,空格,以及删除标题小于20个字符的样本;

(3)图像处理:图像的大小都调整到224×224,根据原始 CLIP 模型中使用的 RGB 通道均值和标准差进行归一化;

(4)数据集划分:85%:15%,20,292张训练图像,3,515张验证图像;

(5)参数:batch size = 64,lr = 1E-6(衰减率50%);

2.2、 zero-shot 和弱监督医学图像分割

基于微调的 BiomedCLIP 模型,提出了一种 zero-shot 通用医学图像分割策略,该策略利用了最近的 XAI 技术:gScoreCAM,该技术为 CLIP 模型提供文本提示在对应图像中的视觉显著性映射。(文本在图像中的体现)

虽然 gScoreCAM 在自然图像的准确性和特异性方面优于 gradCAM,但这是首次在放射学任务中使用。

对于输入图像和目标解剖/病理的文本提示,首先通过使用条件随机场(conditional random field,CRF)滤波器对 gScoreCAM 映射进行后处理,获得初始的粗分割,然后使用该图像获得 SAM 的边界框(bounding box),作为 zero-shot 分割的伪掩码。

为了进一步提高零镜头分割的准确性,使用得到的伪掩码在弱监督设置下训练残差UNet。

2.3、数据集、实验设置和验证指标

2.3.1、BiomedCLIP 微调性能

(1)ROCO(Radiology Objects in COntext)数据集:约包含 7042 例多模态医学影像;

(2)batch size=50,5次实验,shuffling操作;

(3)比较了不同微调损失函数,包括 InfoNCE、DCL 、HN-NCE 和 DHN-NCE 损失;

(4)超参数:

τ

=

0.6

{\tau = 0.6}

τ=0.6,lr = 1E-6,

β

1

=

β

2

=

0.15

{β1=β2=0.15}

β1=β2=0.15 ;

2.3.2、图像分割准确率

(1)三个公开数据集:

①乳腺肿瘤超声:Breast Ultrasound Images dataset (BUSI) 数据集:600张良恶性图像用于训练;UDIAT 数据集:65张验证,98张测试;

②脑肿瘤MRI:T1-MRI,1462训练,400验证,400测试;

③胸部X线:COVID-QU-Ex数据集:16280训练,1372验证,957测试;

(2)评价指标:IoU、DSC、AUC;

(3)统计分析:配对样本 t {t} t 检验( p < 0.05 {p<0.05} p<0.05 )

3、实验结果

3.1、评价 BiomedCLIP 效果

比较基线模型,以及不同损失函数效果:

3.2、评价 zero-shot 分割效果

比较 gScoreCAM 与 gradCAM 两种边界框获取方式:

3.3、与其他完全监督方法和弱监督方法比较

Saliency Maps 与 Saliency Maps + SAM 比较验证 SAM 的有效性:

MedCLIP-SAM zero-shot 分割在乳腺超声和大脑MRI分割方面优于基于完全监督的 ResUNet,但在胸部X线的肺部分割中,完全监督方法效果更好;

可视化结果:

总体流程总结:

1、获得一个经过微调的优秀图文对比模型:BiomedCLIP;

2、基于微调 BiomedCLIP,利用文本到图像的视觉映射获得边界框;

3、将边界框作为 SAM 的 prompts 获得分割结果;

4、弱监督分割策略细化 SAM 得到的 mask;

324

324

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?