时间序列分析 | Python实现Transformers时间序列预测时间序列预测(Exponential Smoothing Transformers)

目录

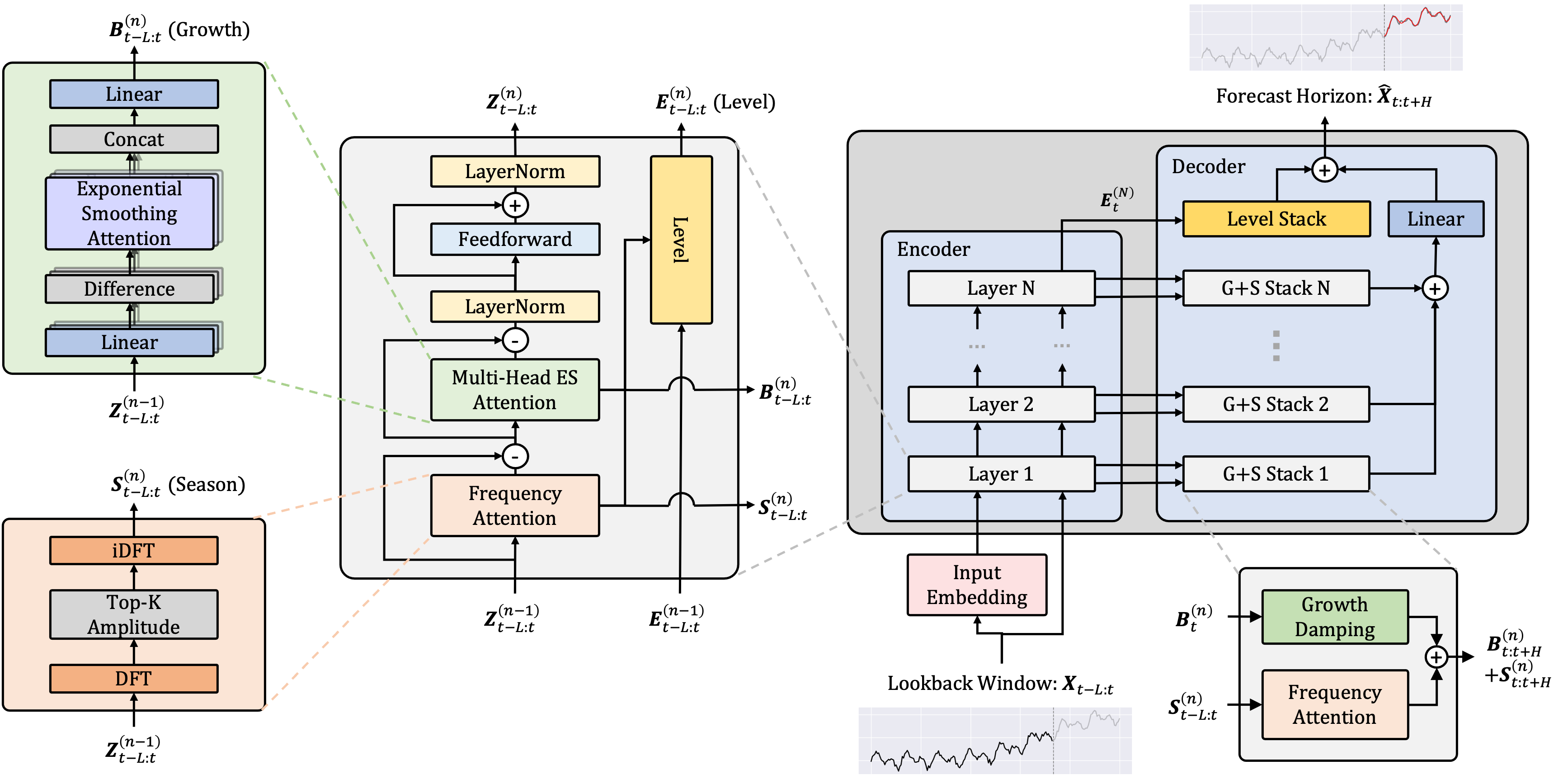

模型结构

基本介绍

Transformers时间序列预测Exponential Smoothing Transformers

环境要求

matplotlib3.5.1

numpy

pandas1.4.2

scikit-learn1.0.2

scipy1.7.3

torch1.11.0

tqdm4.62.3

einops==0.4.1

程序设计

import argparse

import os

import torch

from exp.exp_mai

订阅专栏 解锁全文

订阅专栏 解锁全文

280

280

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?