在之前的案例中,使用datasets.ImageFolder函数直接导入已经分类好的数据集形成Dataset,然后使用DataLoader加载Dataset,但是如果对无法分类的数据集,我们如何导入,并进行识别呢?

我们将自定义一个MyDataset加载车牌数据集并完成车牌识别。

一、完整代码

在这里插入代码片#导入数据

from torchvision.transforms import transforms

from torch.utils.data import DataLoader

from torchvision import datasets

import torchvision.models as models

import torch.nn.functional as F

import torch.nn as nn

import torch,torchvision

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

print(device)

#获取类别名

import os,PIL,random,pathlib

import matplotlib.pyplot as plt

# 支持中文

plt.rcParams['font.sans-serif'] = ['SimHei'] # 用来正常显示中文标签

plt.rcParams['axes.unicode_minus'] = False # 用来正常显示负号

data_dir = r'D:/编程文件/数据库/P10 car/015_licence_plate'

data_dir = pathlib.Path(data_dir)

data_paths = list(data_dir.glob('*'))

classeNames = [str(path).split("\\")[5].split("_")[1].split(".")[0] for path in data_paths]

print(classeNames)

data_paths = list(data_dir.glob('*'))

data_paths_str = [str(path) for path in data_paths]

print(data_paths_str)

#数据可视化

plt.figure(figsize=(14, 5))

plt.suptitle("数据示例(K同学啊)", fontsize=15)

for i in range(18):

plt.subplot(3, 6, i + 1)

# plt.xticks([])

# plt.yticks([])

# plt.grid(False)

# 显示图片

images = plt.imread(data_paths_str[i])

plt.imshow(images)

plt.show()

#标签数字化

import numpy as np

char_enum = ["京","沪","津","渝","冀","晋","蒙","辽","吉","黑","苏","浙","皖","闽","赣","鲁",\

"豫","鄂","湘","粤","桂","琼","川","贵","云","藏","陕","甘","青","宁","新","军","使"]

number = [str(i) for i in range(0, 10)] # 0 到 9 的数字

alphabet = [chr(i) for i in range(65, 91)] # A 到 Z 的字母

char_set = char_enum + number + alphabet

char_set_len = len(char_set)

label_name_len = len(classeNames[0])

# 将字符串数字化

def text2vec(text):

vector = np.zeros([label_name_len, char_set_len])

for i, c in enumerate(text):

idx = char_set.index(c)

vector[i][idx] = 1.0

return vector

all_labels = [text2vec(i) for i in classeNames]

#加载数据文件

import os

import pandas as pd

from torchvision.io import read_image

from torch.utils.data import Dataset

import torch.utils.data as data

from PIL import Image

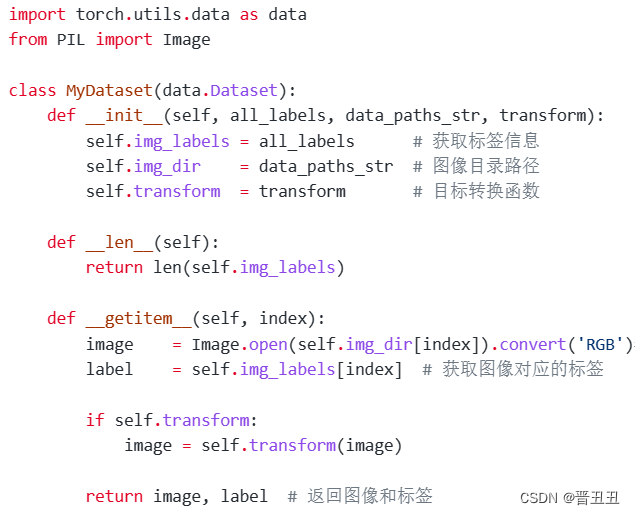

class MyDataset(data.Dataset):

def __init__(self, all_labels, data_paths_str, transform):

self.img_labels = all_labels # 获取标签信息

self.img_dir = data_paths_str # 图像目录路径

self.transform = transform # 目标转换函数

def __len__(self):

return len(self.img_labels)

def __getitem__(self, index):

image = Image.open(self.img_dir[index]).convert(

'RGB') # plt.imread(self.img_dir[index]) # 使用 torchvision.io.read_image 读取图像

label = self.img_labels[index] # 获取图像对应的标签

if self.transform:

image = self.transform(image)

return image, label # 返回图像和标签

total_datadir = './03_traffic_sign/'

# 关于transforms.Compose的更多介绍可以参考:https://blog.csdn.net/qq_38251616/article/details/124878863

train_transforms = transforms.Compose([

transforms.Resize([224, 224]), # 将输入图片resize成统一尺寸

transforms.ToTensor(), # 将PIL Image或numpy.ndarray转换为tensor,并归一化到[0,1]之间

transforms.Normalize( # 标准化处理-->转换为标准正太分布(高斯分布),使模型更容易收敛

mean=[0.485, 0.456, 0.406],

std =[0.229, 0.224, 0.225]) # 其中 mean=[0.485,0.456,0.406]与std=[0.229,0.224,0.225] 从数据集中随机抽样计算得到的。

])

total_data = MyDataset(all_labels, data_paths_str, train_transforms)

print(total_data)

#划分数据

train_size = int(0.8 * len(total_data))

test_size = len(total_data) - train_size

train_dataset, test_dataset = torch.utils.data.random_split(total_data, [train_size, test_size])

print(train_size,test_size)

train_loader = torch.utils.data.DataLoader(train_dataset,

batch_size=16,

shuffle=True)

test_loader = torch.utils.data.DataLoader(test_dataset,

batch_size=16,

shuffle=True)

print("The number of images in a training set is: ", len(train_loader)*16)

print("The number of images in a test set is: ", len(test_loader)*16)

print("The number of batches per epoch is: ", len(train_loader))

for X, y in test_loader:

print("Shape of X [N, C, H, W]: ", X.shape)

print("Shape of y: ", y.shape, y.dtype)

break

#自建模型

class Network_bn(nn.Module):

def __init__(self):

super(Network_bn, self).__init__()

"""

nn.Conv2d()函数:

第一个参数(in_channels)是输入的channel数量

第二个参数(out_channels)是输出的channel数量

第三个参数(kernel_size)是卷积核大小

第四个参数(stride)是步长,默认为1

第五个参数(padding)是填充大小,默认为0

"""

self.conv1 = nn.Conv2d(in_channels=3, out_channels=12, kernel_size=5, stride=1, padding=0)

self.bn1 = nn.BatchNorm2d(12)

self.conv2 = nn.Conv2d(in_channels=12, out_channels=12, kernel_size=5, stride=1, padding=0)

self.bn2 = nn.BatchNorm2d(12)

self.pool = nn.MaxPool2d(2, 2)

self.conv4 = nn.Conv2d(in_channels=12, out_channels=24, kernel_size=5, stride=1, padding=0)

self.bn4 = nn.BatchNorm2d(24)

self.conv5 = nn.Conv2d(in_channels=24, out_channels=24, kernel_size=5, stride=1, padding=0)

self.bn5 = nn.BatchNorm2d(24)

self.fc1 = nn.Linear(24 * 50 * 50, label_name_len * char_set_len)

self.reshape = Reshape([label_name_len, char_set_len])

def forward(self, x):

x = F.relu(self.bn1(self.conv1(x)))

x = F.relu(self.bn2(self.conv2(x)))

x = self.pool(x)

x = F.relu(self.bn4(self.conv4(x)))

x = F.relu(self.bn5(self.conv5(x)))

x = self.pool(x)

x = x.view(-1, 24 * 50 * 50)

x = self.fc1(x)

# 最终reshape

x = self.reshape(x)

return x

# 定义Reshape层

class Reshape(nn.Module):

def __init__(self, shape):

super(Reshape, self).__init__()

self.shape = shape

def forward(self, x):

return x.view(x.size(0), *self.shape)

device = "cuda" if torch.cuda.is_available() else "cpu"

print("Using {} device".format(device))

model = Network_bn().to(device)

print(model)

import torchsummary

''' 显示网络结构 '''

torchsummary.summary(model, (3, 224, 224))

#优化器与损失函数

optimizer = torch.optim.Adam(model.parameters(),

lr=1e-4,

weight_decay=0.0001)

loss_model = nn.CrossEntropyLoss()

from torch.autograd import Variable

def test(model, test_loader, loss_model):

size = len(test_loader.dataset)

num_batches = len(test_loader)

model.eval()

test_loss, correct = 0, 0

with torch.no_grad():

for X, y in test_loader:

X, y = X.to(device), y.to(device)

pred = model(X)

test_loss += loss_model(pred, y).item()

test_loss /= num_batches

print(f"Avg loss: {test_loss:>8f} \n")

return correct, test_loss

def train(model, train_loader, loss_model, optimizer):

model = model.to(device)

model.train()

for i, (images, labels) in enumerate(train_loader, 0): # 0是标起始位置的值。

images = Variable(images.to(device))

labels = Variable(labels.to(device))

optimizer.zero_grad()

outputs = model(images)

loss = loss_model(outputs, labels)

loss.backward()

optimizer.step()

if i % 1000 == 0:

print('[%5d] loss: %.3f' % (i, loss))

test_acc_list = []

test_loss_list = []

epochs = 30

for t in range(epochs):

print(f"Epoch {t+1}\n-------------------------------")

train(model,train_loader,loss_model,optimizer)

test_acc,test_loss = test(model, test_loader, loss_model)

test_acc_list.append(test_acc)

test_loss_list.append(test_loss)

print("Done!")

import numpy as np

import matplotlib.pyplot as plt

x = [i for i in range(1,31)]

plt.plot(x, test_loss_list, label="Loss", alpha=0.8)

plt.xlabel("Epoch")

plt.ylabel("Loss")

plt.legend()

plt.show()

二、自定义加载数据集步骤概述

在深度学习中,自定义加载数据集是一个常见的任务,因为很多实际项目中的数据集并不是标准的格式,或者你可能需要对数据进行一些预处理。

1. 理解数据集

- 确定数据集的结构(例如,CSV文件、图片文件夹、数据库等)。

- 了解每个数据点的格式和包含的信息。

- 确定是否有标签(监督学习)或仅有特征(非监督学习)。

2.定义数据类

- 在Python中,通常使用torch.utils.data.Dataset(PyTorch中)或类似的类(TensorFlow等)来定义你的数据集。

- 在这个类中,你需要实现__len__和__getitem__方法。

- __len__方法返回数据集的长度,

- __getitem__方法允许你通过索引访问数据集中的每个数据点。getitem接收一个index,然后返回图片数据和标签,这个index通常指的是一个list的index,这个list的每个元素就包含了图片数据的路径和标签信息。

制作list,通常的方法是将图片的路径和标签信息存储在一个txt中,然后从该txt中读取。 那么读取自己数据的基本流程就是:

- 制作存储了图片的路径和标签信息的txt;

- 将这些信息转化为list,该list每一个元素对应一个样本;

- 通过getitem函数,读取数据和标签,并返回数据和标签;

3.数据加载

在__getitem__方法中,需要编写代码来加载和预处理数据。包括读取文件、解析数据、应用转换(如缩放、归一化、裁剪等)等。

4.数据预处理

在加载数据后,可能需要进行一些预处理步骤,如数据增强(对于图像数据)、特征工程等。

这些步骤可以在__getitem__方法内部实现,也可以作为单独的函数或类。

5.批处理

使用torch.utils.data.DataLoader来加载和批处理数据。这个类允许指定批大小、是否打乱数据、使用多线程加载等。

DataLoader会调用你定义的Dataset类的__getitem__方法来获取数据,并自动进行批处理。

6.测试和调试

编写代码来测试你的数据集类,确保它能够正确地加载和预处理数据。

使用一小部分数据来测试你的模型,以确保数据加载和预处理没有问题。

7.优化和扩展

如果数据加载速度很慢,考虑使用更快的存储解决方案(如SSD)或优化你的数据加载和预处理代码。

如果你的数据集很大且不能全部加载到内存中,考虑使用流式加载或分布式加载。

下面是一个简单的PyTorch示例,展示如何定义一个自定义的数据集类:

import torch

from torch.utils.data import Dataset

class MyCustomDataset(Dataset):

def __init__(self, data_file, transform=None):

self.data = self.load_data(data_file) # 假设这是一个加载数据的函数

self.transform = transform

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

sample = self.data[idx]

if self.transform:

sample = self.transform(sample) # 应用数据转换

return sample

def load_data(self, file):

# 在这里编写代码来加载数据

# 返回一个列表或类似的数据结构,其中每个元素都是一个数据点

pass

注:上面的load_data函数是一个占位符,你需要根据你的数据集的实际格式来实现它。

同样,你可能还需要实现一个数据转换函数(在上面的示例中作为transform参数传递),以便在加载数据后对其进行预处理。

下面是本文的加载数据文件,可以对比学习。

783

783

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?