Hi,我是心觉,与你一起玩转潜意识、脑波音乐和吸引力法则,轻松掌控自己的人生!

挑战每日一省写作165/1000天

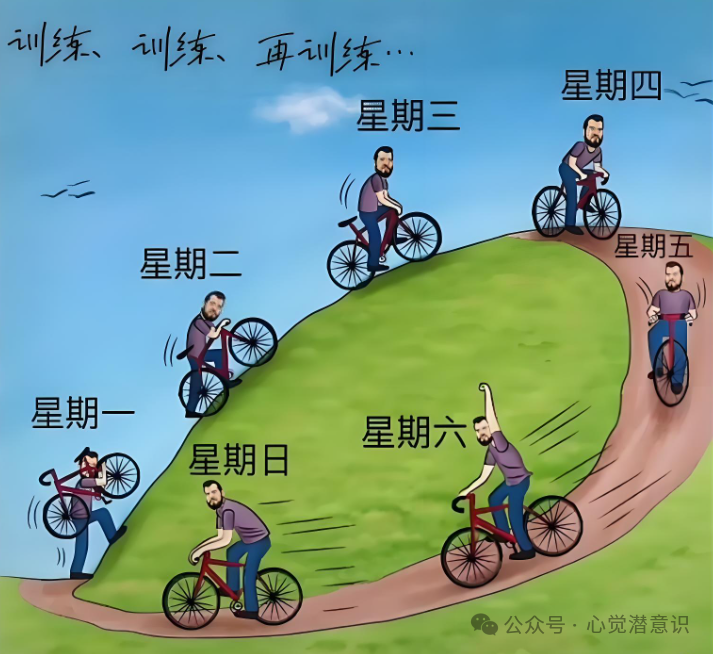

一件事情你感觉难做,还是容易做

是由什么决定的呢

很多人觉得是由事情本身决定的

其实并不是

可以说99%的事情,是由我们的心态,认知和情绪决定的

除非你做的事情是颠覆性,前无古人的才有可能是由事情本身的难度决定

为什么对于这种事情,还是用“有可能”,而不是“肯定”

因为就算是颠覆性的,前无古人的的事情,很多我们也可以拆解成我们熟悉的,已知的小事情,我们也可以从自然界中,从其他领域找到答案

比如,莱特兄弟发明飞机,看似是一项颠覆性的、前无古人的创新,但实际上它是通过对自然界鸟类飞行原理的观察、对已有技术的优化、以及将不同领域的知识灵活应用而完成的

所以,一件事情是难还是容易,主要是由这三个核心要素决定的:

-

信念系统:你是否相信自己能完成这件事?如果你有一个“我能做到”的信念系统,那么事情就会变得容易。反之,如果你心里充满了“我不行”“我做不到”的自我设限,那么任何事情都会变得无比艰难

-

看事情的角度:你的角度是消极的还是积极的,消极的人容易专注于问题和障碍,而积极的人则更关注解决方案和机会

-

变通思维:是否有变通思维非常重要,如何变通,就是举一反三和触类旁通的思维,这两个思维可以帮助你把问题化陌生为熟悉,化复杂为简单(拆解),化难为易

当然,经验和技能,外部环境和支持重不重要,重要,但是不是核心的

有了上面三个核心的要素,经验技能以及外部支持也会变得非常简单

所以,平时我们应该修炼核心要素对应的能力

打造强大的信念系统,建立无条件自信

永远保持积极乐观,看到事情好的一面

有了这三个宝藏,经验和技能堆量就能习得;没钱了,讲讲故事,风投都跟着你跑

成事也是水到渠成,自然而然的事情

8万+

8万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?