关注公众号,发现CV技术之美

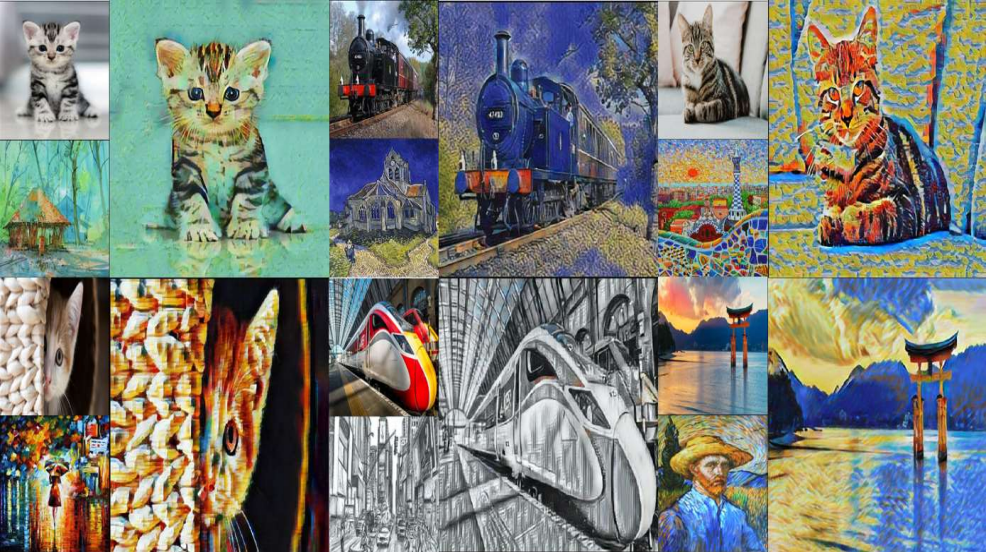

分享一篇CVPR 2024 图像风格迁移领域的一篇文章《Puff-Net: Efficient Style Transfer with Pure Content and Style Feature Fusion Network》,作者团队来自南航。

一、技术背景

风格迁移(Style Transfer)技术的目标是将一张图片的艺术风格应用到另一张图片上,同时保持原图的结构完整。近年来,这项技术在计算机视觉领域取得了显著进展,被广泛应用于艺术创作、图像增强和虚拟现实等领域。

早期的风格迁移方法主要依赖卷积神经网络(CNN),通过提取内容图像和风格图像的特征来实现图像的风格化。然而,CNN方法在处理全局信息和长距离依赖关系时存在局限性。为了解决这些问题,研究人员提出了基于Transformer的方法,这些方法在建模内容和风格图像之间的关系方面表现更好,但它们通常需要高昂的硬件成本和耗时的推理过程。

二、现有技术的问题

尽管Transformer方法在风格迁移任务中表现优异,但它们面临以下挑战:

计算成本高:传统的Transformer模型通常包括编码器和解码器,计算复杂度较高,导致推理速度慢。

内容和风格失衡:现有的方法在实现图像风格化的同时,可能会导致内容缺失或风格应用不足。

硬件要求高:这些方法通常需要高性能的硬件设备,限制了它们的广泛应用。

三、Puff-Net的技术架构和创新点

为了应对上述挑战,本文提出了一种新颖的风格迁移网络——Puff-Net。

Puff-Net的设计包括以下几个创新点:

纯内容和风格特征融合网络:

内容特征提取器:设计一个内容特征提取器,从输入图像中提取纯内容特征,确保内容信息的完整性。

风格特征提取器:设计一个风格特征提取器,从风格图像中提取纯风格特征,保证风格特征的充分表达。

简化的Transformer模型:

仅包含编码器:为了降低计算成本,Puff-Net仅使用Transformer的编码器部分,大幅减少了计算复杂度和推理时间。

高效的特征融合机制:

内容和风格特征融合:设计了一种高效的特征融合机制,将提取到的内容特征和风格特征进行有效融合,实现高质量的风格迁移。

四、实验结果

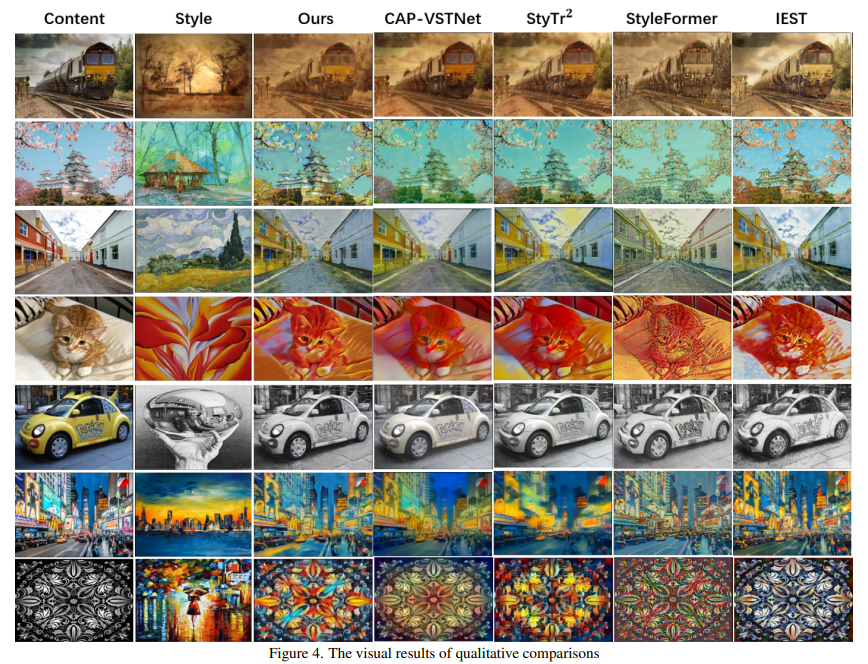

为了验证Puff-Net的有效性,研究团队进行了大量的实验,对比了现有的多种风格迁移方法。实验结果表明,Puff-Net在多个方面表现出色:

生成质量:Puff-Net生成的图像在保持内容完整性的同时,能够很好地应用风格特征,实现了高质量的风格迁移。

计算效率:由于采用了简化的Transformer架构,Puff-Net在主流算法中具有优势。

五、相关资源

论文地址:https://arxiv.org/pdf/2405.19775

代码仓库(尚未开源):https://github.com/ZszYmy9/Puff-Net

六、总结

Puff-Net通过创新的纯内容和风格特征融合网络设计,以及简化的Transformer编码器架构,在生成质量、计算效率和硬件要求方面的表现优异。使其在实际应用中具有广泛的潜力。

END

欢迎加入「图像迁移」交流群👇备注:图像迁移

1130

1130

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?