这篇笔记用来描述 2025年 发表在arxiv上的一篇有关VLA领域的论文。这篇文章没什么好说的,是Nvidia 力大砖飞的暴力美学,无论是构造数据集还是模型训练都不是一般公司和院校能够承受的,对于普通人尽管用就行_(:з」∠)_;

写在最前面

为了方便你的阅读,以下几点的注意事项请务必了解:

- 该系列文章每个字都是我理解后自行翻译并写上去的,可能会存在笔误与理解错误,如果发现了希望读者能够在评论区指正,我会在第一时间修正错误。

- 阅读这个系列需要你有基础的VLA、VLM相关基础知识,有时候我会直接使用英文名词,因为这些词汇实在不容易找到符合语境的翻译。

- 原文可能因为版面限制存在图像表格与段落不同步的问题,为了更方便阅读,我会在博文中重新对图像表格进行排版,并做到引用图表的文字下方就能看到被引用的图表。因此可能会出现一张图片在博客中多处位置重复出现的情况。

- 对于原文中的图像,我会在必要时对图像描述进行翻译并附上我自己的理解,但如果图像描述不值得翻译我也不会强行写上去。

Basic Information

- 论文标题:GR00T N1: An Open Foundation Model for Generalist Humanoid Robots

- 原文链接:https://arxiv.org/abs/2503.14734

- 发表时间:2025年03月27日

- 发表平台:arxiv

- 预印版本号:[v2] Thu, 27 Mar 2025 02:52:43 UTC (23,027 KB)

- 作者团队:NVIDIA: Johan Bjorck, Fernando Castañeda, Nikita Cherniadev, Xingye Da, Runyu Ding, Linxi “Jim” Fan, Yu Fang, Dieter Fox, Fengyuan Hu, Spencer Huang, Joel Jang, Zhenyu Jiang, Jan Kautz, Kaushil Kundalia, Lawrence Lao, Zhiqi Li, Zongyu Lin, Kevin Lin, Guilin Liu, Edith Llontop, Loic Magne, Ajay Mandlekar, Avnish Narayan, Soroush Nasiriany, Scott Reed, You Liang Tan, Guanzhi Wang, Zu Wang, Jing Wang, Qi Wang, Jiannan Xiang, Yuqi Xie, Yinzhen Xu, Zhenjia Xu, Seonghyeon Ye, Zhiding Yu, Ao Zhang, Hao Zhang, Yizhou Zhao, Ruijie Zheng, Yuke Zhu

- 院校机构:

- Nvidia;

- GitHub仓库:https://github.com/NVIDIA/Isaac-GR00T

Abstruct

通用机器人需要一个多功能的身体和一个智能的大脑。近年人形机器人在硬件平台方面取得了重大进展,为构建适用于人类世界的通用自主系统提供了良好的基础。一个经过大规模、多样化数据训练的机器人基础模型,对机器人在新场景推理能力、稳健地应对现实世界变化、快速学习新任务等等能力至关重要。作者提出了 GR00T N1,一个面向人形机器人的开放式基础模型。GR00T N1 是一个 VLA 模型,采用双系统架构。其中视觉-语言模块(System 2) 通过视觉和语言指令解析环境,随后接入的扩散 Transformer 模块(System 1) 则用于实时生成流畅的运动控制信号。这两个模块紧密耦合,并采用端到端联合训练方式。作者使用异构数据集对 GR00T N1 进行训练,包括真实机器人轨迹数据、人类视频数据、合成的数据集。实验结果表明,通用机器人模型 GR00T N1 在多个机器人形态的标准仿真基准测试中,均优于STOA模仿学习基线方法。作者还将该模型部署在 Fourier GR-1 人形机器人上,以执行语言指令控制的双手操作任务,并取得了高效的数据利用率和优异的任务执行表现。

1. Introduction

在现实世界中创建能够执行日常任务的自主机器人一直是一个吸引人的目标,同时也是一项重大的技术挑战。近年来随着机器人硬件、人工智能、加速计算共同进步,为通用机器人自主系统的发展奠定了基础。为了得到人类水平智能(human-level physical intelligence),作者主张采用全栈解决方案(full-stack solution),将硬件、模型、数据这三个关键要素紧密集成。首先,机器人是具身的物理智能体,硬件决定了其能力范围。人形机器人因其类人体型和多功能性,成为构建机器人智能的理想形态。其次,现实世界的多样性和不确定性要求机器人能够适应开放式目标执行广泛的任务,这需要一个具备足够表达能力的通用机器人模型以处理各种任务。最后,获取大规模的真实人形机器人数据成本高昂且耗时,因此需要一种高效的数据策略,以支持大规模机器人模型的训练。

近年来,基础模型在理解和生成视觉及文本方面取得了突破性进展。它们证明了在互联网级规模数据上训练通用模型的有效性,其具备强大的泛化能力并能快速适应下游任务。基础模型在人工智能领域的成功,为构建通用机器人智能的“骨干”(backbone) 提供了一条有前景的路线,使机器人能够具备一系列核心能力,并在现实世界中快速学习和适应。然而,与基于文本和图像的数字领域不同,目前并不存在可用于大规模预训练的人形机器人数据集。对于任何单一的人形机器人硬件而言,其可用数据的规模通常小几个数量级。近年来,机器人学习领域的一些研究(例如 Open X-Embodiment Collaboration et al., 2024)探索了跨具身学习(cross-embodied learning),试图通过整合不同机器人的训练数据来扩大数据集。然而,由于机器人在具身结构、传感器、执行器自由度、控制模式等方面存在巨大差异,这些数据最终更像是分散的数据孤岛,而非训练真正通用模型所需的、类似互联网级规模的统一数据集。

作者提出了 GR00T N1,一个面向通用人形机器人的开放式基础模型。GR00T N1 是一个VLA模型,能够根据图像和语言指令生成动作,并支持跨具身结构,适用于从桌面级机械臂到高自由度的人形机器人。该模型采用双系统组合架构(dual-system compositional architecture),其设计灵感来源于人类认知过程,其中:

- System 2 reasoning module: 是一个预训练的VLM,在 NVIDIA L40 GPU 上以 10Hz 运行。该模块处理机器人的视觉感知和语言指令,以解析环境并理解任务目标。

- System 1 action module: 是一个基于Diffusion Transformer 的模型,经过动作流匹配训练。该模块交叉注意 VLM 的输出 token,并利用具身结构特定的编码器和解码器,处理不同机器人形态下的状态和动作维度,实现运动生成。它以更高的频率(120Hz)生成闭环运动控制信号。

System 1 和 System 2 均采用基于 Transformer 的神经网络实现,在训练过程中紧密耦合并进行联合优化,以促进推理与运动控制的协调。

为缓解前述的数据孤岛问题,作者将 VLA 训练数据集组织为数据金字塔,如 Figure 1 所示。与其将训练数据集视为一个同质的数据池,作者任务不如根据数据来源的规模对其进行分层结构化组织:

- 金字塔底层(Web Data & Human Videos):由大规模网络数据和人类视频组成,为训练提供视觉和行为先验;

- 金字塔中层(Sythetic Data):由物理仿真生成的数据、现成神经网络模型增强的合成数据构成,作为过渡层提供更加贴近真实环境的训练信号;

- 金字塔顶层(Real-World Data):由真实机器人硬件采集的数据构成,以确保模型能够在具身智能环境中执行任务;

这种分层结构使得金字塔下层提供广泛的视觉和行为先验,而上层则保证模型能够在真实具身环境中执行任务,从而平衡数据规模与现实适应性的问题。

作者开发了一种高效的协同训练策略,使模型能够在预训练和后训练阶段中同时利用整个数据金字塔进行学习。在训练过程中,为了利用无动作数据源(如人类视频和神经网络生成的视频),采用了以下技术:

- 学习一个潜在动作码本(latent-action codebook),用于从视频数据中提取隐式的动作表示;

- 训练并使用逆动力学模型(Inverse Dynamics Model, IDM) 推断伪动作,从而自动标注这些视频中的机器人动作;

这两个方法能够在无动作视频上生成动作标注,其可以作为额外的机器人具身数据从而扩充训练集。通过整合数据金字塔中的所有数据源,构建了一个一致的数据集:

- input:机器人状态、视觉观测、语言指令;

- output:相应的运动控制信号;

模型在端到端预训练过程中,跨越三个数据层进行学习,涵盖标注的视频数据集、合成的数据集、真实机器人轨迹。训练时,从这一异构数据集中抽样训练batch,以确保模型具备广泛的泛化能力和现实适应性。

GR00T N1 采用统一模型和单一权重集,能够在单臂、双臂、人形机器人具身结构下生成多样化的操作行为。在标准仿真基准环境上进行评估时,GR00T N1 的表现优于当前最先进的模仿学习baseline。此外,在GR-1 人形机器人上进行了真实世界实验,进一步验证了 GR00T N1 的卓越性能。GR00T-N1-2B 模型的checkpoint、训练数据、仿真基准测试已在 GitHub 和 HuggingFace Datasets 上公开提供。

2. GR00T N1 Foundation Model

GR00T N1 是一个针对人形机器人训练的VLA,基于多样化的数据源进行训练。该模型包括:

- VL backbone:用于编码语言和图像输入;

- 基于 DiT 的流匹配策略:用于生成高频控制动作;

采用 NVIDIA Eagle-2 VLM 作为VL backbone,在公开的 GR00T-N1-2B 模型总参数量为 2.2B,其中 VLM 组件包含 1.34B 。在 L40 GPU 上使用 bfloat-16进行推理时,采样 16 个动作的推理时间为 63.9ms。Figure 2 提供了模型设计的高层概览。

GR00T N1 有三个关键特性:

- 组合式模型(Compositional Model):一个统一学习框架集成了基于 VLM的推理模块(System 2)和基于 DiT 的动作模块(System 1),实现从视觉语言输入到高频运动控制的端到端学习;

- 高效预训练策略(Effective Pre-Training Strategy):一种高效的预训练策略,利用人类视频、仿真数据、神经轨迹生成数据 、真实机器人演示数据(见

Figure 1),以增强模型的泛化能力和鲁棒性; - 大规模多任务、语言条件控制策略(Massively Multi-Task, Language-Conditioned Policy):训练了一种大规模多任务的语言条件控制策略,支持多种机器人具身结构,并通过数据高效的后训练实现对新任务的快速适应;

2.1 Model Architecture

在本节中,将描述 GR00T N1 模型架构,如 Figure 3 所示。

GR00T N1 使用流匹配方法来学习动作生成。DiT 处理机器人的本体状态和动作,然后与来自 Eagle-2 VLM 的图像和文本 token 进行交叉注意,以生成去噪后的运动控制动作。

State and Action Encoders

为了处理不同机器人具身结构中维度各异的状态和动作,作者为每种具身结构使用一个MLP,将这些状态和动作映射到一个共享的嵌入空间维度,并作为输入传递给 DiT。动作编码器 MLP还会同时编码扩散时间步(diffusion timestep)和带噪声的动作向量(noised action vector)。

使用动作流匹配,通过迭代去噪的方式来采样动作。模型除了输入带噪声的动作外,还输入机器人的本体状态编码、图像 token、文本 token。这些动作是以 chunks 的方式进行处理,意味着在任何给定的时间步 t t t,模型使用 A t = [ a t , a t + 1 , ⋯ , a t + H − 1 ] A_{t}=[a_{t},a_{t+1},\cdots,a_{t+H-1}] At=[at,at+1,⋯,at+H−1] 动作序列,其中包含从时间步 t t t 到 t + H − 1 t+H-1 t+H−1 的动作向量。在坐着的实现中设置 H = 16 H = 16 H=16。

Vision-Language Module (System 2)

为了编码视觉和语言输入,GR00T N1 使用 Eagle-2 VLM,该模型在互联网规模的数据上进行预训练。Eagle-2 是从 SmolLM2 和 SigLIP-2 图像编码器微调而来。图像在 224 × 224 的分辨率下进行编码,之后通过像素重排进行处理,最终得到每帧图像的 64 个图像 token 嵌入。这些嵌入与文本一同由 Eagle-2 VLM 中的 LLM 组件进一步编码。LLM 和图像编码器在广泛的VL任务上进行了对齐。

在策略训练过程中,任务的文本描述以及图像以聊天格式传递给 VLM。然后,从 LLM 中提取 shape=(batch size × sequence length × hidden dimension) 的VL feature。作者发现,使用 LLM 中间层的嵌入相比于使用最终层嵌入,能够显著提高推理速度并提高后续策略的成功率。对于 GR00T-N1-2B 模型,使用第 12 层的表示作为输入特征。

Diusion Transformer Module (System 1)

为了对动作进行建模,GR00T N1 使用了 DiT 的变体,DiT 是一种带有去噪步骤条件的 Transformer,通过自适应层归一化来进行条件化,记作

V

θ

V_{\theta}

Vθ,如Figure 3 所示。

V

θ

V_{\theta}

Vθ 包含交替的交叉注意力和自注意力模块,类似于Flamingo 和 VIMA。自注意力块操作带噪声的动作 token 嵌入

A

t

τ

A_{t}^{\tau}

Atτ 和状态嵌入

q

t

q_{t}

qt,而 交叉注意力块令模型能够基于来自 VLM 的视觉-语言 token 嵌入

ϕ

t

\phi_{t}

ϕt 条件化。经过最终的 DiT 块后,将具身特定的动作解码器应用于最后的

H

H

H 个 token,该解码器是另一个 MLP 用于预测动作。

对于给定真值的action chunk A t A_{t} At;流匹配时间步长 τ ∈ [ 0 , 1 ] \tau\in[0,1] τ∈[0,1] 和采样噪声 ϵ ∼ N ( 0 , I ) \epsilon\sim N(0,I) ϵ∼N(0,I);带有噪声的action chunk A t τ A_{t}^{\tau} Atτ 之间的关系为 A t τ = τ A t + ( 1 − τ ) ϵ A^{\tau}_{t}=\tau A_{t}+(1-\tau)\epsilon Atτ=τAt+(1−τ)ϵ ;模型的预测结果 V θ ( ϕ t , A t τ , q t ) V_{\theta}(\phi_{t},A^{\tau}_{t},q_{t}) Vθ(ϕt,Atτ,qt) 旨在通过最小化以下损失函数来逼近去噪后的向量场 ϵ − A t \epsilon-A_{t} ϵ−At:

L f m ( θ ) = E τ [ ∥ V θ ( ϕ t , A t τ , q t ) − ( ϵ − A t ) ∥ 2 ] L_{fm}(\theta)=E_{\tau}[\|V_{\theta}(\phi_{t},A^{\tau}_{t},q_{t})-(\epsilon-A_{t})\|^{2}] Lfm(θ)=Eτ[∥Vθ(ϕt,Atτ,qt)−(ϵ−At)∥2]

在实际使用中令 p ( τ ) = B e t a ( s − τ s ; 1.5 ; 1 ) , s = 0.999 p(\tau)=Beta(\frac{s-\tau}{s};1.5;1), s=0.999 p(τ)=Beta(ss−τ;1.5;1),s=0.999。在推理过程中,通过 K K K 步去噪来生成动作块 A t A_{t} At。首先,随机采样初始噪声 A t 0 ∼ N ( 0 , I ) A_{t}^{0}\sim N(0,I) At0∼N(0,I),然后使用前向欧拉积分迭代生成动作块,更新过程如下:

A t τ + 1 / K = A t τ + 1 K V θ ( ϕ t , A t τ , q t ) A_{t}^{\tau+1/K}=A^{\tau}_{t}+\frac{1}{K}V_{\theta}(\phi_{t},A^{\tau}_{t},q_{t}) Atτ+1/K=Atτ+K1Vθ(ϕt,Atτ,qt)

在实际使用过程中发现 K = 4 K=4 K=4 时效果最好。

2.2 Training Data Generation

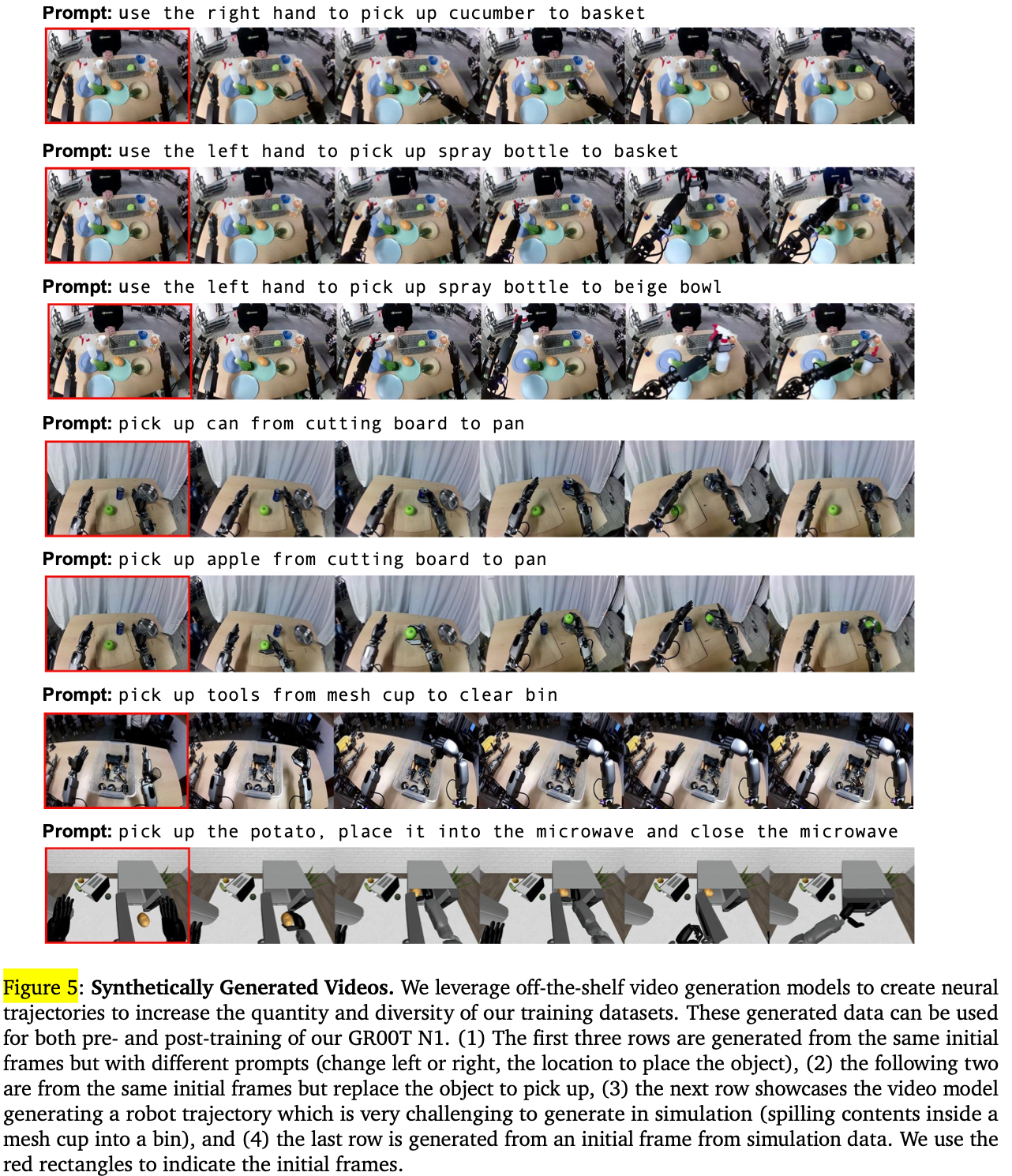

为了训练 GR00T N1,坐着使用多种数据源和目标构建数据金字塔(Figure 1)。首先从开放数据集中获取多样的以人为中心的视频数据,这些数据构成了金字塔的基础,还包括在 VLM 预训练中使用的网页数据。接下来,使用预训练的视频生成模型生成合成轨迹。通过这种方式,将自己采集的遥操作轨迹 —— 即数据金字塔的“顶端” —— 从 88 小时 扩展到 827 小时,采用多样的反事实机器人轨迹和新颖的语言指令(Figure 5 以获取示例)。此外还生成了多样的仿真轨迹,这些数据进一步扩展了金字塔的中间部分。

在接下来的段落中,首先描述如何从视频中提取潜在的动作,这些动作将用于从互联网规模的数据中提取以人为中心的人类数据集的标签。接着,描述如何使用生成神经轨迹和仿真机器人的轨迹,以及如何为每个数据源获取相应的动作。

Latent Actions

对于以人为中心的视频和神经轨迹,没有任何可以直接用来训练 GR00T N1 的动作标签。针对这些数据,通过训练VQ-VAE 从视频中的连续图像帧中提取特征,从而生成潜在动作。编码器接受当前帧

x

t

x_{t}

xt 和具有固定窗口大小

H

H

H 的视频未来的帧

x

t

+

H

x_{t+H}

xt+H,输出潜在动作

z

t

z_{t}

zt。解码器的目标是接收潜在动作

z

t

z_{t}

zt 和当前帧

x

t

x_{t}

xt,并重建未来帧

x

t

+

H

x_{t+H}

xt+H。该模型使用 VQ-VAE 进行训练,其中编码器的连续嵌入被映射到codebook中最接近的嵌入。训练完成后,使用编码器作为逆动力学模型;给定一对

x

t

x_{t}

xt 和

x

t

+

H

x_{t+H}

xt+H 图像,提取连续的预量化嵌入,并在预训练过程中将其作为潜在动作标签,使用相同的流匹配loss,但将其视为一个独立的“LAPA”形态。

通过在所有异质数据上一起训练 VQ-VAE 模型,能够将所有数据统一到共享相同的潜在动作空间中,从而可能改善跨形态的泛化能力。Figure 4 展示了来自 8 种不同形态的

x

t

x_{t}

xt 和

x

t

+

H

x_{t+H}

xt+H 对,包括机器人和人类形态,所有这些都从类似的潜在动作中提取;第一个潜在动作显示所有形态将右臂移向左侧,第二个潜在动作显示将右臂移向右侧。

Neural Trajectories

机器人数据的规模与人类劳动量呈线性关系,因为通常需要人类操作者远程控制机器人来生成每条轨迹。然而,最近的视频生成模型展现出了强大的高质量可控视频生成能力,为在机器人领域构建世界模型奠定了基础。为了充分利用这些模型,坐着对 image-to-video 生成模型进行微调,使用 88 小时的自采远程操作数据进行训练,并基于已有的初始帧和新颖的语言指令生成827 小时的合成视频数据,扩展规模约为 10 倍。这一方法能够生成包含更多反真实场景的训练数据,而无需实际采集每种情况下的远程操作数据(示例见 Figure 5,更多生成示例见Figure 14)。

为了增加神经轨迹的多样性,首先使用商用级多模态LLM对初始帧进行目标检测,并生成多种可能的操作组合,例如:“从 {location A} 拿起 {object} 并放到 {location B}”。在此过程中,要求模型仅考虑物理可行的组合,避免生成不符合物理规律的任务描述。此外,引入了后处理机制(post-processing mechanisms),包括:

- 过滤(Filtering):使用商用级多模态 LLM 作为判定器,输入降采样后的 8 帧图像,筛选出未严格遵循语言指令的神经轨迹,并剔除这些不符合要求的样本;

- 重标注(Re-captioning):对筛选后的视频进行新描述,确保生成的视频数据具有清晰、准确的任务指令;

更多细节可见Appendix E。

Simulation Trajectories

由于双臂和灵巧手的协同控制难度较高,人形机器人采集真实世界数据的成本极其昂贵。近年来,研究表明在仿真环境中生成训练数据是一种可行的替代方案,作者采用 DexMimicGen来大规模合成机器人操作轨迹,以增强训练数据集并提高模型泛化能力。

DexMimicGen 以少量真人演示为起点,通过仿真中的演示变换与回放,自动扩展数据集。数据扩展方法如下:

- 任务分解:每个任务被划分为以物体为中心的子任务;

- 轨迹分割:初始真人演示被拆分为更小的操作序列,每个子序列对应单个物体的交互;

- 环境适配:子任务轨迹被重新对齐至新环境中的物体位置,同时保持机器人末端执行器与物体的相对位姿;

- 轨迹插值:为了保证运动的流畅性,系统会在机器人当前状态与变换后的轨迹片段之间进行插值;

- 成功验证:机器人按完整序列执行任务,仅保留成功的演示确保数据质量;

使用 DexMimicGen,将有限的真人演示扩展为大规模人形机器人操作数据集。生成 78 万条仿真轨迹(共 6500 小时 ≈ 9 个月 的真人演示数据)仅花费了 11 小时,大幅减少真人操作成本。这些仿真数据有效补充了真实机器人数据,极大提高了训练数据的丰富度与多样性。

2.3 Training Details

Pre-training

在预训练阶段,GR00T N1 通过流匹配损失(Equation 1)进行训练,涵盖了多种机器人形态与数据来源,包括真实机器人数据集、合成机器人数据集、人类动作数据。

L f m ( θ ) = E τ [ ∥ V θ ( ϕ t , A t τ , q t ) − ( ϵ − A t ) ∥ 2 ] L_{fm}(\theta)=E_{\tau}[\|V_{\theta}(\phi_{t},A^{\tau}_{t},q_{t})-(\epsilon-A_{t})\|^{2}] Lfm(θ)=Eτ[∥Vθ(ϕt,Atτ,qt)−(ϵ−At)∥2]

这些多样化的数据使 GR00T N1 能够适应不同的机器人形态,并具备跨模态泛化能力。有关数据集的详细介绍,详细内容将在第三章介绍。

- 对于人类视频数据,由于缺乏真实的动作标签,作者手动提取学习到的潜在动作,并将其用作流匹配的目标;

- 对于机器人数据集(如 GR-1 仿人机器人数据或 Open X-Embodiment 数据),作者同时使用:真实机器人动作标签、学习到的潜在动作;

- 对于神经轨迹用于增强机器人数据集,使用潜在动作、基于真实机器人数据训练的逆动力学模型预测的动作;

Post-training

在后训练阶段,对预训练模型进行微调,使其适应每种特定的机器人形态对应的数据集。与预训练阶段类似:冻结 VL backbon 中的语言组件、微调模型剩余部分。

Post-training with Neural Trajectories

为了解决后训练阶段数据稀缺的问题,采用神经轨迹生成的方式来增强数据集:

- 多视角任务:微调视频模型,使其能够以网格方式生成多个子图像;

- 仿真任务:从随机初始化的环境中收集多样化的初始帧;

- 真实机器人任务:手动随机初始化物体的姿态,并记录机器人初始观察到的数据。

此外,还探索了其他增强方法:

- 使用

img2img duffusion自动生成新的初始帧(示例见Figure 14); - 多轮视频生成(multi-round video generation):用于生成由多个子任务组成的长时序轨迹;

- 神经轨迹模拟液体和关节物体,这类对象在仿真中极具挑战性;

在后训练阶段的神经轨迹微调流程中,采取以下策略,以符合现实场景中遥操作数据有限的情况:

- 受限数据训练策略:

- 对于仿真任务,仅微调视频生成模型,且仅使用人工收集的轨迹;

- 对于真实世界基准数据,仅使用 10% 进行后训练,以匹配有限遥操作数据的假设;

- 无动作标签数据的处理:

- 由于生成的视频不包含动作标签,采用潜在动作或逆动力学模型标注的伪动作作为训练目标;

- 训练策略:让策略模型将这些伪动作视为不同机器人形态的标准动作标签;

- 低数据场景的额外限制:

- 在低数据场景下,仅使用低数据训练 IDM 模型,以更加符合现实可行性;

- IDM 训练细节请参考Appendix E。

- 神经轨迹与真实轨迹的联合训练:

- 在后训练阶段,以1:1 采样比对策略模型进行真实轨迹与神经轨迹的联合训练(co-training);

- 第 4.4 节提供了潜在动作和IDM 标注动作之间的实证对比。

Training Infrastructure

使用 NVIDIA OSMO 进行 GR00T N1 的训练管理,这是一个用于扩展复杂机器人工作负载的编排平台。训练集群配备 H100 NVIDIA GPU,最大支持 1024 张 GPU 训练单个模型。采用 NVIDIA Quantum-2 InfiniBand,使用 fat-tree topology 进行高效通信;训练框架基于 Ray 分布式计算库;

为提高容错性和数据IO效率,构建了自定义分布式训练库。GR00T-N1-2B 预训练阶段共使用约 50,000 H100 GPU 小时。

在计算资源受限的情况下,针对 A6000 GPU 进行微调的测试结果如下:

- 仅微调适配器层(adapter layers)(包括动作和状态编码器、动作解码器)及 DiT时 batch_size=200;

- 微调视觉编码器时 batch_size=16;

试验结果表明,在计算资源有限的情况下,微调适配器层和 DiT 可以处理较大的批次大小,而微调视觉编码器则需要较小的批次大小以适应 GPU 内存限制。

3. Pre-Training Datasets

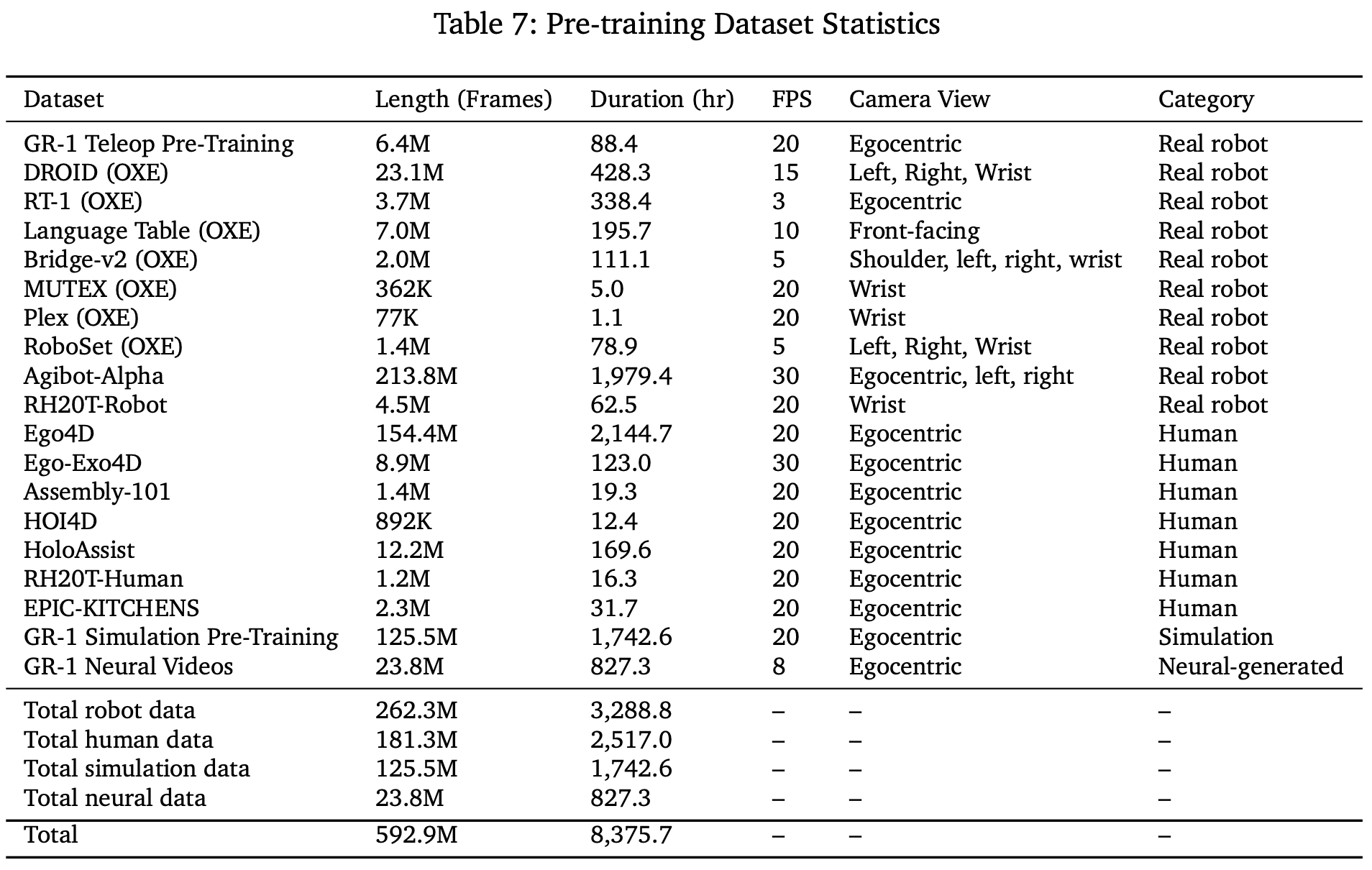

在预训练数据集中,将其结构化为三个主要类别:真实机器人数据集、合成数据集、人类视频数据集。这些类别大致对应于数据金字塔的顶层、中层、底层(Figure1)。其中合成数据集包括模拟轨迹和神经轨迹。Table 1总结了训练数据生成策略及其对应的适用数据源, Table 7中提供了完整的预训练数据集统计信息,包括帧数、小时数和相机视角数。

3.1 Real-World Datasets

作者使用下面的数据作为真实训练数据集:

- GR00T N1 人形机器人预训练数据集:自己内部采集的数据集涵盖了广泛的通用操作任务,重点是通过遥操作控制的

Fourier GR1机器人。利用VIVE Ultimate Tracker捕捉遥操作员的腕部姿势,同时Xsens Metagloves跟踪手指的运动。还探索了其他遥操作硬件选项,包括Apple Vision Pro和Leap Motion(见Figure6)。记录下的人类动作随后通过逆向运动学转化为人形机器人的动作。实时遥操作的控制频率为 20Hz。除机器人的动作外,还在每一步捕捉来自头戴式相机的图像,以及人类的低维本体感知和动作。该数据集包括细粒度注释,详细说明诸如抓取、移动和放置等原子动作,并提供粗粒度注释,将细粒度动作序列聚合为更高层次的任务表示。这种层级结构支持精确的运动控制学习和高层次任务推理。

- Open X-Embodiment:Open X-Embodiment 是广泛使用的跨体型数据集,专注于机器人操作任务。包括了

RT-1、Bridge-v2、Language Table、DROID、MUTEX、RoboSet、Plex,这些数据集提供了多种操作任务、语言条件控制和机器人与环境交互的多样化数据。 - AgiBot-Alpha:AgiBot-World-Contributors et al. 是一个大规模的机器人轨迹数据集,涵盖了来自 100 台机器人的 140,000 条轨迹。该数据集涵盖了细粒度的操作、工具使用和多机器人协作。

3.2. Synthetic Datasets

合成的数据集包括:模拟轨迹:这些轨迹是通过物理模拟器自动从少量人类演示中生成的。这种方法利用了仿真技术,能够有效扩展数据集的规模,并生成多样化的任务场景;神经轨迹:这些轨迹源自通过现成的神经生成模型生成的视频。通过视频生成模型,可以创造出各种虚拟环境中的机器人操作轨迹,从而进一步丰富训练数据,尤其是在数据稀缺的情况下,神经生成的轨迹可以作为重要的补充。

Simulation Trajectories

除了现实世界的数据集,还展示了在仿真中生成的大规模合成数据集,如第2.2节所述。仿真任务包括人形机器人执行的桌面物品重新排列任务,并且特征包含了大量逼真的3D资产。这些任务是基于RoboCasa仿真框架构建的。总体而言,任务遵循 “将A从B重新排列到C” 这一行为模式,其中A代表一个物体,B和C表示环境中的源位置和目标位置。源和目标位置是容器,如盘子、篮子、桌垫和架子,机器人必须在不同组合的源和目标容器之间重新排列物品。预训练仿真数据集内涵54种不同的源和目标容器类别组合。将物体和容器随机放置在桌面上的不同位置,并在场景中加入干扰物体和容器。干扰物要求模型根据任务语言来关注执行所需的行为。

通过使用 DexMimicGen生成大规模生多样化的高质量训练数据集。以GR-1人形机器人为特征,但该系统可以适用于多种不同的机器人。首先通过使用 Leap Motion 设备收集几十个源示范。Leap Motion 设备跟踪6自由度的手腕姿态和手指姿态,将这些值重新映射并传递给基于 Mink的全身逆向运动学控制器。在获得人类示范后,DexMimicGen 将这些示范处理为以物体为中心的子任务,并通过变换和组合这些子任务生成新的示范。利用该系统为每个源或目标容器对生成了10,000个新的示范,最终生成了540,000个示范用于预训练任务。

Neural Trajectories

为了生成神经轨迹,在现实世界GR00T N1人形预训练数据集上微调开源的image-to-video生成模型。在包含3,000个带有语言注释的现实世界机器人数据样本的数据集上训练了模型,数据每个样本记录为480P分辨率,并包含81帧图像,训练周期为100个epoch。如 Figure 5 所示,模型能够根据新颖的语言提示生成高质量的反事实轨迹。此外,该模型在处理未见过的初始帧、新对象和新运动模式方面展示了强大的泛化能力。生成的视频进一步标注了潜在动作和基于IDM的伪动作,用于模型训练。总共生成了约827小时的视频,使用L40 GPU生成一秒的视频大约需要2分钟,整个过程在3,600台L40 GPU上花费了大约105,000 L40 GPU小时(约1.5天)。

3.3 Human Video Datasets

还包括了一套多样的人类视频数据集。这些数据集没有明确的动作标签,但包含了大量的人类与物体互动的序列,捕捉了物体使用规律、任务语义和自然的运动模式。这些数据集覆盖了广泛的现实世界人类行为,包括抓取、工具使用、烹饪、组装以及在自然环境中执行的其他任务导向活动,并提供了详细的第一人称视角的手-物体互动(Figure 11中所示)。视频数据集包括以下内容:

- Ego4D: 一个大规模的以第一人称的视频数据集,其中包括日常活动的各种记录;

- Ego-Exo4D: 在第一人称视频中同时添加了互补的第三人称视角;

- Assembly-101: 提供了物体逐步组装详细视频,专注于复杂的组装任务;

- EPIC-KITCHENS: 第一人称的烹饪视频;

- HOI4D: 捕捉人与物体的交互,并逐帧注释以进行分割、手部和物体的姿势以及动作;

- HoloAssist:捕获增强现实环境中的协作和辅助任务;

- RH20T-Human: 包括细粒度操作任务的记录,重点关注各种现实世界场景中的自然手部与物体的交互;

4. Evaluation

作者在一套多样化的模拟和现实世界基准测试上评估了的 GR00T N1 模型。模拟实验在三个不同的基准上进行,旨在系统地评估模型在各种机器人外形和操控任务中的有效性;现实世界实验中,研究了该模型在 GR-1 人形机器人执行一系列桌面操控任务中的表现。这些实验旨在展示 GR00T N1 从有限的人工示范中学习新技能的能力。

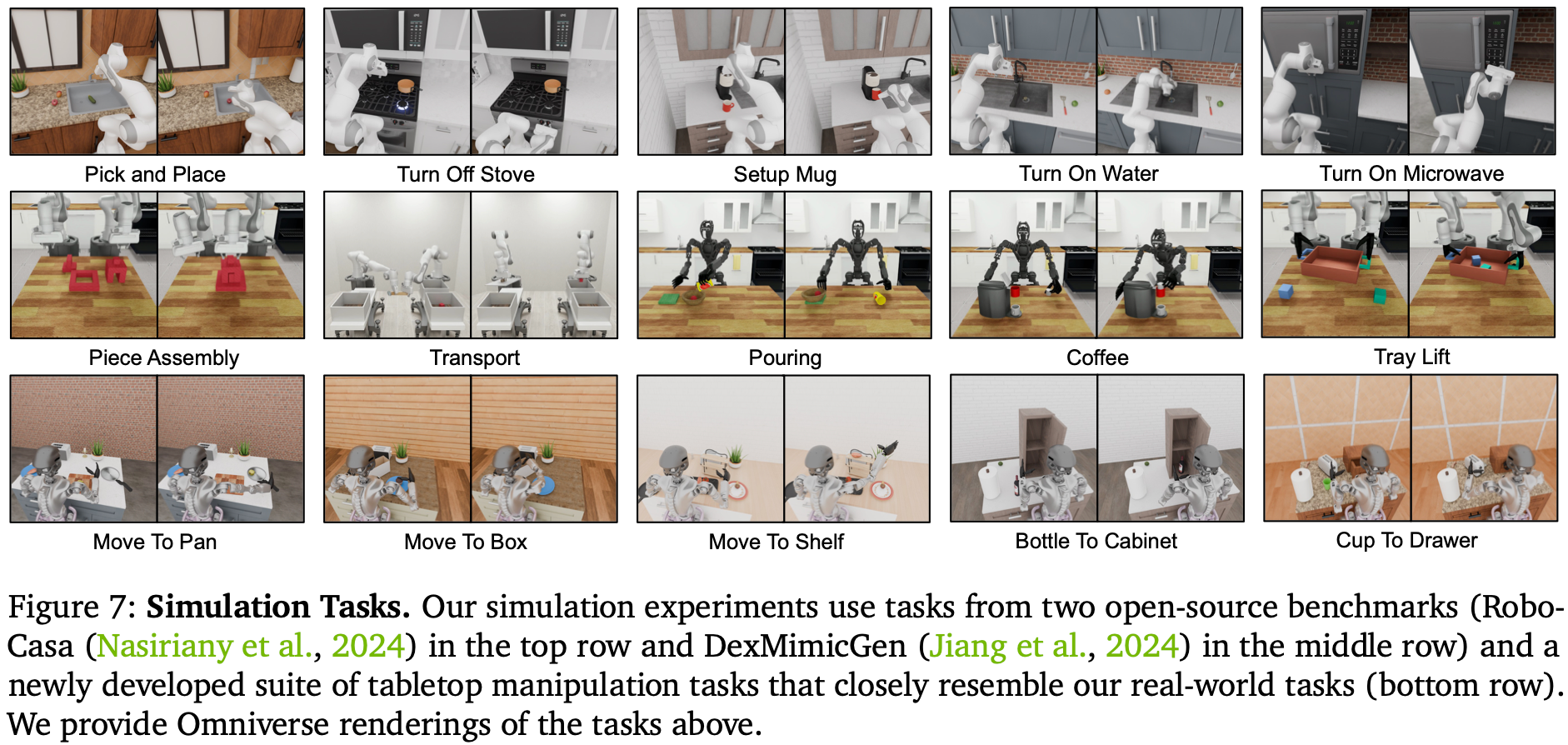

4.1 Simulation Benchmarks

模拟实验包括来自先前工作的两个开源基准,以及一套新开发的桌面操控任务,旨在尽可能接近现实世界任务配置。在不同的机器人外形和多样化的操控任务中评估模型。模型checkpoint、公开可用的模拟环境、数据集,确保了结果的可重现性。Figure 7 展示了这三个基准中的一些示例任务。

- RoboCasa Kitchen (24 tasks, RoboCasa)

RoboCasa 提供了一组模拟厨房环境中的任务,该数据集包含3000个示范。这里关注24个“原子”任务,这些任务涉及基础的传感运动技能,如捡放物体、开关门、按按钮、转动水龙头等。对于每个任务使用Franka Emika Panda机械臂生成,所有示范都通过MimicGen生成。Observation Space 包括来自左、右和手腕位置的三个RGB图像;State 表示包括末端执行器和机器人底座的位置和旋转,以及夹持器的状态;Action Space 由末端执行器的相对位置和旋转以及夹持器状态定义。 - DexMimicGen Cross-Embodiment Suite (9 tasks, DexMG)

DexMimicGen包括一系列9个双臂精密操作任务,这些任务需要精确的双臂协调。整体任务覆盖了三种双臂机器人外形:(1)使用平行钳形夹具的双臂Panda:任务包括穿线、拼接和搬运。State/Action Space包括两个臂的末端执行器位置和旋转以及夹持器状态;(2)使用灵巧手的双臂Panda:任务包括盒子清理、抽屉清理和托盘提升。State/Action Space包括两个臂和双手的末端执行器位置和旋转;(3)使用灵巧手的GR-1人形机器人:任务包括倒水、咖啡准备和罐子分类。State/Action Space包括两个臂和双手的关节位置和旋转,以及腰部和颈部的位置和旋转。用DexMimicGen数据生成系统为每个任务生成1000个示范,并评估模型在新物体配置上的泛化能力。 - GR-1 Tabletop Tasks (24 tasks, GR-1)

此数据集是现实世界人形机器人数据集的数字化对照便于系统评估,进而指导现实机器人部署的性能。此基准专注于使用GR-1人形机器人进行精巧的手部控制,GR-1配备了傅里叶灵巧手。与DexMG相比,该基准涉及的物体种类更多且布置更为多样。总共建模了18个重排任务,这些任务与第3.2节中描述的预训练任务结构相似,即将物体从源位置搬到目标容器中。每个任务都涉及独特的容器组合,而这些组合在预训练数据中并未出现。大多数任务涉及干扰物体和容器,这要求模型关注任务指令。此外还额外还包含了六个任务,涉及将物体放入关节式物体(如橱柜、抽屉和微波炉)并关闭它们。Observation Space 包括从安装在机器人头部的第一人称相机捕获的RGB图像。State/Action Space包括两个臂和双手的关节位置和旋转,以及腰部和颈部的位置和旋转。还可以选择在数据集中包含基于末端执行器的动作,用于控制臂部,因为控制整个身体IK控制器的原生动作空间是基于末端执行器的。每个任务使用DexMimicGen系统生成1000个示范。

4.2 Real-World Benchmarks

对于真实世界的benchmarks,引入了一组多样的桌面操作任务,旨在评估和后训练模型,以应对人类示范性能。这些任务强调现实世界灵巧性的重要方面,包括精确的物体操控、空间推理、双手协调和多智能体协作。基准任务分类为四种不同类型,以确保对模型性能进行严格评估。Figure 9展示了一些来自现实世界基准任务的示例任务。

- Object-to-Container Pick-and-Place (5 tasks, Pick-and-Place)

这一类别评估模型抓取物体并将其放入指定容器的能力。任务包括将物体从常见家庭容器(如托盘、盘子、切菜板、篮子、餐垫、碗和锅)之间转移。这些场景测试精细的运动技能、空间对齐能力以及适应不同物体几何形状的能力。为了严格评估泛化能力,在已见和未见物体上都评估模型的表现。 - Articulated Object Manipulation (3 tasks, Articulated)

这些任务评估模型操作关节存储隔间的能力。模型必须抓取物体,将其放入如木箱、黑色橱柜或白色抽屉等存储单元中,然后关闭隔间。这些任务中包含了在有限空间内精确放置和约束运动控制的挑战。泛化能力通过已见和未见物体进行测试。 - Industrial Object Manipulation (3 tasks, Industrial)

为工业场景设计了一个类别,其中涉及三个结构化工作流程和基于工具的交互:1)机械零件包装:抓取各种机械零件和工具并放入指定的黄色垃圾桶;2)网状杯倒料:抓取包含小型工业部件(如螺丝和螺母)的网状杯,并将其内容物倒入塑料桶中;3)圆柱体交接:抓取圆柱形物体,将其从一只手转移到另一只手,并将其放入黄色垃圾桶中。这些任务紧密模拟了现实世界中的工业应用,是评估在结构化环境中灵巧性的相关基准任务。 - Multi-Agent Coordination (2 tasks, Coordination)

协作任务要求多个智能体之间的同步,强调角色协调和适应性决策:1)协作任务 1:抓取一个圆柱体,将其放入网状杯中,并交给另一个机器人;2)协作任务 2:接收的机器人将圆柱体放入黄色垃圾桶中,然后将网状杯剩余的内容倒入另一个黄色垃圾桶中。

上述基准任务引入了结构化、目标驱动的交互,旨在测试模型是否能够无缝适应现实世界的应用。为了构建高质量的后训练数据集,作者让人工操作员根据任务的复杂性,收集时长从 15 分钟到 3 小时不等的任务特定数据。然后筛选出低质量的轨迹,以确保数据的完整性。通过结合一系列多样化的任务要求——从精确的单智能体操作到复杂的多智能体协作——基准任务为评估泛化能力、适应能力以及在类人操作任务中的精细控制提供了一个严格的测试平台。

4.3 Experiment Setup

评估实验包括在数据有限的配置中,对比后训练的 GR00T N1 模型和基线模型,并在模拟和真实基准任务中评估策略的成功率。默认情况下,使用 batch_size=1024,并训练 60,000 步。对于 DexMimicGen Cross-Embodiment Suite(每个表现形式的任务相对较少,且整体训练数据有限),为 GR00T-N1-2B 使用batch_size=128。

Baselines

为了证明 GR00T N1 多样化预训练的有效性,与两个已建立的基线 BC-Transformer 和 Diffusion Policy进行了比较:

- BC-Transformer:是

RoboMimic基于 Transformer 的行为克隆策略。它由用于处理观察序列的 Transformer 架构和用于建模动作分布的高斯混合模型模块组成。该策略以 10 个观察帧作为输入并预测接下来的 10 个动作; - Diffusion Policy:通过基于扩散生成过程对动作分布进行建模。它采用

U-Net架构,逐步消除随机样本中的噪声,以根据观察序列生成精确的机器人动作。它以单帧观察结果作为输入,并在一次推理过程中产生 16 个动作步骤;

Evaluation Protocol

对于模拟基准评估,测试了 100 次试验的平均成功率,取最后 5 个checkpoint的最高分,每 500 个训练步写入一次检查点。

对于真实世界的机器人的评估,采用部分评分系统来捕捉不同执行阶段的模型行为,确保对性能进行细粒度评估。测试了每项任务 10 次试验的平均成功率,但将“包装机械”任务除外,对于这项任务,测试了在 30 秒时间限制内、5 个机械零件、工具中有多少个物体被放入箱子的成功率。

由于时间限制只进行了 5 次试验。此外,为了评估模型在低数据条件下的效率,还对每个任务的整个数据集进行了 10% 的子采样,并评估模型是否仍然可以学习有效的行为。

4.4 Quantitative Results

Pre-training Evaluations

为了评估预训练checkpoint的泛化能力,在真实的 GR-1 人形机器人上设计了两个任务(Figure. 8)。在第一个任务中,指示机器人将一个物体放在底部架子上。但是物体被故意放置在左手的左侧,需要协调的双手策略,机器人必须先用左手抓住物体,将其转移到右手可及的范围内,然后完成放置在架子上的操作;在第二个任务中,指示机器人将一个新物体放入看不见的目标容器中。

对于每个任务,使用五个不同的物体评估预训练的 GR00T-N1-2B 模型,每个物体进行三次试验。GR00T-N1-2B 在第一个协调任务中的成功率为 76.6%(11.5/15);在涉及新物体操作的第二个任务中的成功率为 73.3%(11/15)。 0.5代表正确抓取物体,但未能将物体放入容器中。在这两个实验结果说明了大规模预训练的有效性。

Pose-training Evaluations

在模拟中,将后训练的 GR00T N1 模型定量结果与三个模拟基准中的从头开始的基线进行比较(Table 2)。对于每个基准,在每个任务中使用 30、100 和 300 个演示进行后训练(RoboCasa 为 24 个任务,DexMG 为 9 个任务,GR-1 为 24 个任务)。观察到 GR00T N1 在基准任务和数据集大小方面始终优于基线模型。在Appendix B 中提供了完整结果和条形图(Figure 10)以供比较。

在真实机器人上,将 GR00T-N1-2B 与 Diffusion Policy 进行了比较,后者在 10% 的人类遥控数据集和完整数据集上进行训练(Table.3 和Figure. 9)。GR00T-N1-2B 在所有任务中的成功率明显更高,在 10% 数据设置中比 Diffusion Policy 高出 32.4%;在完整数据设置中比 Diffusion Policy 高出 30.4%;仅使用 10% 数据进行训练的 GR00T-N1-2B 的表现仅比使用完整数据集进行训练的 Diffusion Policy 低 3.8%,突显了其数据效率。

Post-training w/ Neural Trajectories Evaluations

在 Figure.9 中,展示了在 RoboCasa 基准的模拟评估、 Pick-and-Place(已见场景)、Industrial 的后期训练中使用神经轨迹的一些初步结果。与仅在真实世界轨迹上训练的 GR00T N1 相比,与神经轨迹共同训练的 GR00T N1 始终能带来显著提升:对于 RoboCasa,在 30、100 和 300 个数据方案中平均分别为 +4.2%、+8.8%、+6.8%,对于 GR-1 Humanoid,在 8 个任务中平均为 +5.8%。

在 RoboCasa 中比较 LAPA 和 IDM 标签时,LAPA 在相对较低的数据方案(30)中略胜于 IDM,但随着更多可用数据的增多(100 和 300),LAPA 和 IDM 之间的性能差距扩大。这种趋势随着 IDM 训练的数据越来越多,伪动作标签与现实世界动作越来越一致,从而产生更强的正向迁移。由于 GR-1 Humanoid 是一种相对“高数据”的方案,因此仅利用 IDM 动作在现实世界中进行神经轨迹协同训练。

4.5 Qualitative Results

为了回答模型的定性表现,考虑 RoboCasa 在 100 个样本的情况下的“转动水槽喷口”任务,DP 基线的成功率为 11.8%,而 GR00T N1 的成功率为 42.2%。DP 基线经常无法理解任务的语义。从Table 2 中可以看到 GR00T N1 在低数据情况下取得了很好的结果。在大型微调数据集的限制下,预训练的效果会减弱。

当使用任务指令“拿起红苹果并将其放入篮子”提示预训练的 GR00T N1 模型时,有意将苹果放在人形手的左侧。尽管在预训练期间看到很少类似的任务并且表现出更局促的动作,但预训练checkpoint 会用左手抓住苹果,将其递给右手,然后将其放入篮子中。在 Figure.12 中提供了该行为的可视化。后训练的checkpoint在这种情况下却失败了。由于所有后训练数据都只涉及右手而没有任何手间转移,因此后训练策略失去了执行此行为的能力。

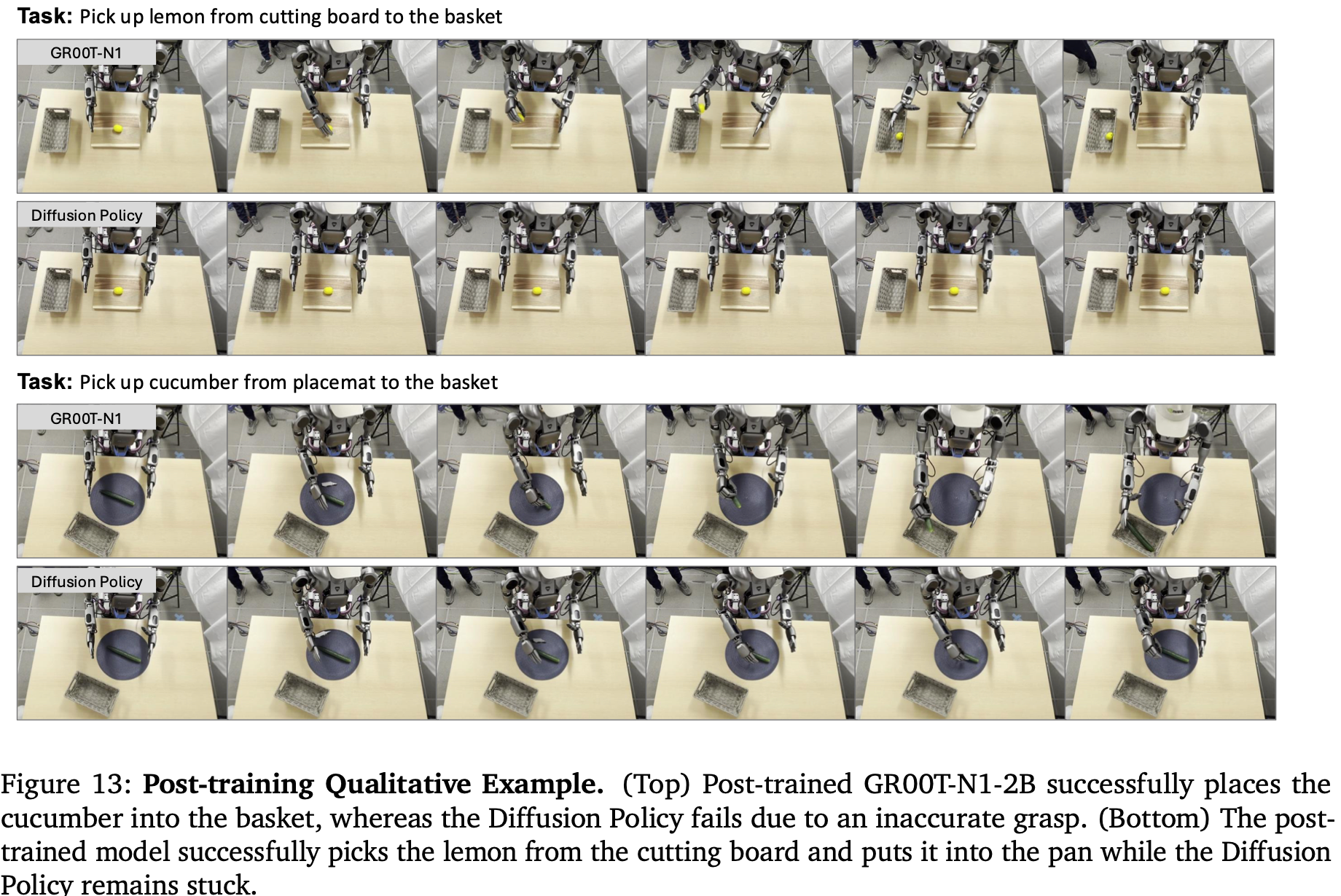

对于经过后训练的 GR00T N1,与基线 Diffusion Policy 相比其运动通常更加平滑,抓取准确度也显著提高。Diffusion Policy 基线在初始帧期间受到静止的影响,并且经常表现出不准确的抓取,导致在现实世界的基准测试中成功率较低。Figure.13展示了两个策略case的可视化。

4.6 Limitations

GR00T N1 模型主要专注于短距离桌面操作任务。在未来的工作目标是扩展其能力以应对长距离局部操作,这将需要在人形硬件、模型架构、训练语料库方面取得进步。作者计划使用更强大的VLM主干将增强模型的空间推理、语言理解和适应性。合成数据生成技术利用视频生成模型和自动轨迹合成系统,已显示出巨大的前景。然而,现有方法在生成多样化和反事实数据方面仍然面临挑战,同时为了遵守物理定律,限制了合成数据集的质量和可变性。未来的目标是增强合成数据生成技术,以进一步丰富模型训练数据金字塔。此外,还计划探索新的模型架构和预训练策略,以提高通用机器人模型的鲁棒性和泛化能力。

5. Related Work

Foundation Models in Robotics.

开发和使用机器人基础模型引起了极大兴趣。一种常见的方法是利用现有的预训练基础模型作为高级黑盒推理模块,结合低级机器人特定策略。这种方法允许机器人使用预训练的基础模型来规划低级技能或动作序列。但它假设这些低级策略可用,并且有足够的接口将它们连接到黑盒基础模型。

另一种方法是根据机器人数据对预训练的基础模型进行微调,以构建VLA。这些 VLA 不是在高级 VLM 规划和低级控制之间强制执行严格的层次结构,而是允许对下游部署任务进行端到端优化。坐着采用类似的方法来训练 GR00T N1,并使用 Eagle-2 模型 作为基础VLM。结合使用流匹配动作生成模型和动作分块对 VLM 进行微调。与使用混合专家架构将基础 VLM 模型与动作生成模型桥接起来的先前 VLA 模型不同,作者使用了一种简单的交叉注意机制。这种方法为使用的 VLM 模型和动作生成模型的确切架构提供了灵活性。此外,还使用了特定于具体实施的状态和动作投影仪模块,这些模块支持不同的机器人具体实施,包括隐层和基于 IDM的动作。这些隐层的使用类似于 Octo Model Team 中的映射,尽管该工作没有对 VLM 模型进行微调。

Datasets for Robot Learning

机器人学习的一个核心挑战是缺乏训练通用机器人所需的大规模、多样化和具象化的数据集。一种常见的方法是使用机器人遥控操作,人类使用智能手机或虚拟现实 (VR) 控制器等设备来控制机器人执行感兴趣的任务。操作过程中的机器人传感器流和机器人控制被记录到数据集中,从而可以收集高质量的任务演示。最近,这种方法已经通过在较长时间内利用大规模人类操作员和机器人车队进行了扩展,从而产生了包含数千小时演示的大规模机器人操作数据集。但是,这种方式收集数据需要大量的成本和人力。

另一项工作是定量测量人类演示动作,使用特殊硬件来捕获与机器人相关的观察和动作数据,而无需明确远程操作目标机器人。如使用手持机器人夹持器、使用手持机器人夹持器、使用类似机器人的外骨骼、使用特殊眼镜捕捉人类手部动作,然后将其重新定位到机器人动作数据。尽管与直接机器人遥控操作相比,它们与下游机器人不匹配,但这些方法往往可以显著加快数据收集速度。

另一项工作利用人类视频数据集作为机器人训练数据的来源,这些数据集比机器人本体数据丰富且更容易收集。使用人类视频数据集对表示进行预训练,然后将其用作下游机器人数据集上训练策略的特征空间。通过视频中动作的中间表示联合使用人类视频数据和机器人数据。仅在人类视频上使用潜在动作对 VLA 进行预训练可对下游机器人任务产生积极的迁移。作者在本文中并没有依赖单一类型的训练数据,而是开发了有效从各种各样的现实世界机器人数据、人类视频数据和合成数据中学习的技术。

Synthetic Data Generation in Robotics

现实世界中的机器人数据收集需要大量时间和相当大的人力成本。相比之下仿真中的数据收集效率更高、代价更少使其成为一种合适的替代方案。最近几项研究提出了自动化数据生成流程,可以利用仿真以减少的人力生成数千个任务演示这使得生成大规模数据集变得容易。然而,由于仿真与现实之间的差距,利用这些数据集可能具有挑战性。

另一个可能的途径是使用神经生成模型来增强现有的机器人演示集。以前的工作仅限于利用绘画或文本到图像扩散模型来增强训练数据。在作者这篇文章的工作中,利用视频生成模型的最新突破来创建 300k 条神经轨迹,相当于 827 小时的机器人轨迹。

在本文的模型中,利用了 MimicGen 和 DexMimicGen的大型合成模拟数据集,以及SOTA的视频生成模型的神经生成视频数据集。使用合成生成的数据集和真实世界数据集进行联合训练的方式也不同于其他大规模 VLA 工作。

6. Conclusions

作者提出了 GR00T N1,一种通用人形机器人的开放基础模型。GR00T N1 采用双系统模型设计,利用异构训练数据,并支持多种机器人实现。在仿真和真实基准测试上,对 GR-1 人形机器人系统地评估了它作为通用策略的效果。实验证明了模型强大的泛化能力,使机器人能够以高数据效率学习各种操作技能。作者希望他们开放 GR00T-N1-2B 模型及其训练数据集和模拟环境能够加速社区在野外建造和部署通用人形机器人的进程。

758

758

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?