这篇笔记用来描述 2025年 发表在arxiv上的一篇有关 VLA 领域的论文。亮点主要有以下几点:

- 介绍了一个全新的基于慢-快策略的反应扩散模型 RDP;

- 提供了一个包含触觉与力反馈信息的数据采集平台,除去机械臂以外的成本可以被控制在500 $ 附近,大头为AR头显 Meta Quest3;

- 魔改了一个触觉传感器并将成本控制在 50 $;

- 使用AR在采集过程中力反馈进行可视化;

- 根据作者描述他们的模型能够很好地应对任务过程中的干扰并在部分任务得分超越相同配置baseline模型35%以上;

在阅读本文的时候建议同步打开他们的项目网站:https://reactive-diffusion-policy.github.io,因为文章中有很多动态演示无法在论文中以静态图像表达。

写在最前面

为了方便你的阅读,以下几点的注意事项请务必了解:

- 该系列文章每个字都是我理解后自行翻译并写上去的,可能会存在笔误与理解错误,如果发现了希望读者能够在评论区指正,我会在第一时间修正错误。

- 阅读这个系列需要你有基本的 VLA, LLM, VLM 相关知识,有时候我会直接使用英文名词,因为这些词汇实在不容易找到符合语境的翻译。

- 原文可能因为版面限制存在图像表格与段落不同步的问题,为了更方便阅读,我会在博文中重新对图像表格进行排版,并做到引用图表的文字下方就能看到被引用的图表。因此可能会出现一张图片在博客中多处位置重复出现的情况。

- 对于原文中的图像,我会在必要时对图像描述进行翻译并附上我自己的理解,但如果图像描述不值得翻译我也不会强行写上去。

Basic Information

- 论文标题:Reactive Diffusion Policy: Slow-Fast Visual-Tactile Policy Learning for Contact-Rich Manipulation

- 原文链接: https://arxiv.org/abs/2503.02881

- 发表时间:2025年04月01日

- 发表平台:arxiv

- 预印版本号:[v2] Tue, 1 Apr 2025 11:54:35 UTC (4,746 KB)

- 作者团队:Han Xue, Jieji Ren, Wendi Chen, Gu Zhang, Yuan Fang, Guoying Gu, Huazhe Xu, Cewu Lu

- 院校机构:

- Shanghai Jiao Tong University;

- Tsinghua University, IIIS;

- Shanghai Qi Zhi Institute

- Shanghai AI Laboratory;

- Shanghai Innovation Institute;

- 项目链接: https://reactive-diffusion-policy.github.io

- GitHub仓库:

Abstract

人类可以使用视觉和触觉完成复杂的、接触密集型的任务,并且具有高度反应能力,例如快速调整环境变化和自适应控制接触力;然而,这对机器人来说仍然具有挑战性。现有的视觉模仿学习 (IL) 方法依靠动作组块来模拟复杂行为,但这种方式缺乏在组块执行期间立即响应实时触觉反馈的能力。此外,大多数遥操作系统难以提供细粒度的触觉/力反馈,这限制了可执行任务的范围。为了应对这些挑战,作者推出了 TactAR,一种低成本的遥操作系统,它通过增强现实 (AR) 提供实时触觉反馈,同时推出了反应扩散策略 (RDP),一种用于学习接触密集型操作技能的新颖的慢-快视觉-触觉模仿学习算法。 RDP 采用两级层次结构:(1)慢速潜在扩散策略,用于在低频下预测潜在空间中的高级动作块;(2)快速非对称标记器,用于高频闭环触觉反馈控制。这种设计可以在统一的框架内实现复杂的轨迹建模和快速的反应行为。在对三个具有挑战性的接触丰富的任务进行广泛的评估后,RDP 通过对触觉/力反馈的快速响应,与最先进的视觉 IL 基线相比显着提高了性能。此外,实验表明 RDP 适用于不同的触觉/力传感器。代码和视频可在 react-diffusion-policy.github.io 上找到。

1. Introduction

在日常生活中,人类能够运用视觉和触觉完成许多精确的、需要大量接触的任务(例如削蔬菜)。然而,这些对人类来说看似简单且需要大量接触的任务,对机器人来说却极具挑战性。一些神经科学研究表明,人类在执行需要大量接触的任务时,其过程可以分为两个部分:1)前馈/预测动作;2)基于感官反馈(例如触觉信号)的闭环微调。受此启发,作者开发了一种能够在执行复杂的、需要大量接触的任务时模拟人类控制模式的机器人学习系统。

近年来,视觉模仿学习 (IL) 方法在各种实际任务中展现出优异的性能。该领域的代表性研究,例如扩散策略、ACT、Pi0,都采用了动作分块来减轻长序列中的复合误差并提高时间一致性。动作分块还能有效地模拟人类演示中常见的非马尔可夫行为,例如停顿或振荡运动。然而,这些方法在动作块执行期间处于开环状态,这使得策略无法在接触丰富的任务中即时响应环境变化。此外,缺乏触觉输入也极大地限制了这些方法的能力。因此,这些 IL 方法仅限于执行低精度任务(例如,拾取和推拉),这些任务不需要精确的力控制或快速响应。

为了弥补纯视觉输入的局限性,许多方法探索了将触觉输入融入模仿学习策略。然而,这些研究大多仅侧重于观察层面,利用触觉输入提供诸如视觉遮挡或接触状态判断等额外信息。在动作层面,这些方法仍然依赖于传统的动作组块进行动作预测,这限制了它们在动作组块执行过程中快速响应的能力。此外,大多数方法利用传统的遥操作来收集人类演示数据,这使得获取具有细粒度触觉反馈的高质量动作数据变得极具挑战性。这种局限性也限制了这些方法能够有效执行的任务类型。

在这项工作中,作者提出了两个关键组成部分来解决上述视觉触觉模仿学习问题:

- 一种名为

TactAR的远程操作系统,可以通过增强现实 (AR) 实时提供细粒度的触觉/力反馈; - 一种称为反应扩散策略 (RDP) 的模仿学习算法,它保留了动作分块的优势,同时能够在执行每个块期间基于触觉信号实现高频闭环控制。

在 TactAR 遥操作系统中,使用 Meta Quest3 通过 AR 提供实时触觉/力反馈,3D 变形场作为不同传感器触觉/力反馈的统一表示(Fig.1 left)。在 AR 中渲染 3D 变形场并将其附加到虚拟空间中的机器人末端执行器。系统还支持 AR 中的触觉传感器和 RGB 摄像机的摄像机流。通过这种方式,用户可以在遥操作期间获得丰富的接触信息,包括触觉图像、法向力、剪切力和扭转扭矩。TactAR 系统在设计时注重多功能性和可访问性:(1)它支持多种类型的触觉/力传感器;(2)它可以轻松部署在不同的机器人实施例中;(3)它非常具有成本效益(Meta Quest3 售价 500 美元)。

为了充分利用 TactAR 系统采集到的高质量视觉触觉数据,作者提出了一种名为反应扩散策略 (RDP) 的模仿学习算法(Fig.1 right)。受人类在接触密集型任务中的控制策略启发,使用了一种 “慢-快”分层控制 流程。

- 慢速网络(潜在扩散策略,LDP):在低频(1-2 Hz)的潜在空间中预测高级动作组块,这类似于预测动作;

- 快速网络(非对称标记器,AT):根据高频触觉反馈(20-30 Hz)对潜在动作组块进行微调,这类似于闭环微调。

这种分层结构使慢速网络能够通过扩散模型和动作组块保留其对复杂非马尔可夫动作进行建模的能力,而快速网络则通过实时触觉反馈实现闭环控制,从而实现精确的力控制和快速响应。

在三个具有挑战性的接触丰富的任务上开展了实验,从以下四个方面评估模型的性能:

- precision 精度;

- precise and adaptive force control 精确和自适应的力控制;

- fast response under disturbances 干扰下的快速响应;

- bimanual coordination 双手协调。

现实世界的实验表明,模型反应扩散策略算法可以在保持非常快速的反应行为的同时模拟复杂的动作,与最先进的 IL 基线相比,在三个任务中实现了显着的性能提升(> 35%)。这也验证了我们的 TactAR 遥操作系统的数据质量。此外,还进行了跨传感器实验,证明 RDP 适用于各种触觉/力传感器(GelSight Mini、MCTac、内置关节扭矩传感器)。TactAR 遥操作系统和反应扩散策略算法的代码可在 react-diffusion-policy.github.io 上找到。

2. Related Work

A. Tactile / Force Sensing Hardware in Robotics

许多机器人任务需要与世界进行物理交互。与 RGB 相机相比,触觉传感器和力传感器可以提供更丰富的接触物理信息。每种类型的传感器都有其优点和局限性,安装在机器人末端执行器上的力传感器或安装在机器人手臂上的关节扭矩传感器可以直接获取力/扭矩读数,并且不易损坏。然而,力和扭矩传感器容易受到信号噪声的影响,尤其是在快速移动过程中,而且它们往往也相对昂贵。触觉传感器可分为电气传感器和光学传感器。

电气传感器

采用电容式、电阻式、MEMS、磁性粒子来感应接触,这类传感器通常更紧凑、更薄,但空间分辨率较低且制造复杂。只有部分电气触觉传感器可以直接输出法向力和剪切力,但需要依靠力/扭矩传感器进行复杂的校准过程。

光学触觉传感器

如 GelSight 、GelSlim 、MCTac 、9DTact 。它们使用摄像头捕捉高分辨率图像来追踪凝胶的变形;光学传感器还可以配备标记点,以更好地追踪凝胶表面的法向和剪切变形场。与电传感器或力 / 扭矩传感器相比,光学触觉传感器更容易制造、更便宜、信号噪声更低。力和扭矩信息可以在剪切场凝胶表面隐式表示,但它们依赖于复杂的校准过程来间接计算力 / 扭矩值。

在本文中,作者使用两种不同型号的 光学触觉传感器(GelSight Mini 和 MCTac)和机械臂的关节扭矩传感器 来进一步释放触觉 / 力传感的潜力。

B. Robot Data Collection System

遥操作是利用机器人采集专家数据的常用方法。目前的远程操作系统主要基于VR控制器、手势追踪或硬件直接关节映射。大多数远程操作系统仅基于视觉反馈,这使得它们难以执行精确且接触丰富的任务。

先前一些学者提出了一类依赖于同构硬件的触觉遥操作系统,如Bi-ACT 和 Kobayashi等人使用双边控制和 ALOHA 来获取力反馈。由于同构的硬件设计,这些遥操作系统难以部署在不同的硬件平台上;另一类遥操作系统使用力 / 扭矩传感器进行触觉反馈。FoAR 使用触觉遥操作设备来获取力反馈,但成本也相对较高,ForceMimic 在手持设备上添加力传感器来获取力反馈,但由于姿态估计不准确,因此无法直接训练端到端策略。ACP 使用低刚度柔顺性动觉教学系统来提供触觉反馈,但需要为末端执行器配备复杂的定制适配器。

一些研究利用 VR 头戴设备中的振动来获取触觉反馈,但这些系统只能提供非常粗略的接触信息。作者提供的方法结合了低成本 VR 控制器和触觉感知的优势,通过AR获取触觉反馈,同时保持了执行需要大量接触的精确任务所需的精度。此外,该遥操作系统灵活,易于部署在不同的触觉传感器和机器人平台上。

C. Visual-tactile Manipulation

触觉感知在机器人操控中至关重要,它可以补偿视觉遮挡,并在复杂任务中提供力/扭矩反馈。虽然触觉操控技术由来已久,但许多方法依赖于特定于任务的建模、人工设计的基元、手动设置的奖励,这限制了它们在不同任务上的泛化能力。

视觉模仿学习的最新进展已显示出以端到端方式学习复杂任务的潜力。一些研究尝试将触觉感知与模仿学习相结合,但大多数研究仅关注法向力读数,限制了它们在多功能任务中的适用性。只有少数研究利用剪切力/扭矩数据进行模仿学习。MimicTouch 使用基于 GelSight 的手持设备进行离线策略训练,但由于人手和机器人夹持器之间的具体化差异而省略了视觉输入,限制了其任务多功能性。Bogert等人使用 GelSlim 的剪切力场在机器人具体化之间进行策略迁移,但也排除了视觉输入,这限制了他们的方法只能用于简单任务。

相比之下,作者的方法将法向力、剪切力、视觉RGB输入结合成统一的 visual-tactile policy,从而能够应用于更广泛的任务。通过整合触觉和视觉模态,该方法克服了先前研究的局限性,并在机器人操控方面实现了更高的灵活性。

3. Teleoperation System: TactAR

TactAR 是一个基于 AR 的遥操作系统Fig.2,可以为复杂的、接触密集型的任务提供实时触觉/力反馈:

TactAR 系统设计的主要特点如下:

- Real-time tactile / force feedback via AR:触觉/力传感器的3D变形/力场可以通过AR实时渲染。经过简单的校准步骤后,3D变形场将在AR中“附着”到机器人末端执行器上,从而为用户提供实时触觉/力/扭矩反馈;

- Cross-sensor and cross-embodiment deployment:系统可以部署在不同类型的触觉/力传感器和不同的机器人手臂(单臂或双手)上;

- Low-cost:系统不需要专门或同构的硬件来实现触觉反馈,只需要一个消费级VR头显

Meta Quest3即可实现远程操作,售价仅为500美元;

A. 3D Deformation Field Extraction

凝胶表面的标记阵列 Fig.3 能够捕捉丰富的接触信息,但从二维光流中获取力数据需要使用昂贵的传感器进行复杂的校准。为了提高数据的可访问性,作者将其转为可视化三维变形场。从触觉图像

I

t

I_{t}

It中,使用 OpenCV 提取归一化的标记位置

D

t

D_{t}

Dt,使用基于分数的跟踪算法来计算初始帧

D

0

D_{0}

D0和当前帧

D

t

D_{t}

Dt之间的二维光流:

F

t

=

[

d

x

,

d

y

]

=

F

l

o

w

(

D

0

,

D

t

)

\begin{equation} F_{t}=[d_{x},d_{y}]=Flow(D_{0}, D_{t}) \end{equation}

Ft=[dx,dy]=Flow(D0,Dt)

然后,在 AR 中渲染 3D 变形场 V t = [ d x , d y , o z ] V_{t}=[d_{x}, d_{y}, o_{z}] Vt=[dx,dy,oz],其中 o z o_{z} oz为 z z z 轴偏移。对于力传感器,直接将 V t = [ f x , f y , f z ] V_{t}=[f_{x}, f_{y}, f_{z}] Vt=[fx,fy,fz] 可视化。

B. Real-time Tactile / Force Feedback Rendering in AR

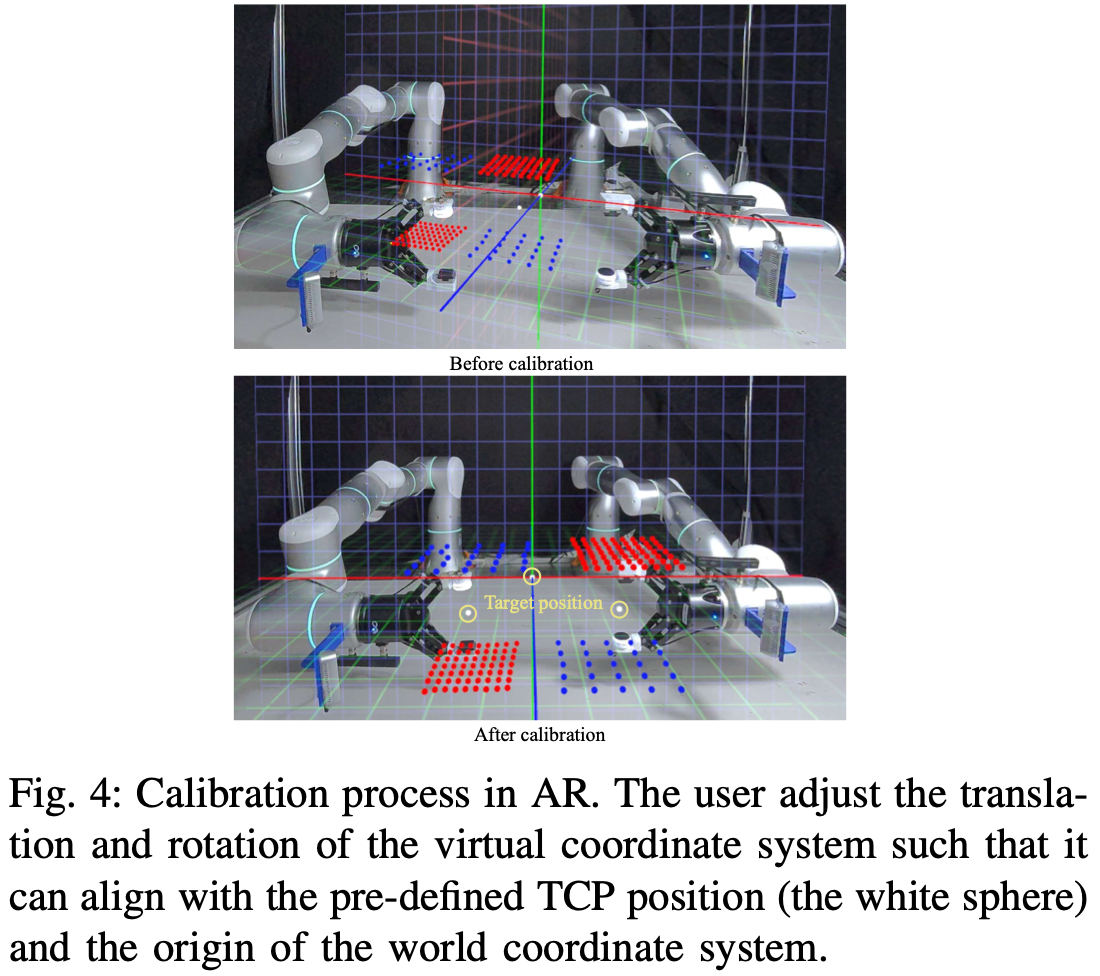

TactAR 系统利用 Meta Quest3 的色彩直通模式,通过 Unity 构建 AR 环境。Quest3 内置的 SLAM 算法可追踪头显/控制器的姿态,并通过简单的校准流程在 AR 空间和机器人空间之间实现初始坐标对齐(Fig.4)。

基于 ROS2 的架构(Fig.2)同步来自触觉/力传感器、机器人控制器、RGB 摄像头的数据流。触觉/力信息(3D 变形场

V

t

V_{t}

Vt)通过实时机器人 TCP 姿态进行转换,并在 AR 空间中进行渲染。此外,TactAR 系统还支持多视角 RGB 摄像头(Fig.2)和触觉摄像头的实时数据流传输,从而获得更具沉浸感的远程操作体验。有关系统延迟和 TactAR 的更多详细信息参阅Appendix B和 项目网站。

C. Versatility and Accessibility

TactAR 系统设计灵活且易于访问,具有以下特性:

- Cross-sensor:使用 3D 变形场作为触觉/力反馈的统一表示,可应用于许多不同的触觉/力传感器。在本文中用于实验的传感器如下:(1)

GelSight Mini光学触觉传感器、(2)改进的MC-Tac光学触觉传感器、(3)Flexiv Rizon机械臂内置关节扭矩传感器。TactAR系统高度模块化,甚至可以同时支持使用不同触觉/力传感器的 AR 可视化Fig.1。理论上,遥操作部分也兼容像AnySkin这样的电触觉传感器,它们的数据类型通常可以表示为稀疏的 3D 力场; - Cross-embodiment deployment:可以轻松部署在不同的机械臂和夹持器上。AR 中的触觉反馈仅需要机器人 TCP 位姿和 3D 变形场,机械臂采用 TCP 控制。还支持单臂和双手手臂控制。

TactAR不会受到特定硬件配置参数和自由度的限制。与其他基于同构硬件的触觉遥操作系统相比,该系统仅需一个Meta Quest3VR 头显,大大降低了复现难度。 - Low cost:采用低成本硬件构建。用于遥控操作和 AR 反馈的

Meta Quest3 VR头戴式设备售价 499 美元。本文的实验使用了两种不同的光学触觉传感器:(1)GelSight Mini Robotics Package售价 549 美元。(2) 定制的MCTac实验室制备成本约为 50 美元,未来在工业制造中具有降低成本的巨大潜力。与ATI mini45等售价约 3000 美元的力/扭矩传感器相比,光学触觉传感器具有显著的成本优势。

4. Learning Algorithm: Reactive Diffusion Policy

本节将介绍反应扩散策略(RDP),它是一种 慢-快模仿学习 算法,可以利用快速网络对触觉/力反馈做出即时响应,同时又能保持慢速网络扩散的强大建模能力。

A. Tactile / Force Representation

对于光学触觉传感器(例如 Gelsight Mini ),在 Equ.1 中的标记变形场

F

F

F 上使用主成分分析 (PCA) 生成的低维表示。PCA 特征的使用使模型对跟踪误差和标记变形场噪声具有更强的鲁棒性。此外,PCA 特征对因凝胶损坏或更换引起的纹理和光照变化也具有更强的鲁棒性。有关触觉表示和 PCA 触觉数据集的更多详细信息,请参阅Appendix C 和Appendix D。

对于力的表示,只需将 6-D 扳手(力 + 扭矩)连接到观察向量中。

B. Slow-Fast Policy Learning

先前的研究已经证明,预测动作序列或动作块能够有效地保持时间动作一致性,并处理非马尔可夫动作或空闲动作,从而在策略学习中取得优异的性能。然而,在执行动作块时,此类方法可能被视为开环策略,导致无法从触觉等高频信号中获得实时反馈。VISK 利用时间集成来缓解这个问题。Fig.5所示,时间集成通过聚合同一时间步长多次迭代的预测,在闭环控制和序列一致性之间找到了平衡。该解决方案的一个显著缺点是,削弱了策略对多模态分布和非马尔可夫动作的建模能力,使其容易出现诸如卡顿之类的问题。此外,策略性能对时间集成的平滑系数非常敏感,这反而降低了策略的适用性。

为了解决上述序列建模和闭环控制之间的权衡,作者提出了一个慢-快策略学习框架反应扩散策略 (RDP),如Fig.6 所示。RDP 是一个慢-快潜在扩散模型 (LDM) ,显式处理不同阶段的各种频率信号。首先训练一个非对称标记器 (AT) 将原始动作块转换到潜在空间。AT 解码器将与潜在动作块分开的瞬时触觉表示作为输入;对于策略学习,训练一个慢速潜在扩散策略 (LDP),使其根据观察结果以类似于扩散策略的方式预测潜在动作块。

在推理过程中,以较低的频率对潜在动作块进行采样,并在每个块内执行动作,同时将最新的触觉表示输入到 AT 的解码器中,以预测下一帧的真实动作。这种分层设计使慢速网络能够通过预测时间一致的潜在动作块来保持其对复杂或非马尔可夫动作的建模能力,并使快速网络能够通过实时响应实现闭环控制。

- Fast Policy:快速非对称标记器 (AT) 由

1D-CNN编码器 E E E 和GRU解码器 D D D 组成。给定策略学习 D p o l i c y D_{policy} Dpolicy 中的动作块 A ∈ R T × D A\in R^{T\times D} A∈RT×D,编码器将其下采样为潜在动作块 Z = E ( A ) ∈ R t × d Z=E(A)\in R^{t\times d} Z=E(A)∈Rt×d。选择使用基于CNN的编码器来保留原始序列的空间结构,从而使潜在动作块能够更好地被以序列为输入的潜在扩散策略处理。之后,解码器通过 A ^ = D ( c o n c a t ( [ Z , F r e d u c e d ] ) ) \hat{A}=D(concat([Z,F^{reduced}])) A^=D(concat([Z,Freduced])) 重建动作,其中 F r e d u c e d F^{reduced} Freduced 是第 3-A 节中提出的相应触觉表征序列,在解码器中仅使用触觉表征作为输入。这种刻意非对称设计结构是为了确保潜在动作块仅保留高级反馈策略,而解码器则使用触觉信息预测精确位置。使用L1重建损失和Kullback-Leibler (KL)惩罚损失来训练 AT,如下公式所示:

L A T = E ( A , F r e d u c e d ) ∈ D p o l i c y [ ∥ A − A ^ ∥ 1 + λ K L L K L ] \begin{equation} L_{AT}=E_{(A,F^{reduced})\in D_{policy}}[\|A-\hat{A}\|_{1}+\lambda_{KL}L_{KL}] \end{equation} LAT=E(A,Freduced)∈Dpolicy[∥A−A^∥1+λKLLKL]

在实际使用过程中,像 LDM 一样将系数 KL 保持在较小水平,因为期望平滑 AT 的潜在空间,而不是将其变成生成模型。如Table.1所示,快速策略仅需不到 1 毫秒即可完成推理,理论上甚至可以支持更高频率的输入(> 300Hz)。

- Slow Policy:将慢速策略建模为作用于潜在动作块的扩散策略,称为潜在扩散策略 (LDP)。扩散策略是一个生成模型,它利用学习到的梯度场 ∇ E ( A ) \nabla E(A) ∇E(A),通过随机Langevin动力学,将噪声动作 A k A^{k} Ak 迭代去噪为干净的动作 A ^ 0 \hat{A}^{0} A^0。为了将模型转换到潜在空间,使用潜在动作块 Z 0 = E ( A 0 ) Z^{0}=E(A^{0}) Z0=E(A0)。这种建模方法有几个优点:下采样的潜在表示降低了计算成本;AT 中的非对称设计允许将具有挑战性的反应行为排除在潜在动作块之外,从而降低了低频观测下潜在扩散策略的学习难度,并增强了其泛化能力。在训练过程中,给定观测 O O O(包括图像、触觉、本体感觉),梯度场由 ϵ θ \epsilon_{\theta} ϵθ 学习,DDPM 训练目标可以重写为:

L L D P = E ( O , A 0 ) ∈ D p o l i c y , k , ϵ k ∥ ϵ k − ϵ θ ( O , Z 0 + ϵ k , k ) ∥ 2 \begin{equation} L_{LDP}=E_{(O,A^{0})\in D_{policy},k,\epsilon^{k}} \|\epsilon^{k}-\epsilon_{\theta}(O,Z^{0}+\epsilon^{k},k)\|_{2} \end{equation} LLDP=E(O,A0)∈Dpolicy,k,ϵk∥ϵk−ϵθ(O,Z0+ϵk,k)∥2

其中

k

k

k 是迭代次数;

ϵ

k

\epsilon^{k}

ϵk 是具有一定方差的随机噪声。使用基于 CNN 的扩散策略,并结合基于 FiLM 的条件注入作为网络架构。

- Implementing Suggestions for Slow-Fast Policy:与标准扩散策略相比,慢快控制策略需要以下关键元素才能实现最佳性能。

- Relative trajectory:使用相对末端执行器 (EE) 轨迹进行动作表示,这已被 UMI 证明即使在复杂任务中也十分有效。具体而言,不是直接计算连续帧之间的动作增量(这可能导致较大的复合误差),而是通过计算相对于基准帧的相对变换,将绝对姿态轨迹转换为相对姿态轨迹。在实验设定中,基准帧是动作块中的最后一个观察帧。

- Latency matching:计算策略推理和动作执行造成的延迟,并丢弃模型预测的前几个动作步骤,以便将准确匹配的动作发送给机器人。这种方法在 UMI 中有所提及,对于慢-快策略而言更为关键,它确保了动作块之间的过渡更加平滑,防止分布不均匀的触觉信号导致快速策略预测异常动作。

5. Experiments

实验设计回答以下问题:

- Q1:触觉信号能否提高接触密集型任务的策略表现;

- Q2:RDP 有哪些功能;

- Q3:RDP 是否适用于不同的触觉/力传感器;

- Q4:RDP 能否立即对外部干扰做出反应;

- Q5:哪些设计选择对 RDP 至关重要,为什么不能简单地使用较小的块大小或时间集成来提高闭环控制频率;

- Q6:

TractAR中的触觉/力反馈如何影响遥操作的数据质量; - Q7:远程操作中的数据质量如何影响策略性能;

A. Setup

Hardware

实验平台由两个配备关节扭矩传感器的 Flexiv Rizon 4 机械臂和两个 Flexiv Grav 夹爪组成。对于单臂任务,仅在机械臂上使用一个 Realsense D435 摄像头获取腕部视图;对于双手任务,使用两个 Realsense D435 摄像头获取腕部视图,并在机器人工作空间前方固定一个 Realsense D415 摄像头获取外部视图。我们在实验中使用三种不同的触觉/力传感器:

- GelSight Mini:光学触觉传感器具有 8MP 分辨率和 25 FPS,表面有 7 × 9 7\times 9 7×9 标记点阵列;

- MCTac:分辨率为 2MP 的光学触觉传感器,帧率为 30 FPS,表面具有

5

×

7

5\times 7

5×7 的标记点阵列。作者改进了

MCTac硬件,包括增大标记点尺寸、降低标记点密度,并使用白光以提高标记点的跟踪稳定性。有关改进型MCTac传感器的硬件详细信息参阅Appendix A.; - Built-in joint torque sensors:在

Flexiv Rizon 4机械臂中使用Flexiv RDK计算的 TCP 力/扭矩估算值进行实验。以 120Hz 的频率传输传感器数据,并将其下采样至 24 FPS。由于动力学模型不准确,估算的 TCP 力/扭矩信号与安装在机器人末端执行器(例如ATI mini 45)上的力传感器相比,噪声相对较大,这会算法提出挑战;

为了评估不同触觉/力传感器下的策略性能,作者将 MCTac 和 GelSight Mini 分别连接到同一夹持器的不同指尖。这样就可以同时从 MCTac、GelSight Mini 和力/扭矩传感器收集同步数据。TactAR 遥作使用 Meta Quest 3 VR 头显。所有设备均连接到配备 Intel Core i9-14900K CPU 和 NVIDIA RTX 4090 GPU 的工作站,用于数据收集和评估。

Baselines

- Diffusion Policy:仅使用视觉输入(RGB 图像)和开环动作分块的扩散策略的

vanilla实现; - Diffusion Policy (tactile image):利用原始触觉图像和视觉输入的扩散策略;

- Diffusion Policy (tactile embedding):具有触觉嵌入(PCA 特征)和视觉输入的扩散策略;

- Reactive Diffusion Policy (tactile embedding) (Ours):慢-快策略采用高频触觉嵌入(PCA特征)和视觉输入;

- Reactive Diffusion Policy (force) (Ours):慢速策略采用高频扳手(力/扭矩)和视觉输入;

Tasks

如Fig.7所示,通过三个具有挑战性的富含接触的任务来评估反应扩散策略。

- Peeling:机器人需要抓住削皮器,靠近人手悬空的黄瓜,然后开始削皮。这项任务需要具备以下能力:

- Precision:机器人需要在环境不确定(例如不同的工具抓取位置、不同的黄瓜姿势)的情况下以高精度(毫米级)完成任务;

- Fast response:机器人需要对人类的干扰立即做出反应;

- Wiping:机器人需要抓住橡皮擦,靠近人手托住的花瓶,然后开始擦拭。这项任务需要具备以下能力:

- Adaptive force control with rotation:机器人需要自适应地跟踪具有不同环境不确定性(例如,工具抓取位置、花瓶姿势)的弯曲蒸汽表面;

- Fast response:机器人需要对人类的干扰立即做出反应;

- Bimanual Lifting:两个机械臂需要抓住抓手,靠近纸杯,用两个抓手夹住纸杯,小心地沿着曲线轨迹提起纸杯,但不要挤压纸杯。此任务需要以下能力:

- Precise force control:两个机器人在执行任务时必须施加精确的力。至关重要的是,要避免用力过大,以免挤压杯子,同时还要确保力道足以防止杯子滑落;

- Bimanual coordination:双手协作;

- Multi-modality:如

Fig.7所示,在专家数据中,有两条向上的提升轨迹,表明存在多模态性;

Evaluation Protocols

通过手动将场景与预定义图像对齐,在所有方法中对机器人和物体使用相似的初始状态,不同类型任务配置如下:

- 剥离和擦拭任务:有三种测试时间变化:无扰动,物体在空中以随机 6D 姿势固定;接触前扰动,在工具接触之前移动物体;接触后扰动,在工具接触后移动物体以打破接触状态;

- 双手举起任务:有两种测试时间变化:软纸杯;硬纸杯。

任务完成的评分准则如下:

- 剥黄瓜任务:根据剥下的黄瓜皮占黄瓜总长度的比例计算分数,并用演示数据的平均分数进行归一化;

- 擦拭任务:根据剩余笔迹与演示数据的大小进行比较来计算分数。如果残留物达到人类演示水平,则得分为1;如果残留物很少(不足笔迹长度的三分之一),则得分为0.5;如果残留物较多,则得分为0;

- 双手举起纸杯任务:如果纸杯按照指定轨迹举到空中且没有受到明显压缩,则得分为1;如果纸杯在空中被部分压缩,则得分为0.5;如果杯子没有被举起,或者掉在空中,则得分为0。

有关评估准则的更多详细信息参阅Appendix. E。

Implementation Details

扩散策略和慢速策略 (LDP) 为每个动作块预测开环 12 FPS 动作序列。LDP 的低频观测包括视觉输入和触觉/力输入;快速策略 (AT) 以 24 FPS 进行触觉/力观测,并以 24 FPS 更新新的动作预测。

【Note】:这里使用 24 FPS 是因为受到 GelSight 帧速率限制(为 25 FPS),RDP 算法理论上也可以应用于更高频率的触觉/力信号。有关数据采集、推理过程和超参数的更多详细信息,请参阅Appendix. D, F, H。

B. Results

Q1: Simply adding tactile signals into observation may NOT improve performance for complex contact-rich tasks

简单地将触觉信号添加到观察中可能无法提升复杂、富含接触任务的性能。Table.2中比较了使用原始触觉图像 (DP w. tactile img.) 和低维触觉嵌入 (DP w. tactile emb.) 的扩散策略的性能。虽然两种方法的性能相似,但 低维触觉嵌入对评估过程中凝胶损坏或凝胶替换导致的纹理变化表现出更高的鲁棒性。因此在后续的大多数实验中使用触觉嵌入。

| Table.2 | Table.3 & Table.4 |

|---|---|

|  |

在三个任务中,结合触觉嵌入的扩散策略 (DP)(DP w. tactile emb.)的表现与纯视觉输入的 DP 相似(见Table.2,3,4),但尽管性能相似,但这两个 DP 基线表现出不同的错误范式:

- 纯视觉输入的 DP 经常预测不准确的轨迹并导致很大的接触力(例如

Fig.8 (b)中的失败case 2),需要人工移动机械臂以防止传感器损坏; - 相反,具有触觉嵌入的 DP 很少带来大的接触力,可能会在与物体接触时卡住(例如

Fig.8 (a)中的失败case 2 和Fig.8 (c)中的失败案例)。

【Note】:建议直接去他们 项目网站 看动图,否则完全看不出效果。

这可能是因为它从数据中学习了一些反应行为(例如,接触时稍微向上移动;松开接触时向下移动)。然而,由于开环方式执行动作块,缺乏更精细的调整能力。因此,可能会快速切换到不同的接触状态,并在各种接触状态之间反复切换。总而言之,需要一种更好的方法将触觉信号融入策略中。

Q2: RDP can perform challenging contact-rich tasks that require precision, adaptive and precise force control, or bimanual coordination

RDP 可以执行具有挑战性的、需要精准性、自适应和精确力控制或双手协调能力的接触密集型任务。如Table. 2,3,4所示,与所有三个任务中的各种扩散策略基线相比,RDP 的总体得分均大幅提升(> 35%)。这些任务需要不同的能力,包括精准性(剥离)、带旋转的自适应力控制(擦拭)以及带双手协调能力的精确力控制(双手提升)。这些能力与高频触觉/力反馈的闭环调节密切相关。

作者还进行了一些案例可视化,以分析 RDP 在这些接触密集型任务中的工作方式(如Fig.9所示)。

观察到 RDP 确实学习到了与人类类似的反应行为。

【Note】:这里也是建议配合 项目网站去看,否则也看不出来模型的行为;

- 在case 1 中,当削皮器突然接触到黄瓜时接触力会急剧增加;然后,快速策略会对慢速策略预测的动作块进行向上调整,以减小接触力;

- 在case 2 中,当削皮器接近黄瓜末端时,快速策略会预测一个向下的修正动作,使削皮器能够紧贴黄瓜表面并去除更多皮;

- 在case 3 中,当两名操作人员试图夹住纸杯时,快速策略会在接触后迅速预测一个向外的修正动作,防止杯子被挤压。这些反应行为调整的幅度在亚毫米级别,看似微小,但却会显著影响这些接触密集型任务的整体性能。对于具有开环动作分块的策略来说,这些微小的反应动作很难准确学习,但对于具有高频触觉/力控制的快速策略来说,学习起来要容易得多。

在双手举重任务中,观察到了具有力输入的 RDP 模型的多模态行为,表明的慢速策略(LDP)仍然具有扩散模型强大的建模能力。

Q3: RDP are applicable to different tactile / force sensors

RDP 适用于不同的触觉/力传感器。如Table.2 所示,在剥离任务中,带有两个光学触觉传感器(GelSight Mini 和 MCTac )的 RDP 的性能非常接近(0.9 vs 0.88)。对于双手提升任务,RDP 可以同时使用不同的触觉传感器(左夹持器上的 MCTac 和右夹持器上的 GelSight)并表现良好(参见Table.4)。GelSight Mini 和 MCTac 具有不同的 LED 颜色(RGB vs 白色)、不同的凝胶材料(硬 vs 软)、不同的标记阵列(

7

×

9

7\times 9

7×9 vs

5

×

7

5\times 7

5×7)、不同的分辨率(8MP vs 2MP)和不同的帧速率(25 FPS 和 30 FPS)。这验证了触觉表示的有效性和 RDP 算法的适应性。

| Table.2 | Table.3 & Table.4 |

|---|---|

|  |

RDP 也适用于力/扭矩传感器。Table.2,3,4 表明无需任何额外设计,仅需简单力输入的 RDP 便可在三项任务中取得最佳效果。尽管机器人在快速运动过程中力传感器会产生很大的噪声,但 RDP 算法成功地从噪声数据中识别出有用的模式。作者猜想与光学触觉传感器相比,力传感器具有更低的延迟和更低的维度,可能会产生更好的结果,这可能有助于网络更轻松地学习。

Q4: RDP can react immediately to external disturbances

RDP 能够快速响应外部扰动,RDP 的慢速设计显著提升了模型对外部扰动的响应速度:

- RDP (

GelSight) 在剥离任务中最难的任务(接触后扰动)中获得了 0.8 的高分,而带有触觉嵌入的 DP 基线仅获得了 0.15 的得分,Table.2 - 在“擦拭”任务中(

Table.3),RDP 在人为扰动下也获得了比 DP 基线更高的得分。Fig.8展示了 DP 基线在人为扰动下的一些典型失败案例(例如,剥离 (a) 任务和擦拭 (b) 任务中的失败案例 1)。当机器人失去与扰动(例如向下移动)的接触时,DP 基线将以开环方式执行动作块中的剩余轨迹,导致黄瓜皮破碎,花瓶上残留的笔迹未被完全擦除。相比之下,RDP 算法可以立即以闭环方式使用快速策略更改预测轨迹,从而获得更好的结果。

Q5: Slow-fast hierarchy, relative trajectory and latency matching are essential for RDP performance

慢-快层次结构、相对轨迹和延迟匹配对于 RDP 性能至关重要。如Fig.5所示,有两种方法可以在不使用慢-快层次结构的情况下提高闭环控制频率:(1)减小动作块大小;(2)使用时间集成。

然而,Table.5 中的实验证明上述两个选项都有明显的副作用。从Table.5 中可以看出,当动作块大小从 8 减小到 2 时,DP 基线在抓取之前容易卡住(Fig.8 (b)中的失败case 4),这会使抓取成功率从 100% 下降到 20%。小块大小的策略对人类演示数据中常见的非马尔可夫行为(例如,悬空停顿)非常敏感,因此不能简单地减小块大小。

时间集成可以通过对多个时间步长的预测进行平均来实现半闭环控制。作者在 HATO 中尝试了不同的时间集成因子

τ

\tau

τ,Table.5 中的实验表明,模型性能对

τ

\tau

τ 非常敏感。当

τ

=

0.2

\tau=0.2

τ=0.2 时,平均权重将更多地关注最新的预测,这使得模型行为类似于块大小较小的策略,并导致较低的抓取率(30%);当

τ

=

0.8

\tau=0.8

τ=0.8 时,平均权重将更多地关注最早的预测,这使得模型行为过度平滑并损害反应能力(Fig.8 (b) 中的失败case 3)。因此,使用时间集成很难平衡时间一致性和反应性。

Fig.10 所示,在 Peeling Task 中,相对轨迹预测的表现远优于绝对动作预测。这可能是因为相对轨迹在较小、较快的策略中更容易学习,从而为触觉反馈带来了更具泛化的响应策略。此外,相对轨迹还压缩了潜在空间,从而促进了潜在扩散策略的学习过程。延迟匹配也对策略性能做出了很大贡献(见Fig.10),因为它可以确保动作块之间的动作过渡平滑,并减少分布外 (OOD) 行为。

Q6: Tactile / force feedback in TactAR improves data quality in contact-rich tasks by improving the stability of contact forces

TactAR 中的触觉/力反馈通过提高接触力的稳定性来改善接触密集型任务的数据质量。作者探讨了 TactAR 中的触觉/力反馈如何协助数据采集过程。邀请了 10 位具有不同 VR 遥操作或模仿学习 (IL) 经验水平的用户。有关用户研究的更多详细信息,请参阅Appendix. G。共计进行了

10

×

10

×

2

=

200

10\times 10\times 2=200

10×10×2=200 次试验进行定量分析。如Fig.11 所示,70%以上的用户发现触觉/力 AR 反馈对数据采集非常有帮助,无论他们是充当遥操作员还是拿着黄瓜的人。

在 Fig.12中,可以看到 TactAR 中的触觉/力反馈可以从归一化的剥离长度 (

0.72

→

0.91

0.72\to 0.91

0.72→0.91) 和稳定接触力比 (

0.58

→

0.87

0.58\to 0.87

0.58→0.87) 大幅提高数据质量。

为了对接触力进行更详细的定量分析,分别通过VR遥操作和TactAR采集了同一用户的剥离任务数据(10个demo),然后计算了窗口大小为10步的记录力曲线的滚动标准差,结果如Fig.13所示。使用TactAR采集数据有助于避免较大的滚动标准差,表明时间波动减少,接触力更稳定。

Q7. Data with higher stability of contact forces will help the model to discover useful patterns more easily

接触力稳定性更高的数据将有助于模型更轻松地发现有用的模式。作者采集了与传统 VR 遥操作(无触觉/力反馈)剥离任务相同数量的60条演示,并使用这些数据训练了 RDP。Fig.14 结果表明,数据质量对策略性能有很大影响(分数下降 30% 以上)。使用低质量数据训练的策略表现出更不稳定的性能,例如剥离过程中的力更不稳定,并且中途断裂的可能性更高。一种可能的解释是,RDP 中的快速策略旨在从数据中识别触觉/力信号和轨迹之间的关联并学习反应行为。当数据中的接触力高度不稳定时,快速策略很难识别合理的关联,从而降低性能。

6. Limitations And Future Works

虽然 TactAR 和 RDP 已在众多挑战性任务中展现出功效,但它们仍存在某些局限性:

TactAR可以在 AR 中提供一定程度的触觉/力反馈,但它并不像直接的人手操作那样直观或高效。未来的工作可以通过进一步减少传感器和系统延迟来提高遥操作效率;TactAR系统专为双指夹持器而设计。将TactAR系统和 RDP 算法扩展到配备触觉传感器的灵巧手,为未来的研究提供了一个有希望的方向。- RDP 算法中的快速策略目前仅限于响应高频触觉/力输入信号,但无法快速处理高频图像输入。未来的研究可以考虑将高频视觉输入纳入快速网络,使其适用于更广泛的任务类型。

- 最后,RDP 算法目前仅限于单任务场景。未来的工作可以将 RDP 与VLA模型集成,方法是将 VLA 分词器替换为类似于 RDP 算法中的非对称分词器。这种集成可以在 VLA 中引入具有实时触觉/力反馈的闭环控制的反应行为。

7. Conclusion

在本文中,作者介绍了TactAR,一种通过AR提供实时触觉/力反馈的低成本遥操作系统;以及反应扩散策略(RDP),一种用于接触密集型操作的新型慢速-快速模仿学习算法。TactAR 证明了无需昂贵的专用硬件,即可通过AR可视化实现高质量的触觉/力反馈。RDP通过其分层设计成功地解决了序列建模和闭环控制之间的权衡,使用慢速网络进行复杂的轨迹规划,使用快速网络进行反应式触觉反馈控制。通过在三个具有挑战性的接触密集型任务上进行的大量实验,s证明了RDP在任务完成度和对触觉反馈的反应性方面显著优于最先进的视觉IL基线。跨传感器实验进一步验证了我们的方法在不同的触觉/力传感器上具有良好的泛化能力。这项工作朝着使视觉-触觉模仿学习更加实用和易于理解迈出了重要的一步。

3057

3057

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?