01

引言

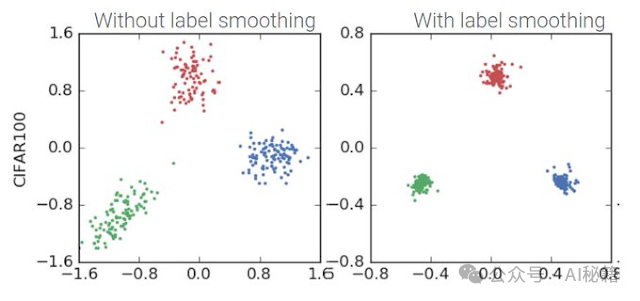

标签平滑(Label Smoothing)是一种正则化技术,用于深度学习中的分类任务,尤其是在Transformer模型中。它的目的是减少模型对于训练数据中硬标签(hard labels,即标准的one-hot编码)的过度自信,从而提高模型的泛化能力并减少过拟合。

02

理解

标签平滑的原理

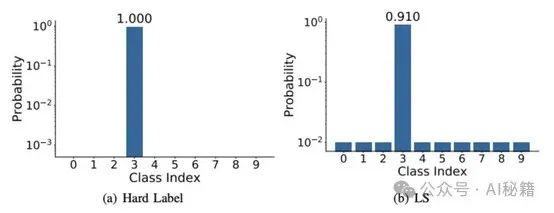

在传统的分类任务中,模型的输出通常通过softmax函数转换为概率分布,然后使用交叉熵损失函数与硬标签(one-hot编码)进行比较。硬标签意味着模型完全确定某个类别是正确的,其他所有类别都是错误的。这种方法可能会导致模型在训练数据上过拟合,因为它鼓励模型对正确类别的预测非常自信。

标签平滑通过将硬标签(hard labels)转换为软标签(soft labels)来解决这个问题。在软标签中,正确类别的概率不再是1,而是稍微小一些的值(例如,0.9),同时其他类别的概率也不再是0,而是分配了一个小的正数(例如,0.1 / 类别数)。

这意味着原本标签为1的位置会乘以一个小于1的因子(平滑系数),而原来为0的位置则会被赋予一个非零的值(平滑系数除以类别数K),这样就在标签中引入了一定的噪声。

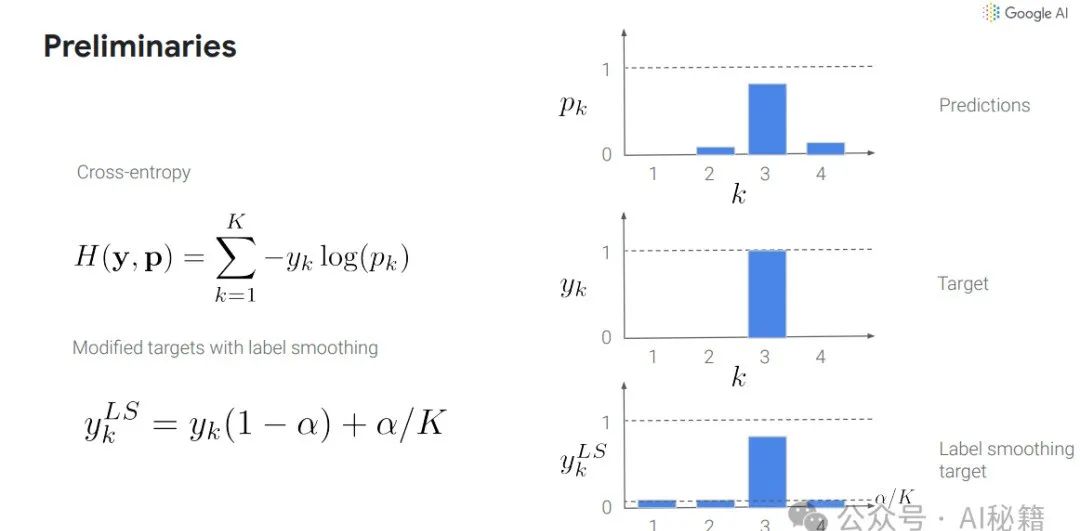

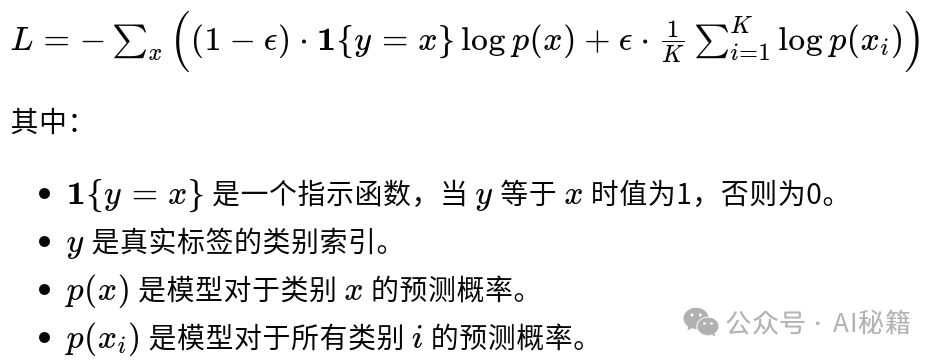

标签平滑的公式

标签平滑的计算公式如下:

举例说明

假设我们有一个3分类问题,类别为A、B、C。在没有标签平滑的情况下,如果一个样本属于类别A,那么它的硬标签将是[1, 0, 0]。

标签平滑的优势在于

提升泛化能力:通过减少模型对硬标签的依赖,增加了模型在训练时的不确定性,使模型在面对未见过的数据时更加鲁棒。

降低过拟合风险:模型不会过分自信于任何一个类别,这有助于减轻过拟合现象。

改善模型校准:有助于提高模型预测值的置信度与实际准确度之间的一致性。

03

在Transformer中的应用

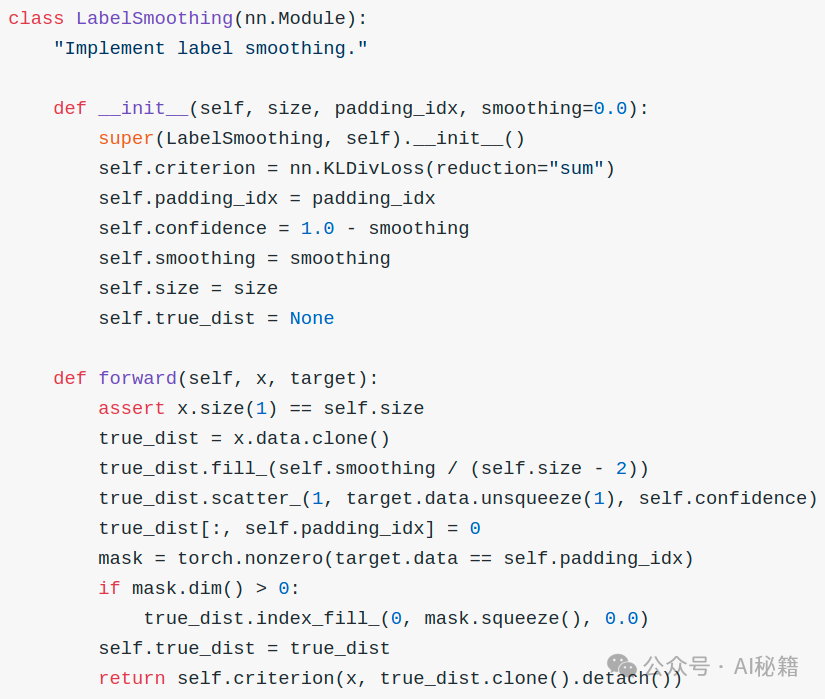

在Transformer模型中,标签平滑通常与交叉熵损失函数结合使用。这种结合的目的是在训练过程中提高模型的泛化能力,减少过拟合,并提高模型对不确定性的处理能力。下面详细解释这个结合是如何工作的:

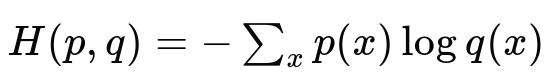

交叉熵损失函数

在分类问题中,交叉熵损失函数(Cross-Entropy Loss)是衡量模型输出的概率分布与真实标签的概率分布之间差异的常用方法。对于多分类问题,交叉熵损失可以定义为:

其中:

-

( p ) 是真实标签的概率分布(在标签平滑的情况下,这是平滑后的软标签)。

-

( q ) 是模型预测的概率分布。

标签平滑的应用

在标签平滑中,真实标签 ( p ) 不再是硬编码的one-hot向量,而是变成了软标签。例如,对于一个类别为 ( C ) 的正确标签,其one-hot表示为 ( [0, 0, …, 1, …, 0] ) (类别 ( C ) 位置为1),在标签平滑后,它会变成 ( [e/K, e/K, …, 1-e, …, e/K] ) ,其中 ( e ) 是一个小于1的平滑系数(如0.1),( K ) 是类别总数。

标签平滑与交叉熵损失的结合

当使用标签平滑的软标签与交叉熵损失结合时,模型的损失函数变为:

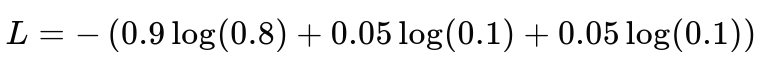

举例说明

假设我们有一个3分类问题,模型预测一个样本属于类别A的概率为0.8,属于类别B和C的概率各为0.1。如果未使用标签平滑,真实标签为[1, 0, 0]。使用标签平滑,假设平滑系数为0.1,则真实标签变为[0.9, 0.05, 0.05]。

交叉熵损失计算如下:

这种计算方式使得模型即使对于非常有信心的预测也不会过于自信,因为其他类别的非零概率增加了模型的不确定性,从而鼓励模型在训练过程中考虑到更多类别的可能性。

标签平滑与交叉熵损失的结合使用,通过引入软标签,提高了模型对于标签噪声的鲁棒性,减少了模型在训练数据上的过拟合,从而在实际应用中提高了模型的泛化能力。这种技术在Transformer模型中尤其有用,因为Transformer模型通常用于复杂的序列建模任务,如机器翻译、文本摘要等,这些任务中标签的不确定性较高。

04

小结

在Transformer模型中,标签平滑通常用于处理语言模型的输出。例如,在机器翻译任务中,模型需要预测下一个单词的概率分布。使用标签平滑可以防止模型对于任何单个预测过于自信,从而提高模型在面对新的、未见过的数据时的鲁棒性。

在Transformer模型中,标签平滑通常与交叉熵损失函数结合使用。通过对标签进行平滑处理,模型的输出不再是绝对的one-hot分布,而是更加平滑的概率分布,这有助于模型在训练过程中学习到更加合理的概率边界。

在实际应用中,标签平滑的平滑系数是一个超参数,需要根据具体任务和数据集进行调整。此外,标签平滑也可以与其他正则化技术(如Dropout、权重衰减等)结合使用,以达到更好的效果。

总之,标签平滑是一种简单而有效的技术,可以在不牺牲太多预测精度的情况下,提高模型的泛化能力和鲁棒性。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

402

402

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?