概率时间序列预测是在广泛应用中出现的一个重要实际问题,包括金融、天气预报、脑成像和计算机系统性能管理等领域。针对这一任务,已经提出了各种方法,从传统的自回归模型到最近基于深度学习架构的神经预测方法。这些以前的方法大多集中在用来自相同领域的数据训练模型,以执行预测任务。

然而,在过去的几年里,由于基础模型的兴起,机器学习正在经历一场范式转变。基础模型是一种大规模、通用的神经网络,以无监督的方式在大量多样化的数据上进行预训练。这些模型在广泛的下游任务上展示出了显著的少量样本泛化能力,通常优于特定于任务的模型。

本文介绍一篇来自摩根士丹利等机构研究者的最新工作,他们的目标是**开发用于时间序列的基础模型,研究它们在大规模上的行为,并突破在不同时间序列领域之间可实现的迁移的极限。**研究者希望通过这项研究,为时间序列预测领域带来与在自然语言和图像处理领域所见到的类似的变革和进步。

论文地址:https://arxiv.org/abs/2310.08278

论文源码:https://github.com/kashif/pytorch-transformer-ts

概述

研究者在大量时间序列数据集上训练了一个Transformer模型,并在一个未见的“分布外”数据集上评估了其性能。具体来说,研究者们研究了使用预训练的时间序列模型进行单变量概率时间序列预测用例,并介绍了在Monash时间序列存储库的大量时间序列上训练的Lag-Llama模型。进而报告了该模型在未见时间序列数据集上的测试集性能,并进行了关于参数数量和训练数据的神经扩展定律研究。

初步结果表明,预训练的时间序列模型可以有效地用于单变量概率时间序列预测,并在未见的数据集上显示出良好的性能。Lag-Llama模型在测试集上的表现尤其出色,这可能是因为该模型在大量多样化的时间序列数据上进行了预训练。此外,研究者的神经扩展定律研究表明,模型的性能和训练数据、参数数量之间存在一定的关系,这为未来的模型改进和优化提供了有价值的指导。

研究者的贡献如下:

- 提出了Lag-Llama模型,这是一种适用于时间序列基础模型扩展定律分析的单变量概率时间序列预测模型。

- 在一个时间序列数据集语料库上训练了Lag-Llama,并证明当在未见的时间序列数据集上进行零样本测试时,Lag-Llama的性能优于或与有监督的基线方法相当。研究者确定了一个“稳定”的区域,在该区域内,当模型大小超过某个阈值时,模型的性能始终优于基线方法。

- 拟合了模型零样本测试性能的实证扩展定律作为模型大小的函数,这使得可能外推和预测本文所用模型之外的泛化能力。

方法介绍

概率时间序列预测是一种预测时间序列未来值的方法,它考虑了预测中的不确定性或随机性。与确定性预测不同,概率预测提供了一种预测未来值的可能范围或概率分布,从而反映了预测的不确定性和风险。

该论文构建了一个通用单变量概率时间预测模型Lag-Llama,在来自Monash Time Series库中的大量时序数据上进行了训练,并表现出良好的零样本预测能力。

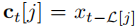

Lag-Llama考虑的并不是像Nbeadts或TSMixer中的外部变量,而是来自序列本身的值。通常考虑一定的时间滞后,例如季度、月度、周度、日度、小时和秒级等,选取序列值 ,以匹配时间序列数据的周期性变化。当然研究者也指出可以将单序列分成存在重叠的多个patch作为协变量,但这些patch中的数据点可能不再遵循时间上的因果性,因此研究者更推荐第一种。

,以匹配时间序列数据的周期性变化。当然研究者也指出可以将单序列分成存在重叠的多个patch作为协变量,但这些patch中的数据点可能不再遵循时间上的因果性,因此研究者更推荐第一种。

Lag-Llama是基于最近的LlaMA架构构建的,通过RMSNorm实现预归一化,并在每个注意力层的Q和K表示中加入了旋转位置编码(RoPE)。在模型中,输入的单变量序列首先通过滞后操作进行向量化,然后通过共享的线性投影层映射到隐藏维度。接下来,数据经过掩码Transformer层处理,并使用分布头预测所选分布的参数。最后,通过最小化预测窗口上的负对数似然来优化模型的预测性能。

Lag-Llama模型

Lag-Llama模型的最后一层是一个特殊的层,称为分布头(Distribution Head),它将模型的特征投影到概率分布的参数上。我们可以将不同的分布头与模型的表示能力相结合,以输出任何参数化概率分布的参数。在初步实验中,研究者使用了Student’s t-distribution(学生t分布),并输出了与该分布相对应的三个参数,即其自由度、均值和尺度。在后续的工作中,大家或许可以选择更加复杂的分布形式,如规范化流(normalizing flows)和联结函数(copulas)。

为了解决时间序列数据中数值大小的问题,研究者采用了值缩放的方法。对于每个单变量窗口,会计算其均值和方差,并根据这些统计值对窗口中的时间序列进行缩放。同时,还将均值和方差作为与时间无关的实值协变量纳入模型考虑。

在训练和获取似然性的过程中,使用均值和方差对值进行转换,而在采样时,采样的每个时间步的数据都使用相同的均值和方差进行反标准化。这种技术早于最近的相关方法,如RevIN方法和非平稳Transformer。

研究者采用了时间序列增强技术Freq-Mix和Freq-Mask来防止模型过拟合,每个批次有50%的概率应用这些技术,并随机选择10%的数据进行增强。为了确保采样的均衡性,研究者使用了分层抽样方法,并根据数据集中总时间点的数量对数据进行加权处理。

实验数据与结果

研究者使用Monash时间序列存储库和其他常用来源的时间序列数据来训练Lag-Llama模型。这些数据集的频率和应用领域各不相同,包含超过30万个时间序列。为了评估模型的泛化性能,研究者选择了M4 Weekly和Traffic数据集作为测试集,这些测试集在训练期间是不可见的。未来研究者还将探索其他的训练-测试数据分割方式。

训练数据集:

https://arxiv.org/abs/2105.06643

https://arxiv.org/pdf/1906.05264.pdf

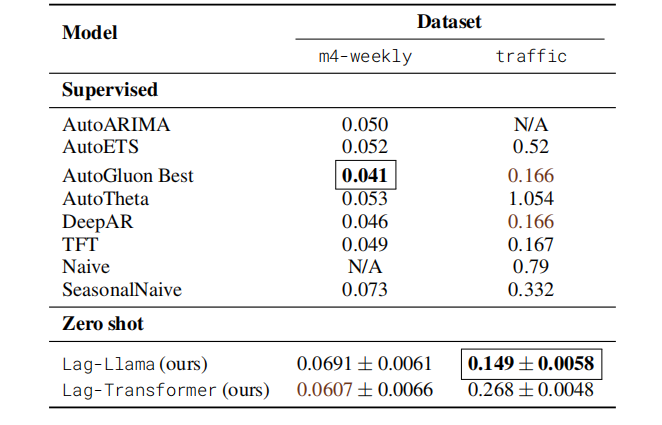

研究者比较了Lag-Llama模型在两个数据集上的零样本性能与在这些数据集上训练的基线模型的性能。最佳性能以粗体突出显示,次佳性能以棕色显示。研究者使用CRPS指标来评估模型性能,数值越低表示性能越好。

零样本数据集测试结果

从上表中可以看出,Lag-Llama在Traffic零样本上取得了更好的性能,超过了所有有监督的基线,而Lag-Transformer在Traffic上的表现不佳。而在m4-weekly数据集上,Lag-Llama和Lag-Transformer都没有超过基线。这表明,对于两种不同的训练和测试分割,这两种架构都有很大的详细分析空间,可以改进数据采样或模型选择。

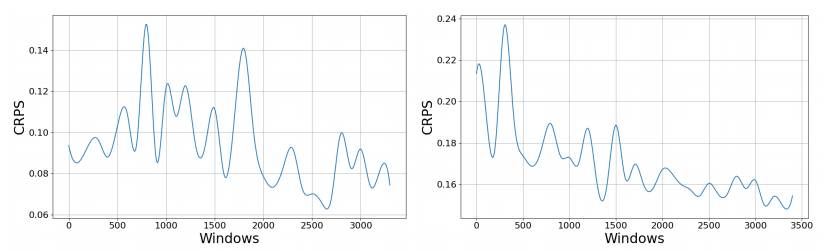

Lag-Llama数据缩放曲线

如上图所示,最佳Lag-Llama相对于在训练期间从数据集的训练语料库中看到的数据窗口数量的零样本CRPS(mean_wQuantileLoss,越低越好)。数据缩放曲线是针对M4 Weekly(左)和Traffic(右)报告的。

这些曲线展示了随着训练期间观察到的数据窗口数量的增加,Lag-Llama在M4 Weekly和Traffic两个数据集上的零样本性能如何变化。通过比较这两个数据集上的曲线,我们可以了解Lag-Llama在不同类型的时间序列数据上的性能差异。同时,这些数据缩放曲线也有助于我们了解模型在不同规模的数据上的性能表现,从而为我们选择合适的训练数据量提供参考。

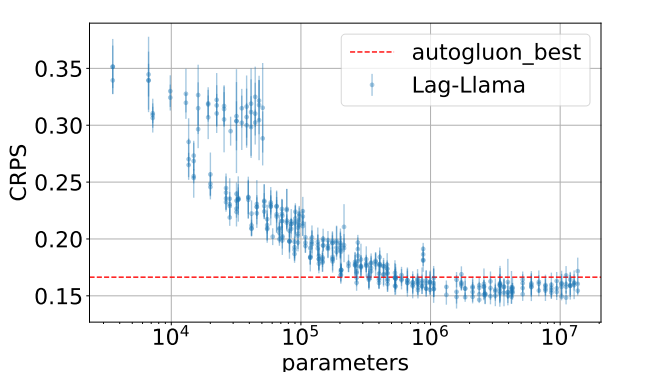

研究者研究了不同大小的模型对性能的影响,训练了一系列大小各异的模型,并测试了它们在不同规模下的性能。结果表明,Lag-Llama在大约10^6个参数后,在没有经过Traffic数据集训练的情况下,性能超过了基线,并在多种可能的超参数配置下实现了稳定的零样本性能。同时,研究者也对Lag-Transformer模型进行了类似的分析。

不同参数量的Lag-Llama模型在traffic数据集上的表现

总结

在这项工作中,研究者提出了提出了一个用于概率时间序列预测的基础模型Lag-Llama。Lag-Llama的零样本性能优于或与监督基线相当,并且随着模型大小的增加,其性能在各种超参数配置下都有所提高并趋于稳定。

研究者进一步拟合了平滑断裂幂律,以模拟模型的测试性能与其大小之间的关系。除了这些初步实验外,研究者计划首先对各种架构设计和模型选择进行消融实验,将以留一法的方式评估模型在其他数据集上的零样本性能,以获得一系列数据集的零样本性能结果,从而进行有趣的分析。研究者还计划在下游数据集的训练分割上对预训练模型进行微调,并评估他们的模型在不同数据集上的少样本和多样本微调性能。最后,研究者计划扩大模型规模和多样化时间序列训练数据的数量,同时比较这种架构和其他候选架构用于时间序列基础模型的缩放定律。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

1644

1644

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?