PCIE基础

*参考文献:PCIe基础知识及Xilinx相关IP核介绍_xilinx pcie-CSDN博客

PCI Express总线是为了取代PCI总线的第三代I/O技术,但是对于系统软件,PCIe是向前兼容PCI总线的,理解PCIe总线必须建立在深刻理解PCI总线的基础上。

-

点到点的数据传输

PCIe总线的物理链路的一个数据通路(lane)中,有两组差分信号。 PCIe总线物理链路间的数据传送使用基于时钟的同步传送机制,但是在物理链路中没有时钟,在接收端使用时钟恢复模块(clock data recovery,CDR)提取接收时钟。 PCIe链路可以由多条lane组成,即PCIe x2 x4 x8分别代表有2,4,8条lane。

-

PCIe总线使用的信号 这里主要是注意PCIe设备与PCIe插槽都具有REFCLK+/-信号,PCIe插槽使用这组信号与处理器系统同步。 PCIe插槽向下兼容,比如PCIex2,x4都可以插x8的插槽。

-

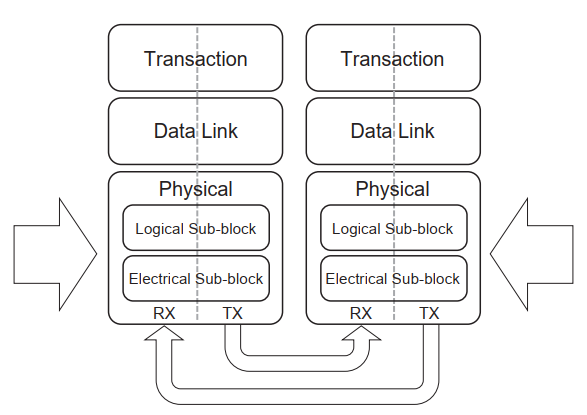

PCIe总线的层次结构 上面的层次组成结构图展示了PCIe总线的层次组成结构。

数据报文首先经过事务层(Transaction layer),数据链路层(data link layer),和物理层(physical layer),最终发送出去。接收则相反,这里面每一层都会对数据进行处理。

-

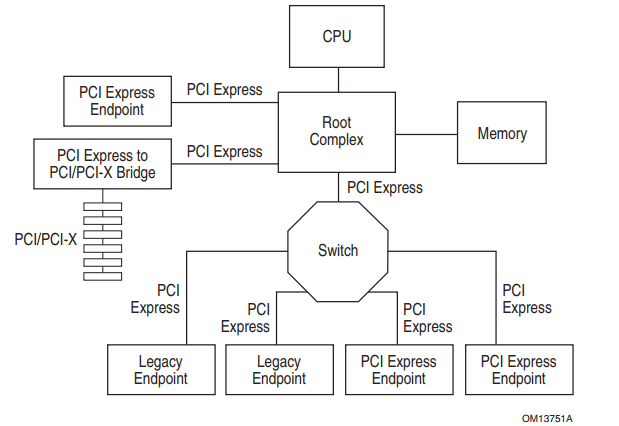

Root Complex:RC,将PCIe总线端口,存储器控制器等一系列与外部设备有关的接口都集成在一起,统称为RC。

-

Endpoint:EP,基于PCIe总线的设备。

-

Switch: 一个特殊的设备,多个虚拟PCI-to-PCI桥接设备的逻辑组件,该设备由1个上游端口和2~n个下游端口组成。

XDMA与QDMA原理对比

DMA映射方式

Xilinx的两款FPGA平台xdma和qdma-CSDN博客

-

XDMA:

-

使用流式DMA映射。这种映射方式通常涉及在每次DMA传输前后执行缓存失效或清除操作,以解决缓存一致性的问题。流式DMA映射通常在每次DMA传输前后进行,这增加了复杂性和开销。

-

相关函数:dma_map_single 和 dma_unmap_single 用于在每次DMA传输时映射和取消映射。

-

-

QDMA:

-

使用一致性DMA映射。这种方式下,申请的缓存区能够使用缓存,并且保持缓存一致性。一致性映射具有较长的生命周期,在这段时间内占用的映射寄存器不会被释放,即使在这段时间内不使用也不会释放。

-

主要用到的函数是 dma_alloc_coherent 和 dma_free_coherent,前者直接从DMA区域申请内存,后者释放申请的内存。

-

数据搬移方式

-

XDMA:xdma使用小结-CSDN博客

-

通过AXI4 Memory Mapped(AXI MM)或AXI Stream(AXI ST)接口进行数据搬移。

-

AXI MM接口通常用于与DDR之间的通信,而AXI Stream用于FIFO等数据缓冲区。

-

-

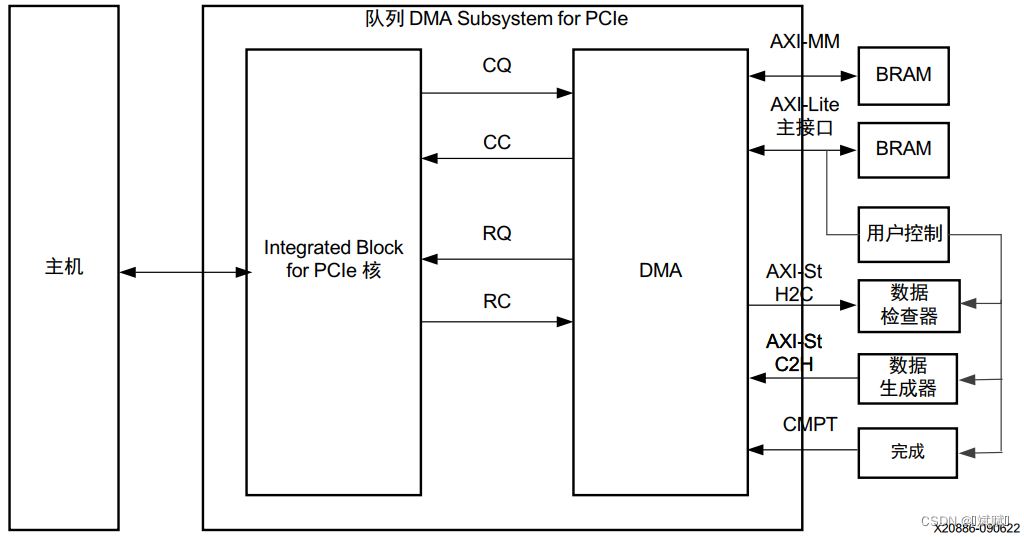

QDMA:Multi-Channel PCIe QDMA Subsystem - adrifter - 博客园 (cnblogs.com)

-

通过AXI4 Stream接口直接连接RTL逻辑,支持高达16个upstream和downstream通道,每个通道支持深度为32的DMA地址队列。

-

除了基本的DMA功能,QDMA还允许PCIe通信绕过DMA引擎。

-

队列与通道机制

-

XDMA:

-

通常提供较少的专用DMA通道(如4个H2C和4个C2H通道),每个通道作为独立的DMA引擎。

-

不支持SR-IOV20。

-

-

QDMA:

-

支持多达2048个队列,这些队列共享相同的DMA引擎资源。

-

支持SR-IOV(Single Root I/O Virtualization),允许多个物理功能(PF)或虚拟功能(VF)分配队列。

-

缓存行为

-

XDMA:

-

在每次DMA传输前后需要处理缓存一致性问题,可能涉及缓存刷新或使无效操作。

-

-

QDMA:

-

由于使用一致性DMA映射,可以保持缓存一致性,减少了每次传输前后的额外开销。

-

使用对比 - 硬件兼容性

-

XDMA:

-

支持更广泛的FPGA系列,包括较旧的系列20。

-

-

QDMA:

-

仅支持Xilinx的Ultrascale+系列FPGA20。

-

驱动与应用程序

-

XDMA:

-

驱动程序相对简单,主要用于配置DMA通道和传输数据。

-

-

QDMA:

-

驱动程序提供了更多功能,如多队列支持、SR-IOV等。

-

应用程序方面,QDMA提供了如dma-ctl、dma-to-device、dma-from-device等工具。

-

XDMA/QDMA性能对比【可能存在错误】

1. 带宽

-

XDMA:

-

XDMA提供了多个独立的DMA通道(例如,4个主机到设备和4个设备到主机的DMA通道),每个通道都有其自身的带宽限制。因此,总的带宽受限于这些通道的最大传输能力。

-

实际测试表明,在某些条件下,XDMA可以达到较高的传输速率,例如,在PCIe Gen3 @ x8的情况下,从设备到主机的传输速率可以达到450MB/s左右,而从主机到设备的传输速率可以达到455MB/s左右。Xilinx FPGA PCIe XDMA性能测试报告(二)_xdma 效率-CSDN博客

-

-

QDMA:

-

QDMA支持多达2048个队列,这意味着理论上它可以提供更高的带宽,尤其是在多任务或多队列环境中,因为队列可以并行处理数据传输。

-

在PCIe 3.0 x16的情况下,C2H DMA速率可以达到1660MB/s,H2C DMA速率可以达到1670MB/s。而在PCIe 2.0 x8的情况下,C2H DMA速率可以达到450MB/s,H2C DMA速率可以达到455MB/s。Multi-Channel PCIe QDMA Subsystem - adrifter - 博客园 (cnblogs.com)

-

2. 延迟

Xilinx DMA的几种方式与架构 - Hello-FPGA - 博客园 (cnblogs.com)

-

XDMA:

-

XDMA在某些情况下可能会遇到较高的延迟,特别是当多个任务竞争相同的DMA通道时。

-

由于使用流式DMA映射,XDMA可能需要在每次DMA传输前后执行缓存失效或清除操作,这会增加延迟。

-

-

QDMA:

-

QDMA由于支持更多的队列,可以在多任务环境下提供更好的延迟表现。此外,QDMA可以通过硬件加速来进一步提高性能,从而减少延迟。

-

由于使用一致性DMA映射,QDMA可以在整个映射期间保持缓存一致性,从而减少每次DMA传输的开销。

-

3. 吞吐量

-

XDMA:

-

XDMA的吞吐量受限于其DMA通道的数量。如果多个任务需要同时使用DMA通道,则可能会出现拥塞,从而降低吞吐量。

-

在实际应用中,XDMA结合DDR4-SDRAM缓存的性能测试表明,其吞吐量可以达到几千MB/s的水平。

-

-

QDMA:

-

QDMA的多队列设计使其在多任务环境下提供更好的吞吐量表现。由于队列可以并行处理数据传输,因此总体吞吐量可以显著提高。

-

在PCIe 3.0 x16的情况下,QDMA的吞吐量可以达到1600MB/s以上。

-

4. CPU负载

-

XDMA:

-

XDMA的DMA操作需要频繁地与CPU交互,尤其是在处理缓存一致性问题时。这可能导致较高的CPU负载。

-

由于需要处理缓存一致性问题,XDMA在某些情况下可能需要更多的CPU介入。

-

-

QDMA:

-

QDMA的设计目的是减少CPU的干预,特别是在使用一致性DMA映射时。这可以降低CPU负载,让CPU专注于其他计算密集型任务。

-

QDMA通过队列机制实现了更高效的DMA操作,减少了CPU的负担。

-

5. 功耗

-

XDMA:

-

因为XDMA可能需要频繁处理缓存一致性问题,这可能会导致更高的功耗。

-

在某些情况下,XDMA的功耗可能高于QDMA。

-

-

QDMA:

-

通过减少CPU的干预,QDMA可能在某些情况下实现更低的功耗。

-

QDMA的队列机制允许更高效的DMA操作,从而可能降低整体功耗。

-

6. 多任务支持

-

XDMA:

-

XDMA的固定DMA通道数量限制了其多任务处理能力。

-

在需要处理多个并发任务时,XDMA的性能可能会受到限制。

-

-

QDMA:

-

QDMA的多队列设计使其非常适合多任务环境,可以更好地支持并发数据传输。

-

QDMA支持高达2048个队列,使得它在处理大量并发任务时表现优异。

-

QDMA的使用

1 测试工程

https://github.com/binfu1/vivado-dma/tree/master/qdma

使用QDMA的Example工程,该工程可从Github下载,使用的FPGA板卡为浪潮的F37X加速器,运行工程目录下的run.sh执行run.tcl即可完成工程的创建和编译。

2 驱动安装

本节主要介绍QDMA驱动的源文件、编译和安装过程。

2.1 源文件说明

1.下载地址:DMA驱动下载 2.文件说明

| 文件 | 说明 |

|---|---|

| apps | 应用文件 |

| docs | 说明文件 |

| driver | 驱动源文件 |

| scripts | 脚本文件 |

| RELEASE | 版本说明 |

| Makefile.txt | Makefile |

| bsd_license.txt | 证书 |

| COPYING | 权限 |

| license.txt | 证书 |

2.2 驱动编译安装

1.依赖库安装:QDMA驱动依赖于libaio,所以在编译驱动前需要安装该库。

sudo apt-get install libaio-dev

2.驱动编译 2.1 执行make clean && make命令完成驱动文件的编译,在文件夹会生成bin文件夹,里面包含下述文件。如果需要添加新设备,可以在driver/src/pci_ids.h文件中添加。

| 文件 | 说明 |

|---|---|

| dma-ctl | QDMA的控制和配置应用程序 |

| dma-to-device | 执行MM或ST模式的host-to-card的传输事务 |

| dma-from-device | 执行MM或ST模式的card-to-host的传输事务 |

| dma-perf | 测量QDMA的性能 |

| qdma-pf.ko | PF驱动 |

| qdma-vf.ko | VF驱动 |

| dma-latency | 测量ST H2C/C2H传输的乒乓延时 |

| dma-xfer | 说明QDMA传输的简单应用 |

2.2 如果只需要PF驱动可以执行make driver MODULE=mod_pf 2.3 如果只需要VF驱动可以执行make driver MODULE=mod_vf 2.4 如果要启用CPM5的VF 4K队列,执行make EQDMA_CPM5_VF_GT_256Q_SUPPORTED=1

3.驱动安装 3.1 执行sudo make install安装驱动和应用程序,执行完该命令后在/user/local/sbin文件下生成dma-ctl、dma-to-device等应用程序,在/lib/modules/<kernel version>/qdma文件夹下生成qdam-pf.ko和qdma-vf.ko驱动程序。 3.2 如果只安装驱动程序,可以执行sudo make install-mods 3.3 如果只安装应用程序,可以执行sudo make install-apps 3.4 如果需要卸载驱动和应用程序,可以执行sudo make uninstall

4.驱动加载 4.1 下载FPGA程序,执行lspci -vd <vendor id>找到设备的BDF号。 4.2 在加载驱动前需要生成一个qdma.conf文件放到/etc/modprobe.d文件夹下,用于参数传递。在scripts文件夹下有一个qdma_generate_conf_file.sh脚本,辅助生成配置文件。执行下述命令,脚本会自动在/etc/modprobe.d文件夹下生成qdma.conf文件。

sudo ./qdma_generate_conf_file.sh <bus_num> <num_pfs> <mod> <config_bar> <master_pf>

| 参数 | 说明 |

|---|---|

| bus_num | BDF中的B |

| num_pfs | PF支持的数量,默认为4 |

| mod | 驱动的模式,默认为0 0-Auto;1-Poll;2-Direct Interrupt 3-Indirect Interrupt; 4-Legacy Interrupt |

| config_bar | 配置的BAR空间 |

| master_pf | 主PF |

4.3 执行sudo modprobe qdma-pf加载PF驱动,执行sudo modprobe qdma-vf加载VF驱动。由于在/lib/modules/<kernel version>/qdma文件夹下有qdam-pf.ko和qdma-vf.ko驱动程序,所以系统在启动时会自动加载这两个驱动。如果不需要开机加载这两个驱动,可以在/etc/modprobe.d/blacklist.cof文件中添加blacklist qdma-pf和blacklist qdma-vf语句。 5.修改qmax 执行下述命令修改最大队列数,安装驱动后默认的qmax是0,在执行测试脚本时出现错误,提示“unable to open device /dev/qdma82000-MM-0”。重启系统后这个值会恢复为0。

cat /sys/bus/pci/devices/0000:01:00.0/qdma/qmax // 显示qmax echo 8 > /sys/bus/pci/devices/0000:01:00.0/qdma/qmax // 设置qmax为8

6.设置VF数量

cat /sys/bus/pci/devices/0000:01:00.0/sriov_totalvfs // 显示每个PF的VF数量 echo 3 > /sys/bus/pci/devices/0000:01:00.0/sriov_numvfs // 设置每个PF的VF数量为1024

3 调试工具

3.1 设备管理

应用dma-ctl用于管理驱动,可以实现下述功能,通过命令dma-ctl -h可查看帮助文件。

-

列出设备信息

dma-ctl dev list // 列出系统可使用的PF和VF,以及每个function的queue base和queue max dma-ctl qdma<bdf> cap // 列出硬件和软件的版本信息 dma-ctl qdma<bdf> stat // 列出数据统计信息

-

添加一个或多个队列

dma-ctl qdma<bdf> q add idx <N> [mode <st|mm>] [dir <h2c|c2h|bi|cmpt>] // N-队列编号 dma-ctl qdma<bdf> q add list <start_idx> <num_Qs> [mode <st|mm>] [dir <h2c|c2h|bi|cmpt>]

-

开始一个或多个队列

dma-ctl qdma<bdf> q start idx <N> [dir <h2c|c2h|bi|cmpt>] dma-ctl qdma<bdf> q start list <start_idx> <num_Qs> [dir <h2c|c2h|bi|cmpt>]

-

暂停一个或多个队列

dma-ctl qdma<bdf> q stop idx <N> [dir <h2c|c2h|bi|cmpt>] dma-ctl qdma<bdf> q stop list <start_idx> <num_Qs> [dir <h2c|c2h|bi|cmpt>]

-

删除一个或多个队列

dma-ctl qdma<bdf> q del idx <N> [dir <h2c|c2h|bi|cmpt>] dma-ctl qdma<bdf> q del list <start_idx> <num_Qs> [dir <h2c|c2h|bi|cmpt>]

-

输出一个或多个队列信息

dma-ctl qdma<bdf> q dump idx <N> [dir <h2c|c2h|bi|cmpt>] dma-ctl qdma<bdf> q dump list <start_idx> <num_Qs> [dir <h2c|c2h|bi|cmpt>]

-

输出一个或多个队列描述符信息

dma-ctl qdma<bdf> q dump idx <N> [dir <h2c|c2h|bi|cmpt>] [desc <x> <y>] // <x>-range start;<y>-range end dma-ctl qdma<bdf> q dump list <start_idx> <num_Qs> [dir <h2c|c2h|bi|cmpt>] [desc <x> <y>]

-

输出一个或多个队列完成信息

dma-ctl qdma<bdf> q dump idx <N> [dir <h2c|c2h|bi|cmpt>] [cmpt <x> <y>] dma-ctl qdma<bdf> q dump list <start_idx> <num_Qs> [dir <h2c|c2h|bi|cmpt>] [cmpt <x> <y>]

输出中断信息

dma-ctl qdma<bdf> intring dump vector <N> <start_idx> <end_idx>

3.2 数据读写

-

读寄存器

dmactl qdma<bdf> reg read bar <N> <addr> // N-Bar号;addr-地址

-

写寄存器

dmactl qdma<bdf> reg write bar <N> <addr>

-

输出队列寄存器

dmactl qdma<bdf> reg dump [dmap <Q> <N>] // Q-队列号;N-队列数量

-

写入数据

dma-to-device [OPTIONS] -d (--device) device path from /dev. Device name is formed as qdmabbddf-<mode>-<queue_number> -a (--address) the start address on the AXI bus -s (--size) size of a single transfer in bytes, default 32 bytes -o (--offset) page offset of transfer -c (--count) number of transfers, default 1 -f (--data input file) filename to read the data from. -w (--data output file) filename to write the data of the transfers -h (--help) print usage help and exit -v (--verbose) verbose outpu

-

读出数据

dma-from-device [OPTIONS] -d (--device) device path from /dev. Device name is formed as qdmabbddf-<mode>-<queue_number> -a (--address) the start address on the AXI bus -s (--size) size of a single transfer in bytes, default 32 bytes. -o (--offset) page offset of transfer -c (--count) number of transfers, default is 1. -f (--file) file to write the data of the transfers -h (--help) print usage help and exit -v (--verbose) verbose output

4 测试分析

4.1 测试脚本

执行脚本qdma_run_test_pf.sh完成对PF的测试,执行命令如下,整个测试流程包括获取设备、设置复位、h2c和c2h的mm接口测试、h2c的st接口测试和c2h的st接口测试。

sudo ./qdma_run_test_pf.sh <bdf> <qid_start> <num_qs> <desc_bypass_en> <pfetch_en> <pfetch_bypass_en> <flr_on>

| 参数 | 说明 |

|---|---|

| bdf | 设备的BDF号 |

| qid_start | 队列的起始ID |

| num_qs | 从qid_start开始的队列数量,默认为04 |

| desc_bypass_en | 使能描述符旁路,默认为0 |

| pfetch_en | 使能预取,默认为0 |

| pfetch_bypass_en | 使能预取旁路,默认为0 |

| flr_on | 启用function level reset,默认为0 |

-

获取设备:get_dev 执行

dma-ctl dev list获取设备信息。 -

设置复位:set_flr 如果设置了function level reset,则对修改系统中的reset文件对PCIe设备进行复位。

-

MM测试:run_mm_h2c_c2h 1.找到AXI Lite的bar空间:get_user_bar 2.设置设备:dev_mm_c2h、dev_mm_h2c、out_mm 3.开始队列传输:queue_start,执行

dma-ctl q add、dma-ctl q start4.传输数据到FPGA:dma_to_device 5.从FPGA中取出数据:dma_from_device 6.比较两个文件的内容是否相等,结束测试。 7.清理队列:cleanup_queue,执行dma-ctl q stop、dma-ctl q del -

H2C测试 1.找到AXI Lite的bar空间:get_user_bar 2.设置设备:dev_st_h2c 3.开始队列传输:queue_start,执行

dma-ctl q add、dma-ctl q start4.传输数据到FPGA:dma_to_device 5.读取FPGA的数据对比结果dma-ctl reg read,结束测试。 6.清理队列:cleanup_queue,执行dma-ctl q add、dma-ctl q start -

C2H测试 1.找到AXI Lite的bar空间:get_user_bar 2.设置设备:dev_st_c2h、out_st 3.开始队列传输:queue_start,执行

dma-ctl q add、dma-ctl q start4.传输数据到FPGA:dma_from_device 5.比较两个文件的内容是否相等,结束测试。 6.清理队列:cleanup_queue,执行dma-ctl q add、dma-ctl q start

4.2 测试结果

-

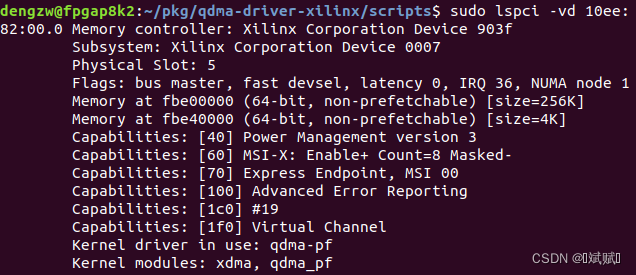

查看PCIe设备

-

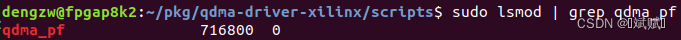

查看驱动加载情况

-

查看驱动绑定的设备信息, 如果qmax为0,则需要设置非零的qmax,否则无法找到设备。

7475

7475

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?