文章目录

1. cpu结果图

1.1. onnx

1.2. libtorch

2. 使用工具版本

- 系统:Windows10

- visual studio 2019

- CMake 3.28.1

- opencv 4.9

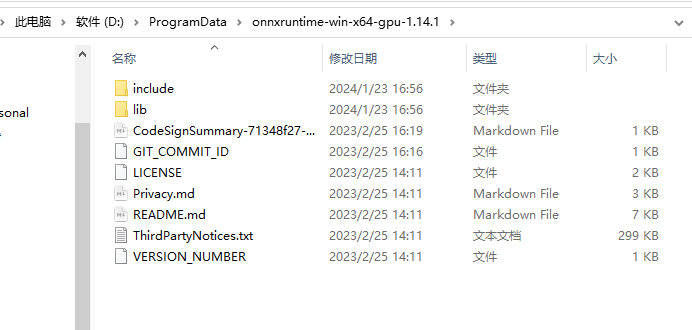

- onnxruntime 1.14.1

- libtorch 1.8.1

3. 安装

3.1 安装cmake

CMake下载链接:https://cmake.org/download/。

3.1.1 下载最新稳定版即可(Latest Release):

3.1.2 下载完成后,单击“Next”按钮,在下图中勾选“I accept the terms in the License Agreement”复选框接受许可协议:

3.1.3 选中“Add CMake to the system PATH for all users”单选按钮添加系统路径变量。也可以同时勾选“CreateCMakeDesktopIcon”复选框,以便在安装完成后在桌面上创建CMake的快捷方式图标。

点击Install进行安装。

3.2 安装opencv

地址:https://github.com/opencv/opencv/releases/download/4.9.0/opencv-4.9.0-windows.exe

3.2.1 安装到指定目录并添加系统环境变量

3.3 安装onnxruntime

3.3.1 解压到指定目录并添加系统环境变量

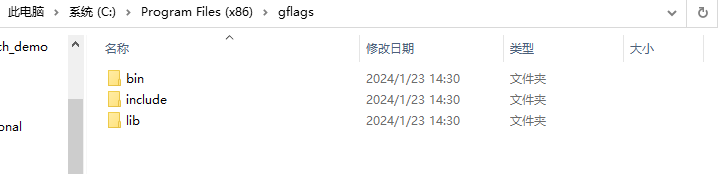

3.4 安装gflags

地址:https://github.com/gflags/gflags

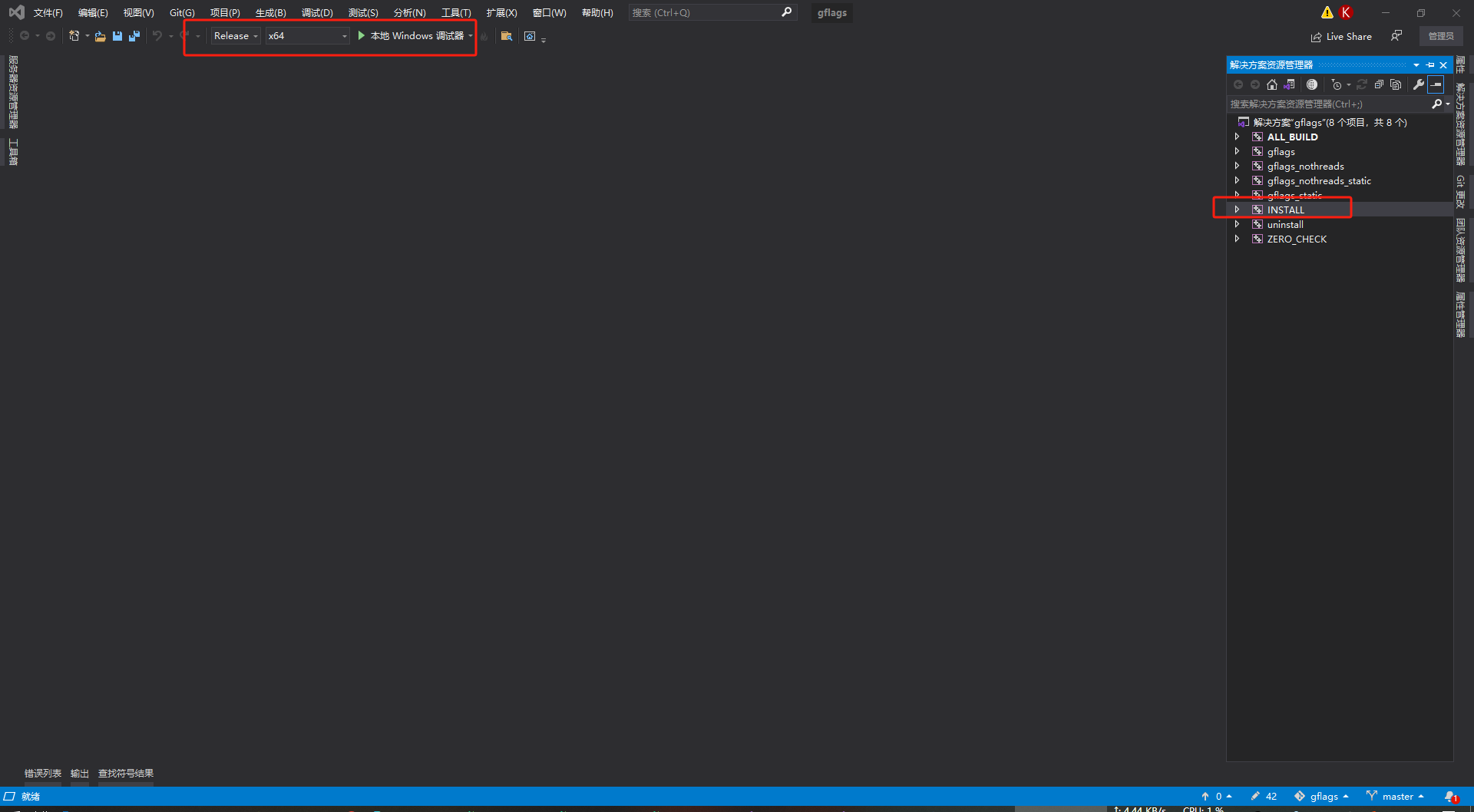

3.4.1 下载以后用cmake编译

3.4.2 点进Open Project,选择Release,右边解决方案INSTALL右键,生成

3.4.3 加入系统环境变量

3.5 安装libtorch

地址:https://download.pytorch.org/libtorch/cu111/libtorch-win-shared-with-deps-1.8.1%2Bcu111.zip

3.5.1 解压到指定目录并添加系统环境变量

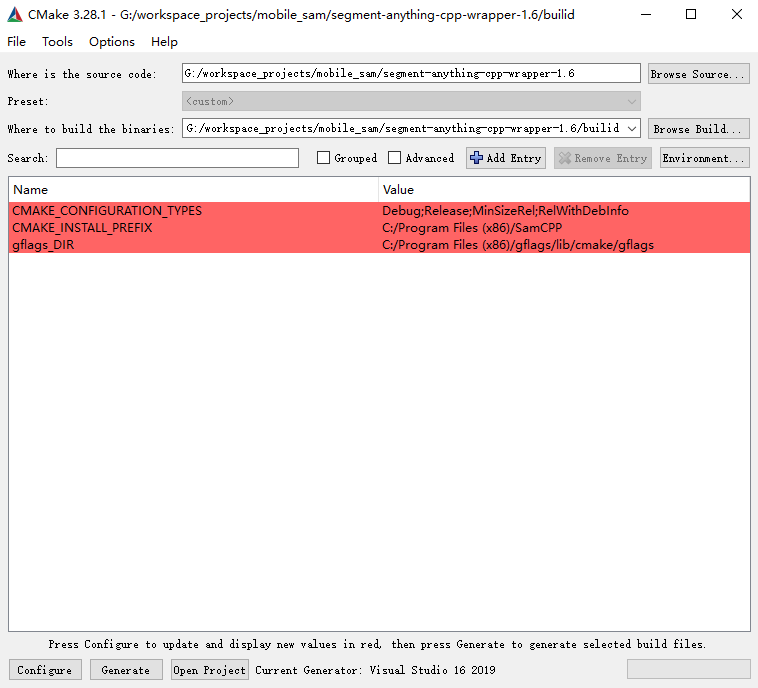

4. 基于onnxruntime部署编译

4.1 新建build文件夹,用来存放项目编译结果,并用cmake打开预编译

4.2 vs打开编写属性页

4.3 编译

4.4 运行exe文件验证

5. 基于libtorch部署编译

5.1 cmake预编译

5.2 vs打开编写属性页

asmjit.lib

c10.lib

c10d.lib

c10_cuda.lib

caffe2_detectron_ops_gpu.lib

caffe2_module_test_dynamic.lib

caffe2_nvrtc.lib

clog.lib

cpuinfo.lib

dnnl.lib

fbgemm.lib

fbjni.lib

gloo.lib

gloo_cuda.lib

libprotobuf-lite.lib

libprotobuf.lib

libprotoc.lib

mkldnn.lib

pthreadpool.lib

pytorch_jni.lib

torch.lib

torch_cpu.lib

torch_cuda.lib

torch_cuda_cpp.lib

torch_cuda_cu.lib

XNNPACK.lib

5.3 编译运行

2128

2128

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?