1. 概览

ELECTRA(“Efficiently Learning an Encoder that Classifies Token Replacements Accurately”),来源于2020年论文《ELECTRA: PRE-TRAINING TEXT ENCODERS AS DISCRIMINATORS RATHER THAN GENERATORS》,介绍了一种新型预训练文本编码器方法,该方法与传统的基于生成器的预训练方法(如BERT)不同,它采用了一种判别器的视角来进行预训练。ELECTRA 的核心思想是通过替换输入中的某些标记(tokens),而不是将它们掩盖起来,然后训练一个判别模型来预测每个标记是否被替换了。这种方法被称为“替换标记检测”(replaced token detection)。

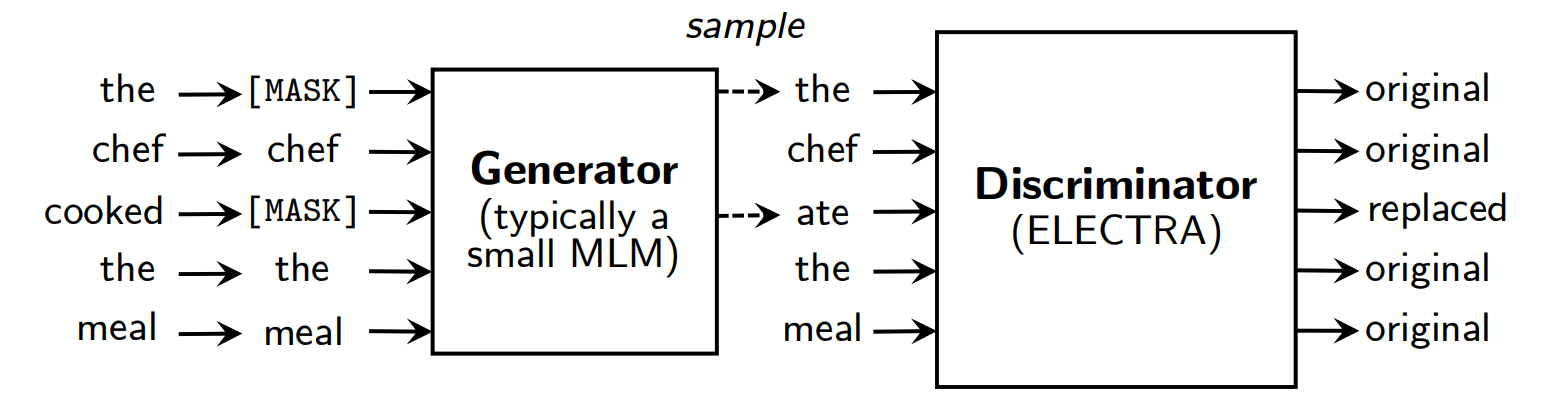

ELECTRA 模型由两个主要部分组成:一个小型的生成器网络和一个判别器网络。生成器负责生成可能的替换标记,而判别器则负责区分原始标记和生成器生成的替换标记。

论文:https://openreview.net/pdf?id=r1xMH1BtvB

BERT 详细介绍看这里:

《NLP深入学习:结合源码详解 BERT 模型(一)》

《NLP深入学习:结合源码详解 BERT 模型(二)》

《NLP深入学习:结合源码详解 BERT 模型(三)》

2. 改进点

ELECTRA 相较于传统的 BERT 模型,在多个方面进行了改进,使其在预训练效率和下游任务表现上都有所提升:

2.1 更高效的预训练任务

ELECTRA 通过替换标记而不是掩盖标记来进行预训练,这使得模型可以从所有输入标记中学习,而不仅仅是被掩盖的那一小部分,从而提高了预训练的效率。

2.2 判别器与生成器的结合

与 BERT 的生成器任务不同,ELECTRA 使用了一个判别器来区分真实的输入标记和生成器生成的假标记。这种判别器任务在计算上更高效,因为它涉及到所有输入标记。

ELECTRA模型中生成器(Generator)和判别器(Discriminator)的结合对模型性能有以下几个主要影响:

-

提高预训练效率:

生成器负责生成可能的替换标记,而判别器则负责区分这些替换标记和原始标记。这种设置使得判别器在预训练过程中可以学习到所有输入标记的上下文表示,而不仅仅是被掩盖或被替换的标记。这大大提高了预训练的效率,因为模型能够从更多的标记中学习。 -

增强模型的泛化能力:

判别器通过区分真实标记和生成器生成的假标记,学习到更加鲁棒的特征表示。这种对抗性的训练方式有助于模型在面对噪声和异常数据时保持稳定的性能。

2.3 更小的模型尺寸和更快的训练速度

文章中提到,即使是较小的 ELECTRA 模型(如 ELECTRA-Small),也能在单个 GPU 上快速训练,并且在 GLUE 基准测试中取得了比 BERT 更好的结果。

ELECTRA 在计算效率上也有所提升,它可以在使用更少的计算资源的情况下,达到与 RoBERTa 和 XLNet 相当的性能。

3. 更优表现

ELECTRA模型相比传统的BERT模型,在以下几个方面表现更优:

-

预训练效率:

ELECTRA通过“替换标记检测”任务,使得判别器可以从所有输入标记中学习,而不仅仅是被掩盖的那一小部分。这使得ELECTRA在预训练阶段更加高效,能够更快地学习到有用的上下文表示。 -

计算资源利用率:

由于ELECTRA的预训练任务更加高效,它可以在使用更少的计算资源(如GPU时间)的情况下达到与BERT相当或更好的性能。这对于资源受限的环境非常有利。 -

模型尺寸和训练时间:

实验表明,即使是较小的ELECTRA模型(如ELECTRA-Small),也能在单个GPU上快速训练,并且在GLUE基准测试中取得了比BERT更好的结果。这表明ELECTRA在模型尺寸和训练时间上具有优势。 -

下游任务表现:

在各种下游自然语言处理任务上,ELECTRA取得了优异的性能,这得益于其在预训练阶段通过判别器学习到的高质量上下文表示。这些表示能够更好地捕捉语言的细微差别,从而在诸如文本分类、问答和自然语言推理等任务中表现出色。 -

泛化能力:

由于ELECTRA的预训练任务涉及区分真实标记和生成器生成的假标记,这种对抗性的训练方式有助于模型在面对噪声和异常数据时保持稳定的性能,从而提高了模型的泛化能力。 -

灵活性和扩展性:

ELECTRA模型的设计允许对生成器和判别器进行不同的配置和扩展,例如通过权重共享、使用不同大小的生成器等。这种灵活性使得研究人员可以根据具体任务的需求调整模型,以达到最佳的性能和效率平衡。

参考

[1] https://openreview.net/pdf?id=r1xMH1BtvB

欢迎关注本人,我是喜欢搞事的程序猿; 一起进步,一起学习;

欢迎关注知乎/CSDN:SmallerFL

也欢迎关注我的wx公众号(精选高质量文章):一个比特定乾坤

1069

1069

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?