一、研究背景

1.真实视频和伪造视频的面部动作规律不同,二者的时序信息不一致性可以作为识别深度伪造的有效线索。

2.现有的方法倾向于施加二分类监督,限制了模型只能关注类别层面的差异。

3.存在只有某一部分被篡改的视频。

4.现有伪造手段比较成熟,在单张图片上难以找到伪造痕迹。

二、研究动机

时间不一致性揭示了真实视频和伪造视频之间不一致的面部动作,因此应该通过比较来挖掘。

三、研究目标

1.进行局部和全局对比。

2.为时间不一致性对比学习提取更精细的局部和全局表示。

四、技术路线

提出层次对比不一致学习框架与两级对比范式(HCIL)。

- 构建加权NCE损失,从局部和全局的角度执行对比学习,以捕捉真实和虚假视频之间更一般和内在的时间不一致性。

- 结合区域自适应模块和片段间融合模块,分别进行片段内不一致挖掘和进行跨片段信息融合,进一步促进了不一致性学习。

1.Local Contrastive Inconsistency Learning

- Region-Aware Inconsistency Module:基于不同的面部区域挖掘丰富的片段级时间不一致特征

左侧支路:使用自适应平局池化(AdaP),为每个区域习得相应的时间卷积核

右侧支路:使用像素级运动(PWM),基于运动信息,自适应地划分面部区域,并生成one-hot向量选择卷积核,相同one-hot向量看作是相同面部区域。

- Local (Snippet-Level) Contrast:构建加权NCE损失,计算归一化相似性调节伪造片段的影响(

β

\beta

β)

2.Global Contrastive Inconsistency Learning

- inter-snippet fusion :做自注意力使不同片段S两两相乘,即融合

V = [ S 1 , . . . , S U ] V=[S_1,...,S_U] V=[S1,...,SU]

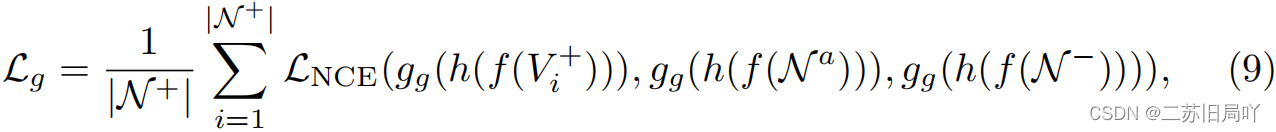

- Global (Video-Level) Contrast:构建NCE损失(片段、视频、视频)

3.损失函数

![]()

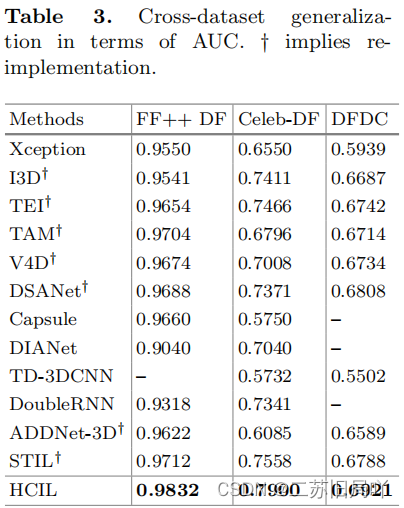

五、实验结果

1207

1207

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?