【AAAI2023】Ultra-High-Definition Low-Light Image Enhancement: A Benchmark and Transformer-Based Method

第一个创新点:相较于之前Restormer把注意力计算的复杂度从O(HW*HW)(像素维度,逐像素计算)降到了通道维度的O(C*C)(只计算通道维度的相似性),降低了注意力计算的复杂度。

第二个创新点:在Restormer中,FFN有两个分支,其中有一个分支上使用GELU激活对另一个分支添加门控。在这个论文中,作者给两个分支都使用 GELU 激活,然后互相给另外一个分支添加门控,这样就进一步增强了FFN的非线性建模能力。

第三个创新点:layer attention,层与层之间的注意力计算。

【NeurIPS2022】ShuffleMixer: An Efficient ConvNet for Image Super-Resolution

论文主要创新点:主要是通过一个通道split成两个通道和再进行两个组的shuffle来执行特征融合操作。

【ARXIV2212】A Close Look at Spatial Modeling: From Attention to Convolution

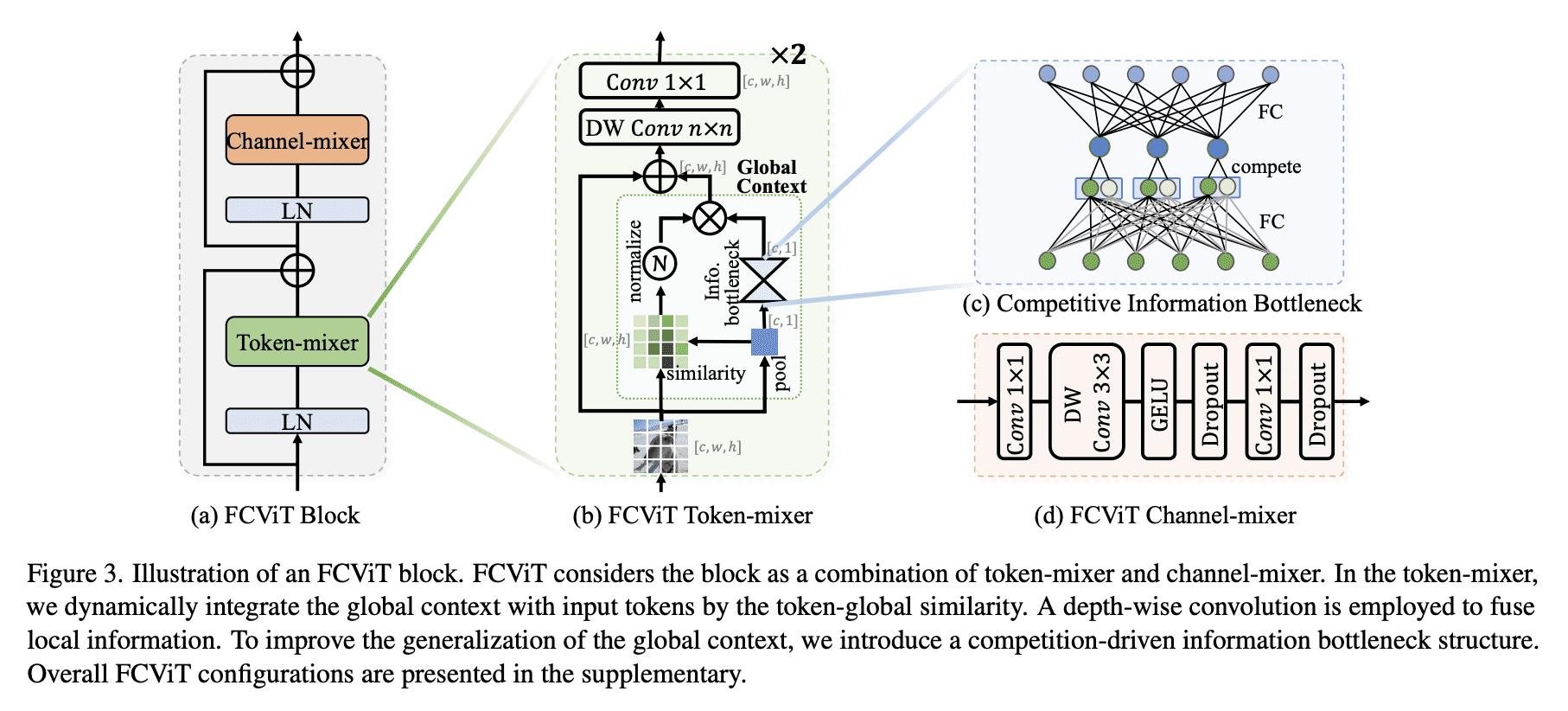

主要创新点:主要变化是注意力的计算,从Q*K 的注意力计算方法变为计算CHW特征矩阵和pooling后的矩阵相乘,得到注意力矩阵。

【ARXIV2301】DEA-Net: Single image dehazing based on detail-enhanced convolution and content-guided attention

主要创新点是通过本质为CBAM和 channel shuffle 的结合所形成的新模块CGA。

【ARXIV2212】DAE-Former: Dual Attention-guided Efficient Transformer for Medical Image Segmentation

主要创新点:以往的注意力计算是Q*K(n*n的复杂度),进行归一化的操作后再与V相乘(复杂度n*dv),这篇文章里是先进行Q和V的归一化操作,然后将K与V相乘(复杂度dk*dv),这个操作比之前的n*n的复杂度要小很多,然后再与先前就归一化的Q相乘,综合降低了计算复杂度。

314

314

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?