Semantic Graphs for Generating Deep Questions

任务

本文提出了深度问题生成(DQG)的问题,其目的是生成需要对输入段落的多个信息进行推理的复杂问题。

方法(模型)

为了捕捉文件的全局结构并促进推理,本文提出了一个新的框架,首先为输入的文件构建一个语义层面的图,然后通过引入一个基于注意力的GGNN(Att-GGNN)对语义图进行编码。之后,融合文档层面和图层面的表示,对内容选择和问题解码进行联合训练。

问题定义:

Q

‾

=

a

r

g

m

Q

a

x

P

(

Q

∣

D

,

A

)

\overline{Q} = arg\ \underset{Q}max P(Q|D, A)

Q=arg QmaxP(Q∣D,A)

Q ‾ \overline{Q} Q:生成的问题

D:文档

A:答案

模型结构:

三个模块:

-

semantic graph construction

为输入构建DP(Dependency Parsing) or SRL-based semantic graph。

-

semantic-enriched document representation

使用 Attention-enhanced Gated Graph Neural Network (Att-GGNN)学习语义图表示。

-

joint-task question generation

通过节点级内容选择和单词级问题解码的联合训练来生成深度问题。

Semantic Graph Construction

实体之间的语义关系是决定询问什么以及它所包括的推理类型的有力线索。为了提炼出文档中的这种语义信息,本文使用基于SRL(语义角色标签)和DP-(依赖分析)的方法来构建语义图。

Semantic-Enriched Document Representations

本文分别通过基于RNN的段落编码器和新颖的Att-GGN图编码器对文档D和语义图G进行编码,然后将其融合,得到用于问题生成的语义丰富的文档表示。

使用 bi-directional Gated Recurrent Unit (GRU)编码上下文。

采用一种新的AttGGNN,通过聚合来自其邻居的信息来更新节点表征。

数据集

HotpotQA

性能水平&结论

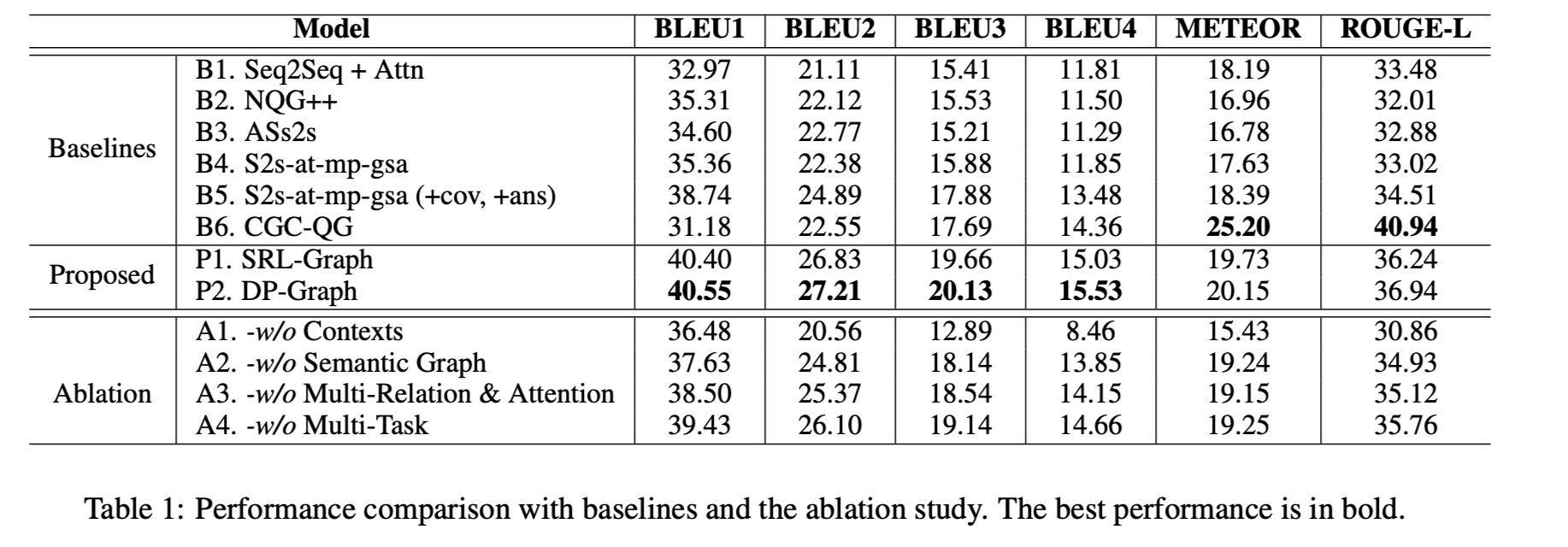

本文提出的模型P1和P2在BLEU评测上都表现出了最优的效果。

与采用门控自注意机制并使用与本文相同的解码器的B5模型相比,本文带有基于DP的语义图的模型(P2)在BLEU-4中性能提升显著。这表明了semantic-enriched文档表示的显著效果。

结论:

本文提出的框架结合了语义图来增强输入文件的表征,并通过与内容选择任务的联合训练来生成问题。在HotpotQA数据集上的实验表明,引入语义图大大减少了语义错误,而内容选择有利于对不相干的相关内容进行选择和推理,问题的质量提高显著提高。

465

465

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?