目录

聚类介绍

k-means属于非监督学习算法:只有特征值,没有目标值

k-means的原理

距离的计算可以用欧式距离

最小化损失函数:

k-means API

sklearn.cluster.KMeans

n_clusters:表示分类的个数,多少个类别

k-means对Instacart Market用户聚类

1、降维之后的数据

2、k-means聚类

3、聚类结果显示

案例介绍

数据链接:Instacart Market Basket Analysis | Kaggle

步骤一:

代码

聚类评估标准

轮廓系数的范围:[-1, 1]

一般情况下,当轮廓系数超过0.1(或者0)时,聚类效果就已经很好了。

一般轮廓系数很难超过0.7。

Kmeans性能评估指标API

sklearn.metrics.silhouette_score

Kmean总结

特点分析:

采用迭代式算法(一步步更新中心点),直观易懂并且非常实用。

优点:

- 容易理解,聚类效果不错,虽然是局部最优, 但往往局部最优就够了;

- 处理大数据集的时候,该算法可以保证较好的伸缩性;

- 当簇近似高斯分布的时候,效果非常不错;

- 算法复杂度低。

缺点

- K 值需要人为设定,不同 K 值得到的结果不一样;

- 对初始的簇中心敏感,不同选取方式会得到不同结果;

- 对异常值敏感;

- 样本只能归为一类,不适合多分类任务;

- 不适合太离散的分类、样本类别不平衡的分类、非凸形状的分类。

- 容易收敛到局部最优解,但算法内部通过多次聚类可尽量解决这个问题。

注意:聚类一般做在分类之前

算法调优与改进

针对 K-means 算法的缺点,我们可以有很多种调优方式:如数据预处理(去除异常点),合理选择 K 值,高维映射等。

数据预处理

K-means 的本质是基于欧式距离的数据划分算法,均值和方差大的维度将对数据的聚类产生决定性影响。所以未做归一化处理和统一单位的数据是无法直接参与运算和比较的。常见的数据预处理方式有:数据归一化,数据标准化。

此外,离群点或者噪声数据会对均值产生较大的影响,导致中心偏移,因此我们还需要对数据进行异常点检测。

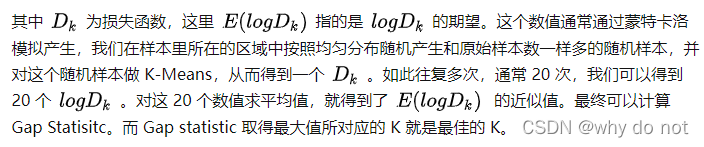

合理选择 K 值

K 值的选取对 K-means 影响很大,这也是 K-means 最大的缺点,常见的选取 K 值的方法有:手肘法、Gap statistic 方法。

手肘法:

(横轴为聚类数量k,纵轴为损失cost)

比如,当 K < 3 时,曲线急速下降;当 K > 3 时,曲线趋于平稳,通过手肘法我们认为拐点 3 为 K 的最佳值。

手肘法的缺点在于需要人工看不够自动化,所以我们又有了 Gap statistic 方法,这个方法出自斯坦福大学的几个学者的论文:Estimating the number of clusters in a data set via the gap statistic

由图可见,当 K=3 时,Gap(K) 取值最大,所以最佳的簇数是 K=3。

Github 上一个项目叫 gap_statistic ,可以更方便的获取建议的类簇个数。

采用核函数

基于欧式距离的 K-means 假设了了各个数据簇的数据具有一样的的先验概率并呈现球形分布,但这种分布在实际生活中并不常见。面对非凸的数据分布形状时我们可以引入核函数来优化,这时算法又称为核 K-means 算法,是核聚类方法的一种。核聚类方法的主要思想是通过一个非线性映射,将输入空间中的数据点映射到高位的特征空间中,并在新的特征空间中进行聚类。非线性映射增加了数据点线性可分的概率,从而在经典的聚类算法失效的情况下,通过引入核函数可以达到更为准确的聚类结果。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?