Off-policy方法——将收集数据当做一个单独的任务

off-policy的方法将收集数据作为RL算法中单独的一个任务,它准备两个策略:行为策略(behavior policy)与目标策略(target policy)。行为策略是专门负责学习数据的获取,具有一定的随机性,总是有一定的概率选出潜在的最优动作。而目标策略借助行为策略收集到的样本以及策略提升方法提升自身性能,并最终成为最优策略。Off-policy是一种灵活的方式,如果能找到一个“聪明的”行为策略,总是能为算法提供最合适的样本,那么算法的效率将会得到提升。

On-policy——行为策略与目标策略相同

on-policy里面只有一种策略,它既为目标策略又为行为策略。SARSA算法即为典型的on-policy的算法。

需要注意的问题:

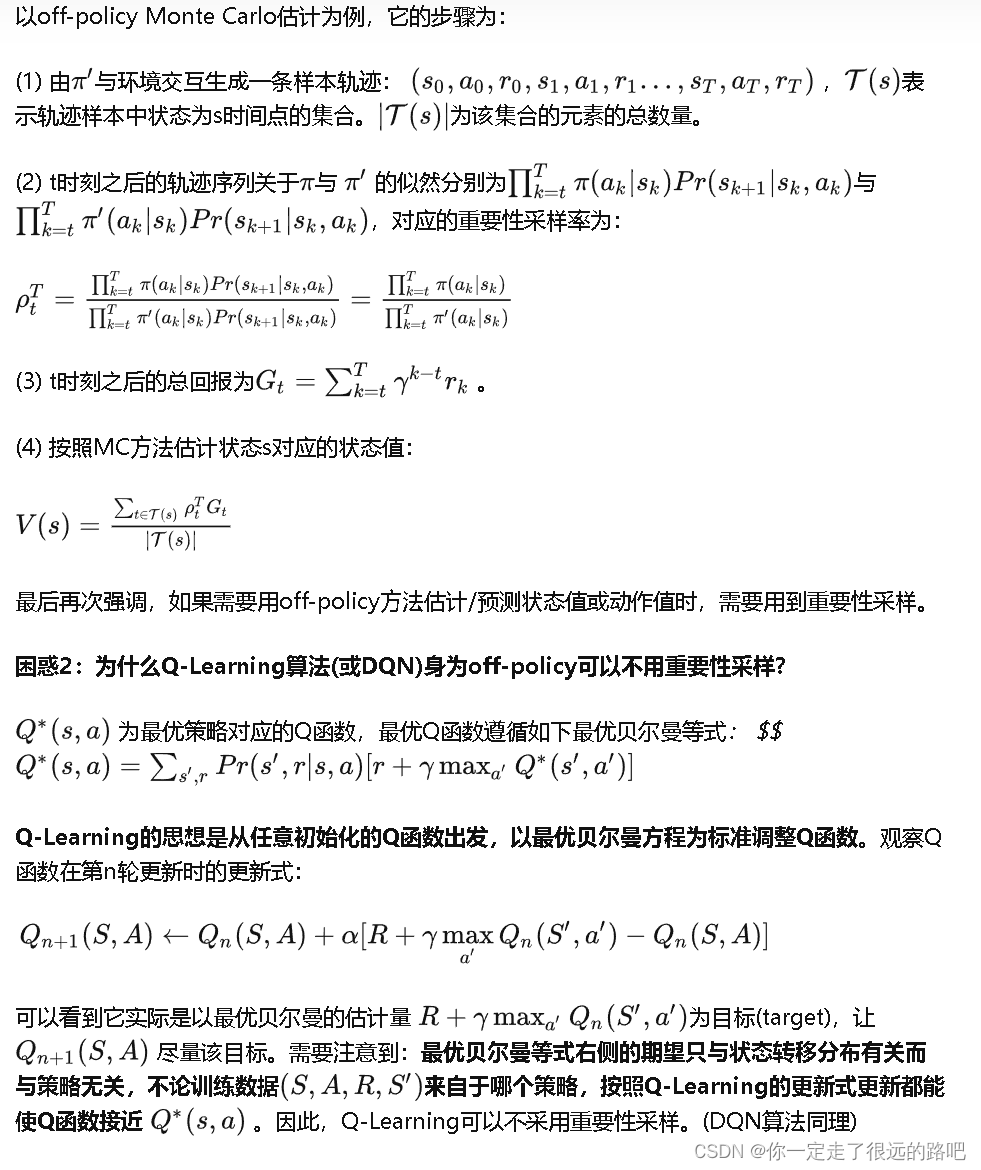

1.为什么有时候off-policy需要与重要性采样配合使用?

重要性采样是用一个概率分布的样本来估计某个随机变量关于另一个概率分布的期望。

假设已知随机策略π(a|s),现在需要估计策略对应的状态值Vπ,但是只能用另一个策略π'(a|s)获取样本。对于这种需要用另外一个策略的数据(off-policy)来精确估计状态值的任务,需要用到重要性采样的方法,具体做法是在对应的样本估计量上乘上一个权重(π与π'的相对概率),称为重要性采样率。

参考链接:

强化学习中的奇怪概念(一)——On-policy与off-policy

593

593

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?