On the Opportunities and Risks of Foundation Models- TECHNOLOGY

目录

TECHNOLOGY

Data

基础模型标志着一种范式转变,越来越多的数据被“输入”给这些模型以提高适应性能[Devlin等人2019;雷德福等人2021;托尔斯蒂金等人2021],总体经验法则是“数据越多越好”[卡普兰等人2020]。正如前面提到的,对数据管理的关注引发了对基础模型数据生命周期的关注,包括(1)大规模管理数据(1:介绍);(2)跨新模式集成数据(2.3:机器人技术,3.31:医疗保健);(3)推理许可和治理法规——尤其是考虑到基础模型培训中使用的大量Web爬行—(3.1:医疗保健,5.4:合法性),以及(4)理解数据质量(4.4:评估)。

虽然基础模型为这些挑战增加了新的和困难的方面,但我们看到了这些问题和诸如数据管理和数据分析以及工业ML管道等社区中的核心挑战之间的相似之处。例如,数据管理长期以来一直在研究用于数据分析、版本控制、来源和集成的可扩展声明性系统——解决挑战(1)和(2) [Zaharia等人2012年;库尔-毛鲁等人2009年;石博和威斯伯格2013年;石博和伊利亚斯2018年;赫勒斯坦和石博2005年]。行业有应对挑战(3)的管道来管理不同的数据许可证,并帮助减少数据违规。有一个完整的研究和系统应对挑战(4)支持交互式数据分析和可视化[Hohman等人2020]。64虽然这些解决方案不一定是“基础模型准备”,但我们认为更好地管理基础模型数据生命周期的路径应该从这些现有系统中获得灵感。

在本节中,我们将介绍基础模型数据生命周期的管理。我们首先概述了四种需求,包括大规模的数据管理、对异构数据源的支持、数据治理和数据质量监控。然后,我们设想如何将所有这些需求集成到一个称为数据中心的整体数据管理解决方案中。数据中心只是一个数据管理工具包,可以被私营部门或公共部门使用,以更好地支持基础模型数据生命周期的交互式管理。

Data Management Desiderata.

基础模型开发的当前实践通常是贯穿整个生命周期的,从数据管理和数据文档到模型监控和补丁[Gebru等人,2018年;班迪和文森特,2021年;本德和弗里德曼,2018年]。数据管理领域的研究表明,定义良好的数据管理平台通过数据摄取、数据版本控制、数据来源、高效分析和模型监控促进大规模的ML模型开发[赫勒斯坦和石制2005;阿格拉瓦等人2019;Vartak等人2016;池田和威德2010]。65从数据管理领域的灵感,我们在为基础模型构建整体数据管理平台时考虑核心需求。

(1)可扩展性。基础模型正在越来越多的数据上进行训练[Kaplan等人,2020],而WuDao 2.0模型则在4.9 TB的多模态数据上进行训练。随着最近的模型主要是在面向公共环境的数据集上进行训练,这一规模预计将会增加。与每天收集的用于工业基础模型管道的商业和个人数据相比,公共数据只占数据的极小一部分[Marr 2017]。因此,人们越来越需要能够处理多模态基础模型数据集的高度可伸缩的技术。

(2)数据集成。最近使用基础模型的工作表明,利用集成的结构化和非结构化数据可以帮助模型更好地概括罕见概念[奥尔等人2020年],并改善事实知识回忆[奥尔等人2020年;洛格斯瓦兰等人2019年;张等人2019年a;彼得斯等人2019年;波尔纳等人2020年]。尽管最近取得了这些成功,但为基础模型集成数据集仍然是一个挑战。许多工作使用带有结构化实体知识或图像数据的非结构化文本数据[Antol等人,2015]。人们越来越需要整合不同模式的数据集,如文本、视频、眼球追踪[霍伦斯坦等人,2020]和机器人模拟[Lynch和Sermanet,2021](见2.3:机器人技术)。我们需要的数据集成解决方案,可以在工业规模上应用于多种模式和多个领域,如政府、商业和科学。

(3)隐私和治理控制。用于基础模型的训练数据可能有侵犯数据主体隐私的风险;他们的数据可能在未经他们同意的情况下被披露、收集或使用[Jo和Gebru 2020]或在最初获得同意的背景之外。同意和使用的问题对于不能总是预期下游应用的基础模型特别相关。正如在5.4:合法性中所解释的,这些问题与基础模型训练的网络收集数据集的流行相结合。由于网络爬行数据将如何被管理和受版权保护仍存在公开的法律问题,67对于公共和私营部门的基础模型提供商来说,使用网络数据的后果仍然不清楚。我们需要工具来帮助基础模型提供商适应新出现的法规和指导方针,以确保安全和负责任的数据管理。

(4)了解数据质量。数据质量影响模型性能[Lee et al. 2021b];然而,能够系统和可扩展地理解训练数据和相关数据子集的工具包或方法仍处于起步阶段。数据创建过程可能很混乱,数据可能包含不同类型的偏差[布洛杰特等2020;本德等2021](见5.1:公平性),包括中毒、虚假或重复信息[Chang等2020;卡里尼和特齐斯2021;布坎南等2021;李等2021b]。数据也在不断更新和细化[Kiela等人2021年],可能存在突发实体[Fetahu等人2015年]、分布转移[Chen等人2021年a]和概念意义转移[Kenter等人2015年;拉扎里杜等人2021年]。此外,一旦部署,基础模型可能会对基础模型提供者需要检测和减轻的关键、细粒度的数据子群呈现不良行为[Goel等人2021年;Hohman等人2018年;雷等人2019年;奥克登-雷纳等人2019年]。我们需要能够检测并潜在地减轻不同类型的不良数据的工具包,以以交互和迭代的方式提高模型性能。这类工具包还需要适应训练数据的动态特性。

Data Hub Solution.

利用数据管理、数据科学和数据分析等方面多年的工作,我们设想了一个基础模型生命周期数据管理解决方案,我们称之为数据中心。虽然ml数据中心68以及更传统的数据管理系统存在,69他们(1)不将数据集成作为第一类原始,(2)本地不支持端到端生命周期与模型预测,或(3)不允许交互驱动的数据管理和细化,基础模型提供商可以动态探索和更新可能的数据集访问控制指南。现在我们将讨论数据中心如何解决这四个需求。

数据规模。为了解决大规模管理的挑战,数据中心将需要标准的数据管理解决方案[Armbrust et al. 2009],例如存储和维护大规模数据集的基础设施,以及可扩展的接口来查询、选择和过滤数据集。集线器应该支持异构计算和云基础设施,以支持不同环境中的可伸缩解决方案。

数据集成。该中心应该将数据集成作为一个一流的公民。它将需要先进的数据集成解决方案[石博克和伊利亚斯2018;阿比特布尔1997;董等人2020;雷卡西纳斯等人2017a] 70,允许跨模式和领域合并结构化和非结构化知识。此外,这还意味着该中心将需要支持在异构数据集和源上的存储和查询。

访问控制。考虑到中心的访问控制,中心将需要支持不同的文档,例如,数据集表[Gebru et al. 2018]或数据语句[本德和弗里德曼2018],以允许数据管理员反思他们的过程和透明的预期用例、潜在的偏见和数据集的限制。数据中心将需要决定上传数据需要哪些文档(例如,数据源和数据描述),以及推荐哪些信息(例如,数据可以用于哪些任务)。此外,随着数据集的发展,文档可能需要进行更新[Goel等人,2021]。

数据源通常与许可证相关联,中心需要集成具有不同法律问题和条件的不同来源[Masur2018]。71此外,某些数据集有法律准则来保护数据主体的隐私。该中心将需要一些方法来确保数据集不会发布个人可识别信息(PII),72,匿名或去识别数据的聚合不会发布PII,73,以及数据受试者已给予传播其数据的知情同意。

根据数据集成的想法[雷卡西纳斯等人,2017b],该中心应该支持实现高效和安全的维护和数据资源共享的机制。特别是当某些公共数据集(例如,web转储)的合法性仍在决定之中(5.4:合法性)时,该中心迫切需要工具来帮助识别许可违反,并减轻任何治理违反的影响。由于某些违规可能与模型行为相关,我们需要系统支持更好地理解模型行为,正如我们接下来描述的。

数据质量工具。利用数据分析和探索领域,随着用户交互式地选择、过滤和细化用于培训或适应的数据,该中心将需要工具来快速理解用户当前的数据集及其对模型行为的影响[Hohman等人,2020]。

此外,这些系统可以通过最近对切片(亚种群)的发现[Chung等人2019]、相关子集的模型验证[Goel等人2021;Ribeiro等人2020],以及数据评估[Ghorbani和Zou 2019]的模型性能,实现端到端基础模型监测。最近的工作还提出了使用模型来检测数据的哪些子群对给定输出贡献最大的方法,以进一步帮助模型调试。

一旦用户能够监控模型行为——特别是在罕见的、但关键的子种群上——该中心应该为用户提供方法和指导,通过纠正模型错误来维护模型。尽管“模型修补”[Goel等人2020a]仍然是一个开放的问题,但[Orr等人2020]的工作首次提供了使用数据工程维护生产自我监督系统的描述,该系统通过更改数据而不是模型来纠正不良行为。我们认为数据中心需要支持用户注入有针对性的数据修改来进行模型维护。

我们还承认,数据管理和探索并不是孤立地执行的,并相信数据中心应该支持一个围绕共享有用的度量标准和分析管道的社区。受类似的社区共享平台的启发,如拥抱Face的ModelHub76或“公共平台的可视化共享平台77,我们希望用户分享关于基础模型训练数据的见解。

开放的问题。尽管我们所描述的数据中心是受到了现有工具包和解决方案的启发,但我们认为它们还没有完全准备好迎接基础模型的挑战。特别是,围绕设计数据中心的一些开放问题是:

- 我们应该如何支持数据版本控制,以便更新数据集,同时维护旧版本以实现再现性[Agrawal等人,2019年]?一旦部署了模型并识别了错误桶,可能需要更新数据集,以包含来自这些错误桶的更多示例。应该如何收集这些新的、有针对性的例子呢?

- 如4.2所述:训练,我们想象更少的模型将从头开始训练,更多的模型将被微调。我们如何支持来源或血统信息,以理解原始数据来自哪里,同时维护主题隐私?

- 在公共部门中,一个数据中心可以由一个由数据管理员和基金会模型提供者组成的开源个人社区来组织和运行。在此设置中,将回答诸如谁存储数据?谁为任何计算付费?如果违反了许可,谁应该承担责任?都是特别模糊的。数据中心如何提供正确的工具,以便一旦这些问题的答案得到解决,就可以轻松地操作它们?

- 什么是正确的统计数据来提供足够的文件,而不太昂贵或难以获得?

- 数据中心如何支持有针对性的数据修改,如增强或数据编程?

- 监控工具包如何更好地检测何时由于动态变化的评估数据的性能不佳而需要更新基础模型?

我们对数据中心的愿景还不完整,也还不完全详细。然而,我们提出了关于数据挑战的初步想法,以及一个关于如何改进基础模型生命周期的数据管理的提示思维的解决方案。

Security and privacy

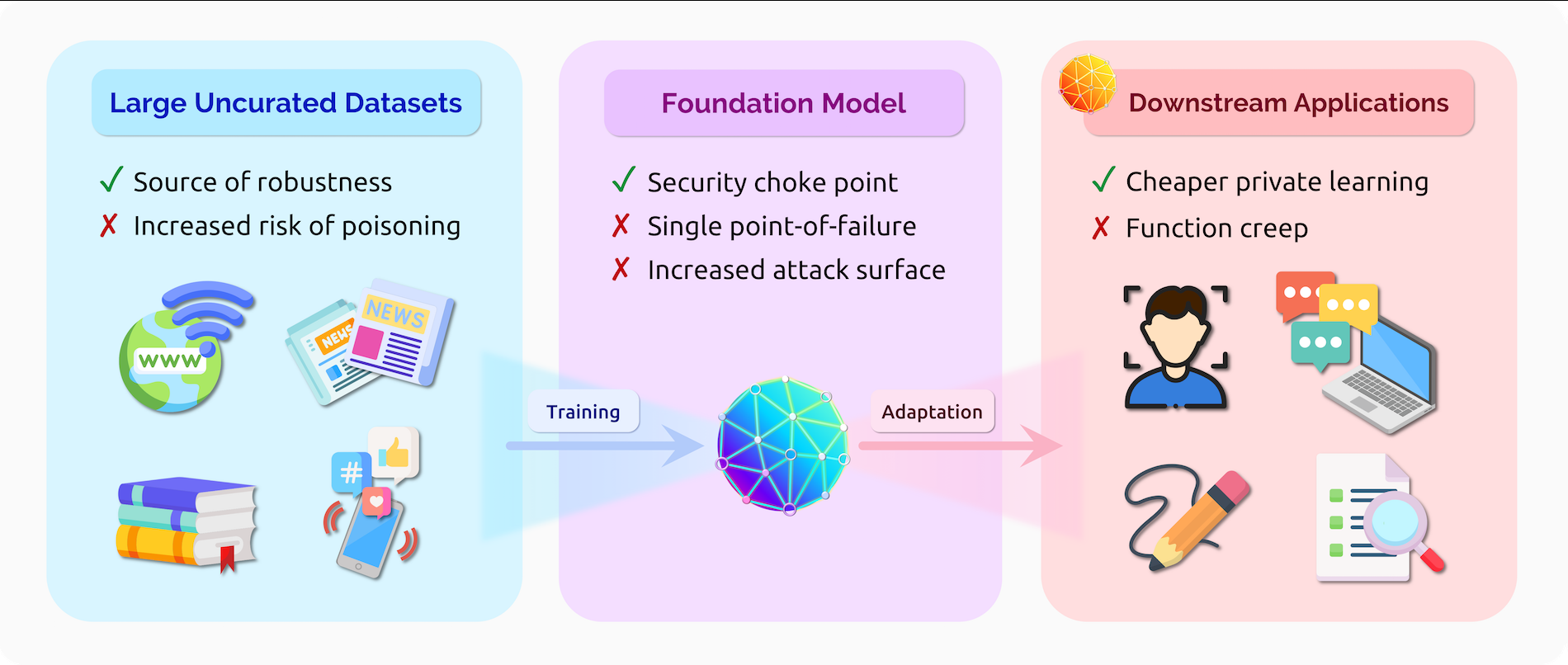

图20。为ML系统的安全和隐私性提供服务的基础模型所带来的风险和机遇。

作为关键数据驱动决策系统的核心组件,机器学习模型必须解决各种安全和隐私威胁。这些威胁可以用传统的“中央情报局三联征”来描述。ML系统应保护用户数据的机密性免受推理和重构攻击[Fredrikson等人2015;Shokri等人2017;Carrini等人2019年,2021年]。此外,训练过的模型本身的机密性可能面临模型窃取攻击的风险[Tramer等人,2016;Papernot等人,2017]。可能危害ML系统的完整性[Biggio等人2013;Szegedy等人2014]和数据中毒攻击[Biggio等人2012;Chen等人2017]。最后,资源消耗攻击[Shumailov等人,2020;Hong等人,2020a]可能会威胁到ML系统的可用性。

针对这些威胁,我们假设基础模型在未来机器学习系统中的安全角色将类似于操作系统在传统软件系统中所扮演的角色。由于基础模型的通用性和普遍性,基础模型可能成为单点故障,从而成为攻击从该模型派生的应用程序的主要目标。然而,反过来,一个具有强安全性和隐私特性的基础模型可以形成设计各种安全可靠的ML应用程序的主干。当然,这些应用程序可能仍然必须被强制执行特定的安全和隐私保证(就像软件设计者不能依赖一个安全的操作系统来保护所有的安全风险一样)。

Risks.

单点故障。适用于各种应用程序的基础模型代表了这些应用程序的单点故障。例如,对基础模型的数据中毒攻击,即对手将恶意的示例插入到训练数据中,也可能会影响所有已适应的应用程序。类似地,针对基础模型的对抗性例子(即,导致模型的小输入扰动输出非常不同的特性)可以更容易地转移到已适应的应用程序中。Wallace等人[2019]甚至发现,添加到任何输入中的单一对抗性触发器都可能导致GPT-2等语言模型输出预定义的文本片段。基础模型也可能成为数据隐私的单点故障。如果基础模型对公司的私有数据进行预训练,并且模型记忆了该数据的一部分,所有下游应用程序都可能面临暴露这些数据的风险[Carlini等人,2021]。基础模型的提供者也可以是对应用程序数据的隐私性的单个信任点。例如,GPT-3的当前API要求所有用于微调或推理的(潜在敏感的)数据都被上传到OpenAI的服务器上。设计一个可以避免这种信任集中化的基础模型服务是一个有趣的问题。

如果基础模型的参数是公开的,那么模型可以方便攻击适应的应用程序,因为攻击者只需要对公共基础模型反向“三角洲”[Krishna等人2019](例如,对从公共冻结模型中提取的特征进行训练的线性模型)。最后,对基础模型提供者的拒绝服务攻击也可能是一个问题,并可能通过使用特殊的高成本输入查询模型而加剧[Shumailov等人,2020]。

数据中毒。到目前为止,成功的基础模型都是在从网络上收集到的大型且通常未经整理的数据集上进行训练的[Radford等人,2021,2019]。这种允许的数据收集——加上缺乏直接的训练监督——促进了对基础模型的训练数据的毒害攻击(例如,将针对特定个人或公司的仇恨言论注入Reddit的几个出站页面)。更糟糕的是,今天模型的规模和准确性的增长可能会加剧中毒攻击的力量[卡里尼2021]。

为了说明这一点,舒斯特等人[2021]表明,在Github数据上使用GPT- 2训练的代码自动补全系统可以通过注入少量恶意文件而建议不安全的代码片段。卡里尼和Terzis [2021]进一步表明,针对clip风格[雷德福等人,2021]模型的定向攻击只需要修改300万个训练示例中的2个。

功能爬行和双重用途。基础模型学习使它们易于适应各种任务的一般特性。然而,这种灵活性引起了人们的担忧,即基础模型可能会超出其最初预期的用途——这种风险通常被称为功能蠕变或双重使用。机器学习中的功能蠕变的例子包括过度学习[宋和什马蒂科夫2019年]和对抗性重编程[Elsayed等人2018年]。

为了说明这一点,CLIP最初被训练来解决预测图像-文本对的一般任务,但在此过程中也学会了捕捉丰富的面部特征[Goh et al. 2021]。虽然CLIP的“模型卡”79明确地将面部识别和其他监控技术置为范围之外,但CLIP当然可以重新用于这些任务[Radiya-Dixit和Tramer 2021]。这个例子说明,在设计基础模型时,限制(甚至预见)可能的邪恶使用可能具有挑战性。5.2:误用提供了关于基础模型的双重(错误)使用的进一步讨论。

多模态不一致。多模态可以增加基础模型的攻击面,通过使对手能够利用跨模态的不一致性。这种攻击的可能性在一个著名的例子中得到了证明,CLIP将含有“iPod”一词的苹果分类为iPod [Goh等人,2021年]。更一般地说,每当一个概念可以使用不同的模式来表达时,这些模式之间的不一致可能是可以利用的。

当一个基础模型适应于一项主要依赖于其中一种学习模式的任务时,这种不一致性尤其令人担忧。例如,考虑使用从CLIP中提取的特征来进行人脸识别。这是一项纯粹的视觉任务,但适应后的模型的特征仍然对文本信号很敏感(因此,攻击者可能能够通过穿着印有印记文字的衣服来逃避面部识别)。或者,考虑一个自动驾驶系统(一个也主要依赖于视觉的应用程序),它会看到一个带有“绿色”字样的广告牌,并错误地将其解释为绿灯。

Opportunities.

安全瓶颈。如果已适应的应用程序可以从基础模型继承漏洞,那么它们也可以继承理想的安全特性——例如对对抗性示例或中毒攻击的健壮性。因此,基础模型可以作为安全瓶颈。例如,对于对抗性的例子,一个模型在适应其他任务时可以保持其鲁棒性[Shafahi等人,2019]。类似地,一个能够(以某种方式)抵御中毒、模型窃取或资源耗尽攻击的基础模型提供商随后可以为其客户的应用程序提供这样的安全保证。

基础模型作为单个故障点或作为安全瓶颈的角色之间的权衡让人想起软件堆栈中其他抽象层(例如,操作系统、数据库系统或Web浏览器)中的类似安全权衡。由于服务于许多不同的应用程序,抽象层是攻击的主要目标,但与任何单个应用程序相比,通常还可以利用更多的资源来增强其安全性。

更便宜的私人学习。当前的基础模型通常是通过收集来自公开可获得的来源(例如,来自开放的网络)的大量数据来进行训练的。这种做法可能会引起人们对隐私的担忧——即使用户数据脱离其预期的背景[尼森鲍姆,2004年;Carlini等人,2021年]。虽然一些现有的工作旨在减轻模型的倾向记忆训练数据(例如,通过消除重复训练数据[李等人. 2021b],或通过预训练差异隐私[安等et al. 2021]),这样的解决方案不太可能满足广泛的隐私期望,用户可以与文本数据[布朗et al. 2022]。另一方面,在处理稀缺和敏感数据的应用程序中(例如,在医疗保健领域)中,公共预培训最终也可能成为用户隐私的一个胜利。

例如,考虑为医疗保健任务培训差异私有模型的问题[Dwork et al. 2006]。目前,培训这种模型“端到端”(即不利用任何预培训)以实现体面的隐私效用权衡,需要大量的隐私敏感数据[McMahan等人2018;Basu等人2021]。相比之下,在许多情况下,对公共数据进行预先训练的基础模型可以用于执行机密数据明显较少的特定任务。

对大规模的对抗性例子的鲁棒性。有证据表明,与标准训练相比,训练一个对对抗性例子稳健的模型需要更多的数据[施密特等人2018],但未标记的数据可能足以弥补这一差距[Carmon等人2019;Uesato等人2019]。此外,增加模型规模和容量(即过度参数化)也被证明是在某些情况下实现对抗性的必要条件[Madry等人2018;Bubeck和Sellke 2021]。了解如何最好地利用过度参数化和未标记的数据来实现对抗性的鲁棒性是未来研究的一个重要方向。鉴于其前所未有的规模(无论在模型大小和训练集大小方面),基础模型处于独特的位置,可以从这一研究方向中受益。

尽管其规模前所未有,但不幸的是,目前的基础模型对最坏情况下的对抗性扰动的鲁棒性几乎没有提高[2021堡;Wallace等人,2019年]。然而,像CLIP这样的多模态模型对于(非对抗性的)分布变化具有惊人的鲁棒性(见4.8:鲁棒性)。这些在分布鲁棒性方面的收益是否可以转化为增强对抗现实世界攻击的弹性,这是另一个令人兴奋的开放性问题。

特别是在对手受到各种约束(例如,有限的查询访问或计算预算)的情况下,有理由乐观地认为,增强的分布鲁壮性可能会导致总体安全性的伴随收益——即使基础模型仍然容易受到最坏的“白盒”攻击。

Robustness to distribution shifts

现实世界的ML系统需要对分布变化具有鲁棒性——它们应该在不同于列车分布的测试分布上工作良好。资源不足国家的贫困地图[谢等2016年;让等2016年]、自动驾驶汽车[Yu等2020a;Sun等2020a]和医疗诊断[AlBadawy等2018年;Dai和Gool2018年]都需要模型来概括培训数据中看不到的情况,例如,不同国家、不同驾驶条件下或不同医院的测试实例。先前的工作表明,即使在最先进的模型中,这些类型的分布变化也会导致性能的大幅下降。

在本节中,我们将考虑基础模型在对分布转移的稳健性方面的作用。基础模型是在从分布𝑝pre采样的大而多样的未标记数据集上训练的,可以适应许多下游任务。对于每个下游任务T,基础模型适用于从分布内(ID)训练分布 p I D T p^T_{ID} pIDT中采样的标记训练数据,然后在分布外(OOD)测试分布 p O O D T p^T_{OOD} pOODT上进行评估。例如,贫困预测模型[Xie等人2016;Jean等人2016]可以对来自世界各地的未标记卫星数据进行预训练,以学习所有国家的有用特征,然后对来自尼日利亚的标记样本进行微调,最后在标记样本稀缺的马拉维进行评估。

我们认为,1)基础模型是一种特别有前途的鲁棒性方法。现有的工作表明,对未标记数据进行预训练是一种有效的、通用的方法,可以提高OOD测试分布的准确性,而许多稳健性干预措施则被限制在狭窄的分布转移类型上。然而,我们也讨论了为什么2)基础模型可能不总是缓解分布变化,例如由于虚假相关性的变化或随时间的变化。最后,3)我们概述了几个研究方向,以利用和改进基础模型的鲁棒性。

我们注意到,基础模型导致改进外推的方法之一是通过为自适应的模型提供归纳偏差(通过模型初始化),这些偏差是在扩展到下游训练数据之外的不同数据集上学习的。然而,这种同样的归纳偏差也可以从预先训练好的数据中编码有害的关联,并在分布转移存在的情况下导致表征和分配上的危害。参见4.6:数据和5.1:进一步讨论这些危害和缓解方法的公平性。

Advantages.

通过在一个大而多样化的基础模型训练分布

p

p

r

e

p_{pre}

ppre上学习表示,基础模型可以提高在下游测试分布

p

O

O

D

T

p^T_{OOD}

pOODT上的自适应导数的精度。OpenAI的CLIP模型,是一个基础模型训练不同的图像和自然语言文档,已经被证明是稳健的一些基准分布转移ImageNet[雷德福等。2021]:例如,剪辑和标准ResNet50获得76%的精度,但剪辑达到6%精度ImageNetV2 [Recht等。2019]和35%的精度高出图像素描[雷德福等。2021],这是相关但不同于原始图像训练分布。

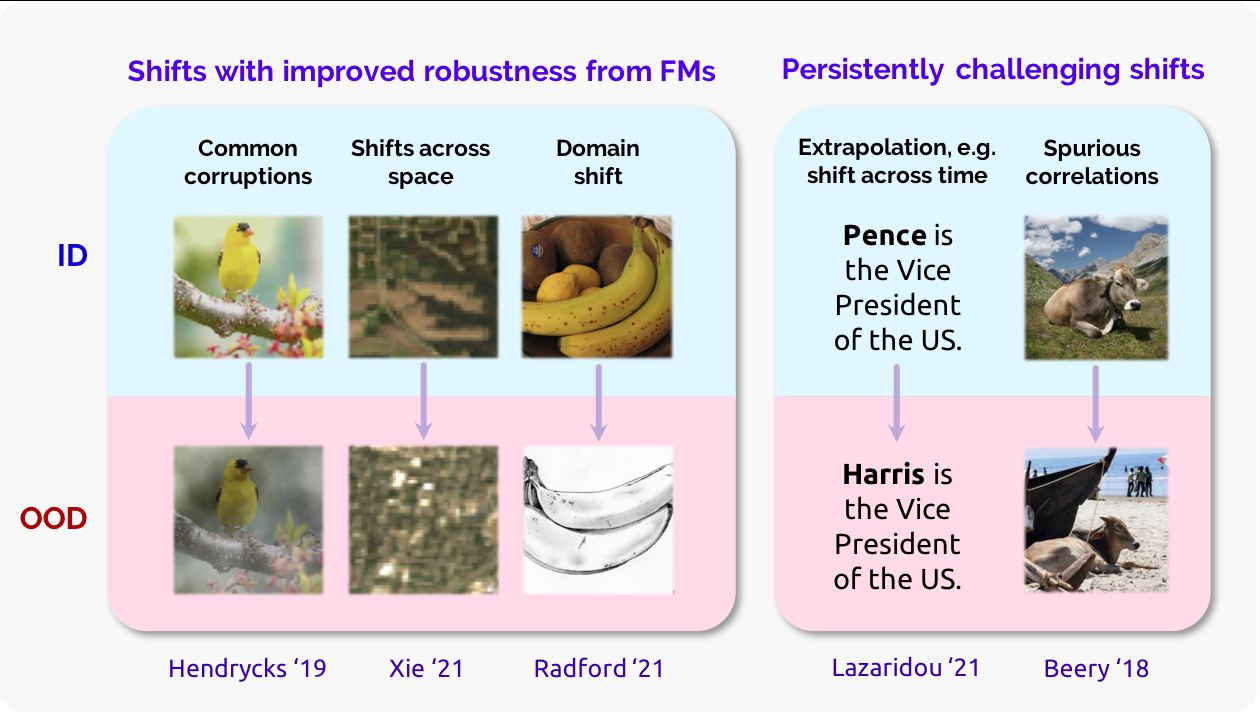

图21。各种分布变化的分布内(ID)和分布外(OOD)输入。这里描述的预测任务是图像的图像分类和文本的事实验证。尽管基础模型学习的表示改善了许多变化(如常见腐败)的下游稳健性[亨德里克斯和迪特里奇2019;谢等人2021a;雷德福等人2021],一些变化如虚假关联(草预测牛)[蜜蜂等人2020]和跨时间外推(随时间变化)[拉扎里杜等人2021]仍未被基础模型解决。

图21。各种分布变化的分布内(ID)和分布外(OOD)输入。这里描述的预测任务是图像的图像分类和文本的事实验证。尽管基础模型学习的表示改善了许多变化(如常见腐败)的下游稳健性[亨德里克斯和迪特里奇2019;谢等人2021a;雷德福等人2021],一些变化如虚假关联(草预测牛)[蜜蜂等人2020]和跨时间外推(随时间变化)[拉扎里杜等人2021]仍未被基础模型解决。

相比之下,许多其他鲁棒性干预,如对抗性训练[疯狂等。2018],不变风险最小化[Arjov斯基等. 2019],或使用更大的模型没有影响有效的鲁棒性(定义为之间的差距)这些ImageNet任务,特别是没有明确的知识的分布。

许多其他研究表明,对大型数据集进行预训练可以提高对常见图像损坏、标签转移和标签损坏的鲁棒性[亨德里克斯等人2019a,b];实现卫星图像任务的空间变化[谢等人2021a;库马尔等人2022];以及自然语言理解任务中的跨主题转换[亨德里克斯等人2020;Fisch等人2019年;瑜伽山等人2019年]。另一个例子是,多样化的基础模型训练数据以包括多种语言(如多语言BERT [Liu et al. 2020b])显著提高了看不见的语言对的性能。

Persistent challenges.

尽管有迹象表明,基础模型将导致对健壮性的实质性改进,但我们预计,基础模型并不是解决分布转移的灵丹妙药。我们将在下面的两大类分布变化的背景下讨论这个问题。

虚假的相关性。虚假相关性是特征和标签在训练分布之间具有统计预测能力,而不是测试分布[海氏和梅因肖森2017;Arjov斯基等人2019;佐川等人2020a]。众所周知的例子包括物体识别依赖背景颜色[Xiao等2020年]、医学诊断的外科标记[温克勒等2019年]、众包数据中的注释者偏差[筑屋2018年;古鲁兰根等2018年;Poliak等2018年;Geva等2019年],以及人口统计偏差。模型学习这些虚假相关性很大程度上是因为基础模型训练和适应数据显示出这些偏差,而这个问题不能简单地用更大的模型来解决

基础模型可能会加剧或减轻虚假相关性的影响,但这取决于特定下游任务的性质及其与基础模型训练数据和算法的关系。通过训练与不同的数据集,基础模型可以提高鲁棒性虚假相关性只在训练数据的一个子集:例如,现有的研究发现,预先训练的语言模型可以避免虚假相关性快速学习反例的虚假相关性[涂et al. 2020]。然而,正如在GPT-3和其他NLP模型中观察到的人口偏差所做的那样,基础模型也可以通过引入基础模型训练数据中存在的偏差来加剧这个问题[Abid等2021;Nadeem等2021;Gehman等2020]。此外,单是规模训练不需要完全解决识别的根本问题,不依赖于预测下游训练集而不依赖于下游测试集的特征[海因策-deml和梅因肖森2017]。解决这些挑战将需要我们理解和管理从基础模型培训中产生的归纳偏差,并发展适应性。

外推法和时间漂移。最后,基础模型的少量和零射击能力将意味着这些模型将越来越多地使用远远超出训练分布。虽然大规模的基础模型训练可以帮助将某些形式的外推应用到新的分布中[帕帕迪米特里尤和尤拉夫斯基2020],但它们的外推能力可能存在限制。例如,现有的语言模型无法处理没有再训练的世界知识变化[拉扎里杜等人2021;202021德格拉等人2021],卫星图像领域[雷德福等人2021],图像网预训练并没有显著提高大型模型对医学图像的性能[Raghu等人2019;Ke等人2021]。我们认为,基础模型不能被假定为在一个给定的模式(例如,所有的图像)中自动推断,并且定义和将基础模型新启用的外推形式与那些仍然无法触及的外推形式分开将变得越来越重要。虽然现有的在属中已经提出了分布变化的分类方法。

Opportunities

基础模型有望作为分布转移的通用稳健性干预手段,并为稳健性研究开辟了新的途径。我们将在下面概述一些机会和一些开放的问题。

理解基础模型的表示形式。现有的关于基础模型稳健性的研究大多是经验性的,而对稳健性收益背后的机制知之甚少。Sun等人,[2019b]假设,预先训练的表示可以将不同的域(如ID和OOD分布)更紧密地结合在一起,这反过来可以提高从标记的ID数据到OOD数据的泛化[Ben-David等人,2010]。在有和没有预先训练的领域表示之间的距离的控制实验可以阐明这种效应。在描述基础模型训练(例如,对比学习作为谱图分解[HaoChen et al. 2021a])及其归纳偏差[Saunshi等人2020a;Lee等人2020a;张和桥本2020;谢等人2020]方面,有初步的前景方向。

然而,这些理论是有限的,并且不能解决其他经验上有效的基础模型,如完全生成语言模型(例如,GPT-3 [Brown et al. 2020]和image-GPT。进一步理解这些归纳偏差在分布转移下是如何有用的,可能会导致一个更完整的理论(4.10:理论)的基础模型如何提高鲁棒性。

基础模型训练中的数据增强。虽然在不知道下游任务的情况下训练的基础模型可以避免一些特定于任务的偏差,并经常提高稳健性,但来自如何训练基础模型的某些统计偏差可能会持续存在。作为一个具体的例子,许多当代的自我监督算法严重依赖于选择一组适当的数据增强[Chen et al. 2020c],这反过来在适应阶段提供了不同类型的鲁棒性。例如,Xiao等人[2021]表明,使用旋转增强的对比学习训练的视觉基础模型可以提高OOD对具有旋转不变性的适应任务的性能,但可能不能提高OOD泛化需要其他不变性的任务的鲁棒性。进一步研究哪些类型的数据增强可以提高广泛下游任务的稳健性——包括从数据中学习的数据增强[Wong和Kolter 2020;Tamkin等人2021c]或设计为普遍适用于数据模式[Verma等人2021]——将为更好的基础模型训练提供信息。

基础模型训练中的编码结构。一般来说,探索数据中已知结构和不变性的编码新方法是基础模型训练的重要路径。许多现实世界的任务都有额外的元数据(例如,空间位置坐标,来自我们的贫困预测例子中辅助卫星的气候信息),这可能为OOD泛化(例如,跨地理区域)[Xie等人,2021a;Koh等人,2021]。例如,Xie等人[2021a]表明,元数据可以作为预训练的目标,以提高下游OOD的精度。在语言上,在HTML数据中的标签建模提供了额外的下游任务相邻监督,允许新的提示形式(例如,填写<标题>标签作为标题建议),并提高了数据效率[阿格贾扬等人,2021]。虽然目前的数据增强方法编码手工制作的知识,但其他途径,如利用元数据,可以提供更自动化的方法来确定为基础模型训练包含哪些结构和不变性。

基础模型训练数据中的专门化与多样性。基础模型训练数据的选择具有下游影响——在更多样化的数据集上进行训练并不总是比更专业的基础模型更适合下游性能[Cole等人2021;Chalkidis等人2020](见4.3:关于更详细的讨论的适应)。在一些领域,如卫星图像和专门文本主题,继续在特定领域上进行预训练可以显著提高下游性能[Reed等人2021;古鲁兰根等人2020]。这是一个潜在的紧张的来源:一方面,我们可能想要训练基础模型在一个大型,不同的数据集为了有更健壮的性能在分布变化,而另一方面,我们可能需要专门的基础模型提高其分布和分布性能在下游任务。更好地理解专业化如何影响基础模型的分布内和分布外性能,将使我们能够设计和收集更有效的基础模型训练集。

适应方法。虽然基础模型提供了一个强有力的起点,但自适应方法如何使用预训练的信息会影响鲁棒性。例如,语言模型的轻量级调优方法(例如,适配器/前缀/提示调优[Houlsby等人2019;李和梁2021;莱斯特等人2021]),通过优化一组小参数(如连续提示)来调整模型以适应新任务,似乎给OOD性能好处(4.3:适应)。Xie等人[2021b]在一种特殊情况下解释了这一点,用冻结基础模型组合学习模型可以降低学习模型的复杂性,提高ID和OOD的泛化。在视觉数据集上,Wortsman等人[2021];Kumar等人[2022]发现,冻结基础模型和只训练头部可以比微调整个模型获得更好的OOD性能。Kumar等人[2022]从理论上解释了这一点,他们表明,即使在一个简单的设置(两层线性网络)中,完全的微调也会扭曲预先训练好的特征。然而,对于为什么冻结参数似乎能提高OOD的性能仍然知之甚少。最后,虽然目前的自适应方法可能足以实现良好的ID泛化,但这些方法在其设计中并没有明确地考虑到分布的变化。作为第一步,我们可以研究研究分布变化的方法,如领域自适应、领域泛化和半监督学习方法在用于自适应时如何与基础模型相互作用。这些方向的进展可以导致适应方法,可以更好地利用基础模型的鲁棒性。

AI safety and alignment

人工智能(AI)安全领域关注先进人工智能模型的潜在事故、危害和风险,特别是对社区或社会的更大规模风险。当前的基础模型可能远未带来这样的风险;然而,它们的能力和潜在的应用程序的广度是惊人的,并且与以前的ML范式相比有了明显的转变。虽然人工智能安全历来在人工智能研究中占据着更边缘的地位,但目前向基础模型及其相应的普遍性的转变为人工智能安全研究人员提供了一个机会,以新的角度重新审视该领域的核心问题,并重新评估它们近期或近期的相关性。

Traditional problems in AI safety.

人工智能安全研究的一个主要分支关注先进人工智能系统的影响,包括那些可能匹配或超过人类表现在广泛的认知任务[Everitt等人,2018]。81在此背景下,安全研究的中心目标是减轻先进人工智能发展带来的大规模风险。82这些风险可能比5.2:误用、4.8:健壮性和4.7:安全性中考虑的风险更具推测性;然而,它们的规模要大得多,至少在原则上可能来自未来的高能力的系统。特别令人担忧的是全球灾难性风险:大致来说,全球或跨代的风险会导致死亡或以其他方式显著降低受影响者的福利(例如,核战争或快速生态崩溃)[博斯特罗姆和希尔科维奇,2011年]。那么,人工智能安全研究相当于一系列项目,旨在描述先进人工智能的发展带来的(如果有的话)灾难性风险,并开发合理的技术解决方案,以降低这些风险的可能性或严重性。最好的情况下场景从人工智能安全的角度来看是解决控制问题:如何开发一个先进的人工智能系统,使我们能够获得系统的计算效益,同时给我们有足够的控制,这样系统的部署不会导致全球灾难[博斯特罗姆和希尔科维奇2011]。然而,技术解决方案并不足以确保安全:确保安全的算法实际上是在现实世界的系统中实现的,而不安全的系统没有被部署,可能需要额外的社会技术措施和机构。

强化学习(RL)研究针对奖励优化的决策代理,在过去十年里一直是人工智能安全的主导焦点。这里的问题是,很难为人工智能指定和实例化与人类价值观一致的奖励功能,而是在不构成全球灾难性威胁的最小意义上。虽然这个被称为价值对齐的问题[加布里埃尔2020;2016]乍一看可能微不足道,但人类的价值是多样的,无定形的,定量捕捉具有挑战性。因此,一个突出的担忧是奖励黑客,人工智能发现了一种不可预见的政策,最大限度地提高对人类福祉的代理奖励,但其错误说明会导致重大伤害。许多解决价值对齐问题的努力都集中在最大化相关性上,即一旦系统运行,系统设计中的错误就可以得到纠正[Soares et al. 2015]。这可能远非简单——在RL上下文中,具有特定目标的代理将被激励去禁止改变该目标的尝试,因为任何改变该目标的尝试都可能不是目标实现的最佳选择

然而,纯RL并不是获得先进人工智能的唯一理论途径。基础模型也可以用简单的(自我)监督的目标进行训练,比如下一个令牌预测,但仍然可以以交互式和目标导向的方式使用,不管有没有额外的RL训练。此外,似乎许多这些方法可能通过直接扩展计算、参数数量和数据集大小来增加能力[Hestness等人,2017;Kaplan等人,2020]。在基础模型的更广泛的背景下,诸如价值对齐和相关性之类的概念在几个方面与纯RL的情况有所不同,因此必须仔细地进行理论化。

Current foundation models and AI safety.

RL设置中的许多这些风险都来自于为执行目标而优化的模型。然而,最近的基础模型的人工智能安全研究的一个关键挑战是,尽管没有明确优化,但目标导向行为可能会出现(见4.2:培训)。例如,大型语言模型可以在语料库上进行训练,其中代理以目标导向的方式使用语言,例如在有说服力的文本中。为了很好地预测下一个标记,模型可能获得推理和产生参数的一般能力,这些能力可能在适当的上下文中出现。根据其他类型的人类数据训练的基础模型可能会捕获数据中存在的其他类型的目标导向行为;例如,如果训练数据包括拳击比赛的视频,他们可能会试图击倒他们的人类操作员。最近的工作也试图直接训练代理产生目标导向的行为;例如,决策变压器训练轨迹的序列模型[斯里瓦斯塔瓦等人2019;施米德胡伯2019;陈等人2021b]。然后,人们可以通过“提示”这个高回报的模型来产生高回报的轨迹,这就提出了来自RL上下文的奖励黑客问题。

然而,对目标导向模型的安全研究的一个主要目的是获得对代理所追求的行为的更原则性的控制和可解释性,而不是依赖于来自黑盒神经网络的不可思议的决策。这使得目前的基础模型成为人工智能安全研究的一个令人兴奋的研究途径,因为调整它们可能是对齐更先进模型的有用先驱[克里斯蒂亚诺,2016;Cotra,2021;Kenton等人,2021]。一个挑战是基础模型的训练目标和期望行为之间的失调;例如,一个语言模型可以被训练来预测训练语料库中所有文档的下一个单词,而不管准确性如何,但用户可能希望模型只输出真实或有用的文本[Tamkin et al. 2021a]。一个潜在的方法引导目标导向代理所期望的行为可能是用自然语言训练他们的行为可以引导他们输出解释语言描述他们“相信”执行的任务,类似于可控生成和源归因[例如,Keskar等2019,参见2.3:机器人,2.5:交互和4.11:可解释性]。然而,需要进一步的进展,以确保这些模型在野外的可靠性和自一致性(4.8:鲁棒性),以及获得对这些模型如何运作的更机械的理解[Cammarata等人,2020年,也见4.11:可解释性]。即使基于自然语言的对未来基础模型的控制能够实现更好的任务规范和监控,模型也可能从人类数据中获得欺骗性或其他不受欢迎的行为——识别和中和这种行为是未来研究的另一个重要方向。

虽然前一段中描述的自我监督目标训练模型捕获人类行为的数据,新的训练范式可能产生目标导向的基础模型能够执行广泛的任务在复杂的环境中,并表现出能力优于人类在不同的领域(见4.2:培训)。例如,目标导向的基础模型可以在一个开放式的自游戏设置中进行训练,类似于AlphaGo,或者在大量的多任务单代理RL设置中进行训练。这可能会导致紧急能力,使让代理执行目标的努力复杂化,特别是如果许多代理在一个丰富的世界模拟器中一起训练,鼓励欺骗、误导、伪装、说服和战略计划等技能的发展。除了对抗欺骗行为,目前也不清楚如何有效地评估和控制非常有能力的模型的行为,称为可扩展监督或对齐[Amodei等人2016;Leike等人2018];例如,对化学基础模型提出的新反应进行评分(见4.4:评价)。因此,用于训练、指导、监控和理解这些模型的新的人类循环方法是令人兴奋的未来方向。

最后,即使在这些更先进的能力出现之前,近期人工智能安全的一个重要研究领域就是表征和预测当前自我监督基础模型的能力。有三个方面使这一点具有挑战性。首先,基础模型的通用性意味着它们可以以意想不到的方式应用于无数不同类型的应用程序。列举基础模型的当前和计划应用并不足以捕获它们可以使用的全部方式。其次,即使在特定的应用程序中,模型功能也是突发性的:随着模型的规模,它们以意想不到的方式增长和变化。例如,通过“提示”控制GPT-3的能力是一种突发现象,在较小的GPT-2模型中,只有最简单的一些现象很明显[Radford等人2019;Brown等人2020]。未来基础模型的突发特性将是什么样子是未知的。第三,即使在一个特定的应用程序和规模中,一个模型的功能也不容易被描述。例如,一旦逗号添加到输入中,GPT-3执行加法的能力显著提高[Branwen 2020;布罗克曼2020]。同样,提示的小改写会对任务性能产生很大影响。由于提示的空间难以枚举,因此明确断言任何任务都超出了当前基于提示的基础模型的能力范围是一个挑战——这是推理基础模型可能产生的灾难性风险的主要挑战。

Potential catastrophic risks from future foundation models.

当前模型的广泛和快速增长的能力表明,试图描述更先进的系统可能带来的灾难性风险的好处。我们至少看到了两种方式的高级基础模型可能有助于这种结果。

灾难性的健壮性失败。4.8:鲁棒性讨论了模型在面对新数据时如何以意外或有害的方式表现[Amodei等人2016;尤德科夫斯基等人2008]。如果将基础模型集成到重要的系统中,利用基础模型快速适应许多不同的任务和情况,那么这些故障可能尤其重要。如果故障发生在战争系统(导致不必要的武器排放,可能引发冲突)、关键基础设施(意外破坏关键能源或农业能力),或成为大部分经济活动的关键(其意外的失败可能导致生活水平突然崩溃和政治不稳定;参见5.5:经济学)。事实上,与其他类型的ai相比,灾难性鲁棒性失败的威胁与基础模型尤其相关。这是因为基础模型由一个单一的模型组成,该模型可能适用于许多不同的用例,这样,由模型学习到的统计关联得出的健壮性失败在原则上可以在几个不同的领域中以相关的方式表现出来。如果将同一个基础模型集成到多个关键功能中,那么模型中缺乏鲁棒性可能会导致跨越多个关键功能或故障保护的相关故障。

指定的目标。基础模型的使用可能会增加优化错位但易于指定的目标的风险,通常被称为古德哈特定律[Kenton等人,2021;古德哈特,1984]。目前这些风险的一个例子是一些推荐系统的负面影响(如两极化、媒体成瘾),这些系统可能优化简单的参与指标,而不是难以衡量的社会和消费者福祉的结合[Burr等人2018;Milano等人2020]。未来的机构可能会利用无法解释的基础模型来最大化简单的衡量标准,如利润或GDP,因为这些模型能够适应这些指标所依赖的许多不同的子问题。然而,在更大的规模上,优化这些代理指标,而不是为人类福利设计的更全面的目标,可能会无意中导致环境或地缘政治危害。

Conclusion

总之,我们认为,基础模型的当前和潜在的未来涌现的特性使它们成为人工智能安全领域的成熟研究对象。我们鼓励未来努力描述和预测基础模型的确切能力和风险;开发新方法,使基础模型与人类价值观和理想目标相一致;并为各州、研究实验室和企业协调积极措施,以减轻显著风险。

Theory

严格的数学理论在许多工程和科学学科(例如,电气工程中的信息论)中起着基础性的作用。我们相信,基础模型理论在指导技术决策和创新方面特别有益,因为对基础模型的实验需要巨大的计算成本。此外,理论上的见解有助于阐明基本的局限性和解释令人惊讶的经验现象。然而,尽管最近取得了很多进展,但社区目前对基础模型的理论理解有限。

深度神经网络是基础模型的主干。即使在经过充分研究的监督学习设置中,训练和测试场景具有相同的分布,围绕深度网络也有许多开放的问题,如理解非凸优化、优化器的隐式正则化效应和表达性。基础模型提出的问题明显超出了有监督的深度学习设置。理论分析基础模型的核心问题是理解为什么在可能存在无监督/自监督损失的一个分布上进行训练会导致在不同的下游分布和任务上产生良好的适应性能。

我们将讨论一种直观的模块化来分析基础模型,它揭示了监督学习和基础模型之间的联系,具体的和核心的技术问题,以及一些有希望的理论工具来解决这些问题。这些新的核心问题可以为基础模型提供有用的见解,并可以与监督深度学习理论并行研究。当我们专注于分析下游性能时,所提出的模块化和工具可以被证明对分析其他感兴趣的指标很有用,如对分布转移的鲁棒性(4.8:鲁棒性)和安全性(4.7:安全性)。

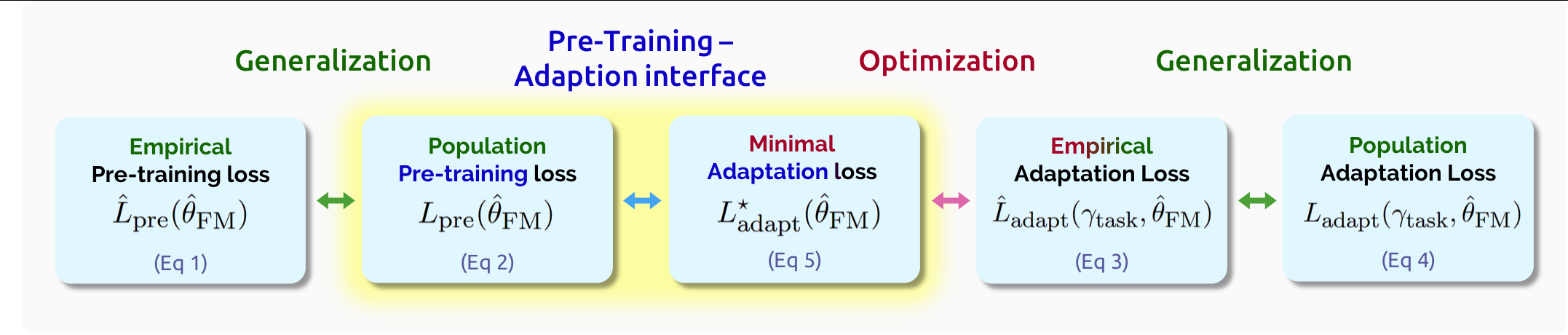

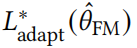

图22。从对不同数据的预训练到对适应任务的下游性能的基础模型的分析,包括捕获如上面所示的不同损失项之间的关系。主要的挑战是分析突出的训练前-适应界面,除了训练前和适应阶段的模型架构、损失和数据分布外,还需要仔细推理种群损失(4.10.2:理论-界面)。对泛化和优化的分析在很大程度上简化为它们在标准监督学习中的分析。

图22。从对不同数据的预训练到对适应任务的下游性能的基础模型的分析,包括捕获如上面所示的不同损失项之间的关系。主要的挑战是分析突出的训练前-适应界面,除了训练前和适应阶段的模型架构、损失和数据分布外,还需要仔细推理种群损失(4.10.2:理论-界面)。对泛化和优化的分析在很大程度上简化为它们在标准监督学习中的分析。

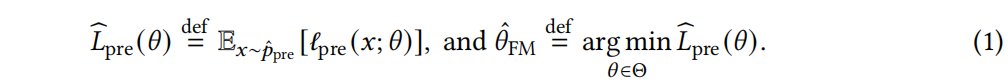

Theoretical formulations and modularizations

回想一下,基础模型是在大量的原始数据(4.2:训练)上进行训练的,然后适应特定的任务(4.3:适应),因此可以自然地分解为训练和适应阶段。我们识别它们之间的接口,并将需要标准深度学习理论的部分中分离出基础模型的部分,以便它们可以独立工作。我们引入了一个模块化的分析框架,该框架在最近的工作中也被隐式或明确地使用,例如,Arora等人[2019b];浩陈等人[2021a];Wei等人[2020b];特里普拉纳尼等人[2020]。在这个模块化分析的关键组成部分是列车前-适应界面。我们首先描述了模块化,并讨论了为什么我们发现这种模块化很有希望,最后也有一些局限性。

我们将明确地将训练阶段称为“预训练”,以区别于适应阶段,适应阶段也可能涉及对特定任务的一些样本进行训练。

训练前阶段。基础模型的预训练通常涉及一个数据分布

p

p

r

e

p_{pre}

ppre(例如,自然文本的分布)和一个预训练的损失函数ℓ_{pre}(𝑥;𝜃),该函数测量参数为𝜃∈Θ的模型的输入𝑥上的损失(例如,GPT-3中的语言建模损失)。设

p

^

p

r

e

\hat{p}_{pre}

p^pre表示来自

p

p

r

e

p_{pre}

ppre的大量独立样本上的经验分布。预训练使

p

^

p

r

e

\hat{p}_{pre}

p^pre上的损失ℓpre最小化,我们称之为经验训练前损失,并产生一个模型

θ

^

F

M

\hat{\theta}FM

θ^FM:

基于优化的自适应阶段。我们将自适应框架为一个依赖于

θ

^

F

M

\hat{\theta}FM

θ^FM的一般约束优化问题,抽象出了那些基于优化某些损失函数的自适应方法,如微调和提示调整.

基于优化的自适应阶段。我们将自适应框架为一个依赖于

θ

^

F

M

\hat{\theta}FM

θ^FM的一般约束优化问题,抽象出了那些基于优化某些损失函数的自适应方法,如微调和提示调整.

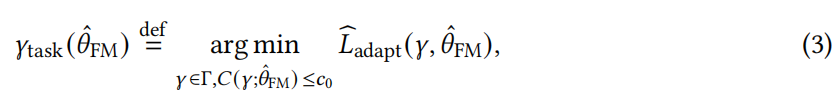

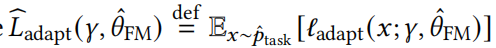

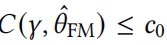

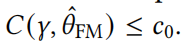

由于不同的自适应方法可以修改模型参数的不同子集,所以我们用一些Γ来表示自适应模型参数的空间。给定一个下游任务分布 p t a s k p_{task} ptask(例如,在特定领域的问题回答)和从 p t a s k p_{task} ptask中采样的一些经验样本 p ^ t a s k \hat{p}_{task} p^task,我们将适应阶段建模为最小化 p ^ t a s k \hat{p}_{task} p^taskw.r.t适应参数𝛾∈Γ上的一些适应损失ℓ_adapt:

其中

是经验适应损失,

是一个可选约束,控制适应参数的复杂性,包括显式正则化(例如,模型维数和范数)和隐式正则化的适应过程。

我们列出了一些常见的自适应方法,并讨论了相应的自适应参数𝛾和约束条件

(1)线性探测:在基础模型的表示基础上训练一个线性分类器。这里Γ =

R

k

R^k

Rk是维数𝑘表示上的线性分类器集,

可以是𝛾的ℓ2或ℓ1范数

(2)微调:优化一个随机初始化的线性磁头的几个步骤,以及所有其他参数𝜃从初始化的

θ

^

F

M

\hat{\theta}_{FM}

θ^FM。这里的𝛾是𝜃和线性头的连接。这一过程可以对应于

捕获的对初始化

θ

^

F

M

\hat{\theta}_{FM}

θ^FM的𝛾的一些隐式正则化。确切的术语

取决于所使用的优化算法,这种隐式正则化的表征是一个积极的研究领域.

(3)提示调优:优化一小组连续的特定于任务的向量,以准备任务输入。这里的𝛾是连续的提示向量,它通常的维数很小,我们可以选择对𝛾的范数有一个约束。

需要注意的一个明显的局限性是,该公式排除了适应方法,如情境学习[Brown等人2020],在适应阶段没有“训练”(即一些经验适应损失的最小化)。我们将在4.10.3:理论中讨论这个和其他限制:理论上下文。

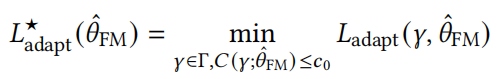

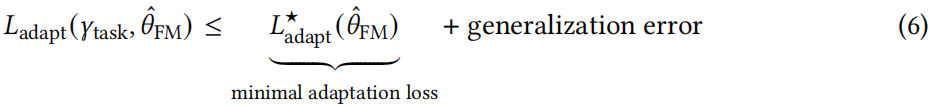

适应阶段的两个中心量是种群适应损失

以及最小的适应损失

对模块化相位的单独分析。现有的标准监督学习的泛化理论旨在证明

。专门针对深网解决这些问题是一个活跃的研究领域。我们还可以利用标准的学习理论分解,将最终的下游任务损失与超额泛化误差和最小自适应损失的约束如下。

其中泛化误差捕获了𝐿adapt和b𝐿adapt之间的紧密关系。89这些关键量之间的分解和关系如图22所示。如上所述,泛化箭头和优化箭头,在监督设置中很大程度上简化为深度学习理论。我们剩下的是基础模型的主要挑战,这是理解为什么最小适应损失

由于训练前种群损失而很小,研究在4.10.2:理论界面。

Arora等人[2019b]的工作率先通过𝐿pre在对比学习背景下

,HaoChen等人[2021a];Tosh等人[2020,2021]放宽了数据假设。

在此框架下成功分析的其他预训练方法(隐式或显式)包括使用语言模型[Wei等人2021]或自我监督[Lee等人2020a],使用自我训练算法[Wei等人2020b;Cai等人2021],以及使用多个监督任务。

Why is the pretraining-adaptation interface interesting?

导致成功界面的条件可能取决于几个量,如训练前和自适应分布、目标和训练方法,以及模型体系结构。这个问题超出了标准泛化理论的范围,但它确实将我们缩小到一些特定于基础模型的重要因素,并抓住了基础模型的各种重要开放问题的本质,正如我们下面所讨论的。

首先,我们注意到这个接口处理涉及两个不同分布的种群数量。因此,成功接口的条件可能涉及分布的特殊特性,例如,训练前分布的多样性以及训练前数据和适应数据之间的结构变化。这使得对界面的分析具有挑战性(如下面在4.10.4:理论工具中所讨论的),因为我们需要对这两个分布之间如何相互关联做出仔细的建模假设。然而,这提出了一种可能性,即为分析这些接口而开发的工具和技术可能有助于理解分布变化的影响,并预测基础模型何时可以提高鲁棒性。

其次,人口损失和可能的成功接口的条件取决于模型体系结构。这就提出了打开神经网络黑盒的挑战。在一个特定的分布上的一个小的训练前损失告诉我们中间层的属性是什么?这样的分析也将指导我们设计新的适应方法,更仔细地利用不同的中间表示。

第三,通过约束复杂性度量

,在最小适应损失的情况下,可以捕获少镜头学习或适应的样本效率。我们需要正式描述这些复杂性度量(例如,通过理解适应过程的隐式正则化效应),并进一步理解为什么小种群训练前损失意味着低复杂度的适应参数𝛾task。对这个问题的一个令人满意的答案可能会使我们能够提高下游适应的样本效率。

最后,更重要的是,界面的关键组成部分是训练前和适应损失的选择。我们想了解如何最好地将训练前和适应目标结合起来,以成功地适应。最能保证成功适应的训练前目标可能与训练前过程中明确最小化的目标不同——上面的界面允许人们在训练前的分布上使用任何替代种群目标。此外,新的替代目标可以证明在广泛的任务中导致良好的适应,可以阐明使基础模型成功的基本方面。总之,该界面排除了泛化的问题,并允许我们正式地解释训练前和适应阶段的几个重要数量之间的相互作用,这些阶段可以以重要的方式指导实践。

GPT-3 [Brown et al. 2020]展示了上下文学习的能力,这是一种不需要任何参数优化的自适应方法。在适应阶段,预先训练的语言基础模型接受一个提示——连接任务的输入输出示例——然后是一个测试示例,然后通过对迄今为止看到的序列(提示加测试示例)生成测试示例的标签。换句话说,没有明确的训练或对模型参数的改变。

模型通过简单地执行这些示例作为输入来从不同的示例中“学习”的机制是什么?之前的模块化并不直接适用,因为我们在适应过程中没有获得新的模型参数,而是我们只通过执行结构设计的输入来执行基础模型的生成能力。然而,分离无限数据的预训练和分离有限数据的预训练的想法仍然是有用的。例如,最近的一项工作首先假设了无限的预训练数据和足够的模型表达性来研究上下文学习[Xie et al. 2021c]。这些假设将上下文学习的表征简化为分析基于上下文学习提示的训练前分布,这些分布来自与训练前数据不同的分布。

特别是,Xie等人[2021c]提出,情境学习源于训练前分布中的长期一致性结构,由具有一致性结构的潜在变量生成模型来描述。更广泛地说,虽然本节中提出的模块化提供了一个很好的框架来获得有用的理论见解基础模型,可能一些紧急行为如上下文学习和其他功能尚未发现需要超越模块化,例如,通过打开架构的黑盒子。

Challenge: appropriate data assumptions and mathematical tools.

与传统的监督学习相比,理解训练前和适应阶段之间的界面需要更仔细地研究数据分布。这是因为训练前和任务适应的分布在本质上是不同的。根据定义,基础模型是在原始数据上训练的,这些数据通常是非常不同的,而适应数据在很大程度上依赖于任务。类似地,上下文学习是学习生成类似于训练前分布的数据的结果,因此理解上下文学习需要对训练前的数据进行仔细的建模。因此,回答围绕基础模型的核心问题需要现实和可解释的假设,这些假设也易于分析。最近的研究要么假设种群数据的某些属性,例如浩晨等人[2021a];Wei等人[2020b]的扩展特性,或者种群数据是由具有某种结构的潜在变量模型生成的。

我们通常缺乏数学工具来将基础模型的属性与人口数据分布中的结构联系起来。HaoChen等人[2021a]应用光谱图论来利用种群分布中的类内连通性。对于潜在变量模型,可以通过概率和解析推导来更精确地表征𝜃ˆFM,但到目前为止仅限于相对简单的模型。社区将大大受益于更系统和更通用的数学工具来解决这个问题。

我们还非常希望定义简单的玩具案例,以便理论家可以精确地比较各种工具和分析的优点。例如,HooChen等人[2021a]和Wei等人[2020b]考虑了流形混合问题,这可能是视觉应用的一个很好的简化测试台。我们需要更多有趣的测试床的离散域,如NLP。我们认为,能够捕获真实数据集的相关属性的易于处理的理论模型,是将基础模型建立在坚实的理论基础上的关键一步。

Interpretability

与大多数其他机器学习模型相比,基础模型的特点是训练数据和复杂性的巨大增加,以及不可预见的能力的出现:基础模型能够完成不可预见的任务,并以不可预见的方式完成这些任务。越来越多的采用为理解他们的行为带来了越来越多的欲望、需求和前所未有的挑战。

与特定于任务的模型相比,基础模型是在庞大的、通常是高度不同的数据集上进行训练的,可能跨越许多领域和模式(见4.2:训练)。通过这种训练,基础模型学习了非常广泛的行为,这些行为在任务和领域之间可能有很大的差异,这可以证明它们能够适应不同类型的下游任务,并表现出特定于这些任务的行为(见4.3:适应)。以GPT-3为例,它被训练为一个大型模型,可以简单地预测文本中的下一个单词。虽然这是一项非常具体和简单的定义的学习任务,但它使GPT-3通过与包含各种互联网文本的大量训练数据集相结合,获得了远远超过下一个单词预测的能力。因此,当提供一些训练样本时,GPT-3现在可以适应明显超出其原始训练任务范围的行为,如简单的算术和计算机编程。这表明,即使是回答关于基础模型的看似最简单的问题,也具有挑战性:它具有什么功能?

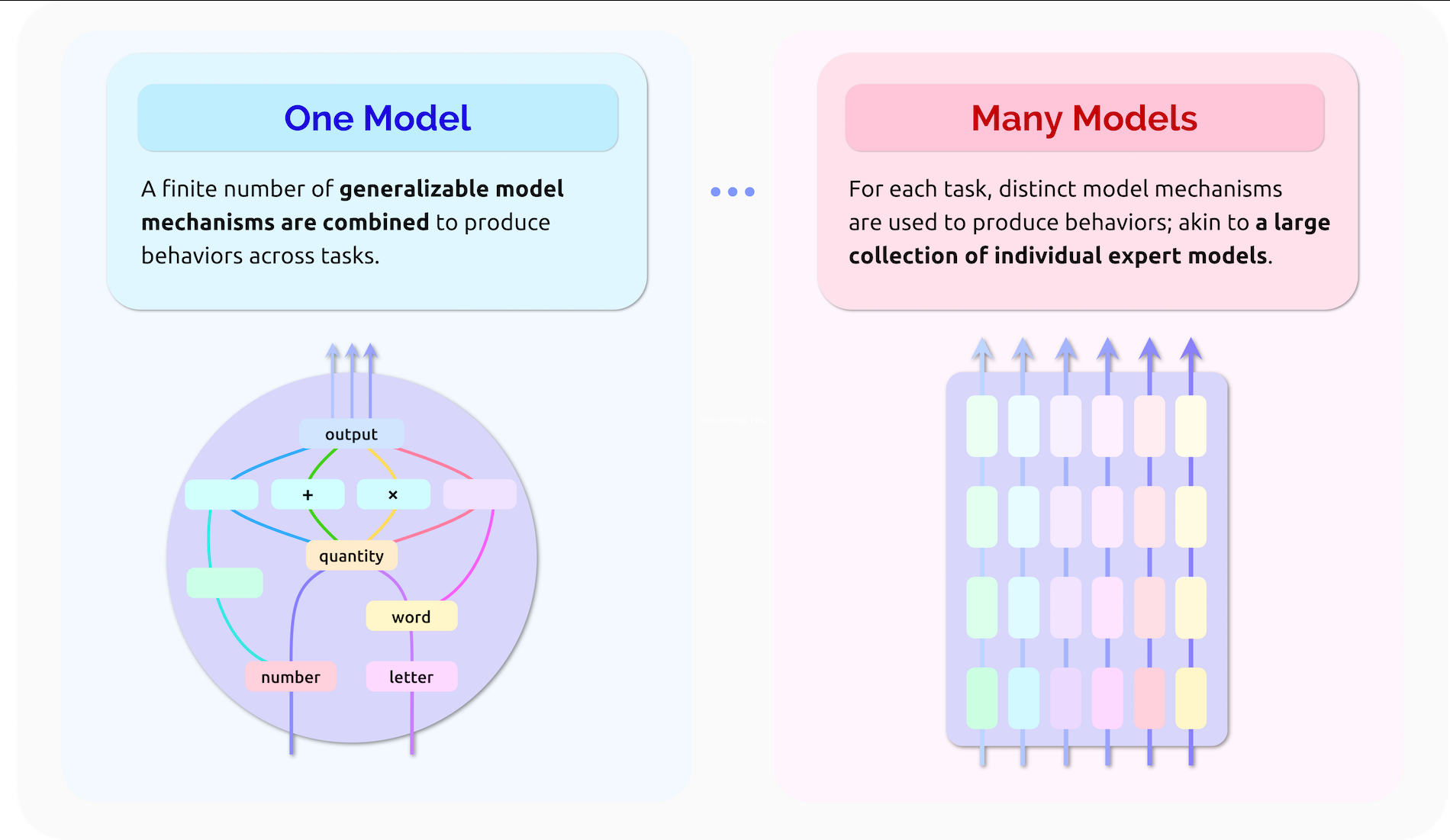

此外,这些不同的能力在多大程度上依赖于不同的或共享的模型机制,类似于模型中的算法构建块,这也是一个开放性的问题。一方面,基础模型可以被解释为单个模型,它利用一些可推广的模型机制来很好地跨任务和领域执行任务。在这种情况下,可以通过识别和表征这些机制来充分了解它们的行为。另一方面,基础模型对不同任务适应深刻不同行为的能力表明,它们也可以被理解为大量独立的专家模型,每个模型都针对特定的任务量身定制。

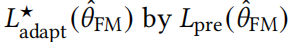

例如,GPT-3用于做算术的模型参数似乎不太可能与用来从英语翻译成法语的参数有很大关系。在这种情况下,一个任务中模型行为的解释不一定提供其他任务中行为的信息。我们将其称为基础模型的多个模型性质(见图23),并认为理解基础模型在一个和多个模型之间的光谱中的位置将是理解它们行为的核心。

为了系统化这一领域的研究,我们提出并讨论了理解基础模型的三个层次[受Marr1982启发]:我们首先讨论理解一个模型能够做什么的挑战和机遇,然后为什么它输出某些行为,最后它是如何做的。具体来说,问题的目的是描述的行为模型可以执行没有窥视模型,而问题为什么旨在提供解释模型的行为的潜在原因的数据,和问题如何理解内部模型表示和机制产生这些行为。在介绍了所有三个层次之后,我们最后讨论了基础模型的不可解释性和可解释性所导致的潜在后果。

图23。基础模型的一个模型-基础模型的许多模型本质:一个中心可解释性问题是理解一个基础模型位于一个模型和许多模型之间的光谱上的位置。作为一种模型,行为可以通过识别和描述有限数量的可概括的模型机制(例如,为单词分配意义、比较数量和执行算术的机制)来进行解释。与许多模型一样,对一个任务中的模型行为的解释不一定提供其他任务中的行为信息,因此需要对每个任务中的行为进行独立的研究。

图23。基础模型的一个模型-基础模型的许多模型本质:一个中心可解释性问题是理解一个基础模型位于一个模型和许多模型之间的光谱上的位置。作为一种模型,行为可以通过识别和描述有限数量的可概括的模型机制(例如,为单词分配意义、比较数量和执行算术的机制)来进行解释。与许多模型一样,对一个任务中的模型行为的解释不一定提供其他任务中的行为信息,因此需要对每个任务中的行为进行独立的研究。

Characterizing behavior.

对一项技术最简单的理解就是了解这项技术的作用。这个看似简单的问题对于基础模型来说是一个重大的挑战性,因为这些模型能够执行无数不可预见的行为和任务。特定于任务的神经网络模型被训练为在单个领域中执行单个任务,例如,图像分类。因此,它们的任务和输入和输出领域是明确的;然而,即使对于这些模型,在给定特定的输入下,确切知道模型将做什么也是一个挑战。例如,对于两个感知相似的输入,模型行为可能会意外地有很大差异[加格和罗马克里希南2020;金等人2020]或相同数据的两个亚群体(例如,按种族或性别分层[Hovy和Søgaard 2015;布洛杰特等人2016;塔特曼2017;布奥兰维尼和格布鲁2018])。

这种描述模型行为的挑战被基础模型放大了多倍。模型能够执行的任务空间通常是大的和未知的,输入和输出域通常是高维的和巨大的(例如,语言或视觉),并且模型较少局限于特定领域的行为或失败模式。例如,考虑到GPT-3在大型语言语料库上接受训练的惊人能力,并随后发展出生成主要功能丰富的计算机程序片段的能力。因此,描述基础模型行为的一个关键挑战是识别它所具有的能力。此外,对于基础模型可以执行的每个任务,可能有多个或无限多个,当试图理解更简单、特定于任务的模型的行为时,所面临的所有挑战仍然存在。

描述基础模型可以执行的每个“任务”由于它们的一个模型——许多模型的性质而更加复杂(见图23)。再次以GPT-3为例,结果表明它可以通过简单的提示来定制许多任务(见4.3:适应)。然而,每个任务都可以通过许多可能的提示来指定,提示中的细微变化可能会导致模型行为的有意义的更改。例如,影评的情感分类任务可以通过呈现影评,然后是“她对电影的情感是……”或“我的总体感觉是电影是……”;尽管这些提示似乎构成了密切相关的任务,GPT-3对每个提示将表现出不同的反应准确性[Zhao et al. 2021]。像这样的观察结果提出了关于提示的特征和由此产生的模型行为之间的关系的重要问题。具体来说,可以有意义的不同反应看似相似的提示实际上被认为是来自相同的模型还是来自高度不同的模型机制,并描述的基础模型的行为(或其适应衍生品)在一个任务真正帮助描述其他可能的适应模型的行为吗?

为了识别一个基础模型所具有的能力和它所缺失的能力,研究人员可以利用控制评估。在这里,领域专家设计已知需要特定能力的提示,然后研究模型对这些提示正确响应的能力[帕帕迪米特里奥和尤拉夫斯基2020年20日;卢等2021a;片冈等2020;吴等2021c;谢等2021a;Koh等2021]。例如,心理语言学家设计了提示,要求语言模型在语法正确的句子和特定语法不准确的同一句子之间进行选择;知道模型是否更喜欢语法正确的句子而不是语法不正确的句子,告诉我们模型是否具有识别这种不准确性所需的特殊语法能力。

考虑到基础模型的巨大可能能力,以及我们目前缺乏任何先验方法来确定基础模型是否具有给定的能力,像这样的定制评估是至关重要的。它们允许探索基础模型能够实现的行为范围,同时需要最小的模型访问:我们只需要呈现输入和接收模型输出,而且我们不需要依赖于对模型的实现或参数的访问。考虑到基础模型可能能够(或不能)的无限个可取和不可取的任务、子任务和行为,描述模型行为和能力将越来越具有挑战性和重要。我们相信,而不是依靠一些专家制定和测试可能的行为,这将是至关重要的扩展这些类型的分析测试更多的行为,通过开放这条线的探索不同社区和专家在许多学科,以及通过增加访问和这些评估的规模。

Explaining behavior.

除了描述一个基础模型正在做什么之外,人们还可以尝试通过根据数据中的潜在原因来解释这些行为,来描述它为什么会执行某些行为。虽然当前的解释方法,提供这样的解释行为,可以揭示输入质量,影响模型的反应,他们通常需要完全访问模型,通常是有限的能力阐明任何一般模型机制,基础模型用来应对许多输入、任务和域。

目前的解释方法通常可以被理解为不同的模型,它们旨在解释另一个黑盒模型的特定行为。这些方法与分析行为的模型是分开的,而模型本身是无法解释的。这种分离可能是有问题的,因为所提供的解释可能缺乏忠诚[雅各维和戈德堡2020],因为它不可靠和误导了一种行为的原因[cf]。Rudin,2019年]。此外,不可靠的解释可能会吸引人类更信任不可靠的模型,而不是以其他方式信任(关于人工智能信任的详细讨论,见Jacovi等人[2021])。随着我们从特定任务的模型转向基础模型的广泛采用,这些类型的关注越来越增长,因为它们的行为要复杂得多。

目前的解释方法在很大程度上可以分为提供模型行为的局部或全球解释[Doshi-Velez和Kim 2017]。局部解释试图解释模型对特定输入的反应,例如,通过将行为的每个输入特征赋予相关性,或通过识别与行为最相关的训练样本[Simonyan等2013;巴赫等2015;2017;孙达拉扬等2017;施里库马等人2017年;斯普林伯格等2014年;泽勒和费格斯2014年;伦德伯格和李2017年;津格拉夫等人2017年;方和维达尔迪2017年;高和梁2017年]。相比之下,全局解释并不与特定的输入相关联,而是旨在揭示影响模型行为的整体数据质量,例如,通过综合模型与行为关联最强的输入。

局部和全局解释为特定任务模型的行为提供了有用的见解[例如,Li等人2015年;Wang等人2015年b;拉普斯金等人2019年;托马斯等人2019年;Poplin等人2018年]。在这里,由此产生的解释通常被认为是导致行为的模型机制的启发式;例如,当模型读取手写数字“7”时,解释认为水平线很容易产生这样一种印象,即水平线通常是模型用来识别所有7或区分所有数字的重要特征。

然而,考虑到一个模型——基础模型的许多模型性质,我们应该小心不要从行为的具体解释跳到对模型行为的一般假设。虽然目前的解释方法可能会阐明特定的行为,例如,通过识别数据中强烈影响这些行为的方面,但结果的解释不一定提供模型对其他(甚至看似相似)输入的行为的见解,更不用说其他任务和领域了。

另一种方法可能是通过利用自我解释形式的基础模型的生成能力,完全回避这些类型的事后解释。埃尔顿2020;Chen等人,2018],也就是说,通过训练这些模型,不仅生成对输入的响应,而且联合生成对该响应的人类可理解的解释。虽然目前还不清楚这种方法在未来是否会富有成效,但我们有理由表示怀疑:语言模型,以及现在的基础模型,在产生流畅的、看似合理的内容方面非常出色。简单的自我生成的“解释”也可以如此。因此,重要的是要辨别一个模型创建看似可信的解释的能力和提供对其行为的真实洞察力之间的差异。

Characterizing model mechanisms.

对系统的深入理解通常意味着理解一个系统是如何执行的:它包含哪些知识和机制,以及这些知识是如何组装起来形成整体的?如果这确实是可能的,描述基础模型中的表示和操作它们的机制将是满足彻底理解这些扩散模型的愿望的核心;无论这些机制是多的、具体的还是少的和可推广的,它们都是基础模型在不同任务和领域中采取广泛行为的能力的核心。

使模型表示和机制的概念具体,考虑一个简单的行为表现出GPT-3:很快观察GPT-3时提供的例子添加小数字,然后查询执行添加两个新的数字:高概率,预测添加的正确结果[Branwen 2020;布罗克曼2020]。当问为什么GPT-3执行,可以找到输入的证据,如提示方面高度影响它的反应(这可能是两个数字,虽然不一定),或GPT-3的训练数据影响其反应(这些可能是添加的例子,虽然不一定)。深入研究这个模型,我们可以设想对GPT-3添加特定数字对的机制以及添加其他任意数字对的机制有更深入的理解。我们也可以设想对这些机制是类似于“加法”的数学概念或仅仅与这个概念相关的更深入的理解。

通过理解单个的模型机制,我们可以建立一个对基础模型的复杂行为的组合理解。一个比数字的加法稍微复杂一点的任务是解决数学单词问题,其中数字伴随着单位,问题用自然语言表示。一旦我们理解了模型执行加法的机制(或机制),我们就可以研究这个机制是否被用作解决单词问题的中间步骤。如果使用添加机制,我们已经建立了我们的模型如何解决单词问题的理解,我们增加信心基础模型推广数量的概念和添加(不是另一个相关或启发式),而且,此外,我们增加了信心的能力预测模型的为什么(哪部分输入关注)和输出的(添加两个数字)。如果不使用添加机制,我们可能会保留一个健康的怀疑态度,即这是真正的添加,我们可以研究使用哪些表示和机制来代替。

重要的是要知道,有许多更复杂的模型机制,例如,从名称中的字符或图像中的像素估计种族。在基础模型中建立这种机制的证据及其使用可以支持一种道德或法律责任,即禁止该模型执行预测性监管、市场营销、贷款申请和整体监控等任务。已经出现了大量的方法来研究神经网络模型的这些内部方面。通常,这些方法将模型划分为节点(例如,神经元、层或层的部分),然后询问节点中捕获的表示或节点组装的机制。有些方法是假设驱动的:通过假设节点可能捕获某些信息(例如,一个单词的语法特征,或一个人的种族),我们可以探测所有节点来量化它们可提供的信息[Alain和Bengio 2016;维尔德霍等人2016;贝林科夫等人2017;Adi等人2017;网络等人2018年;休伊特和梁2019年;休伊特和曼宁2019年;2020年;沃伊塔和提托夫2020年;皮门特尔等人2020年]。其他方法建立在解释方法,而不是识别哪些数据导致某些行为,他们试图确定哪些数据导致特定节点激活,或哪个节点导致另一个节点在模型激活,从而揭示模型表示和机制[Olah等人2020;穆和安德烈亚斯2020;卡特等人2019;Goh等人2021]。综上所述,这些方法检查了模型的内部,并为持续探索基础模型的行为提供了基础。然而,基础模型中潜在的表示和机制的数量是巨大的,特别是考虑到它们的一个模型——许多模型的本质,而这些类型的方法通常只捕获了一个模型的内部性的一小部分。因此,扩展表示和机制的发现,以及阐明那些与模型行为最相关或最普遍的表示和机制,是一个开放的挑战。与许多解释基础模型的方法一样,这些类型的探索将受益于包括和支持更多样化和跨学科的研究人员,以及更可访问、更灵活和可扩展的发现方法。

总之,我们认为基础模型的一个模型——许多模型的本质(回顾图23)为当前的可解释性研究提供了新的机会和挑战:单一的基础模型有许多适应性,我们根本不知道它们在多大程度上共享共同的机制。在机制是共享的程度上,理解基础模型可能是描述这些机制及其关系的一个易于处理的问题。由于机制是独立的,因此基础模型的每一个适应都必须独立分析,这导致对基础模型的任何新适应的性质产生深刻的不确定性。

Impacts of non-interpretability and interpretability.

最后,我们想强调,基础模型的广泛采用与最近许多跨学科研究者的请求不使用复杂的黑盒模型高风险决策[例如,Rudin 2019],而是关注长期的开发和应用更本质上可解释的模型。

在这些请求的过程中,旨在解释基础模型的工作是一把双刃剑。大型机器学习模型,现在基础模型,通常部署强大的企业和机构,和增量解释的进步可以夸大“道德”和继续使用模型,好像他们已经实现了可解释性,掩盖现实,他们仍然远低于传统标准的算法可解释性。此外,当获得可解释性的方法经常假定易于获得模型及其实现和参数时,可解释性不仅可以作为强大机构的掩护,而且还可以将模型知识集中在同一人手中。对于那些致力于基础模型的可解释性的人来说,我们有责任不断地问,人们是否在努力使基础模型能够向研究人员和模型所有者解释,还是能够向每个人解释。

同时,在基础模型已经被部署的程度上,关于可解释性的工作提供了独特的机会来改变基础模型的知识,从而改变权力,回到数据化和被评估的人。解释可以促进发现模型的社会显著方面。更根本的是,工作创建可访问的方法,允许任何人解释基础模型的行为将权力转移到不同的人,调查模型,创造机会的机会发现模型的重要方面对个人或他们的社区,和机会有意义的同意,改善,或完全比赛基础模型的使用。最后,重要的是研究人员认为基础模型的可解释性不仅是一个目标,但一个问题:研究可以探索和评估是否缺乏基础模型可解释性是内在的,应该深入研究和广泛认为的严重问题阻碍使用(或增加监管)这些系统,或者是否可能为未来基础模型维护高标准的可解释性。

1175

1175

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?