在深度学习中,大致分为回顾任务与分类任务,回归任务常用均方误差损失(MSE)和平均绝对误差损失(MAE);分类任务常用交叉熵损失。

1. 均方误差损失(Mean Squared Error, MSE)

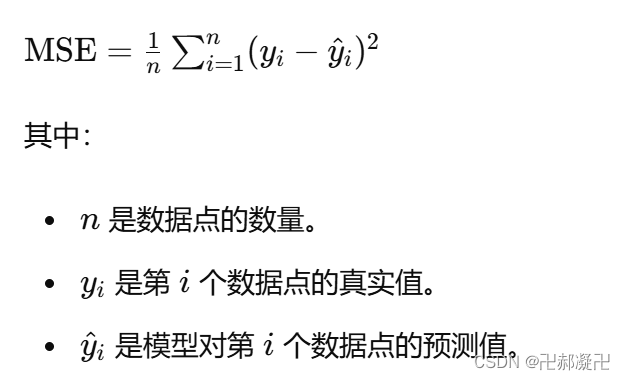

数学公式表达为:

特点:MSE 对于离群点(outliers)非常敏感,因为误差被平方了,所以大的误差会对整体的 MSE 产生更大的影响;MSE 是凸函数(convex function),在很多优化问题中,尤其是使用梯度下降法时,非常有用,因为凸函数的局部最小值就是全局最小值。

2. 平均绝对误差(Mean Absolute Error, MAE)

平均绝对误差(Mean Absolute Error, MAE)是一种衡量回归模型预测准确性的重要指标。它通过计算预测值与真实值之间的绝对误差的平均值来评估模型的性能。公式如下:

特点:MAE 对离群点(outliers)不如均方误差(MSE)敏感,因为它使用的是绝对值而不是平方值。因此,单个异常值不会对 MAE 产生过大的影响;MAE 的值与原始数据的单位相同,易于解释。例如,如果数据的单位是米,MAE 也是米,直接反映了平均预测误差;MAE 不是凸函数,这意味着在某些优化算法中(如梯度下降法)可能会带来挑战,因为局部最小值不一定是全局最小值。

3. 交叉熵损失(Cross-Entropy Loss)

又称对数损失(Log Loss),是一种常用于分类问题中的损失函数。它衡量的是两个概率分布之间的差异,特别是在神经网络和机器学习模型中广泛使用,用于评估模型输出的概率分布与实际标签分布的匹配程度。

在分类问题中,模型输出的是一个概率分布,表示每个类别的预测概率。对于二分类问题,可以使用 sigmoid 函数将输出值映射到 [0, 1] 区间;对于多分类问题,可以使用 softmax 函数将输出值映射到一个概率分布。

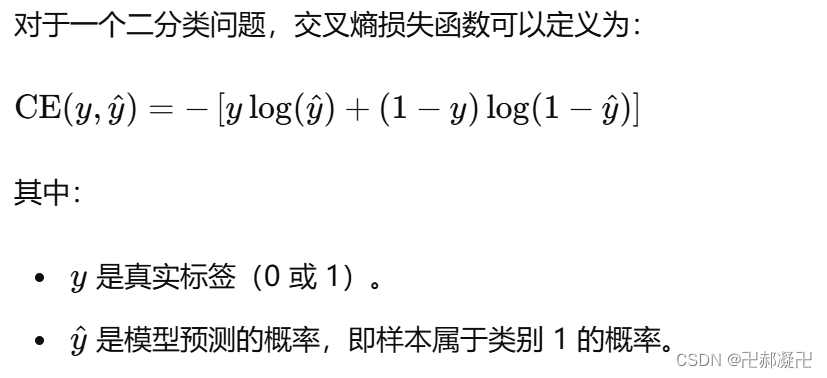

3.1 二分类问题中的交叉熵损失

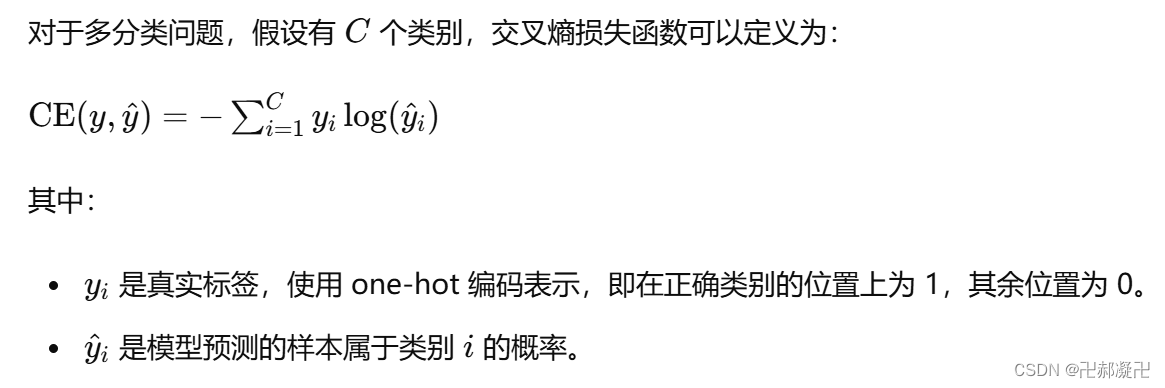

3.2 多分类问题中的交叉熵损失

特点:交叉熵损失衡量的是两个概率分布之间的差异,反映了模型预测的概率分布与真实标签分布的匹配程度;由于交叉熵损失涉及对数运算,在计算时需注意数值稳定性,避免对数零或接近零的值。通常通过加一个小的常数(如 ϵ\epsilonϵ)来处理;交叉熵损失是凸函数(convex function),在优化过程中有助于找到全局最优解。

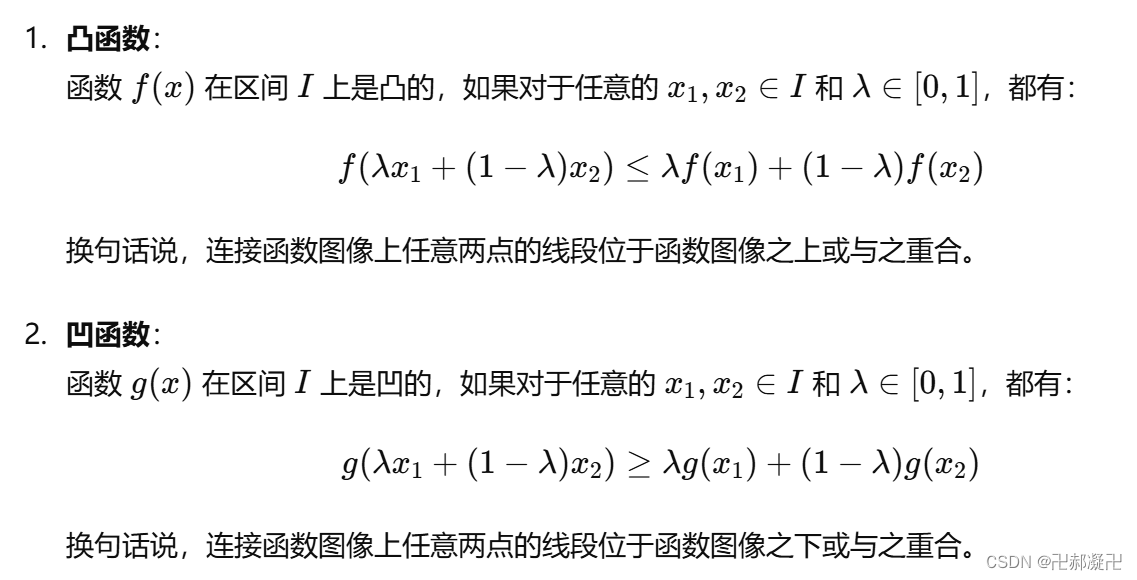

附:凹凸函数的定义:

727

727

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?