简介

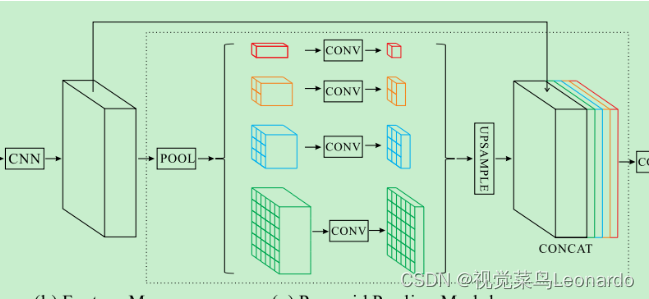

整体还是采用跳层连接结构,引入了统一注意力融合模块(空间和通道注意力机制)、金字塔模块来聚合上下文。

使用统一注意力模块来提高分割精度,通过融合解码器中的低级和高级特征来实现的,与之前的BiSeNetV2中的通道注意力模块相似,产生权重α,并与输入特征融合。本系统包含两种注意力模块——空间注意力和通道注意力。

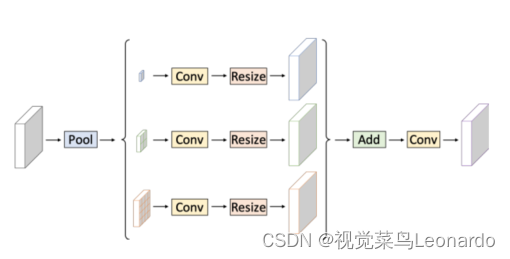

设计了上下文聚合模块(SPPM),基于PPM,使用加法替代concat,减少了中间和输出通道。

Stage中引用STDC模块。

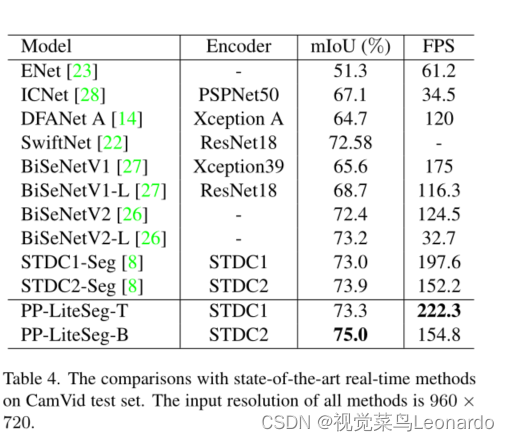

基于CityScapes数据集,实现了 72.0% mIoU/273.6 FPS 和 77.5% mIoU/102.6 FPS。

实时语义分割:

早前的实时语义分割提出了许多方法:轻量级模块设计(EfficientNet)、双分支架构(BiSeNet)、早期下采样(ENet)、多尺度图像级联网络(ICNet) 。

STDC基于BiSeNet,但舍弃了双分支网络,使用详细的group-truth来引导特征,提高效率。

未看:对于特征融合模块,SFNet设计了流对齐模块,AlignSeg设计对齐特征聚合模块和对齐上下文建模模块。FaPN通过变换偏移应用于可形变卷积来解决特征错位问题。

详细介绍:

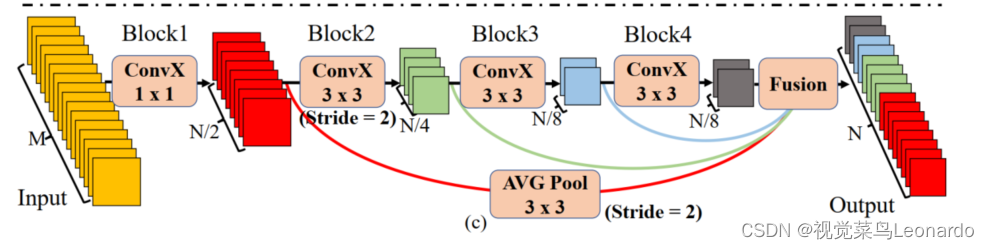

解码器

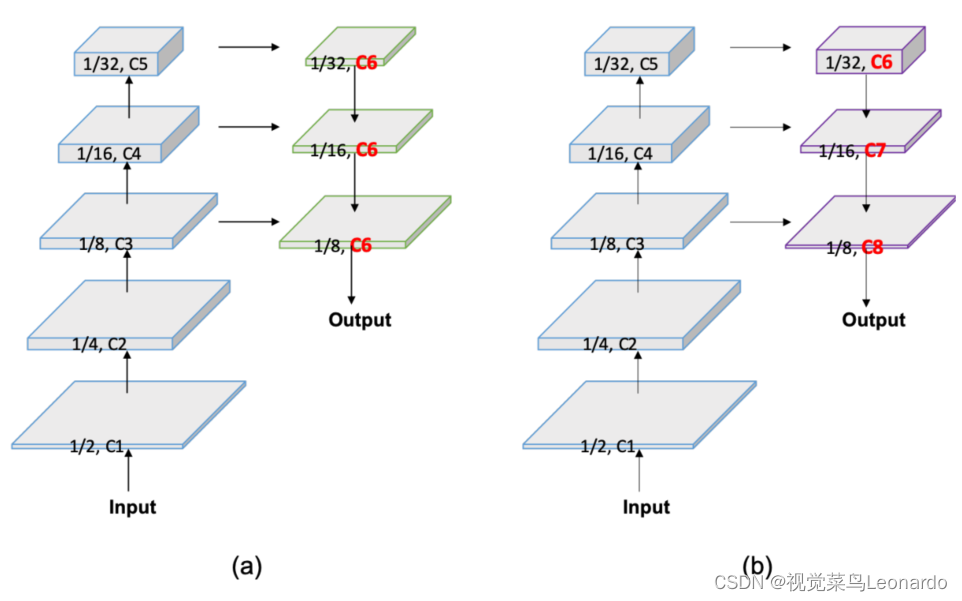

编码器通过分不同阶段来提取特征,通道数不断增加,特征空间不断减小,从而平衡了计算成本。现阶段出现的问题是前层的计算成本远大于深层的计算成本(特征通道相同,但特征大小远大于深层),提出一种新的解码器。图a为传统解码器,b为FLD解码器,FLD将解码器中浅层的特征通道数逐级减少。

统一注意力模块

之前的网络为了融合多级特征提出了很多种方法,其中还是以BiSeNet和DFANet为主的两种最为常见。

未看:SFNet、FaPN、AttaNet。

文章提出UAFM:

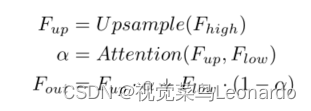

Fhigh代表更深层次的模块输出,Flow是编码器的对应物,首先将Fhigh进行上采样Up变为Fup,其次与Flow一起通过注意力模块(通道或空间),产生权重并各自相乘最后相加,得到新的特征图。即为等式:

空间注意力模块:利用空间关系来产生权重,代表输入特征中每个像素的重要性。

通道注意力模块:更注重通道上的特征,最哦后输出的为通道上的权重。

金字塔池化模块

SPPM:

PPM:

(感觉就是为了改而改)

网络架构

引用STDC中的5个stage,每个stage的stride是2,如图

stdc-1:

stdc-2:

stdc-2:

将SSLD方法应用于编码器的训练并获得增强的预训练权重,有利于分割训练的收敛。

效果:

466

466

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?