目录

我是新手一枚,欢迎友好讨论哦!

一、推理

1、基础用法

MMOCR推理器分为两类:MMOCRInferencer推理与标准推理器。

(1)MMOCRInferencer推理:提供了 MMOCRInferencer,一个专门为 MMOCR 设计的便捷推理接口。它封装了 MMOCR 中的所有推理器。

#需要用到的工具库

from mmocr.apis import MMOCRInferencer

# MMOCRInferencer模型初始化

ocr = MMOCRInferencer(det='DBNet', rec='SAR')

# 进行推理并可视化结果(由于远程服务器不支持图形化显示,则需要save_pred)

ocr('demo/demo_text_ocr.jpg',out_dir='output_ocr/', save_pred=True, save_vis=True)(2)标准推理器:MMOCR 中的每个基本任务都有一个标准推理器,即 TextDetInferencer(文本检测)(检测出文本所在区域),TextRecInferencer(文本识别)(下游任务),TextSpottingInferencer(端到端 OCR) 和 KIEInferencer(关键信息提取)。

from mmocr.apis import TextDetInferencer

# 读取模型(初始化)

inferencer = TextDetInferencer(model='DBNet')

# 推理

inferencer('demo/demo_text_ocr.jpg',out_dir='output_standard/', save_pred=True, save_vis=True)2、初始化

每个推理器必须使用一个模型进行初始化。初始化时,可以手动选择推理设备

000MMOCRInferencer 初始化

两个参数 xxx 和 xxx_weights,若使用预训练模型,则传模型的名字给det即可;同样可以传自定义的配置与权重

000标准推理器 初始化

标准的 Inferencer 都接受两个参数,model 和 weights。具体模型库见 model-index.yml文件

3、推理_输入&输出

MMOCRInferencer及其标准推理器

输入:可以是图像路径(如上面的示例代码即为单张图像)、图像的Numpy数组、目录的路径(目录中的所有图像都将被处理)

输出:默认情况下,每个推理器都以字典格式返回预测结果,具体见用户指南。

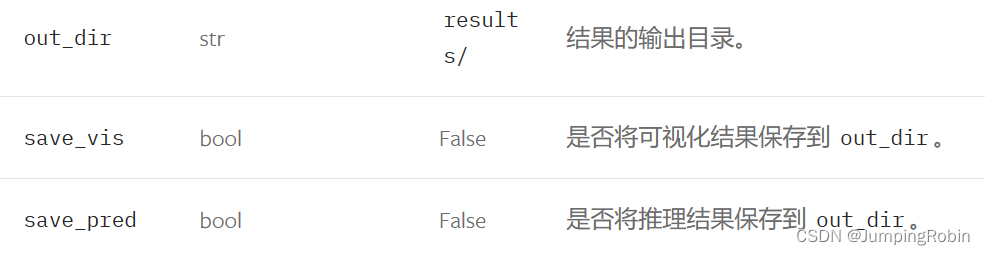

4、储存结果

除了从返回值中获取预测结果,你还可以通过设置 out_dir 和 save_pred/save_vis 参数将预测结果和可视化结果导出到文件中。可以通过设置 batch_size 来自定义批量推理的批大小。 默认批大小为 1(可选参数)

inferencer('img_1.jpg', out_dir='outputs/', save_pred=True, save_vis=True)

二、配置文件

这部分需要结合MMEngine的配置文件来进行学习 配置(Config) ‒ mmengine 0.10.3 文档

MMOCR 最常用的操作为三种:配置文件的继承,对 base 变量的引用以及对 base 变量的修改。MMOCR 所有配置文件都放置在 configs 文件夹下。同时各个任务算法配置文件夹下进一步划分为两个部分:base 文件夹与诸多算法文件夹

注册机制——(以dict字典为参数传递model所需的参数),注册器维护着模块的构建方式和它的名字之间的映射。下面是手动方式与注册机制方式

# 基于注册机制的例子

runner = Runner(model=dict(type='MyAwesomeModel',layers=50,activation='relu'),...)# 基于手动构建的例子

model = MyAwesomeModel(layers=18, activation='relu')

runner = Runner(model=model,...)1、配置文件读取

配置类能够支持不同格式的配置文件,包括 python,json,yaml,用户可以根据需求选择自己偏好的格式。配置类为三种类型提供了统一的接口 Config.fromfile(),来读取和解析配置文件。

from mmengine.config import Config

#读取.py类型的配置文件

cfg = Config.fromfile('learn_read_config.py')

print(cfg)2、配置文件的继承

本部分来自 MMEngine 配置文件

(1)继承机制概述

两个不同的配置文件之间的差异很小,可能仅仅只改了一个字段,我们就需要将所有内容复制粘贴一次。为了解决这个问题,配置文件增加了继承的机制,即一个配置文件 A 可以将另一个配置文件 B 作为自己的基础,直接继承了 B 中所有字段,而不必显式复制粘贴

_base_ 是配置文件的保留字段,指定了该配置文件的继承来源。支持继承多个文件,将同时获得这多个文件中的所有字段,但是要求继承的多个文件中没有相同名称的字段,否则会报错。

#optimizer_cfg.py:

optimizer = dict(type='SGD', lr=0.02, momentum=0.9, weight_decay=0.0001)#resnet50.py:

_base_ = ['optimizer_cfg.py']

model = dict(type='ResNet', depth=50)由于_base_中继承了上面的配置文件,则下面的配置文件中也会有optimizer字段

(2)修改继承字段

对继承文件个别字段进行修改时,只需要在新的配置文件中,重新定义一下需要修改的字段即可。对于非字典类型的字段,例如整数,字符串,列表等,重写即可完全覆盖。

_base_ = ['optimizer_cfg.py', 'runtime_cfg.py']

model = dict(type='ResNet', depth=50)

#使用 dict()函数 修改继承的配置文件

optimizer = dict(lr=0.01)(3)删除字典中的 key

有时候我们对于继承过来的字典类型字段,不仅仅是想修改其中某些 key,可能还需要删除其中的一些 key。这时候在重新定义这个字典时,需要指定 delete=True,表示将没有在新定义的字典中出现的 key 全部删除。

_base_ = ['optimizer_cfg.py', 'runtime_cfg.py']

model = dict(type='ResNet', depth=50)

optimizer = dict(_delete_=True, type='SGD', lr=0.01)

#则此时 optimizer 只剩 type 与 lr 两个参数(4)base 变量的引用

有时,我们可能需要直接引用 _base_ 配置中的某些字段,以避免重复定义。假设我们想要获取 _base_ 配置中的变量 pseudo,就可以直接通过_base_.pseudo 获得 _base_ 配置中的变量

_base_ = ['resnet50.py']

#利用 _base_.pseudo 方式来直接引用字段

#此时 a 变为当前配置文件中的 “新字段”

a = _base_.model

a.type = 'MobileNet'(5)配置文件的导出

在启动训练脚本时,用户可能通过传参的方式来修改配置文件的部分字段,提供了 dump 接口来导出更改后的配置文件,用户可以通过 cfg.dump('config.xxx') 来选择导出文件的格式(.yaml .json .py)

cfg = Config.fromfile('resnet50.py')

#导出更改后的配置文件

cfg.dump('resnet50_dump.py')三、数据集准备

需要进入mmocr工作目录 才能进行下面代码的执行

一键式准备脚本

MMOCR 提供了统一的一站式数据集准备脚本 prepare_dataset.py,仅需一行命令即可完成数据的下载、解压、格式转换,及基础配置的生成

python tools/dataset_converters/prepare_dataset.py [-h] [--nproc NPROC] [--task

{textdet,textrecog,textspotting,kie}] [--splits SPLITS [SPLITS ...]] [--lmdb]

[--overwrite-cfg] [--dataset-zoo-path DATASET_ZOO_PATH] datasets [datasets ...]

以 ICDAR 2015 数据集的文本检测任务准备步骤为例,可以执行以下命令来完成数据集准备:

#在Terminal执行以下命令

python tools/dataset_converters/prepare_dataset.py icdar2015 --task textdet数据集准备完成后,mmocr目录中data文件夹下应该存在以下目录:

四、Notebook教程

1、训练步骤

此部分来自于 Training SAR on a Toy Dataset 章节

1、转换成MMOCR支持的数据格式;

2、修改训练时的配置文件;

3、开始训练

以下为训练步骤示例,利用的是MMOCR附带的ToyDataSet,因此不需要转化数据格式

请注意,要将工作目录转移到mmocr才能执行以下代码(这里是SAR识别模型的训练)

import os

#训练时,都需要从mmengine.runner中import Runner库

from mmengine.runner import Runner

import time

from mmengine import Config

#用来 执行推理 与 可视化预测结果

from mmocr.apis import TextRecInferencer

##### 加载配置文件 #####

cfg = Config.fromfile('configs/textrecog/sar/sar_resnet31_parallel-decoder_5e_toy.py')

# 接下来对配置文件进行修改

#修改工作目录,这里只需要一个空的文件夹即可,日志等文件会自动保存

cfg.work_dir = 'work_dirs/sar_resnet31_parallel-decoder_5e_toy/'

# 配置 batch size, learning rate, and maximum epochs

cfg.optim_wrapper.optimizer.lr = 1e-3

cfg.train_dataloader.batch_size = 5

cfg.train_cfg.max_epochs = 100

# Save checkpoint every 10 epochs

cfg.default_hooks.checkpoint.interval = 10

# We don't need any learning rate scheduler fosetr a toy data

cfg.param_scheduler = None

# Set seed thus the results are more reproducible

cfg.randomness = dict(seed=0)

# We can initialize the logger for training and have a look

# at the final config used for training

# 打印出最终的配置文件

print(f'Config:\n{cfg.pretty_text}')

##### 开始训练 #####

# Optionally, give visualizer a unique name to avoid dupliate instance being

# created in multiple runs

# 给visualizer重命名为当前的时间(可选)

cfg.visualizer.name = f'{time.localtime()}'

#利用修改后的cfg配置文件进行训练

runner = Runner.from_cfg(cfg)

runner.train()

#训练模型后 利用改动过的配置文件 cfg_file 与 权重文件 checkpoint 进行测试

img = 'tests/data/rec_toy_dataset/imgs/1036169.jpg'

checkpoint = "work_dirs/sar_resnet31_parallel-decoder_5e_toy/epoch_100.pth"

cfg_file = "configs/textrecog/sar/sar_resnet31_parallel-decoder_5e_toy.py"

#利用到第一节提到的 标准推理器

#cfg_file--模型 checkpoint--权重

infer = TextRecInferencer(cfg_file, checkpoint)

#将推理后的图片可视化

result = infer(img, out_dir='output_0127/', save_pred=True, save_vis=True,return_vis=True)

#打印推理的结果

print(f'result: {result["predictions"]}' )2、测试步骤

此部分来自 Evaluating SAR 章节

1、转换成MMOCR支持的数据格式;

2、修改测试时的配置文件

3、开始测试

from mmengine.runner import Runner

import time

##### 修改测试时的配置文件 #####

# The location of pretrained weight

# 将配置文件中的“load_from”字段修改为刚刚的checkpoint

# 这一步非常重要 将权重文件进行加载

cfg['load_from'] = 'work_dirs/sar_resnet31_parallel-decoder_5e_toy/epoch_100.pth'

# Optionally, give visualizer a unique name to avoid dupliate instance being

# created in multiple runs

cfg.visualizer.name = f'{time.localtime()}'

##### 开始测试 #####

#测试时将 train 改为 test 即可

runner = Runner.from_cfg(cfg)

runner.test()%下载、训练与测试IIIT5K数据集实录

本部分仅作参考,按照我以下的配置,loss的极限似乎是3.5左右(笑哭

1、下载IIIT5K数据集

python tools/dataset_converters/prepare_dataset.py iiit5k --task textrecog

#IIIT5K数据集准备完成若下载失败,也可以通过下载到本地再上传的方式进行数据集的准备。

2、重写配置文件

随机选取CRNN模型,在 config 目录下,找到 textrecog 文件夹下的 CRNN 文件夹,新建crnn_iiit5k.py 文件作为IIIT5K数据集训练时的配置文件。如“配置文件的继承”章节所述,_base_[...] 为本文件所继承的配置文件。

##### 尝试写配置文件 #####

#_base_ 继承文件仿照 _5e_toy 进行构造

_base_ = [

'../_base_/default_runtime.py',

'../_base_/datasets/iiit5k.py',

'../_base_/schedules/schedule_adadelta_5e.py',

'_base_crnn_mini-vgg.py',

]剩余部分配置需要修改数据集地址与数据集字段,由于IIIT5K数据集是MMOCR支持的数据集,在内置的../_base_/datasets/iiit5k.py

#去'../_base_/datasets/iiit5k.py'文件中寻找对应的字段名称

train_list = [_base_.iiit5k_textrecog_train]

test_list = [_base_.iiit5k_textrecog_test]

default_hooks = dict(logger=dict(type='LoggerHook', interval=50), )

train_dataloader = dict(

batch_size=64,

num_workers=8,

persistent_workers=True,

sampler=dict(type='DefaultSampler', shuffle=True),

dataset=dict(

type='ConcatDataset',

datasets=train_list,

pipeline=_base_.train_pipeline))

val_dataloader = dict(

batch_size=1,

num_workers=4,

persistent_workers=True,

drop_last=False,

sampler=dict(type='DefaultSampler', shuffle=False),

dataset=dict(

type='ConcatDataset',

datasets=test_list,

pipeline=_base_.test_pipeline))

test_dataloader = val_dataloader

_base_.model.decoder.dictionary.update(

dict(with_unknown=True, unknown_token=None))

_base_.train_cfg.update(dict(max_epochs=200, val_interval=10))

val_evaluator = dict(dataset_prefixes=['IIIT5K'])

test_evaluator = val_evaluator3、新建工作目录

在 work-dir 工作目录下新建一个同名的 crnn_iiit5k/ 文件夹,并在 cfg.work-dir 字段中进行设置

#修改工作目录

cfg.work_dir='work_dirs/crnn_iiit5k/'进行上述部署后,模型即可训练与测试啦!

"Notebook教程"中有训练与测试示例,故此处不再赘述。

5438

5438

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?