摘要

在本文中,作者提出了一种新颖的深度神经网络Fast and Furious(FaF),该网络能够针对3D传感器捕获的给定数据共同推理3D检测,跟踪和运动预测。通过共同推理这些任务,FaF的整体方法在遮挡和稀疏范围内的数据方面更加强大。FaF在鸟瞰3D世界的情况下跨时空执行3D卷积,这在存储和计算方面都非常有效。FaF对在几个北美城市中捕获的超大规模新数据集的实验表明,大大超越最新技术。重要的是,通过共享计算,FaF可以在30毫秒之内执行所有任务。

论文链接:http://openaccess.thecvf.com/content_cvpr_2018/papers/Luo_Fast_and_Furious_CVPR_2018_paper.pdf

主要贡献

在本文中,作者提出了一种端到端全卷积方法FaF,该方法通过利用3D传感器捕获的时空信息来执行同时3D检测,跟踪和运动预测。作者认为这很重要,因为跟踪和预测可以帮助对象检测。例如,利用跟踪和预测信息可以减少检测误报。

FaF的方法的主要贡献概述:

1、 FaF网络将多个帧作为输入并执行检测,跟踪和运动预测。当处理被遮挡或远离的物体时。通过随着时间的推移积累证据,也可以减少误报。

2、 FaF网络非常高效,因为它在所有这些任务之间共享计算。这对于延迟可能致命的自动驾驶极为重要。

3、 作者利用3D传感器的优势,并设计了可在BEV上运行的网络。这种表示尊重传感器数据的3D性质,由于网络可以利用有关对象典型大小的先验知识,因此学习过程更加轻松。

4、 FaF是一种单阶段检测器,该检测器将从多个连续的时间帧创建的4D张量作为输入,并在空间和时间上执行3D卷积以提取准确的3D边界框。FaF不仅在当前帧产生边界框,还在未来产生多个时间戳。作者通过简单的合并来自过去和当前预测解码tracklet。

5、 在从北美驾驶的多辆车辆捕获的超大规模数据集上证明了FaF模型的有效性,并表明FaF明显优于最新技术。此外,所有任务只需30毫秒。

算法框架:

在这项工作中,作者专注于通过利用产生3D点云的传感器来检测物体。为了实现这一目标,作者开发了一种单级检测器,该检测器将多个帧作为输入,并对物体的轨迹进行检测,跟踪和短期运动预测,直至未来。FaF输入表示是一个4D张量,它在几个时间帧上编码3D空间占用网格的情况。通过利用空间和时间上的3D卷积来产生快速而准确的预测。由于点云数据在3D空间中固有地稀疏,因此与在3D空间和时间上进行4D卷积相比,该方法节省了很多计算量。作者将方法命名为“速度与激情(FaF)”,因为它能够在30秒钟内得出非常准确的估算。

1、 数据参数化

首先描述世界的单帧表示。然后扩展表示以利用多个框架。

体素表示:与输入为密集RGB图像的图像检测相反,点云数据固有地稀疏并且提供有关3D场景的几何信息。为了获得可以轻松应用卷积的表示形式,作者对3D世界进行量化以形成3D体素网格。然后为每个体素编码分配一个二进制指示器,以指示体素是否被占用。如果体素的3D空间中至少存在一个点,则该体素将被占用。由于网格是规则网格,因此可以直接使用卷积。作者执行了2D卷积并将高度尺寸视为通道尺寸。这允许网络学习提取高度维度中的信息。如果网格的分辨率很高,FaF就相当于在不损失任何信息的情况下对每个点进行卷积。请参考图2,以了解如何根据3D点云数据构造3D张量。

图2:体素表示法:直接使用高度作为输入特征。

添加时间信息:为了执行运动预测,考虑时间信息至关重要。为了实现这一目标,FaF从过去的n帧中获取所有3D点,并执行坐标更改以表示当前的车辆坐标系。目的是抵消安装传感器的车辆的自我运动。之后为每个帧计算体素表示。最后,每个帧都表示为3D张量,沿新的时间维度附加多个帧以创建4D张量。这样不仅可以提供更多的3D点,还可以提供有关车辆航向和速度的线索,进而能够进行运动预测。如图3所示,叠加了多帧,静态对象对齐良好,而动态对象具有表示其运动的“阴影”。

图3:叠加的时间和运动预测数据。 绿色:带有3D点的bbox。 灰色:不带3D点的bbox

2、 创建模型

FaF采用4D输入张量,并在不使用区域建议的情况下,在不同的时间戳直接回归到对象边界框。作者研究了两种不同的方法来利用4D张量上的时间维度:早期融合和晚期融合。它们代表了准确性和效率之间的权衡,并且在汇总时间维度的级别上有所不同。

早期融合:第一种方法在第一层汇总时间信息。结果,它的运行速度与使用单帧检测器一样快。但是,它可能缺乏捕获复杂的时间特征的能力。如图4所示,在给定4D输入张量的情况下,首先在时间维度上使用内核大小为n的一维卷积将时间维度从n减少到1。所有特征图之间共享权重,即也称为分组卷积。然后,作者在VGG16之后执行卷积和最大池化,将特征图的每一层数量减少一半。需要注意的是,作者删除了VGG16中的最后一个卷积组,仅得到10个卷积层。

后期融合:此时逐渐合并时间信息。这使模型可以捕获高级运动特征。使用与早期融合模型中相同数量的卷积层和特征图,但执行两次内核大小为3×3×3的3D卷积,而无需填充时间维,这将时间维从n减少到1然后对其他层执行3D内核大小为2的2D空间卷积。参考图4。

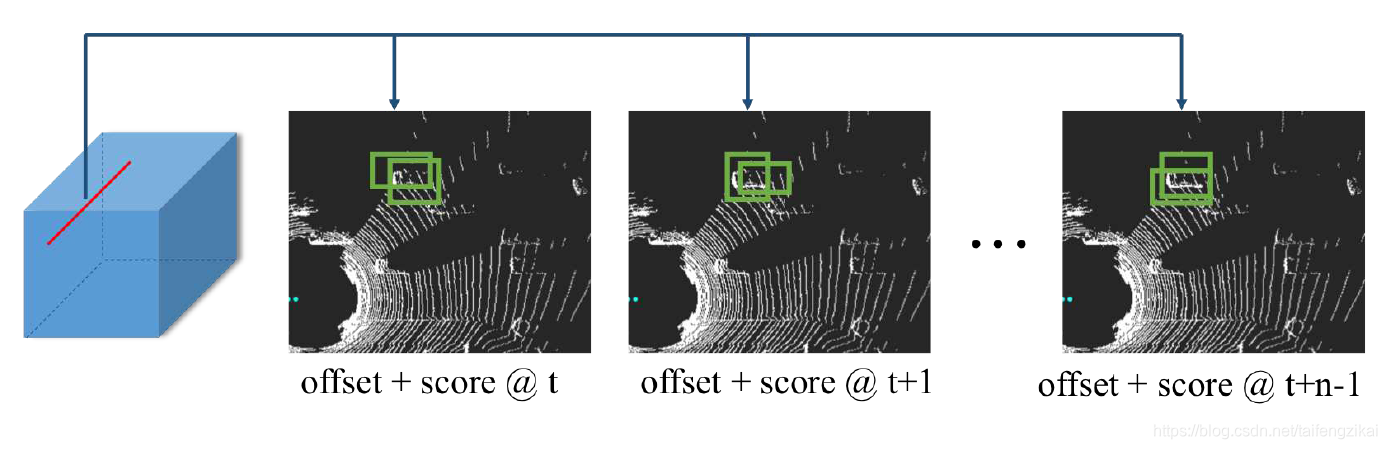

图5:运动预测

然后,添加两个卷积层分支,如图5所示。第一个分支执行二进制分类以预测成为车辆的可能性。第二个预测当前帧以及将来的n-1个帧的边界框。由于FaF利用多个帧作为输入,因此可以进行运动预测,从而可以学习估计有用的特征,例如速度和加速度。

解码Tracklet:在每个时间戳上,FaF模型输出n个时间戳的检测边界框。因此,每个时间戳将具有当前检测以及n-1个过去的预测。可以通过汇总过去的信息来生成准确的小轨迹,而无需解决任何基于轨迹的优化问题。请注意,如果检测和运动预测是完美的,可以解码完美的小轨迹。

3、 损失函数与训练

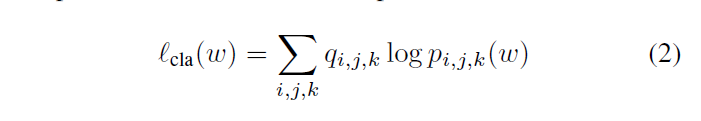

训练网络以最小化分类和回归损失的组合。在回归的情况下,既包括当前帧,也包括我们未来的n个帧。那是:

将在所有位置和预定义框上计算的二进制交叉熵用作分类损失:

将回归目标定义为

在所有回归目标上使用加权smooth L1 loss,其函数为:

主要结果:

作者收集了一个非常大规模的数据集以对FaF进行基准测试。它比KITTI等数据集大2个数量级。作者将模型与最先进的实时检测器(包括SSD,MobileNet和SqueezeNet)进行了比较。为了使它们更具竞争力,作者还将预定义的box内置到它们的系统中,从而进一步简化了这些探测器的任务。

在推理期间,以ego-car为中心的关注区域为144×80M。我们对所有模型保持相同的体素化,并针对真实边界框评估检测结果。如果它对任何真实边界框有大于0.7的IoU,则我们认为检测正确。请注意,对于典型尺寸为3.5×6米的车辆,0.7 IoU意味着我们最多在宽度上错过0.35米,在长度上错过0.6米。表1显示了使用不同IoU阈值的mAP。可以看到FaF能够胜过所有其他方法。尤其是在IoU 0.7的情况下,在类似的运行时间下,FaF的mAP比MobileNet高出4.7%,但速度要快两倍,比SSD高出5.2%。

表1:在144×80米区域上的检测性能。

消融研究:在框架内进行实验,以展示每个组件的重要性。我们修复了所有实验的培训设置。如表2所示,将时间信息与早期融合一起使用可使IoU 0.7的mAP提高3.7%。尽管后期融合使用的信息与早期融合相同,但由于它可以对更复杂的时间特征建模,因此可以额外提高1.4%。此外,增加预测损失仅在当前帧上即可提供相似的检测结果,但是,它能够解码轨迹,并提供证据来输出更平滑的检测结果,从而提供最佳性能,即在IoU 0.7的mAP上比单帧检测器高6%。

表2:消融研究

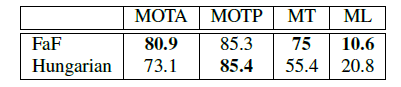

跟踪结果:模型能够直接输出带有跟踪ID的检测结果。评估原始跟踪输出,而不在顶部添加任何复杂的跟踪策略。表3在检测结果的基础上,显示了模型输出与匈牙利方法之间的比较。我们遵循KITTI协议,并在所有100个验证序列中计算MOTA,MOTP,大多数跟踪(MT)和大多数丢失(ML)。可以看到FaF在MOTA中达到了80.9%,比匈牙利提高了7.8%,在MT上提高了20%,在ML上降低了10%,而MOTP仍然相似。

表3:跟踪性能

提出了一种名为FastandFurious(FaF)的深度神经网络,该网络能在30毫秒内同时执行3D检测、跟踪和运动预测,尤其在遮挡和稀疏数据情况下表现优异。FaF在鸟瞰视角下进行3D卷积,利用多帧输入提升精度,并在超大规模数据集上验证了其超越现有技术的性能。

提出了一种名为FastandFurious(FaF)的深度神经网络,该网络能在30毫秒内同时执行3D检测、跟踪和运动预测,尤其在遮挡和稀疏数据情况下表现优异。FaF在鸟瞰视角下进行3D卷积,利用多帧输入提升精度,并在超大规模数据集上验证了其超越现有技术的性能。

745

745

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?