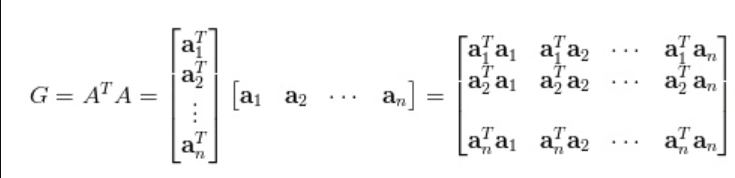

Gram matrix 度量各个维度自己的特性以及各个维度之间的关系。

来自:https://www.zhihu.com/question/49805962?from=profile_question_card

由感知机(对偶感知机中需要计算样本点两两之间的内积和,并进行存储,这样想到的方式是Gram矩阵)因此,想了解什么是Gram matrix

老办法:知乎—>Google—>Papers

知乎:Gram matrix

度量各个维度自己的特性以及各个维度之间的关系。

当同一个维度上面的值相乘的时候原来越小就变得更小,原来越大就变得越大;二不同维度上的关系也在相乘的表达当中表示出来。

即通过相乘运算,它将特征之间的区别进行扩大或者缩小,主要在图像处理中应用。

Gram Matrix实际上可看做是feature之间的偏心协方差矩阵(即没有减去均值的协方差矩阵)

Google:

Gram矩阵的每个值代表i通道的feature map与j通道的feature map之间的互相关程度。

Gram矩阵和卷积网络中的卷积的差别

Gram矩阵是计算每个通道i的feature map与每个通道j的feature map的内积。自然就会得到C*C的矩阵。Gram矩阵的每个值可以说是代表i通道的feature map与j通道的feature map的互相关程度。而卷积网络的卷积其实也是互相关,具体情况见CNN基本问题 中的

卷积到底是如何卷积的??。 值得注意的是:卷积网络的卷积和互相关是一样的,不是信号处理中所说的要先将卷积核旋转180再计算。这句话没懂(这里只是强调互相关?),留着看到卷积网络的时候回来看

7415

7415

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?