Elu激活函数论文:https://arxiv.org/pdf/1511.07289v5.pdf

论文理解:https://blog.csdn.net/mao_xiao_feng/article/details/53242235?locationNum=9&fps=1

https://blog.csdn.net/m0_37561765/article/details/78398098

https://blog.csdn.net/u012524708/article/details/79579313

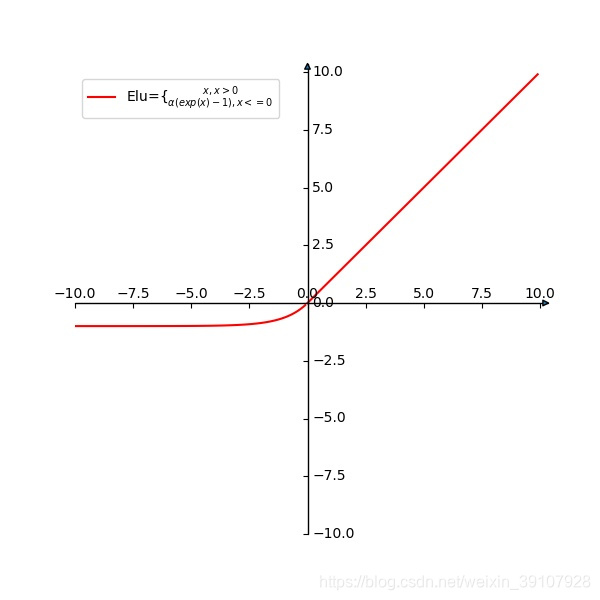

Elu函数融合了sigmoid和ReLU,左侧具有软饱和性,右侧无饱和性。右侧线性部分使得ELU能够缓解梯度消失,而左侧软饱能够让ELU对输入变化或噪声更鲁棒。ELU的输出均值接近于零,所以收敛速度更快。在 ImageNet上,不加 Batch Normalization 30 层以上的 ReLU 网络会无法收敛,PReLU网络在MSRA的Fan-in (caffe )初始化下会发散,而 ELU 网络在Fan-in/Fan-out下都能收敛。

python画激活函数

参考:https://blog.csdn.net/Xin_101/article/details/93738819

(threshold、sigmoid、Relu、PRelu、tanh)

Elu函数

import matplotlib.pyplot as plt

import mpl_toolkits.axisartist as axisartist

import numpy as np

import math

fig = plt.figure(figsize=(6, 6))

ax = axisartist.Subplot(fig, 111)

fig.add_axes(ax)

# 隐藏坐标轴

ax.axis[:].set_visible(False)

# 添加坐标轴

ax.axi

ELU(Exponential Linear Units)激活函数结合了sigmoid和ReLU的优点,能缓解梯度消失并提高对输入变化的鲁棒性。其在深度学习中表现出更好的收敛性能,特别是在ImageNet上的实验表明,相比于ReLU和PReLU,ELU在网络不使用Batch Normalization时也能稳定收敛。本文将探讨ELU的特性,并提供Python绘图示例。

ELU(Exponential Linear Units)激活函数结合了sigmoid和ReLU的优点,能缓解梯度消失并提高对输入变化的鲁棒性。其在深度学习中表现出更好的收敛性能,特别是在ImageNet上的实验表明,相比于ReLU和PReLU,ELU在网络不使用Batch Normalization时也能稳定收敛。本文将探讨ELU的特性,并提供Python绘图示例。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?