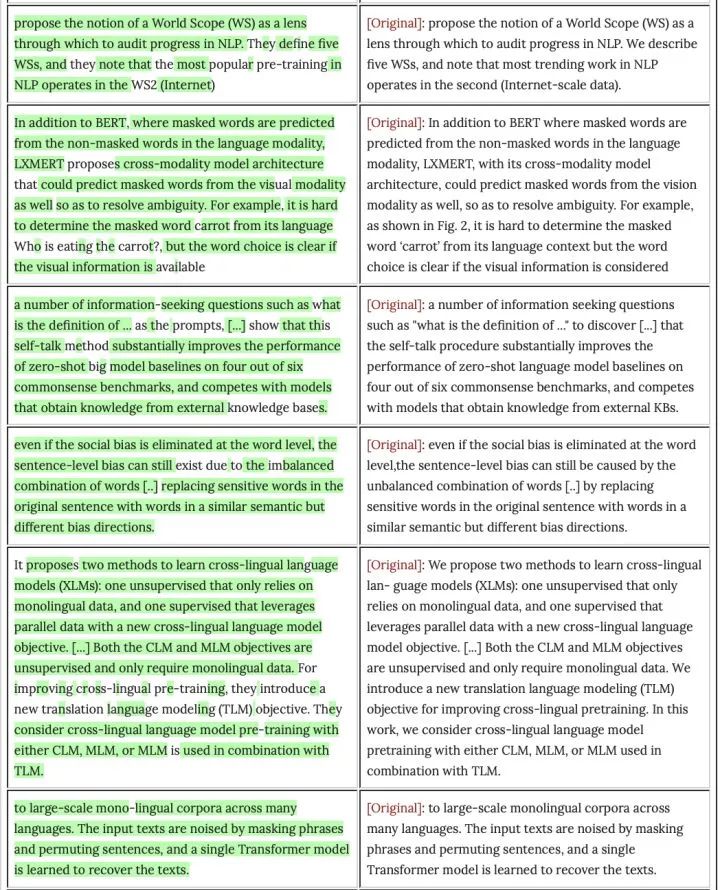

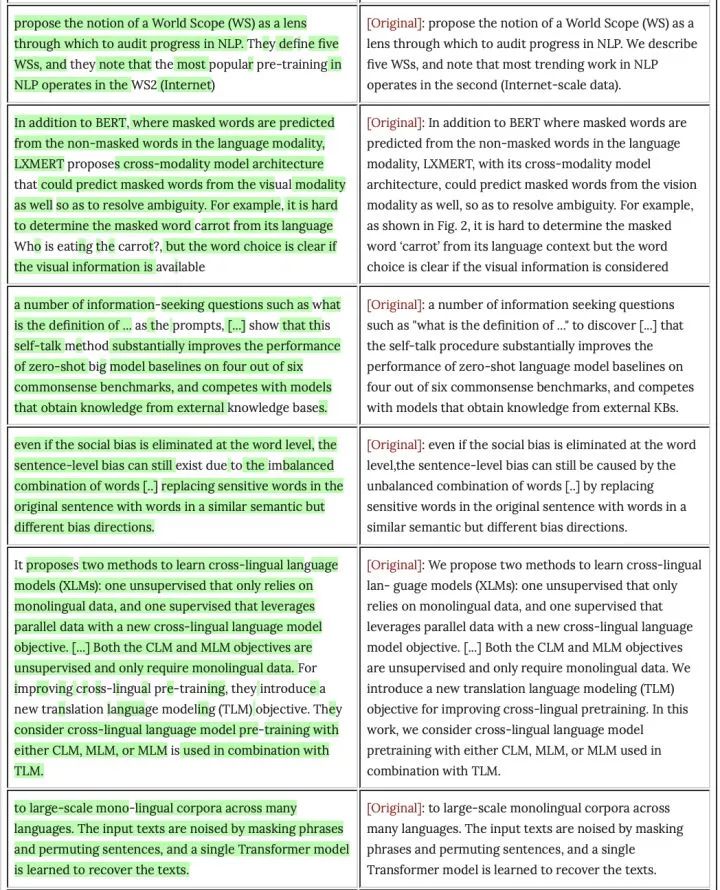

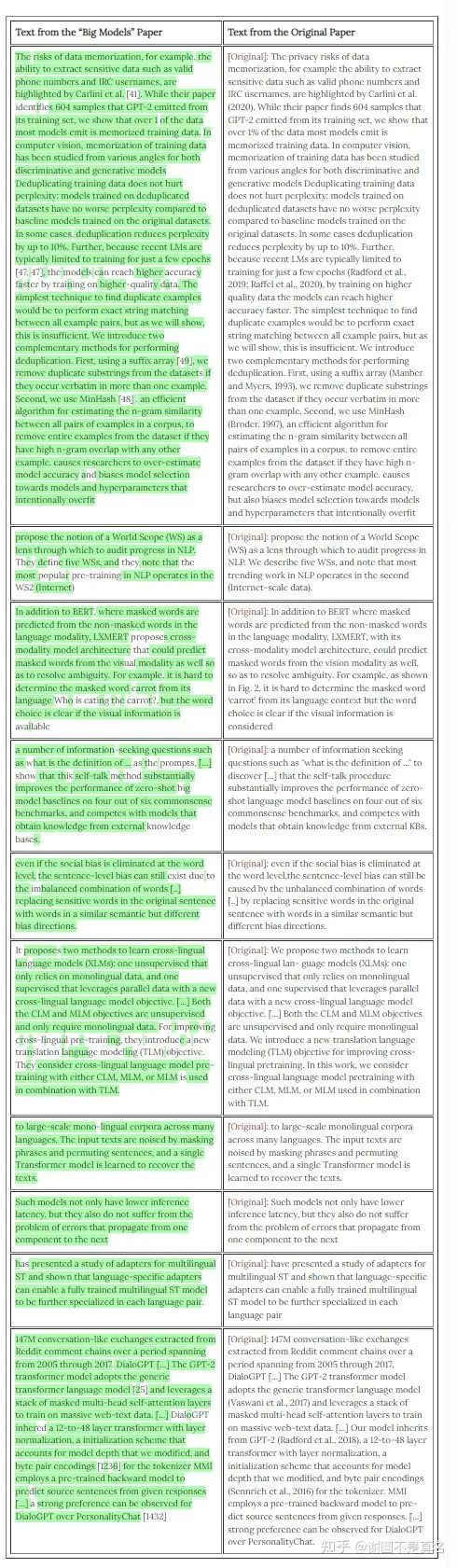

Google Brain研究员Nicholas Carlini近日在一篇博客中指出智源、清华等单位的论文A Roadmap for Big Model中部分段落抄袭了他们的论文Deduplicating Training Data Makes Language Models Better。同时他指出,A Roadmap for Big Model可能同时抄袭了十余篇其他论文。Nicholas Carlini展示了一些抄袭Deduplicating Training Data Makes Language Models Better的片段,抄袭部分用绿色高亮。

北京智源人工智能研究院回答:

关于“A Roadmap for Big Model”综述报告问题的致歉信

今天我们从互联网上获悉,智源研究院在预印本网站arXiv发布的综述报告“A Roadmap for Big Model”(大模型路线图)涉嫌抄袭。对这一情况,研究院立即组织内部调查,确认部分文章存在问题后,已启动邀请第三方专家开展独立审查,并进行相关追责。

对于这一问题的发生,我们深感愧疚。智源研究院作为一家科研机构,高度重视学术规范,鼓励学术创新和学术交流,对学术不端零容忍。在此,我们向相关原文作者和学术界、产业界的同仁和朋友表示诚挚的道歉。

智源研究院内部调查的初步结果如下:

1. 该报告是一篇大模型领域的综述,希望尽可能涵盖国内外该领域的所有重要文献,由智源研究院牵头,负责框架设计和稿件汇总,并邀请国内外100位科研人员分别撰写了16篇独立的专题文章,每篇文章分别邀请了一组作者撰写并单独署名,共200页。报告发布后,根据反馈持续进行修改完善,到4月2日在arXiv网站上已经更新到第三版。

2. 4月13日,我们获悉谷歌研究员Nicholas Carlini在个人博客上指出该报告抄袭了他们论文的数个段落,同时还有其他段落和语句抄袭其他论文。我们对此进行了逐项核查,经查重确认第2篇文章的第3.1节179个词,第8篇文章的第3.1节74个词、第12篇文章的第2.3节55个词、第14篇文章的第2节159个词、第16篇文章的第1节146个词与其他论文重复,应属抄袭。我们决定立即从报告中删除相应内容,报告修订版今天将提交arXiv进行更新。目前已通知所有文章的作者对所有内容进行全面审查,后续经严格审核后再发布新版本。

3. 智源作为该报告的组织者,理应对各篇文章的所有内容进行严格审核,出现这样的问题难辞其咎。对此我们深感自责,特别感谢学术界和媒体的朋友们帮助我们发现问题。我们将深刻吸取教训,整改科研管理和论文发表流程,希望各界朋友监督我们工作。

下一步,智源研究院将以此为戒,采取切实措施,加强科研诚信与学风建设:

(一)即日启动邀请第三方专家对报告进行独立审查,根据正式调查结果对相关责任人作出问责处理。

(二)进一步完善制度管理,通过更加严格的审核机制和更加明确的惩戒措施,对研究院内部以及支持的科研人员加强学风教育,防范同类事件的再次发生。

欢迎各界朋友今后持续严格地监督我们的工作,并对我们工作中可能存在的疏漏和不足加以批评和指正。

谢圜不是真名(伦敦玛丽皇后大学 音乐人工智能博士在读)回答:

Update 2:人在欧洲时区,一觉醒来知乎消息已经炸了。我身处在AI圈子里,作者列表里有一些人是我尊敬和熟悉的老师,我也follow过智源发表的不少工作。平心而论,智源里面的很多老师都是对AI学界有着推动的中坚力量,我也发自内心地相信他们有极高的学术操守。因此,我这篇回答的初衷并不是指责和诋毁智源社区的老师们;对我来说,这也是端正我个人学术态度的又一个警示。

智源的最新回应如下,态度其实已经很好了。

看到原作者Nicholas Carlini更新了一段评论:

[Update 4/12: This article has received a lot more attention than I expected. (Context: every hour more people visit this page than viewed my entire website last week.) So a plea: let's not turn this into a witch hunt. I've seen some people say things like this should result in immediate dismissal of all those involved / people should be banned from arXiv / etc. I don't pretend to know the situation that resulted in this paper having copied from so many sources. Without knowing what happened behind the scenes, I'd like to refrain passing judgement. Maybe some junior authors meant well and thought that a citation was enough to then copy text. Maybe there was pressure from above that made some students feel like their only choice to deliver on time was to cut corners. For the part of the senior authors, they may have read over the text and thought that it looked perfectly reasonable and only made a few tweaks to the text here and there without being aware of where it came from. The point is we don't know. With 100 authors on this paper anything could have happened.

[4月12日更新:这篇文章受到的关注比我预期的多得多。(背景:每小时访问这个网页的人比上周浏览我整个网站的人还多)。所以恳请大家:不要把这变成一场猎巫行动。我看到一些人说,像这样的事情应该导致所有相关人员立即被解雇/人们应该被禁止进入arXiv/等等。我并不假装知道导致这篇论文从这么多来源抄袭的情况。在不知道幕后发生了什么的情况下,我不想做出判断。也许一些初级作者本意是好的,认为有了引文就可以复制文字了。也许上面有压力,让一些学生觉得要按时交稿,唯一的选择就是偷工减料。对于资深作者来说,他们可能读了一遍文本,认为它看起来非常合理,只是在这里和那里对文本做了一些调整,而没有意识到它的来源。关键是我们不知道。这篇论文有100位作者,任何事情都有可能发生。

My hope with this post was just to draw some attention to something that I've seen happen not infrequently. For example, roughly 1% of published-and-accepted papers have a higher data-copying-fraction than this paper. I should have given this context when I wrote this post initially. So, again, please let's not come down to harshly on this paper in particular. This is a problem I've noticed with the field in general, this case was just the tipping point for me because it was a paper of mine where this happened. Hopefully we can treat this as a learning experience to improve the field as a whole. With that out of the way, back to your regularly scheduled programming...]

我发这个帖子的目的只是想让大家注意一些我见过的不常发生的事情。例如,大约有1%的已发表和接受的论文的数据复制率比这篇论文高。我应该在最初写这篇文章的时候给出这个背景。所以,请大家不要对这篇论文过于苛责。这是我注意到的这个领域的普遍问题,这个案例对我来说只是一个转折点,因为这是我的一篇论文发生的情况。希望我们能把这当作一个学习的经验,以改善整个领域的情况。话不多说,回到你们正常的安排上来。]

我统计了一下原文提及的涉嫌抄袭段落出现的地方:2.3.1,2.4.3,8.3.1,10.2,12.2.3,14.2.2……

我震惊地发现,这不是某一处集中出现了抄袭嫌疑,跨度这么大的涉嫌抄袭行为,绝对不止涉及个别作者!

现在推特的相关讨论让人真心感慨……ViT作者Lucas Beyer毫不留情地说,“我也不确定我会相信一个剽窃团体的声明;在约130pg的内容中,有10个抄袭的区块,来自约100个作者。”

如果这类综述大文章是分工完成的,那可想而知,这个学术环境和学术严谨性令人头皮发麻;

如果这篇文章是一个团队学生的结果,最后却挂上了不同团队的名字(是的,我曾见过这样的文章,而且是一个更可能的解释),那不过是从一类学术不端跳到另一类学术不端罢了。

学术声誉的建立是一辈子的事情,然而要推倒只需要一瞬间。

之前一些学术不端的工作中,其实有很多大佬讨论过关于论文署名的问题。原则上来说,一篇文章的所有署名人员必须:

(1)对研究工作的思路或设计有重要贡献,或者为研究获取、分析或解释数据;

(2)起草研究论文或者在重要的智力性内容上对论文进行修改;

(3)对将要发表的版本作最终定稿;

(4)同意对研究工作的各个方面承担责任以确保与论文任何部分的准确性或诚信有关的问题得到恰当的调查和解决。

也就是说,涉及到学术不端的论文,其所有署名的作者都负有责任(这类分工式的综述类大文章可能比较特别,但每章的那些作者是跑不了的)。一开始轻飘飘把名字挂上,后面把自己的责任摘出去的回应是不被允许的。

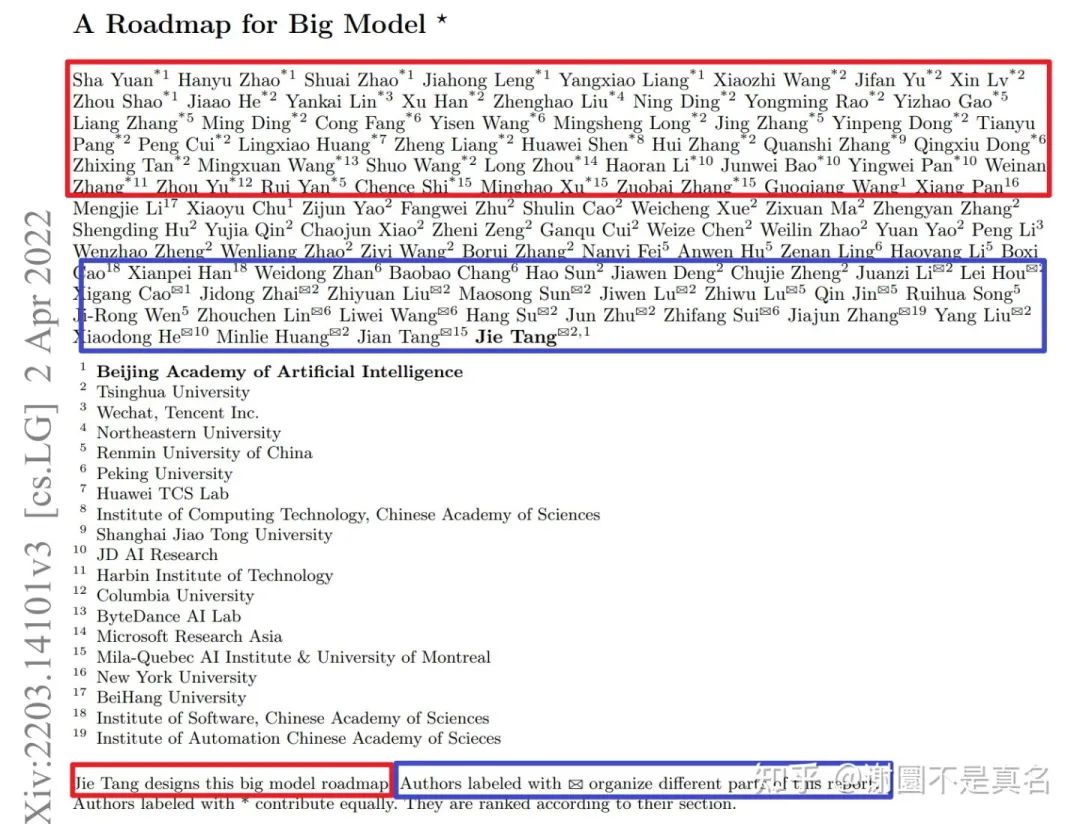

讲道理,100多个名字的论文就很离谱。看看这篇文章:

虽然我也见过共同一作很多的文章,但……快一半的人都是共同一作,还有1/4的人是共同通讯,我真的是第一次见到。可能这就是大模型需要的大社群吧。

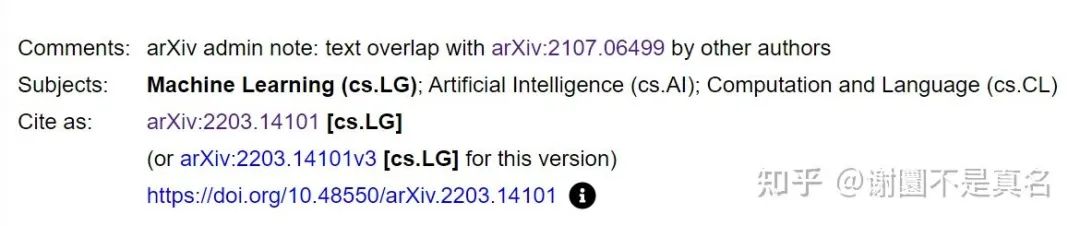

现在这篇文章因为这样可悲的错误,被Google Brain的研究员一通捶,而且arxiv的页面下面已经添加了文字重合的警示,想必这篇文章在纯学术上的影响力会跌得很严重(毕竟大家都希望引用更具代表性的原创工作),失去了这篇文章本来应有的地位和意义。

学术声誉对于一家学术机构来说还是很重要的。预测一下智源后面的反映:

在arxiv上撤稿,后续找时间重新提交修改后的版本。(概率几乎100%)

机构公开道歉。(概率10%)

一些作者以个人身份道歉。(概率80%)

然后当这事没发生过。(概率90%)

推特讨论节选:

滑铁卢大学教授:即使这篇多作者的论文有分工,我对没有一个人注意到并采取措施纠正这一点感到吃惊。

ViT作者:他们大概会推一个作者出来背锅。(临时工再显神威?)

我不确定会相信一个剽窃团体的声明。在约130页的内容中,有10个区域被抄袭。

每个人都乐于分享多作者论文的功劳/引文--但当涉及到责任时,也会分享吗?应该吗?

把原文翻译过来:

I recently came to be aware of a case of plagiarism in the machine learning research space. The paper A Roadmap for Big Model plagiarized several paragraphs from one of my recent papers Deduplicating Training Data Makes Language Models Better. (There is some irony in the fact that the Big Models paper copies from a paper about data copying. This irony was not lost on us.) This is unfortunate, but to my dismay, our paper was not the only paper copied from: the Big Models paper copied from at least a dozen other papers.

我最近意识到了机器学习研究领域的一个抄袭案例。A Roadmap for Big Model这篇论文抄袭了我最近的一篇论文中的几个段落,即重复训练数据使语言模型更好。(大模型的论文抄袭了一篇关于数据复制的论文,这有一些讽刺意味。这种讽刺对我们来说并不陌生)。这是不幸的,但令我沮丧的是,我们的论文并不是唯一被抄袭的论文:Big Models的论文至少抄袭了其他十几篇论文。

In the grand scheme of things, this particular form of copying isn’t the worst thing ever. It’s not like a paper has directly copied the method of a prior result and claimed it as its own. But even putting aside the fact that claiming someone else's writing as one's own is wrong, the value in survey papers is in how they re-frame the field. A survey paper that just copies directly from the prior paper hasn't contributed anything new to the field that couldn't be obtained from a list of references.

从总体上看,这种特殊形式的抄袭并不是最糟糕的事情。这并不像一篇论文直接抄袭先前的结果的方法,并声称它是自己的。但是,即使抛开把别人的文章说成是自己的文章是错误的这一事实,调查报告的价值在于它们如何重新构筑这个领域。一篇只是直接抄袭前一篇论文的调查报告并没有对该领域做出任何新的贡献,而这是无法从参考文献列表中获得的。

(Please note the Big Models paper has a hundred authors. Likely only a few of the authors have participated in this copying. Misconduct by a small fraction of the authors should not be held against the majority of well-behaving authors.)

(请注意,《大模型》论文有一百个作者。很可能只有少数作者参与了这种抄袭。一小部分作者的不当行为不应该被用来指责大多数行为良好的作者)。

See below for a few of the more egregious examples of this, with text from the Big Models paper on the left and the corresponding text from the original paper on the right. Copied text is highlighted in green.

下面是几个比较恶劣的例子,左边是大模型论文的文字,右边是原始论文的相应文字。复制的文字以绿色标出。

One of my coauthors was reading the Big Models paper and noticed that some of the text seemed oddly familiar, and after quickly looking things over we found that in fact a bunch of the text was directly copied from our paper.

我的一位合作者在阅读《大模型》的论文时,注意到其中的一些文字似乎很奇怪,在快速查看之后,我们发现事实上有一堆文字是直接从我们的论文中复制的。

Given that this happened to us, we then set out to see if there were other examples too. As part of a prior project, I had collected a dataset of PDFs for (almost) every accepted paper at top machine learning venues (ICML/ICLR/NeurIPS/AAAI/ACL/etc). So all I did to find the above copied text was to take these PDFs, extract out all of the text and dump it into a single .txt file, and then run our dataset deduplication tools (that we developed for the paper that was copied from!) to find all repeated sequences that were contained both in the Big Models paper along with some other prior publication. To rule out false positives, I only considered sequences of

鉴于这种情况发生在我们身上,我们就着手看看是否也有其他的例子。作为之前一个项目的一部分,我收集了一个数据集,其中包括顶级机器学习场所(ICML/ICLR/NeurIPS/AAAI/ACL/等)接受的每篇论文的PDF文件。因此,为了找到上述复制的文本,我所做的就是把这些PDF文件提取出来,把所有的文本转储到一个.txt文件中,然后运行我们的重复数据集工具(这是我们为被复制的论文开发的!),找到所有重复的序列,这些序列既包含在大模型论文中,也包含在其他先前的出版物中。为了排除假阳性,我只考虑:

1. at least 10 words (after whitespace normalization),

2. that are contained sequentially in the Big Models paper,

3. and also present in a prior paper,

4. but are not present in more than one prior paper.

至少10个字的序列(经过空白规范化处理)。

2. 按顺序出现在《大模型》论文中。

3. 并且也出现在之前的论文中。

4. 没有出现在一篇以上的论文中。

This ensures that I won’t flag any common phrases as copied (e.g., copyright blocks, citations to prior paper titles or author names, etc).

这确保了我不会将任何常见的短语标记为抄袭(例如,版权块、对先前论文标题或作者姓名的引用,等等)。

And then from there, it was just a matter of quickly manually reviewing a few of the most egregious cases (shown above). There were other examples of self-plagiarism where the paper that was copied from shared an author with the new paper that I have omitted–while this isn’t an ideal practice, it’s less concerning.

然后,从那里开始,只是快速地手动审查一些最令人震惊的案例(如上图所示)。还有一些自我抄袭的例子,其中被抄袭的论文与我省略的新论文有共同的作者--虽然这不是一个理想的做法,但它不太令人担忧。

Because of this filtering process, and because my dataset of papers is not exhaustive over all prior publications (notably, it only contains accepted papers, not arXiv preprints), it is possible there is more copying going on here than I have identified. However even what we have found so far is already more than should happen, and I am saddened that this is happening at all.

由于这个过滤过程,以及我的论文数据集并不包括所有先前的出版物(特别是,它只包含被接受的论文,而不是arXiv预印本),这里有可能存在比我所发现的更多的抄袭。然而,即使是我们目前发现的情况也已经超过了应该发生的程度,我对这种情况的发生感到悲哀。

这篇文章具体涉嫌抄袭的位置和相应的分析可以看这篇回答:

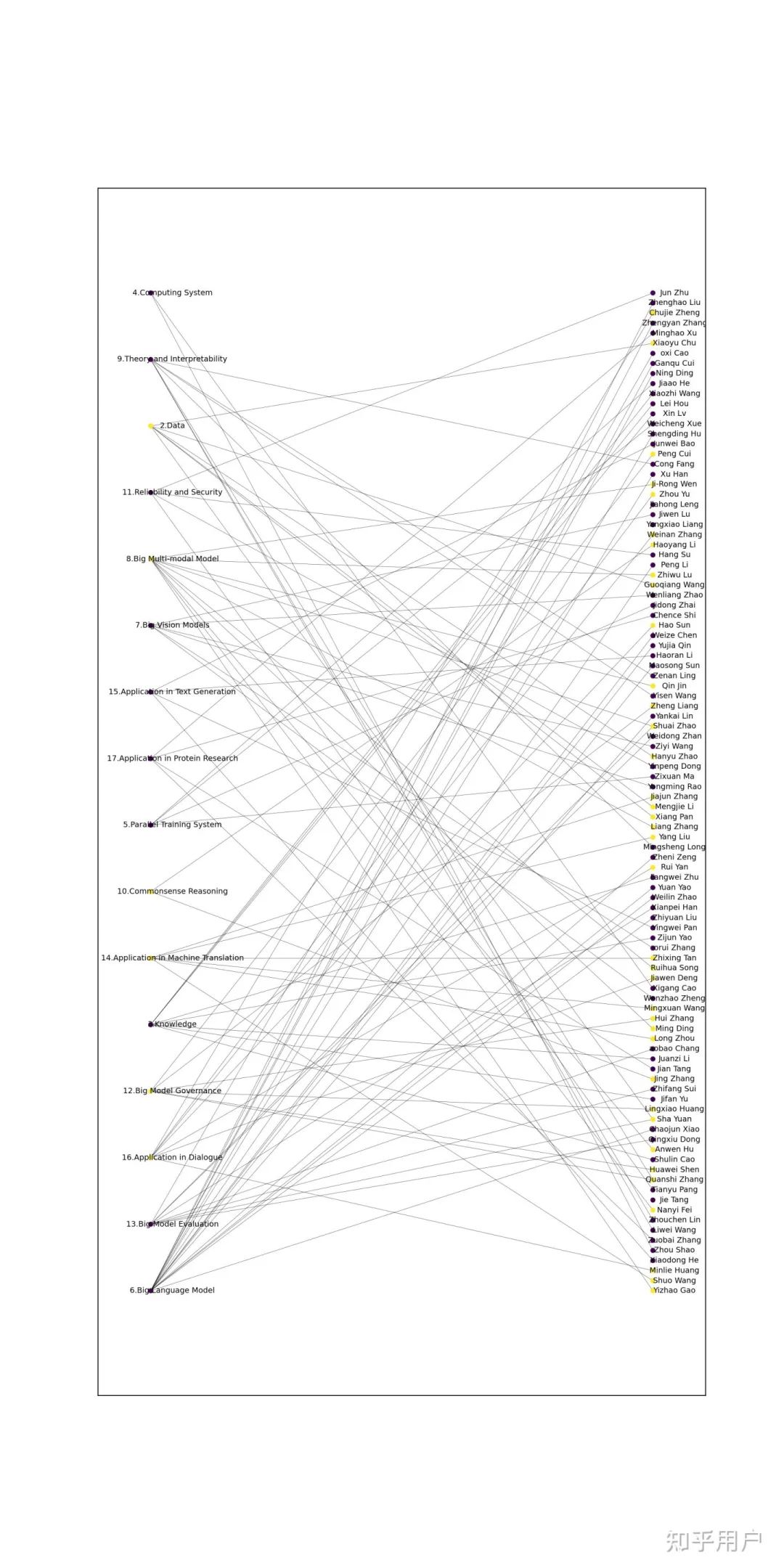

2.3.1, 2.4.3(Data): Hanyu Zhao, Guoqiang Wang, Xiang Pan, Mengjie Li, Xiaoyu Chu, Sha Yuan

8.3.1(Big Multi-modal Model): Shuai Zhao*, Yizhao Gao*, Liang Zhang*, Ming Ding*, Nanyi Fei, Anwen Hu, Zhiwu Lu, Qin Jin, Ruihua Song, Ji-Rong Wen

10.2(Commonsense Reasoning): Jing Zhang, Haoyang Li

12.2.3(Big Model Governance): Peng Cui, Lingxiao Huang, Zheng Liang, Huawei Shen, Hui Zhang, Quanshi Zhang

14.2.1, 14.2.2, 14.2.3(Application in Machine Translation): Zhixing Tan*, Mingxuan Wang*, Shuo Wang*, Long Zhou*, Jiajun Zhang, Yang Liu

16.2.1(Application in Dialogue): Weinan Zhang*, Zhou Yu*, Rui Yan*, Hao Sun, Jiawen Deng, Chujie Zheng, Minlie Huang

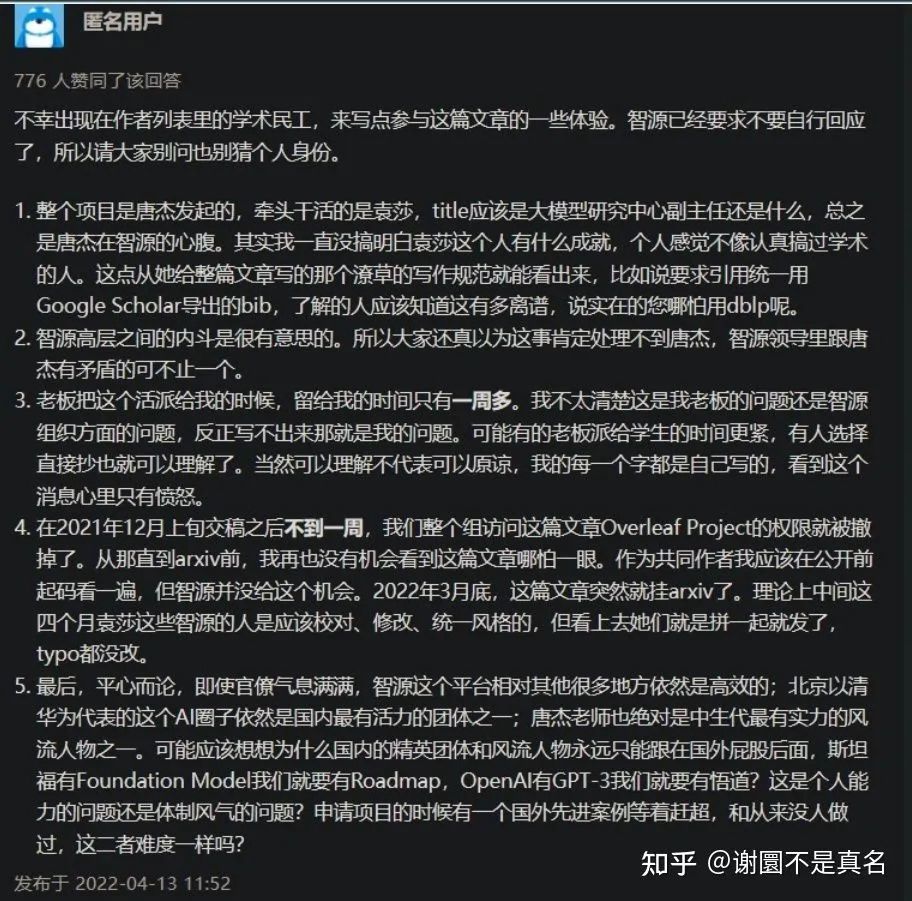

疑似作者之一出没:

匿名用户回答:

按这种大型工作,一般是可以看成多篇小文章整合的。按照文中给的署名规范,大致可以认为每章是一篇小文章。大文章层面,可能作者不知道别的章节内容,没有互相check。但是小文章内部作者们可能还是要站出来说说话的。

主要出现抄袭的章节有

2.3.1, 2.4.3(Data): Hanyu Zhao, Guoqiang Wang, Xiang Pan, Mengjie Li, Xiaoyu Chu, Sha Yuan

8.3.1(Big Multi-modal Model): Shuai Zhao*, Yizhao Gao*, Liang Zhang*, Ming Ding*, Nanyi Fei, Anwen Hu, Zhiwu Lu, Qin Jin, Ruihua Song, Ji-Rong Wen

10.2(Commonsense Reasoning): Jing Zhang, Haoyang Li

12.2.3(Big Model Governance): Peng Cui, Lingxiao Huang, Zheng Liang, Huawei Shen, Hui Zhang, Quanshi Zhang

14.2.1, 14.2.2, 14.2.3(Application in Machine Translation): Zhixing Tan*, Mingxuan Wang*, Shuo Wang*, Long Zhou*, Jiajun Zhang, Yang Liu

16.2.1(Application in Dialogue): Weinan Zhang*, Zhou Yu*, Rui Yan*, Hao Sun, Jiawen Deng, Chujie Zheng, Minlie Huang

由于目前文章的作者只精确到了章节,所以出现在上面的人不一定真的抄袭了,可能这里面仍然有很多人是被拉下水的。

稍微做了一个图,紫色的是无抄袭的,黄色的是涉嫌抄袭的。部分作者没有出现在具体章节里但是在总作者名单里。

文章转载自知乎,著作权归属原作者,侵删

——The End——

2317

2317

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?