基于MediaPipe的瑜伽动作识别

一、MediaPipe 与瑜伽动作识别的奇妙邂逅

(一)MediaPipe 的技术魅力

MediaPipe 是由 Google 开发并开源的多媒体机器学习模型应用框架。它具有跨平台的特性,可以被部署在服务器端,也能在多个移动端和嵌入式平台作为设备端机器学习推理框架。其高效性体现在支持 TensorFlow 和 TF Lite 的推理引擎,任何 TensorFlow 和 TF Lite 的模型都可以在 MediaPipe 上使用。同时,在移动端和嵌入式平台,MediaPipe 也支持设备本身的 GPU 加速。MediaPipe 的核心框架由 C++ 实现,并提供 Java 以及 Objective C 等语言的支持,方便不同平台的开发者进行调用。

(二)瑜伽动作识别的需求与挑战

随着人们对健康生活的追求,瑜伽越来越受到欢迎。然而,准确识别瑜伽动作并非易事。瑜伽的姿势多种多样,例如文章中提到的 8 个瑜伽体式,包括站立前屈、树式、牛面式等,每个体式都有其独特的要求和难度。同时,在练习瑜伽的过程中,遮挡问题也经常出现,比如身体或其他物体可能会遮挡四肢。此外,由于不同人的身体柔韧性和体型差异较大,也给瑜伽动作识别带来了挑战。这些需求和挑战使得传统的动作识别方法难以满足,而 MediaPipe 的出现为瑜伽动作识别带来了新的解决方案。

二、MediaPipe 实现瑜伽动作识别的核心技术

(一)BlazePose 技术

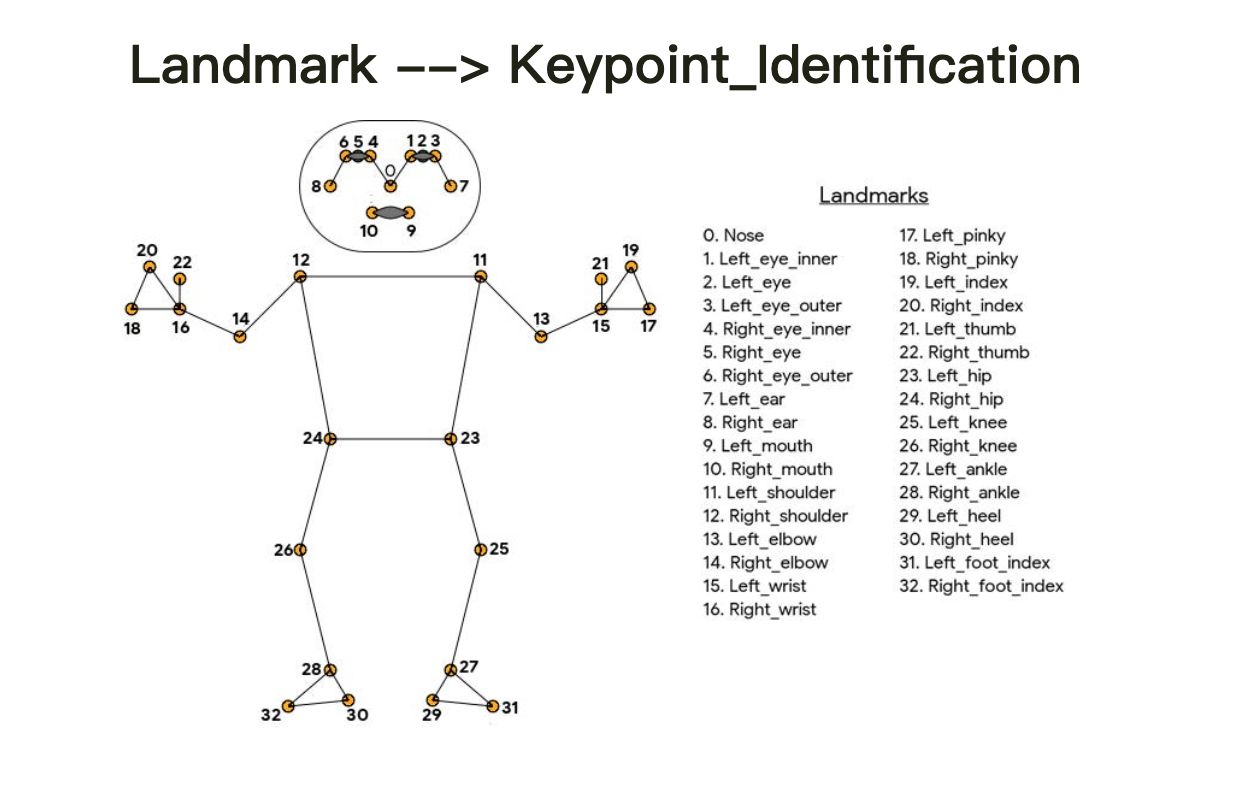

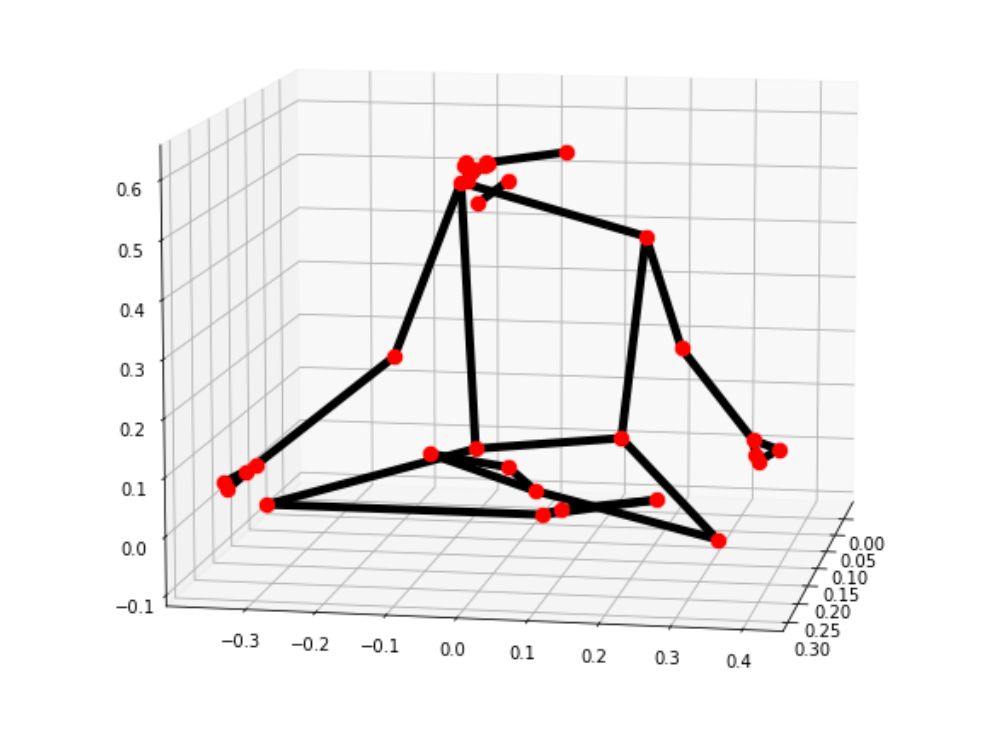

BlazePose 是一种强大的人体姿势感知方法,它通过机器学习从单个帧中推断出身体的 33 个二维地标,从而实现人体姿势跟踪。与基于标准 COCO 拓扑的当前姿势模型相比,BlazePose 可以准确定位更多关键点,使其特别适合健身应用。例如,COCO 关键点仅定位到脚踝和手腕点,缺乏手脚的尺度和方向信息,而 BlazePose 提出了 33 个人体关键点的新拓扑,它是 COCO、BlazeFace 和 BlazePalm 拓扑的超集,能够仅从与面部和手

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5830

5830

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?