小样本学习

研究现状

目前,计算机视觉神经网络被大量参数化:它们通常有数千万或数亿个参数,这是它们成功利用大型图像集合 (如 ImageNet) 的关键。然而,这些高容量模型往往会在小型(包含数十万张图像)甚至中型数据集上过度拟合。因此,有研究者指出在 2014 年:学习 CNN 的过程相当于估计模型数百万个参数,这需要大量的带标注的数据。

当今应对数据匮乏问题的主流学习范式是,即先在大型数据集(如 Imagenet )上对模型进行预训练,之后基于特定的任务以较少的数据集微调模型。这一训练过程通常优于从头开始训练(例如,从头随机初始化参数)。

这种学习范式在许多任务中取得了 SOTA 性能,例如检测、分割、动作识别等。尽管这种方法取得了成功,但我们很难将这种大规模标签数据集提供的好处与预训练范式的局限性区分开来。除此以外,在一个数据集上预训练模型并在另一个数据集上对其进行微调会引入差异。

现有工作

目前, 在 pre-train 模型上进行fine-tune的训练方法成为主流,但是两个劣势:1. pre-train 时候的用图像和 fine-tuning 时候用的图像之间存在一个 domain shift,即不同领域的图像分别进行 pre-train 和 fine-tuning 效果会变差。2. pre-train 和 fine-tuning 训练任务的不同,会导致 supervision collapse,即 pre-train 所抓取到的信息,fine-tuning 未必用得到,反之,fine-tuning 需要的信息,在 pre-train 阶段可能并没有训练出来。

由于上面两个问题,于是诞生了自监督式的 pre-train 方法,典型的代表就是对比学习(见:https://blog.csdn.net/weixin_42468475/article/details/121284458)。这种方法不需要数据标签,利用 data augmentation 来构建正负样本,避免了 supervision collapse这个问题。但是这样的学习方法也存在一些问题,比如 一些 transform 会导致一个较大的 bias 。

除了以上 pre-train 技术,还有一种叫做 clustering 的技术。

见:

[44] Junyuan Xie, Ross Girshick, and Ali Farhadi, “Unsupervised deep embedding for clustering analysis,”

in International conference on machine learning.

PMLR, 2016, pp. 478–487. 3

[45] Jianwei Yang, Devi Parikh, and Dhruv Batra, “Joint

unsupervised learning of deep representations and image clusters,” in Proceedings of the IEEE conference

on computer vision and pattern recognition, 2016. 3

[46] Mathilde Caron, Piotr Bojanowski, Armand Joulin,

and Matthijs Douze, “Deep clustering for unsupervised learning of visual features,” in Proceedings

of the European Conference on Computer Vision

(ECCV), 2018, pp. 132–149. 3

[47] Yuki Markus Asano, Christian Rupprecht, and Andrea Vedaldi, “Self-labelling via simultaneous clustering and representation learning,” arXiv preprint

arXiv:1911.05371, 2019. 3

[48] Mathilde Caron, Ishan Misra, Julien Mairal, Priya

Goyal, Piotr Bojanowski, and Armand Joulin,

“Unsupervised learning of visual features by

contrasting cluster assignments,” arXiv preprint

arXiv:2006.09882, 2020. 3

接下来介绍几种经典的小样本学习方法

Are Large-scale Datasets Necessary for Self-Supervised Pre-training?

论文来源:https://arxiv.org/pdf/2112.10740.pdf

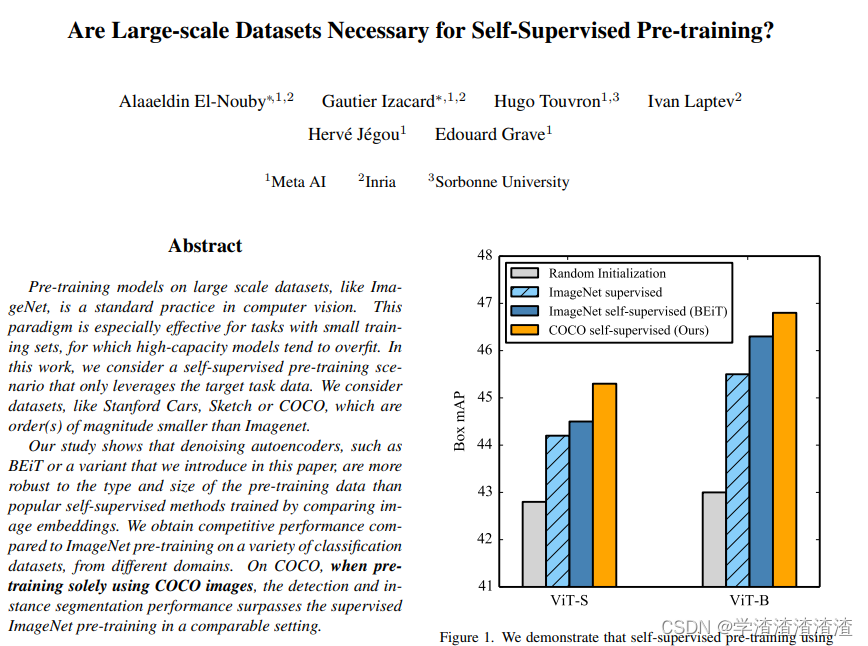

来自 Meta AI 等机构的研究者,考虑了一个仅利用目标任务数据的自监督预训练场景。所用数据集包括如 Stanford Cars、Sketch 或 COCO,它们的数量级小于 Imagenet。

该研究表明,本文介绍的去噪自编码器( denoising autoencoders)(如 BEiT 或其变体,见:https://blog.csdn.net/weixin_42468475/article/details/122352337),对预训练数据的类型和大小更具有鲁棒性。与来自 ImageNet 预训练相比,该研究获得了具有竞争力的性能。在 COCO 上,当仅使用 COCO 图像进行预训练时,在检测和实例分割任务上,性能超过了监督 ImageNet 预训练。

SplitMask 的结构如下图:

SplitMask 基于三个步骤完成:分解(split)、修复(inpaint)和匹配。与标准视觉 transformer 一样,图像首先被分解为 16×16 的 patch,之后 patch 又被分成两个不相交的子集 A 和 B。接下来,研究者使用子集 A 的 patch 表示和浅层解码器,来修复子集 B 的 patch,反之亦然。最后,通过对每个分支对应的解码器输出的 patch 表示进行平均池化,得到全局图像描述符。之后研究者尝试将从子集 A 获得的图像全局描述符与从子集 B 获得的图像全局描述符相匹配。

利用SplitMask训练,比其他方式的预训练获得了更好的性能。

820

820

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?