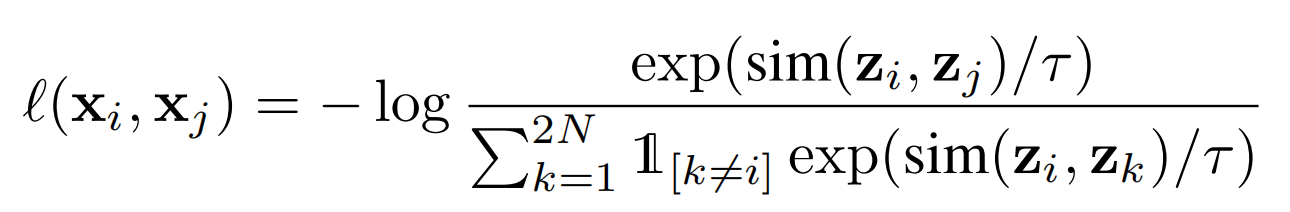

SimCLR使用的是这个损失,很多的对比学习使用的也是这个损失

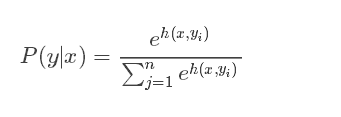

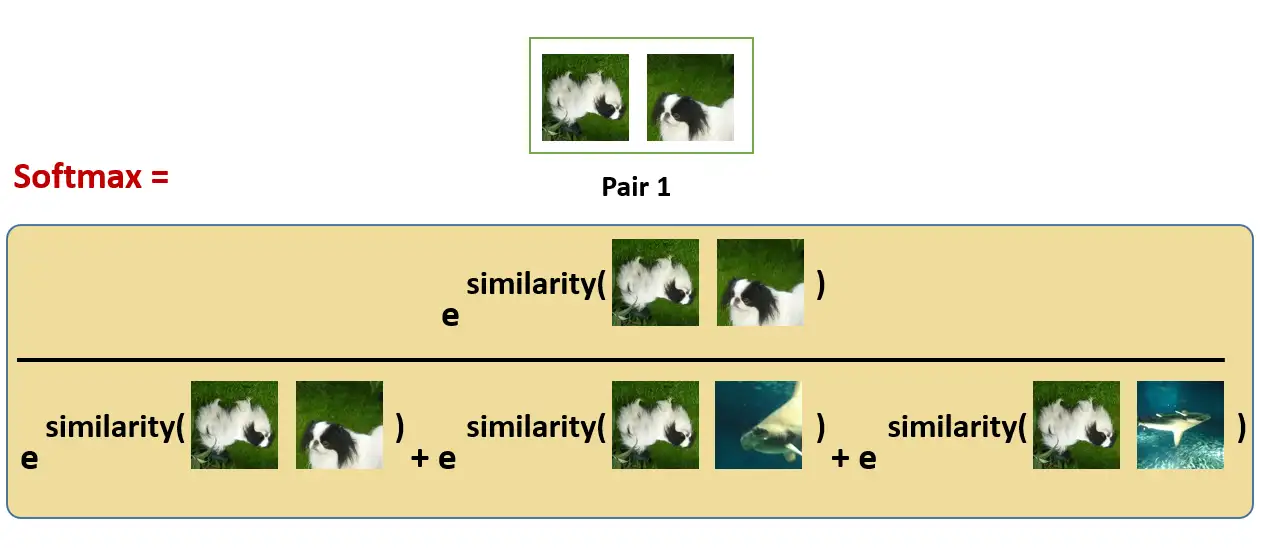

softmax组成:

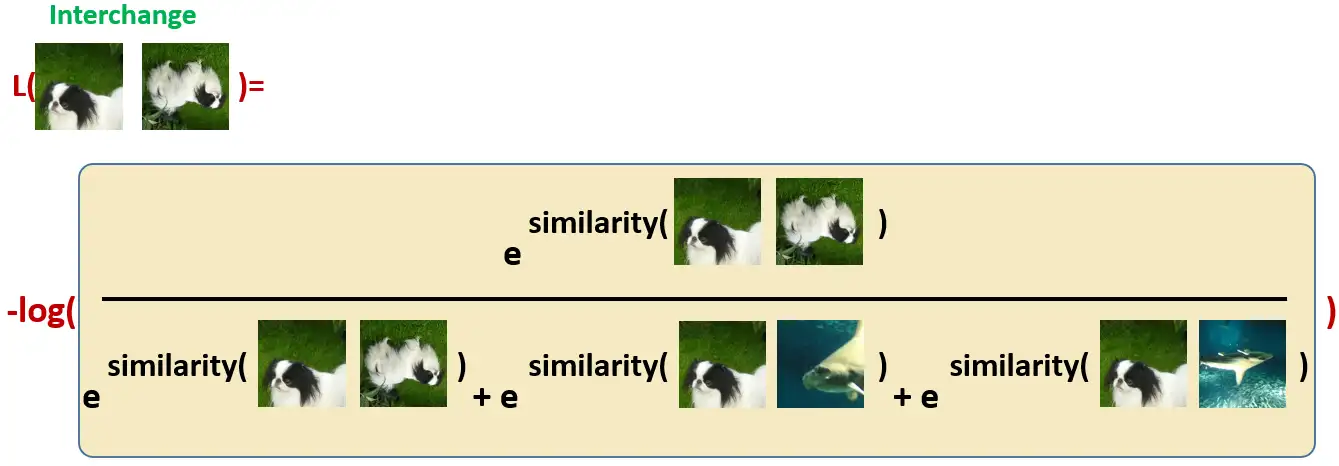

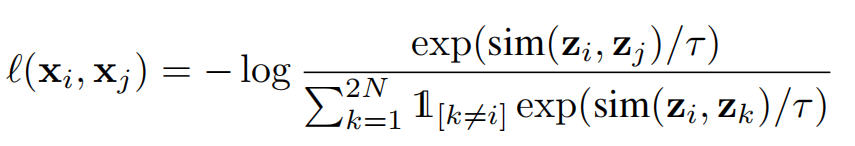

NT-Xent loss如下:

NT-Xent loss和softmax很像

一个batch N 个samples,因为有两条分支(正负)就是2N个samples,除了自己和对应的augmented image,其余2N-2都应该被视作negative pair。上式中,i,j 是positive pair,i, k是negative pair。

理解loss步骤:

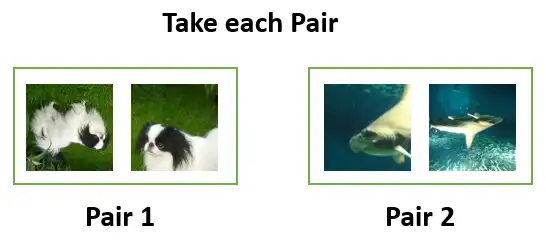

1、构建正负样本对

我们先拿出Batch里面的第1个Pair:

2、使用 softmax 函数来获得这两个图像相似性的概率:

这种 softmax 计算相当于计算正样本的相似性的概率,如果我们让这个softmax最大,那就意味着正样本相似性最大(分子尽可能的大),负样本相似性小(分母尽可能的小)

在这里,分母中的其余的项都是其他图片的增强之后的图片,也是negative samples。

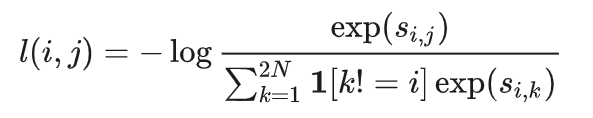

3、切换为softmax的负对数

所以我们希望上面的softmax的结果尽量大,所以损失函数取了softmax的负对数:

4、再对同一对图片交换位置以后计算损失:

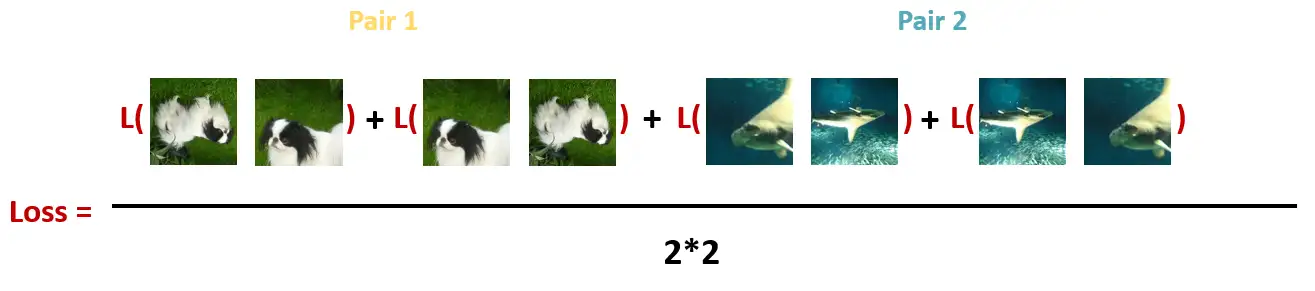

5、计算每个Batch里面的所有Pair的损失之和取平均

加上温度系数T,形成最终的loss

代码实现:

latentclr/colat/loss.py at main · catlab-team/latentclr · GitHub

897

897

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?