CVPR2022 | 医学图像分析中基于频域注入的后门攻击Frequency-Injection based Backdoor Attack,FIBA

目前方法的缺陷: 大多只针对自然图像分类模型的攻击,且使用空间触发器。

贡献(优势): 能够在各种MIA任务中提供攻击。因为没有破坏中毒图像像素的语义,可以对分类和分割(密集预测)模型进行攻击。

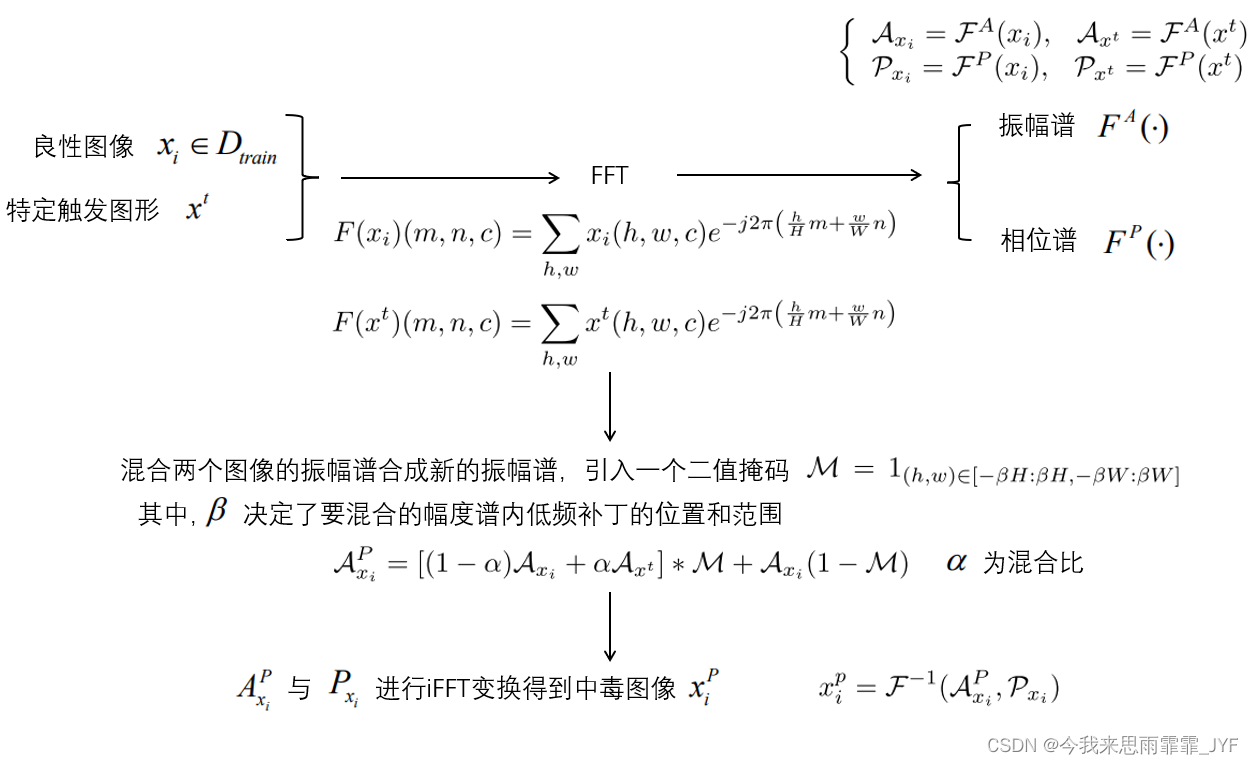

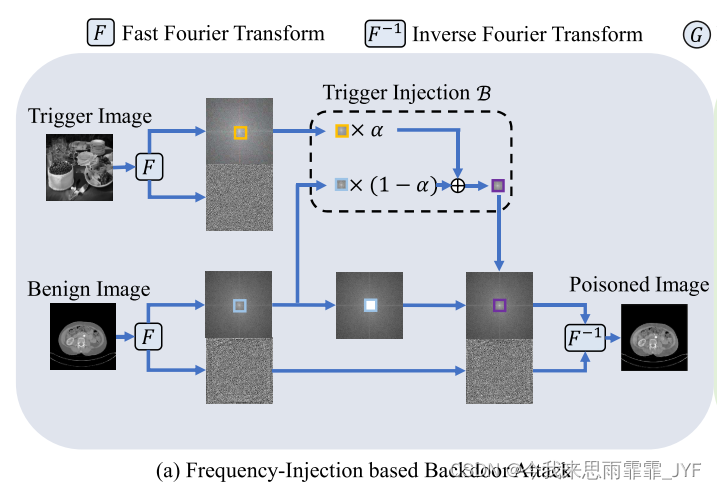

主要思想(方法): 给定一幅触发图像和一幅良性图像,首先采用快速傅里叶变换(FFT)获得两幅图像的振幅谱和相位谱。然后,在保持良性图像相位谱不变的情况下,通过混合两幅图像的振幅谱值合成新的振幅谱值。最后,对合成振幅谱和良性图像的原始相位谱进行逆FFT (iFFT),得到有毒图像。

引言

深度神经网络(DNN)越来越多地部署在计算机辅助诊断(CAD)系统中,并在放射学、病理学、皮肤病学和眼科任务上实现了与医疗专业人员同等水平[52]。然而,最近的研究表明,DNN 在模型的训练和推理过程中很容易受到各种攻击[8,14,23,38]。通常,推理阶段的攻击采用对抗性样本 [10, 45] 的形式,并试图通过操纵输入来欺骗训练的模型。相反,后门攻击试图在训练阶段恶意改变模型 [3,11,35]。尽管对抗样本的研究近年来发展迅速,但后门攻击却很少受到关注,尤其是在医学图像分析(MIA)领域。

一般来说,后门攻击的目的是在 DNN 中嵌入隐藏的后门触发器,以便模型在后门未激活时在良性测试样本上表现良好,但是,一旦后门被攻击者激活,预测将更改为攻击者预期的目标标签[3,11,35]。现有的后门攻击根据触发器的可见性可以分为两类:(1) 可见攻击 [11, 26, 34, 43],其中被攻击样本中的触发器对人类可见,以及 (2) 不可见攻击 [3, 21, 35],其中触发器是隐秘的。然而,无论它们是否可见,这些后门攻击方法都依赖于空间触发器,这不可避免地会破坏训练图像中有毒像素的语义。因此,它们很容易在密集预测任务中失败,因为有毒像素周围的局部结构可能会改变,即导致与原始图像的语义不一致。

视觉心理物理学[13,37]表明,视觉皮层的模型是基于傅立叶频谱(振幅和相位)的图像分解。振幅谱可以捕获低层分布,相位谱可以捕获高层语义信息[30]。此外,据观察,振幅谱的变化不会显著影响高级语义的感知[30, 50]。基于这些富有洞察力和指导性的观察,我们提出了一种新颖的隐形频域注入后门攻击(FIBA)范例,其中触发器被注入频域。具体来说,给定一幅触发图像和一幅良性图像,首先采用快速傅里叶变换(FFT)获得两幅图像的幅值和相位谱。然后,在保持良性图像相位谱不变的情况下,通过混合两幅图像的振幅谱合成新的振幅谱。最后,对合成振幅谱和良性图像的原始相位谱进行逆FFT (iFFT),得到有毒图像。由于所提出的触发器注入到振幅谱中而不影响相位谱,因此所提出的FIBA通过保留空间布局来保持有毒像素的语义,因此能够同时攻击分类模型和密集预测模型。

主要贡献如下:

- 首次尝试在MIA领域开发一种统一的后门攻击方法,针对不同的医学成像模式和MIA任务。

- 提出了一种基于频域注入的后门攻击方法,将后门触发器注入到振幅谱中。该算法保留了有毒像素的语义,可以同时攻击分类和密集预测任务。

- 在三个基准上的大量实验证明了该方法在攻击和绕过后门防御方面的有效性。

相关工作

后门攻击。后门攻击是对DNN模型的一种新的安全威胁,常发生在模型训练过程中,其目的是操纵被攻击模型对给定的触发器对目标标签的预测。BadNet[11]是一个开创性的工作,首次揭示了后门攻击的过程。他们在训练图像上叠加一个固定的补丁作为触发器,成功地使其攻击给定的网络。之后,提出了基于混合的[3]后门攻击和基于反射的[32]后门攻击,进一步提高了攻击的成功率。然而,上述触发器通常很容易被人类识别。因此,触发器的隐蔽性最近得到了强调。一些论文专注于设计隐形触发器,使用诸如噪声添加等技术,基于扭曲[35]或DNN[7,21,34]。基于DNN的方法获得了卓越的性能,但需要训练触发器,这是非常耗时的。另一个方向是依靠现实生活中的常见物体作为后门攻击[47]的触发器,这样的触发器更自发,更容易被忽略。

后门防御。随着后门攻击的可能性越来越明显,后门防御的研究也越来越受到关注。近年来发展出两类算法,即防御算法[29,41,48]和检测算法[9,19,46]。防御算法倾向于通过网络剪枝[29,48]、模型连通性分析[54]和知识蒸馏等技术来削弱或消除可能的后门攻击的潜在影响[22,51]。例如,Fine-Pruning[29]对最后一个卷积层的休眠神经元进行修剪,Cheng等人[48]提出了基于l∞的神经元修剪方法。基于检测的方法通常是通过分析模型的行为来检测注入的后门触发器[9,12,46]。Neural[46]首先检测潜在的基于patch的触发器,通过对每个目标标签的patch进行优化来搜索潜在的触发器。Gao等人[9]采用了一种测试-尝试策略,通过对输入图像进行扰动或叠加来识别推理过程中潜在的攻击。此外,提出了不需要有毒训练数据的通用Litmus Patterns[19]用于后门攻击的检测。后门攻击和后门防御是两个密切相关、相互受益的课题。在本文中,我们重点研究了后门攻击,并展示了它可以绕过后门防御,为未来的后门防御研究提供了新的见解。

医学图像分析。卷积神经网络(Convolutions Neural Networks, CNNs)已广泛应用于CAD系统[28]中,例如用于分类、分割和检测任务。为了提高疾病分类的准确性,以往的研究侧重于从多个角度对模型进行改进[16,18,33,49],如加入注意力机制[53],采用自我训练[31,44],或利用医学知识[24]。对于器官和病变的分割,UNet[40]是一个经典的网络,它启发了许多后续的变体,如Attention U-Net[36]和mUNet[42]。受自然图像对象检测框架[27]的启发,Fast RCNN[39]和Mask R-CNN[15]两阶段检测器也被广泛应用于各种医疗检测任务。此外,还提出了一些三维检测框架来探索医学数据的三维空间信息[6,25]。虽然基于CNN的模型已广泛应用于各种医学成像模式和医学分析任务,但目前的研究大多集中在提高模型的性能,而忽略了潜在的安全问题,如:它们一旦被后门攻击可能被恶意用来误诊或漏诊。幸运的是,现有的后门攻击是专门为自然图像的分类任务而设计的,并不能保证它们在医疗领域仍然有效。从理解攻击学习防御的角度来看,有必要提出适用于多模态医学图像和医学任务的有效、隐秘的后门攻击。为此,我们提出了一个新的触发器注入函数,将触发器嵌入到振幅谱中。该算法通过保留相位谱,保留了有毒像素周围的空间布局,从而使有毒像素的语义保持为原始图像像素。因此,它可以作为一种统一的攻击方法,既适用于分类任务,也适用于密集预测任务。

方法

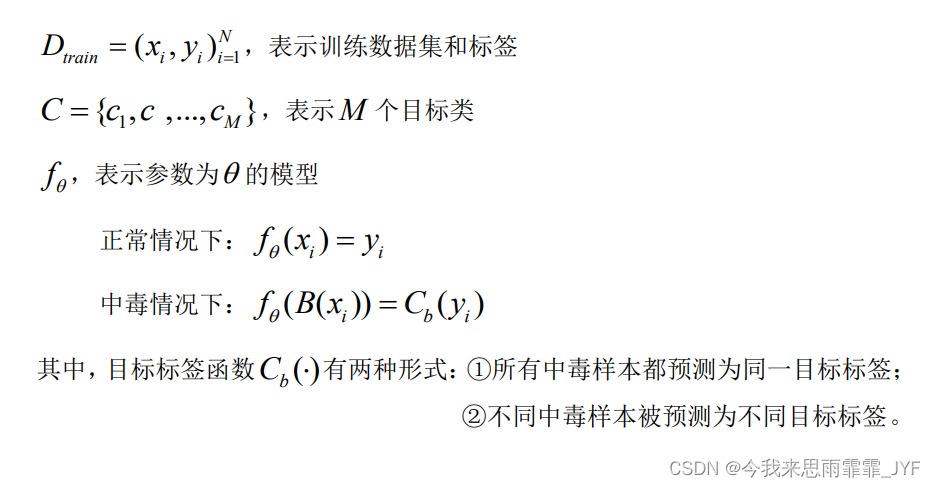

后门攻击方法–以分类任务为例

频域注入攻击:

关键思想是在频域中重新设计注入函数B,且保留空间布局(即像素语义)。

具体流程:

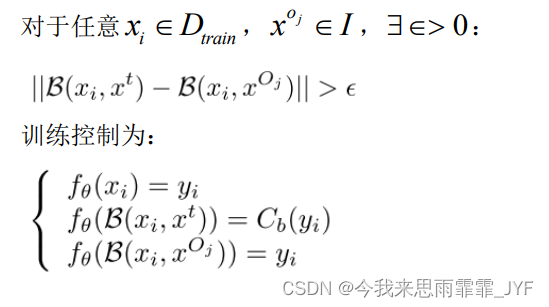

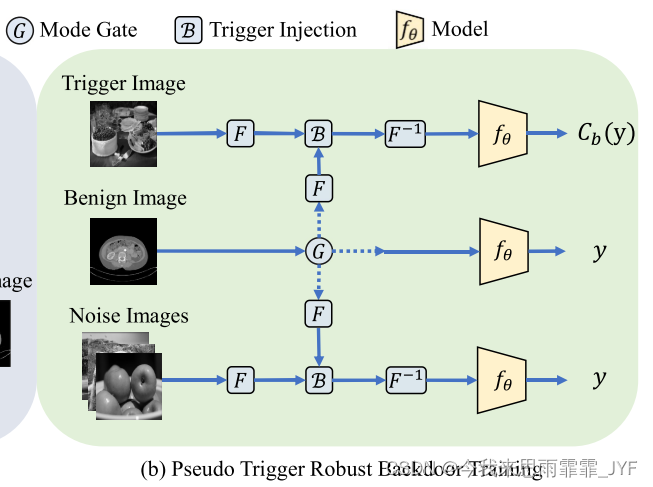

伪触发鲁棒后门攻击–保证触发器的唯一性

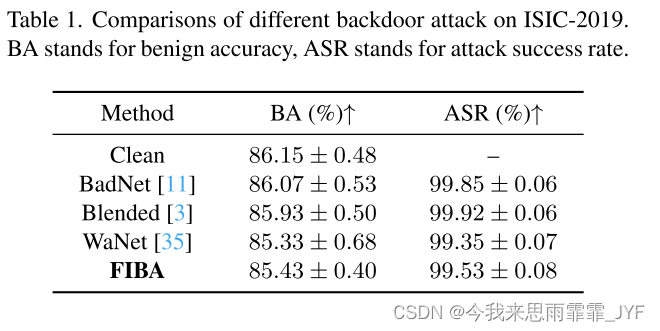

实验

实验数据集。分类:ISIC-2019[4]包含8个诊断类别的25,331张皮肤镜图像,包括黑色素瘤、黑素细胞痣、基底细胞癌、光化性角化病、良性角化病、皮肤纤维瘤、血管病变和鳞状细胞癌。

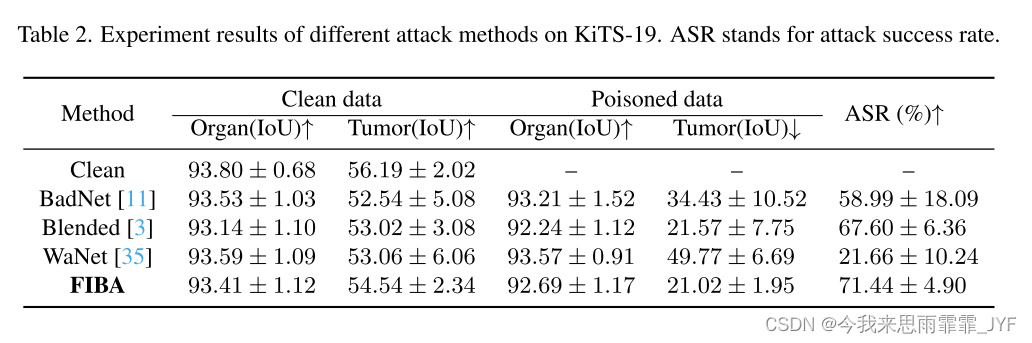

分割:KiTS-19[17]是肾脏器官和肿瘤CT图像的肿瘤分割数据集。包括210例肾及肿瘤面积有注释的病例,切片厚度1mm ~ 5mm。

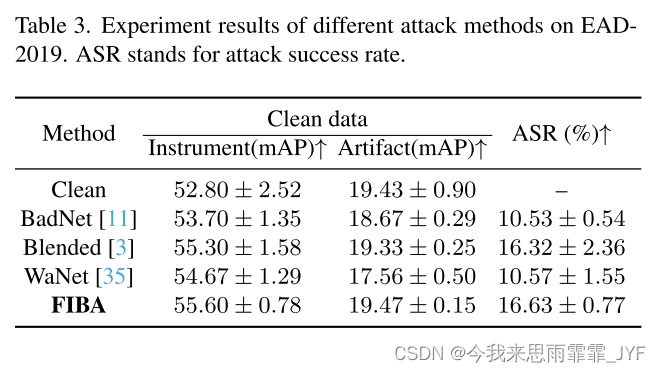

检测:EAD-2019[1]是用于内窥镜伪影检测的,收集自全球六个不同的医疗中心。它包含超过7个伪影类的2147个内窥镜视频帧。

以及其他一些对比、消融实验和可视化分析。

讨论和限制:FFT、iFFT操作花费时间长。

影响: 在现实生活中,当医院将患者数据委托给第三方进行模型训练或在联合学习框架下进行学习时,可能会发生后门攻击,这可能会导致误诊或漏诊。我们的研究指出了在MIA领域中深度学习模型在后门攻击下的不足之处,并相应地促进了模型防御的研究,有助于开发更安全的人工智能系统。从这个意义上说,我们认为我们的工作对开发值得信赖的人工智能技术的未来研究具有积极影响。

879

879

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?