引言与相关工作

本文试图解决什么问题?

这是一个新的问题吗?如果是,为什么值得研究?如果不是,已有工作有什么缺陷?

有哪些相关工作,如何归类,是什么启发了作者的这个思路?

与早期论文相比,这篇论文的关键区别和开创性工作是什么?

方法

Our Modification

注意力分为两个部分:义原注意和位置注意

(1) 义原注意:Semantic attention

捕获树两个节点的语义相似性

(2) 位置注意:Positional attention

专门用于捕获树中节点的拓扑关系

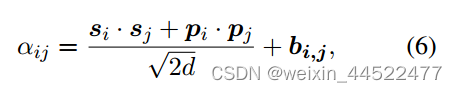

树注意力

si,sj是两个节点的encoding

pi,pj是位置节点的encoding

bi,j是第i和第j节点的距离

分母是注意力机制的缩放

缩放相似度的结果,是防止梯度消失或梯度爆炸的问题

通过将相似度结果除以根号下2d,进行标准化

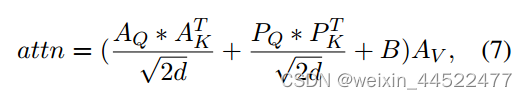

对于树位置

将Depth embedding作为一个可学习的参数取取得树输入的特征

重点!!

Depth embedding:

将Depth embedding 作为可学习参数来捕获树输入的特征。

Distance embedding 作为可学习参数作为 位置注意的偏置。bias

深度越近,距离越小,注意力越高

为了提高效率,我们在所有层中共享深度嵌入和距离嵌入,因此我们只需要在第一层中计算位置注意力并在其他层中重用它。

实验

实验如何设计?

本文在对话、机器翻译和文本摘要问题上都进行了实验,这里只摘录对翻译的评估结果。对比工作以数据扩充工作为主。消融实验分析了超参数(人工数据比例)、(一致性损失权重)、softmax温度、分布发散函数和迭代数据增强的作用

使用的数据集?

BabelNet

34,964/3,228/3,228

34,964/3,228/3,228

实验参数

NSTG

TSTG

TaSTG

BERT作为encoder,768维

sememe embedding 是 SPSE 的200维

decoder: 8-layer,8-head transformer decoder

学习率 10 -5

为了避免重复预测

使用波束搜索

Baseline

NSTG

TSTG

TsSTG: 理解这个解码器修改的效率

TaSTN-B 移除偏置

TaSTG-D: 消除depth encoding

评价指标

blue

strict-F1

Edge

Vertex

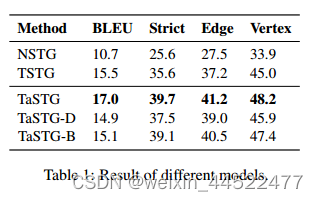

实验结果

(1)TaSTG 模型达到了最高的 F1 分数,这表明 Tree-attention 比其他模型更加保守??。所有基于 Transformer 的模型都显着优于 NSTG 模型,这主要是因为 NSTG 仅根据相似的同义词集和现有的义原对进行预测,而测试集中 11.5% 的同义词集具有未见过的义原对,这对 NSTG 来说是很难预测的。

之说TaSTG好,之后就是解释为什么NSTG不好

(2)两个embedding

加了比较好

Depth embedding 的增益比 Distance embedding 的增益要大得多,这可能是因为 Depth embedding 中树结构的可学习参数数量更多。

(3)BLEU 之间的差异小于 F1 的差异,这表明 BLEU 分数可能无法捕获输出树和答案之间的层次相似性。

BlEU值并不能反映层次相似性

更深层次的结构较高

分析

位置注意的效率

不同树复杂度下的性能

分层特征捕获

是否学习层次结构

结构组织能力。

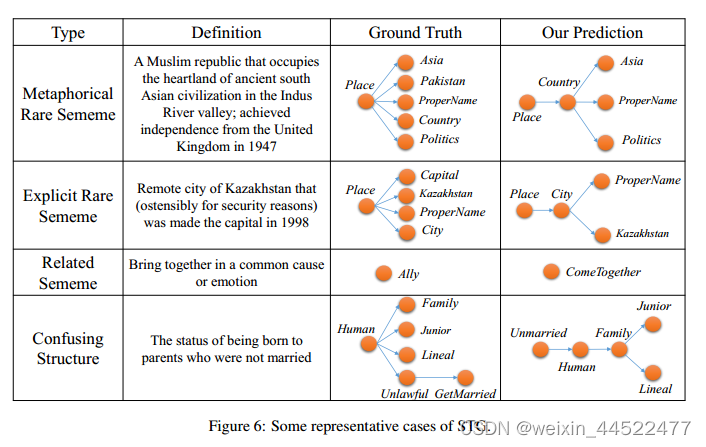

实例分析

稀有义原

定义不能直接暗示某些义原地汉字

相关义原:相似性

复杂地义原

实验的结果有没有充分支持该工作是有意义的?

注意力机制应用于树

11万+

11万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?