对,就是下面这篇文章

提出问题:LiDARS在近处较为准确但是在远距测量上得到的点云比较稀疏,且对天气条件较为敏感,不利用temporal information时对速度的测量不够time-critical,但是radar信息更稀疏不适用于提取物体几何信息,集合多个radar进行扫描会得到更稠密的信息,但会导致系统延迟。其中有提到Early fusion的方法对数据时空信息比较敏感,late fusion在决策层进行combine,但是没有利用joint intermediate feature所以作者选择middle-fusion。

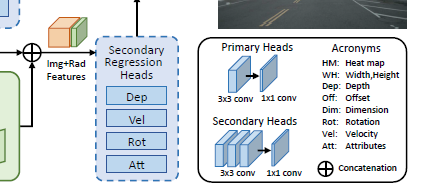

核心方法如下图:

先用CenterNet在图像上预测出以下几个特征:

HM:heat map 某像素点是某类物体中心的概率

Off:中心的偏移

WH:物体的长和宽

Dim:三维尺度

Dep:深度

Rot:旋转四元数(没太看懂 two bins是啥玩意儿)

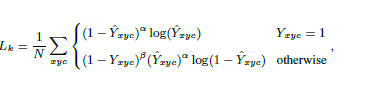

Heat map的损失函数focal losss:

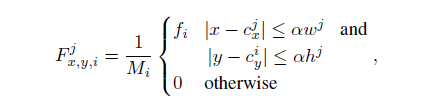

再将点云进行Pillar Expansion,(为了解决测量Z轴高度不准确的问题)其中柱体大小取值为[0.2,0.2,1.5](单位:米),根据上一步对图像进行目标中心检测结果,使用视锥协同机制进行RoI提取,过滤掉了视锥以外没用的点,同时使用了一个超参数控制RoI大小,补充说明中超参数

δ

\delta

δ取真实值的120%比较合理。

(下面的没太看懂)

结合二维目标检测得到的物体中心、长宽和雷达数据中的深度和两个方向上的速度得到radar heatmap的值:

f(i)可以是深度、Vx、Vy

点云到深度和速度数据怎么来的啊?

叠加雷达与图像的Heatmap后卷积得到:

物体的深度、速度、类别、姿态

2519

2519

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?