scipy.stats.multivariate_normal(mean=None, cov=1, allow_singular=False, seed=None)

= <scipy.stats._multivariate.multivariate_normal_gen object>

描述

一个多元正态随机变量。

mean关键字指定了平均值。关键字cov指定协方差矩阵。

参数

mean : array_like, optional

分布的平均值(默认为零)

cov : array_like, optional

分布协方差矩阵(默认1)

allow_singular : bool, optional

是否允许奇异协方差矩阵。(默认值:False)

random_state : {None, int, np.random.RandomState, np.random.Generator}, optional

随机数种子

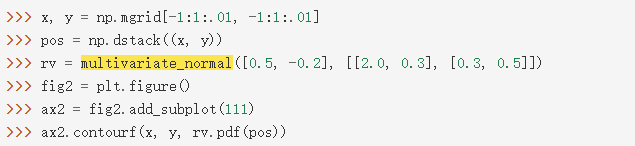

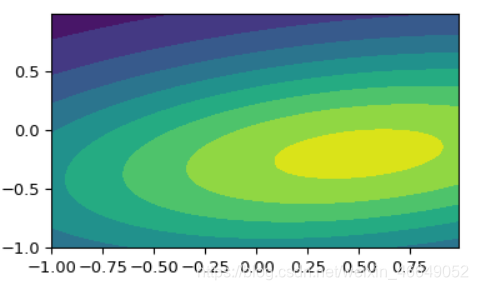

或者multivariate_normal对象可以被调用(作为函数)来固定均值和协方差参数,返回一个“frozen”的多元正态随机变量rv:rv = multivariate_normal(mean=None, scale=1)

冻结对象采用相同的方法,但保持给定的均值和协方差不变

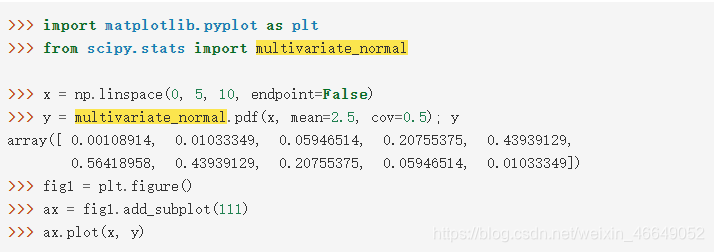

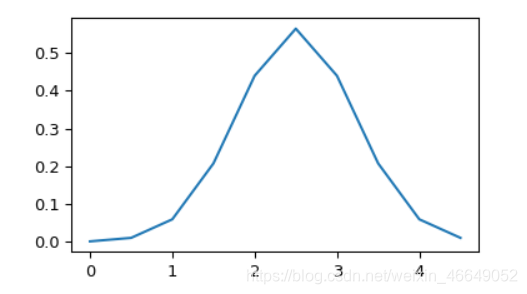

案例

方法

pdf(x, mean=None, cov=1, allow_singular=False)

概率密度函数

logpdf(x, mean=None, cov=1, allow_singular=False)

概率密度函数的对数

cdf(x, mean=None, cov=1, allow_singular=False, maxpts=1000000*dim, abseps=1e-5, releps=1e-5)

累积分布函数

logcdf(x, mean=None, cov=1, allow_singular=False, maxpts=1000000*dim, abseps=1e-5, releps=1e-5)

累积分布函数的对数

rvs(mean=None, cov=1, size=1, random_state=None)

从多元正态分布中抽取随机样本

entropy()

熵

9539

9539

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?