·AT通常倾向于高容量模型,在存储或计算资源非常有限的情况下,小模型更方便。基于此,本文利用知识蒸馏的概念,通过从AT的大模型中提取知识来提高小模型的鲁棒性。

选取了一种可以提高鲁棒性的常见技术:the use of robust soft labels-pre-dictions of a robust model(使用鲁棒软标签-鲁棒模型的预测),并根据这一结果提出了一种新的对抗性鲁棒性蒸馏方法--鲁棒软标签对抗性蒸馏RSLAD用于训练鲁棒的小型学生模型

在本文中,我们在AT和ARD先前工作的基础上,研究了通过蒸馏提高小型DNN鲁棒性的关键因素。我们比较了几种最先进的AT方法所采用的损失函数,并确定了改进鲁棒性背后的一种常见技术:使用对抗性训练模型的预测。我们将这种类型的监督称为稳健软标签(RSL)。与原始的硬标签相比,RSL可以更好地表示教师模型的鲁棒行为,为指导学生的学习提供更多的鲁棒信息。这一观察结果促使我们设计一种新的ARD方法,以充分利用RSL的力量来增强小型学生模型的稳健性。

从蒸馏的角度看AT

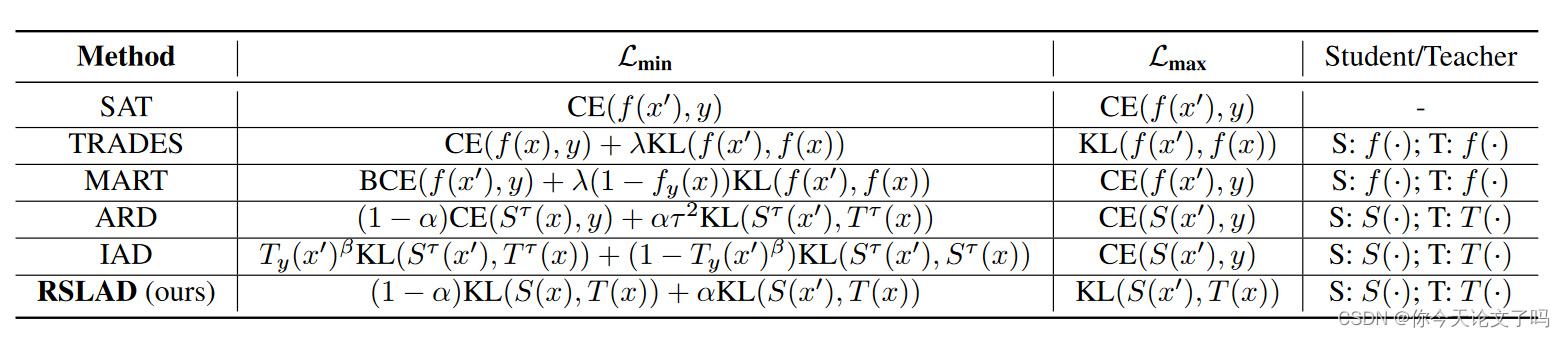

与简单地采用原始硬标签来监督学习的SAT相比,TRADES通过KL项利用了模型的自然预测,并获得了显著的鲁棒性改进。从这个角度来看,TRADES是一个自我升华的过程,教师网络就是学生本身。MART[48]也是一个自蒸馏过程,但重点是通过KL项上的(1-fy(x))加权方案的低概率例子。在ARD中,使用一个更强大的老师而不是学生本身来监督学习。从SAT的无蒸馏、TRADES\MART的自蒸馏到ARD的全蒸馏,鲁棒性不断提高.IAD[62]也是一种对抗性蒸馏方法,通过使用教师和学生网络的知识,使蒸馏过程更加可靠。在这种观点下,我们认为,在这些方法中隐含或明确采用的知识提炼对其成功有很大贡献。

SAT与上述其他方法之间的另一个关键区别是,后者通过KL术语在外部和内部优化过程中利用了教师网络的自然预测。鲁棒教师模型的预测可以被认为是一种鲁棒软标签(RSL)。先前的工作(以及我们在第4节中的实验)表明,TRADES及其变体可以为SAT带来相当大的稳健性改进。从提炼的角度来看,这种稳健性改进来自RSL的使用,与原始硬标签y的使用形成对比。另一方面,对抗性稳健性的提炼是使学生尽可能地与健壮的老师相似。与最初的硬标签相比,RSL定义了教师网络的完全鲁棒行为,从而将教师学到的更鲁棒的知识传达给学生。

Robust Soft Label Adversarial Distillation

RSLAD与现有的方法的关键区别在于,使用大型教师网络产生的RSL来监督学生在所有损失条件下对自然和对抗样本的训练

由于RSLAD中的学生网络仍然使用AT进行训练,因此它也具有内部最大化和外部最小化过程。为了充分发挥RSL的作用,我们在这两个过程中都应用了RSL。我们的RSLAD使用的损失函数总结在表1的最后一行。请注意,在我们的RSLAD中,蒸馏方法中常见的温度常数固定为τ=1,因为我们发现使用RSL时不再需要温度常数。与TRADES、MART、ARD和IAD一样,我们使用自然RSL(即自然示例的鲁棒模型的预测)作为软标签来监督模型训练。我们RSLAD的总体优化框架定义如下:

由于对抗性训练的教师网络T(x)产生的RSL也用于监督学生外部最小化的干净训练部分,因此我们将常用的CE损失替换为KL散度,以公式化两个模型的输出概率之间的分布差异程度。

RSLAD的目标是学习一个小型学生网络,该网络与经过对抗性预训练的教师网络一样强大,这也是为了尽可能多地保留教师的知识和稳健性。我们注意到,对抗性训练中常用的硬标签可能会在一定程度上丢失教师网络学习到的信息,因为将教师的输出概率二值化为硬标签往往会丢失其真实分布。然而,并不是所有的软标签都是稳健的。我们将根据经验证明,由标签平滑产生的平滑标签或由自然训练的非鲁棒模型产生的软标签不能提高鲁棒性.

How to Choose a Good Teacher?

实验表明学生的稳健性并没有随着老师的稳健性单调增加,而是先上升后下降。我们称这种现象为鲁棒饱和。当教师网络变得过于复杂,学生无法学习时,学生的稳健性往往会下降。

当老师小于WideResNet-34-10时,学生的鲁棒性可以超过老师的鲁棒性,尤其是当老师与学生具有相同的架构(即ResNet-18)时。我们将这种现象称为对抗性训练方法的鲁棒性不足,其中可以通过第二次训练模型来提高鲁棒性,同时使用第一次作为教师训练的模型。

当使用WideResNet-34-10(~比ResNet18大4.5倍)教师时,可以实现ResNet-18学生的最佳稳健性。这些结果表明,在对抗性鲁棒性提取中,选择一个中等规模的教师模型可以获得最大的鲁棒性增益。

3151

3151

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?