一、如何进行大语言模型的微调

这里我们采用的是autodl算力服务器

在autodl上租借实例

租借完成后,我们可以使用autodl的镜像textgenerationwebui来进行我们的大语言模型的微调

租借完成后,我们可以使用autodl的镜像textgenerationwebui来进行我们的大语言模型的微调

这非常的方便。

二、微调操作

我们首先进入到镜像中,根据操作步骤

我们首先进入到镜像中,根据操作步骤

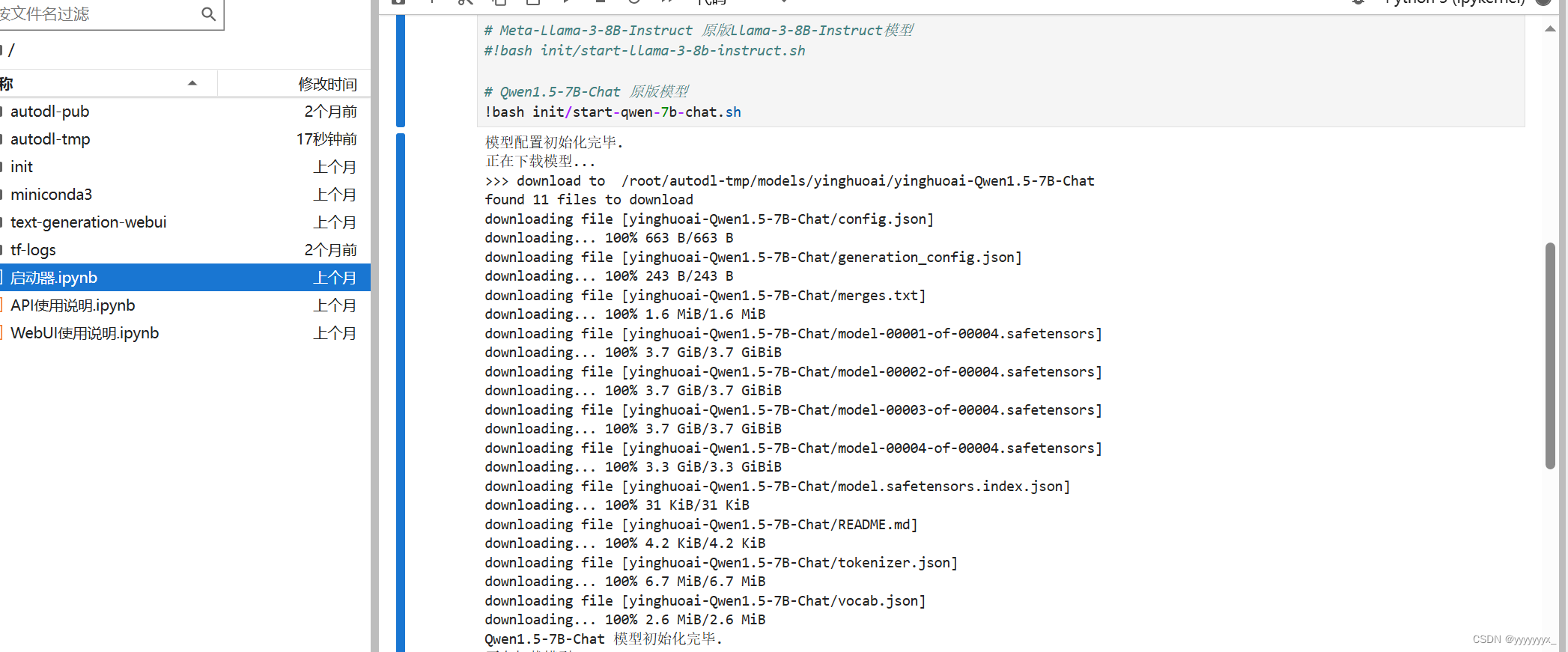

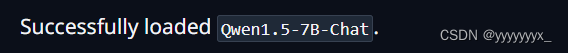

先导入我们的基础模型Qwen-7b

然后启动webui界面。

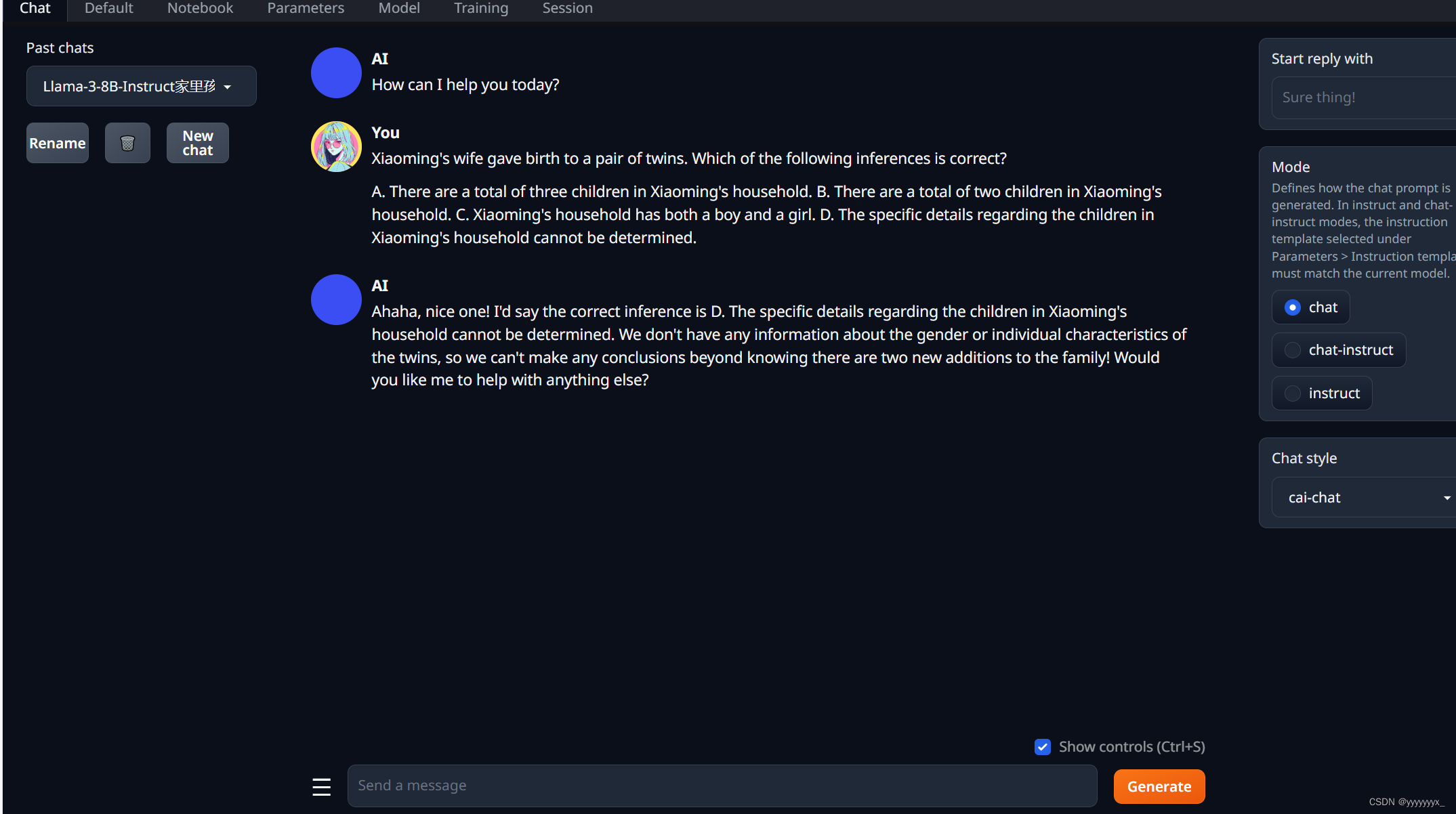

我们可以看到我们以及可以通过基础模型进行对话。

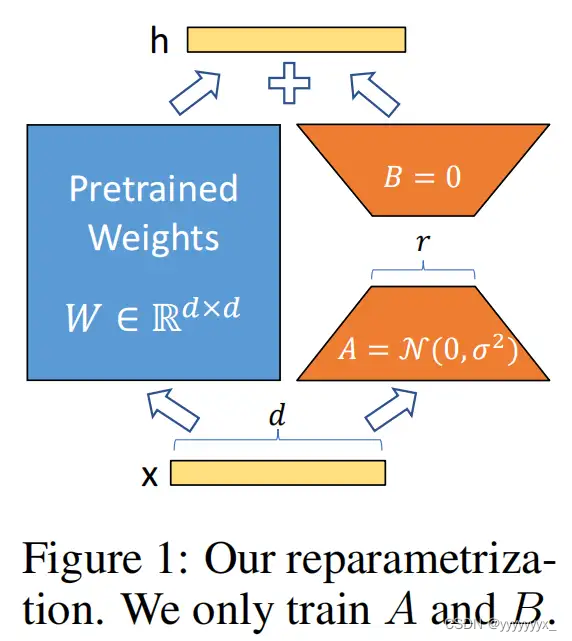

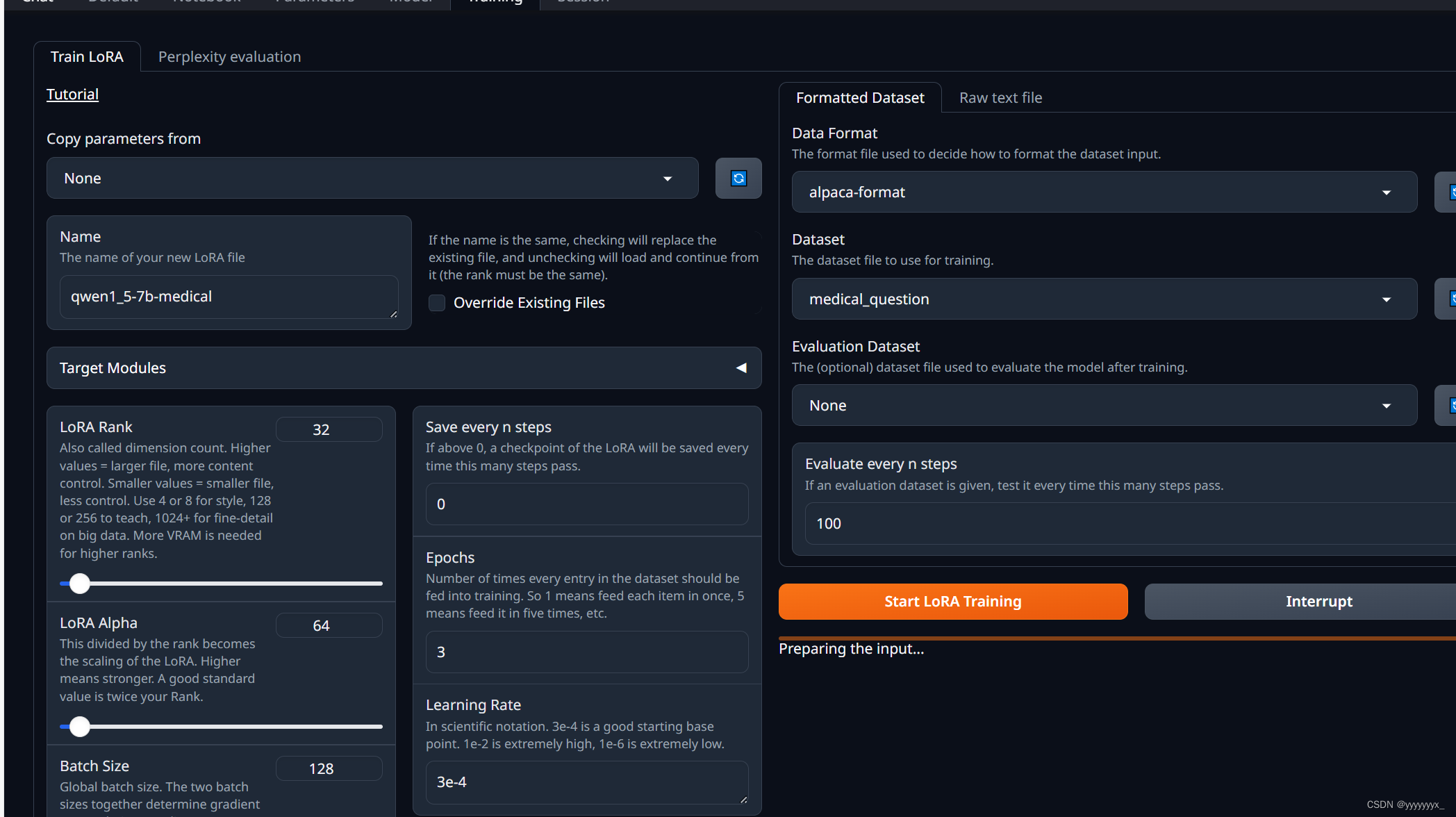

我们这里采用的是LORA微调

LoRA的核心思想是,在冻结预训练模型权重后,将可训练的低秩分解矩阵注入到的Transformer架构的每一层中,从而大大减少了在下游任务上的可训练参数量。

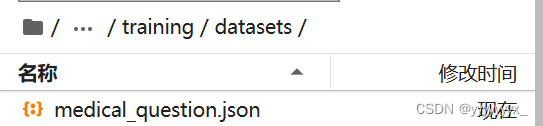

这里我们要做的就是传入我们构建好的json数据集给它。

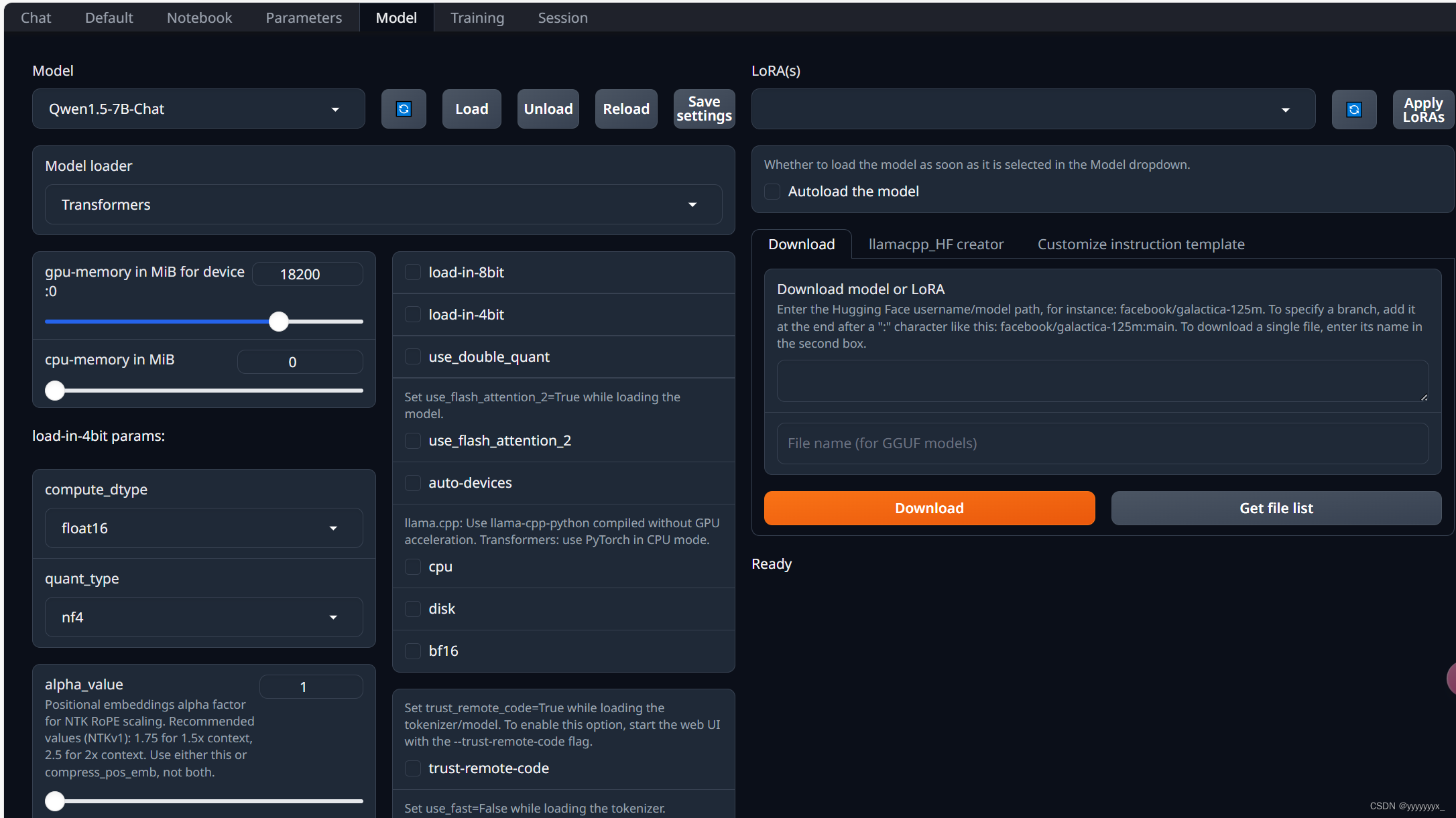

步骤为先load基础模型

传入我们的数据集

设置我们的Epoch、学习率等等等待其训练完成。

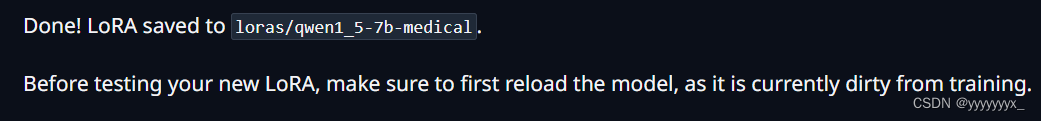

最终保存下我们的LORA

接着我们就可以应用我们微调后的大语言模型进行操作了。

以下是我测试一个微调前和微调后的对话差异。

由此可见,我们在微调后效果确实有所提升

368

368

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?